当深度学习遇上量化交易——模型篇

©PaperWeekly 原创 · 作者|桑运鑫

学校|上海交通大学硕士生

研究方向|图神经网络在金融领域的应用

本文介绍三篇从模型层面着手解决股价预测问题的顶会文章。

IJCAI 2019

论文标题:Enhancing Stock Movement Prediction with Adversarial Training

论文来源:IJCAI 2019

论文链接:https://www.ijcai.org/Proceedings/2019/0810.pdf

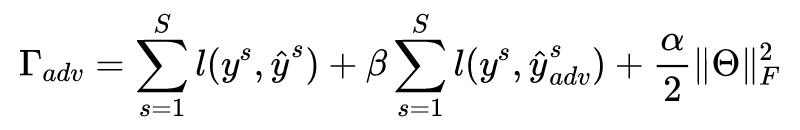

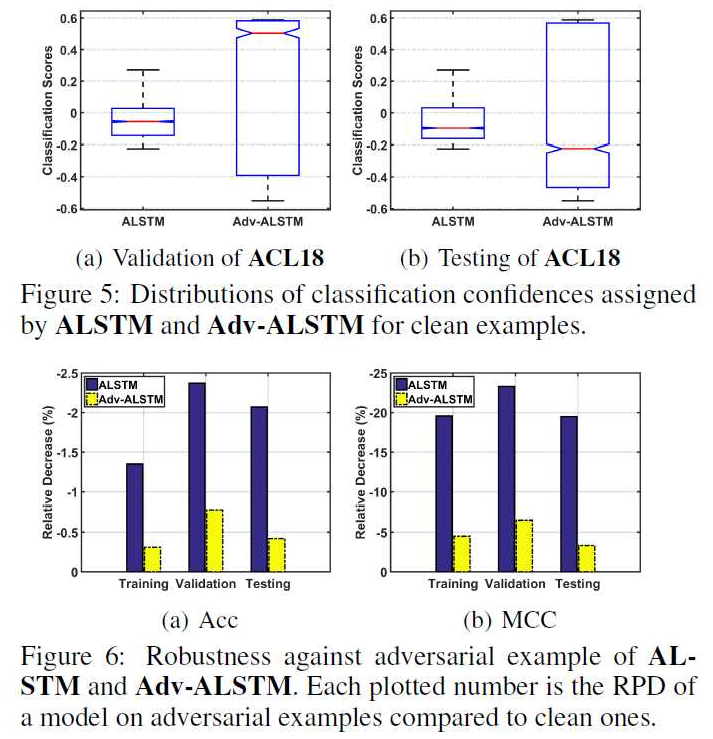

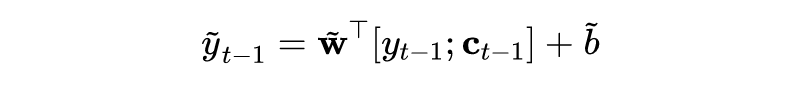

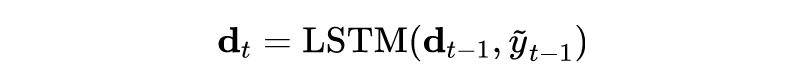

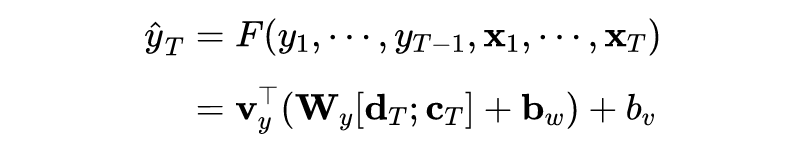

众所周知,股票市场具有噪声高和随机性强的特点,传统使用静态历史数据训练的模型很容易过拟合。为了提高模型的泛化能力,文章提出通过对数据增加扰动来解决这一问题。其最大的亮点就是提出了使用对抗训练(Adversarial Training)的方式来训练模型。

但这种训练方式不那么适用于股票市场,因为我们输入模型的数据(如各种技术因子的取值)是有随机性的,因此很容易导致过拟合而缺少泛化性能。而一个好的模型应当能捕捉随机性。所以文章提出了对抗训练的方式。

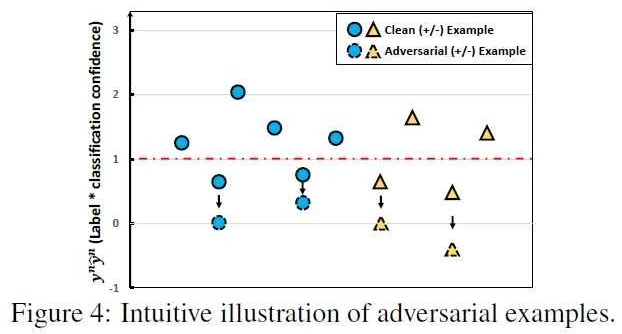

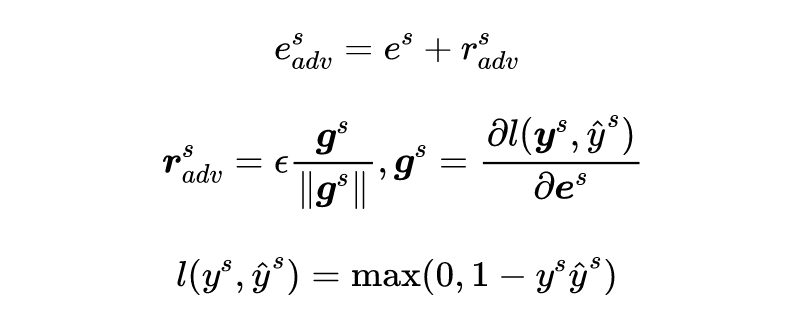

首先来思考一个问题,怎么提高模型建模随机性的能力?自然的想法就是如果我们对输入样本加一个扰动,模型仍然可以正确预测,那么模型肯定能很好的抵御随机性。那么这个扰动怎么加也很有学问,我们希望加的扰动能够让模型输出结果发生最大的改变。

那么哪个方向的扰动能够让模型输出结果发生最大的改变呢?回忆一下梯度下降法,梯度方向是下降最快的方向。显然,样本的梯度方向就是我们寻求的那个能够让模型输出结果发生最大改变的方向。

所以从本质上来说,文章提出的对抗训练就是一种梯度下降法,不过梯度下降法优化的是参数,而这里的对抗训练改变的是样本,得到对抗样本。

KDD 2017

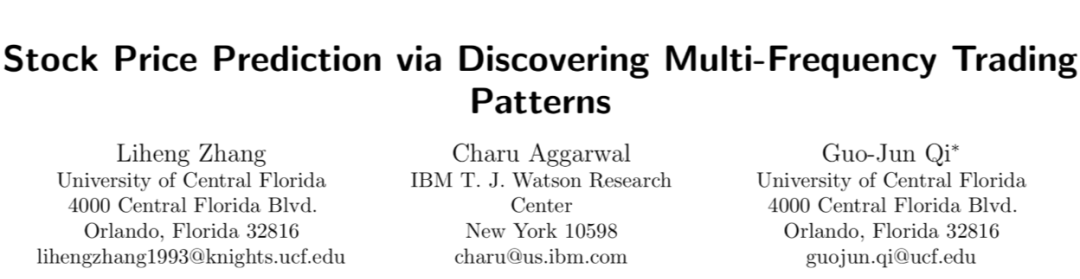

论文标题:Stock Price Prediction via Discovering Multi-Frequency Trading Patterns

论文来源:KDD 2017

论文链接:http://www.eecs.ucf.edu/~gqi/publications/kdd2017_stock.pdf

这是一篇应用的文章,作者还发了一篇偏理论的文章在 ICML 2017 上:State-Frequency Memory Recurrent Neural Networks, in Proceedings of International Conference on Machine Learning [1] 。

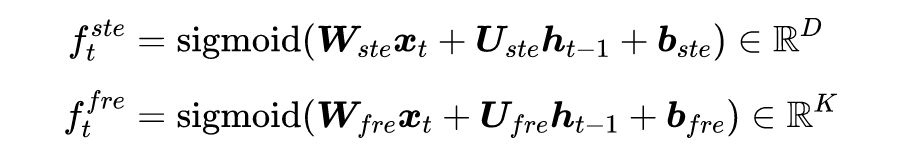

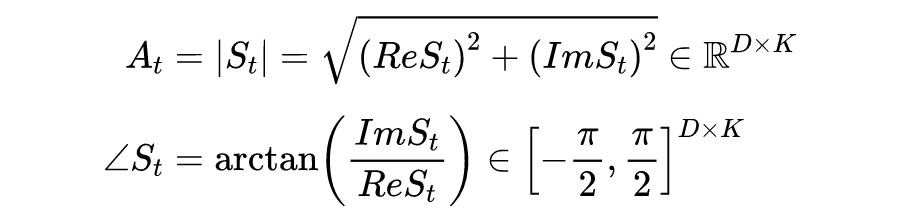

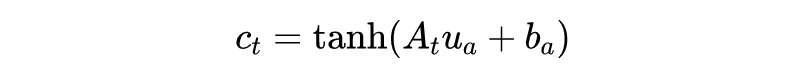

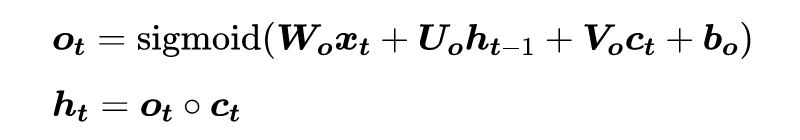

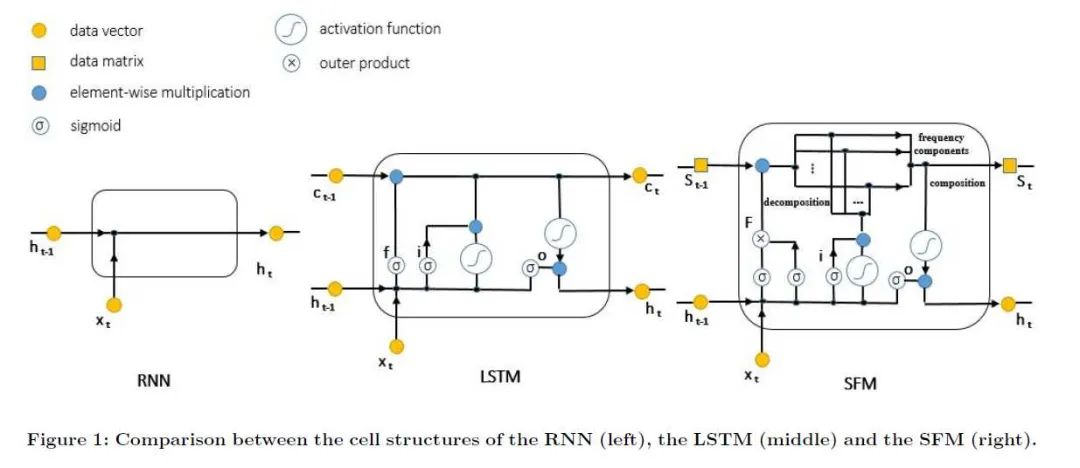

我们通常使用 LSTM 来建模时间序列之间的长期依赖。如果我们将股价的变动看作一种信号处理任务的话,那么利用 LSTM 来预测股价变动只捕捉了时域上的信息,而忽略了频域上的信息。

而对于股价信号来说,频域上的信息是非常有用的,其中的高频部分反应了股价的波动性,低频部分捕捉了长期的趋势和规律。基于此,文章提出了 SFM 来同时建模时间序列的时域与频域信息。

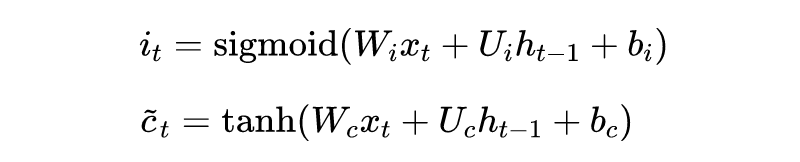

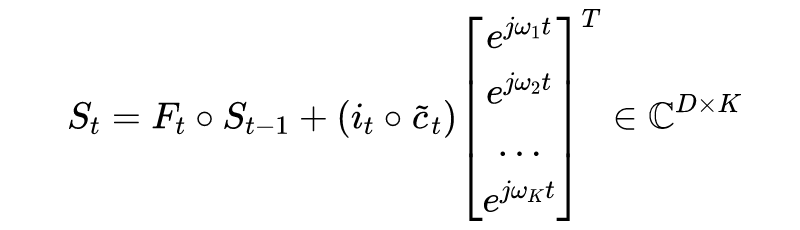

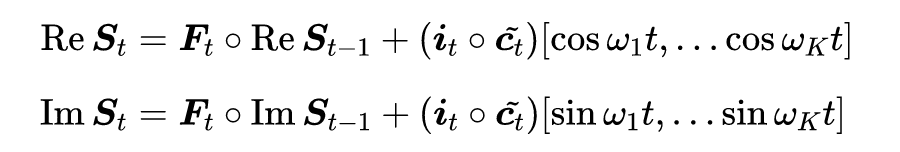

传统的 LSTM 结构大家都知道,这里不再赘述。我们来介绍下文章提出的 SFM 对于传统 LSTM 的三个改进:

-

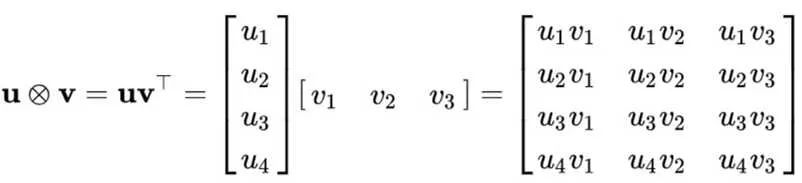

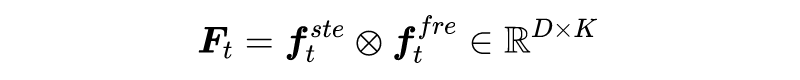

将 LSTM 中的记忆细胞 变成状态-频率矩阵(the state-frequency matrix) ; 将遗忘门改成联合状态-频率遗忘门;

-

利用傅里叶变换和逆变换使信号能够在时域与频域之间转换。

-

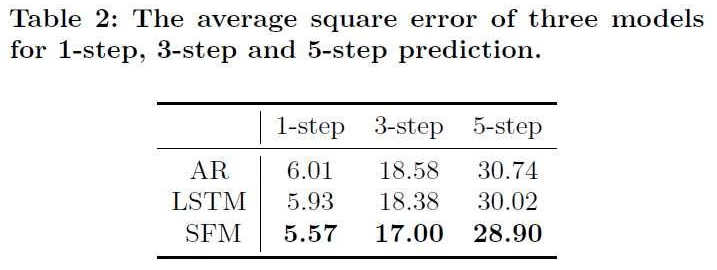

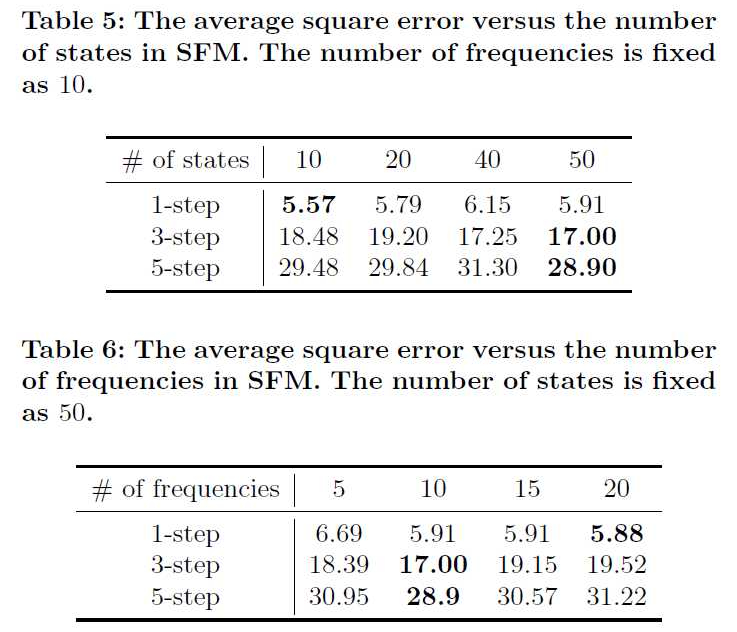

AR 的表现会随着 的增大而变差,LSTM 与 SFM 则会变好。证明了 LSTM 和 SFM 对于长期依赖的捕捉能力。 对于短期预测,太多的状态会让结果变差(过拟合),而长期预测则需要更多的状态来提供更多信息。

-

短期预测需要更多的频率成分来表现短期股价的高波动性,而长期预测则依赖于那些比较稳定的低频成分。

IJCAI 2017

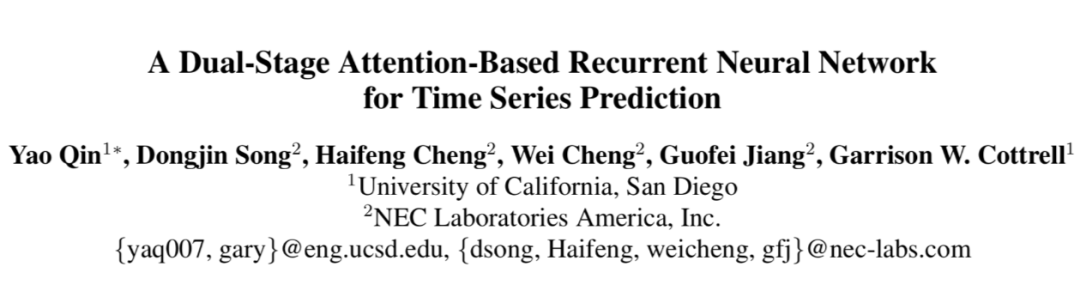

论文标题:A Dual-Stage Attention-Based Recurrent Neural Network for Time Series Prediction

论文来源:IJCAI 2017

论文链接:https://www.ijcai.org/Proceedings/2017/0366.pdf

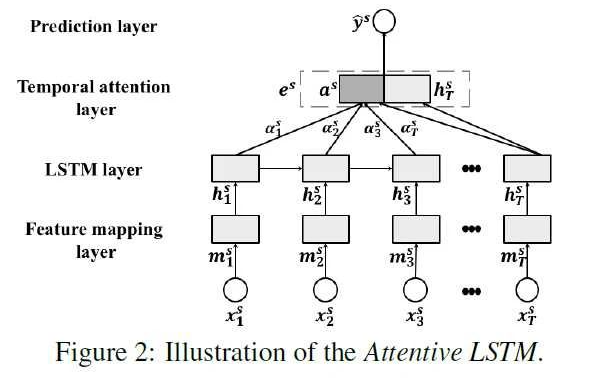

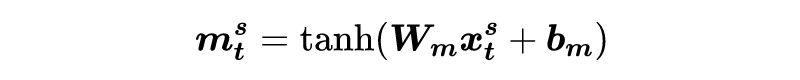

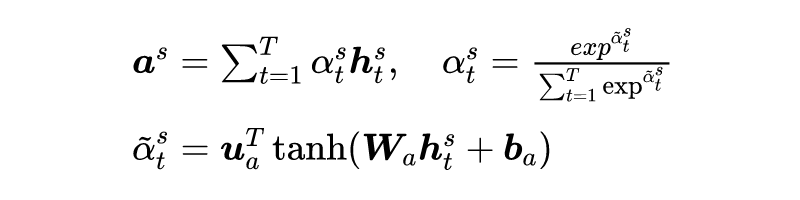

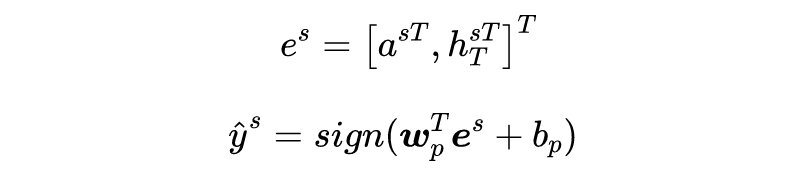

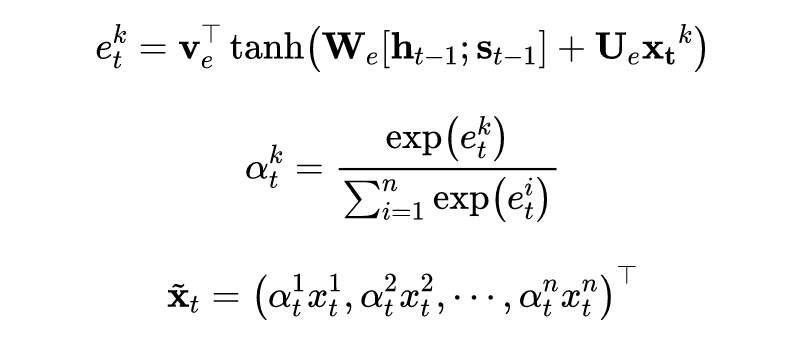

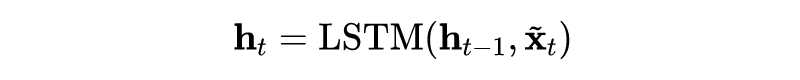

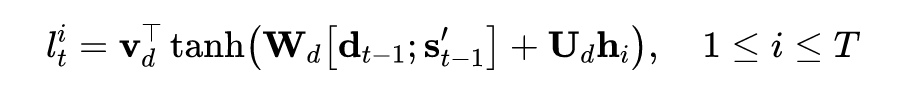

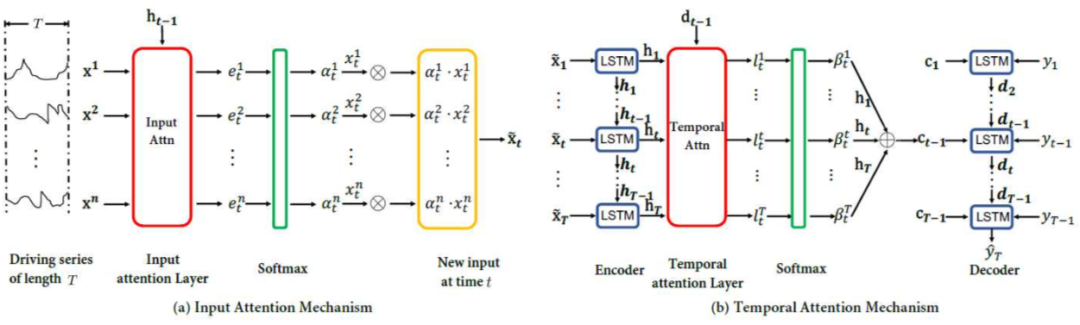

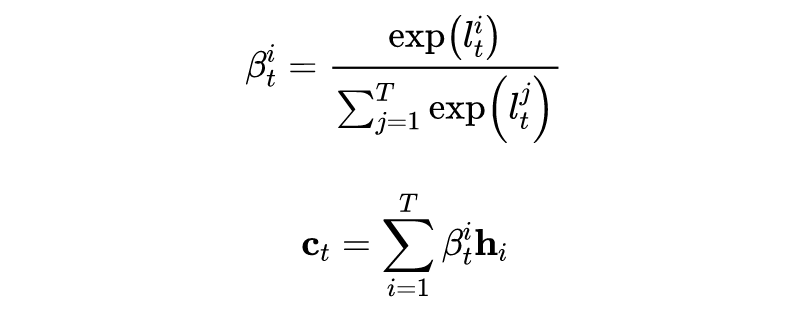

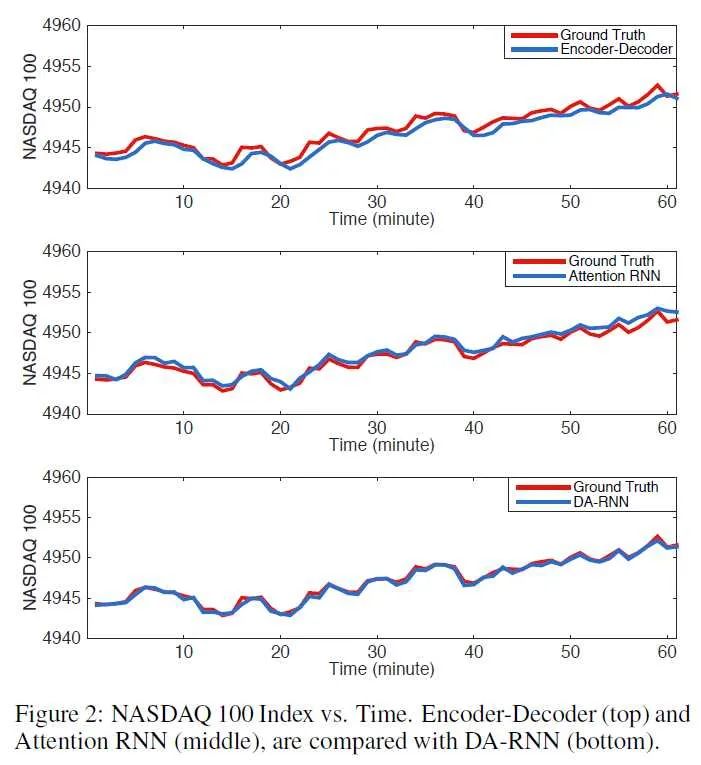

相比于传统的 Seq2Seq 模型,DA-RNN 在输入端增加了一个 input attention 层。可以分成两部分:Encoder with input attention、Decoder with temporal attention。

文章还将模型的输入做了扰动后拼接上正常的输入进行训练,发现 input attention 对于扰动后的数据赋予了较低的权重,证明了 input attention 让模型抗干扰能力更强。

总结

股价数据具有极低信噪比、随机性强、时序依赖的特点,比一般的序列预测任务相比更加困难,模型改进的方向也是尽可能的提升模型的抗干扰能力(对抗训练),从噪声中提取有价值的信号(频域、注意力机制)。希望未来在这一领域看到更多更有创造性的工作。

因为相关的资料确实相当匮乏,我在 GitHub 上新建了一个 repo 用于收集、整理相关的研究论文、书籍、数据、网站等,欢迎 star!

https://github.com/sangyx/deep-stock

参考链接

[1] https://dl.acm.org/doi/10.5555/3305381.3305543

更多阅读

#投 稿 通 道#

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。