PAKDD17 | Marked Temporal Dynamics Modeling based on RNN

PAKDD17 | Marked TemporalDynamics Modeling based on Recurrent Neural Network

Author:Yongqing Wang, Shenhua Liu, Huawei Shen, Jinhua Gao and Xueqi Cheng

前言:翻了下公众号的更新历史,说来实在惭愧,有快两个月木有更新了Orz……别的理由啥也不说咧,亏欠了两个月的更新我会想办法一一补回来,言归正传,来讲今天的主题。今天说的这篇是我们今年被PAKDD录用的文章:利用循环神经网络(RNN)建模时空序列。

1 背景介绍

在具体介绍工作之前,先明确一些基本概念。首先说明的是“时空序列”,时空序列中的时和空分别是时间和空间,两者构成了对单一事件的基本描述。以购物场景为例,某一用户一次购物事件的基本描述为:何时在何地购买商品。对应的时空序列是其在一段观测窗口内的消费记录。建模时空序列,目标是建模时空序列的产生过程,用以推断下一事件的发生时间和空间。在传统工作中,考虑到时间和空间并不在同一尺度,因而解决时空建模问题常将其分为两部分单独解决:要么建模空间序列,要么建模时间序列。建模空间序列,典型的例如马尔科夫过程,建模空间内从一个点跳转至下一个点的跳转概率;建模时间序列,利用一系列的时序模型,建模各个跳转所需的时间消耗。那么,有没有一种可能,可以联合描述一个事件的时间和空间,进而建模完整的时空序列呢?问题的关键是,如何将时间和空间转换到同一尺度空间下。

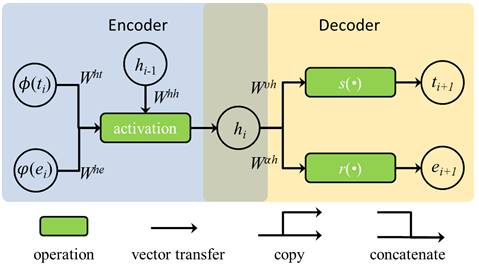

我们借助于循环神经网络来实现这种转换,对于时空建模而言,输入:已观测的事件序列,输出:下一事件。输入和输出的形式都是事件,循环神经网络的作用是将输入进行编码,继而再做解码还原为事件描述输出。由于需要统一时间和空间,人为的方式难以定义这种编解码的过程,因此藉以能够通过循环神经网络去寻找。图1展示了一个利用循环神经网络对时空序列建模的基本框架:左侧为编码过程,右侧为解码过程。图中的t,e分别表示时间和空间变量,在编码前,我们预先对时间和空间进行Φ(t)和φ (e)转换,使之能够作为神经网络的输入;编码过程的输出,我们称为表达h,接着表达h作为解码过程的输入,通过函数s和r做解码变换确定下一可能发生的事件。可以发现,表达h是连接编解码过程的关键,是统一时间和空间的一结果。

图1 Recurrent marked temporal point processes (RMTPP)

2 动机

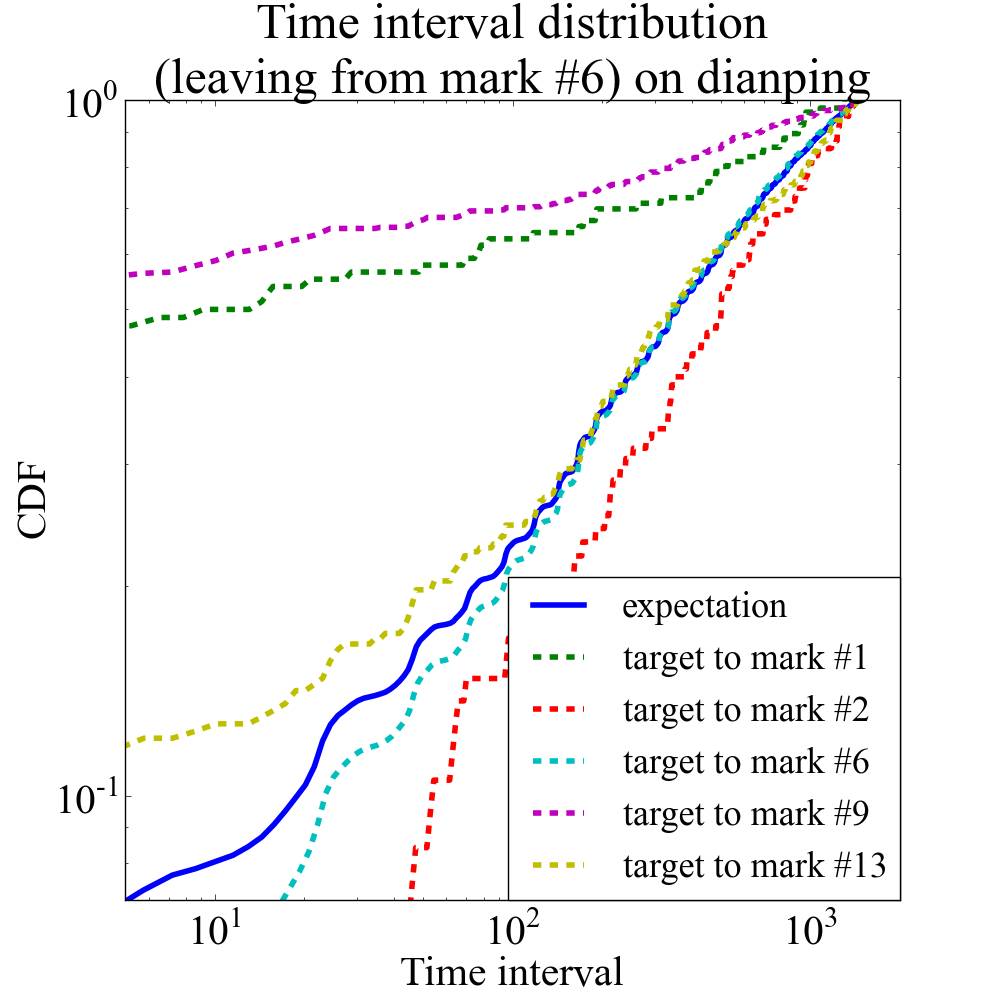

利用图1所提的框架可以解决对时空序列建模中时、空无法统一尺度的问题。但我们发现上述解码过程存在一个问题,对时间和空间变量的解码是独立的,这种独立解码的方式会导致对事件的描述存在偏差。还是以购物为例,假设有两个人分别在北京西单大悦城购物,其中一个人逛完商场完后坐地铁去了簋街小吃街,而另外一人则去了位于西单的首都电影院打算去看一场电影。我查了下地图,从大悦城去簋街大约需要35分钟左右的时间,而去首都电影院只需要坐上电梯,花上大约3-5分钟的时间就可以到达。可以看到,这个过程中时间的消耗和目的地有明确的关联关系,而独立解码则会忽略两者之间的关联性。在真实数据中,这种情况又常见么?接下来我们对大众点评中团购频道的数据进行了统计,用以说明我们不能忽视这种时空存在关联的现象。图2是数据的统计结果,我们选择了某一特定店铺,在线团购中,用户在该店铺进行消费后,我们观测他们的下一消费选择会如何变化。图中枚举了5家用户后续经常选择的店铺,可以看到,不同的选择所消耗的时间会存在明显差异。假如,我们采用之前独立解码的方式,那么最后拟合出来的结果会如图2中蓝色实线部分所示,这显然不是我们想要的结果。

图2 大众点评团购数据统计结果。图上标识了在线团购中用户在某一特定店铺消费后下一笔团购的不同选择

3 模型及实验

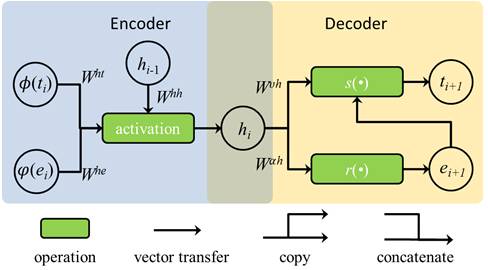

要解决这一问题,也并非难事,我们只需要在图1的框架中添加一条连接关系即可。我们提出一种存在先后次序的、解码方式:先确定空间变量,而后由确定的空间变量以及时空的联合表达h确定时间变量。当然,这种先空间后时间的解码顺序也可以进行置换,这里我们只讨论图2中的情况。增加了这条连接关系后,我们就能区分用户从大悦城出发去簋街和去首都电影院这两个不同地点所需要消耗的时间,也能更为准确的刻画解码过程。

图 3 Marked temporal dynamics modeling based on RNN (RNN-TD)

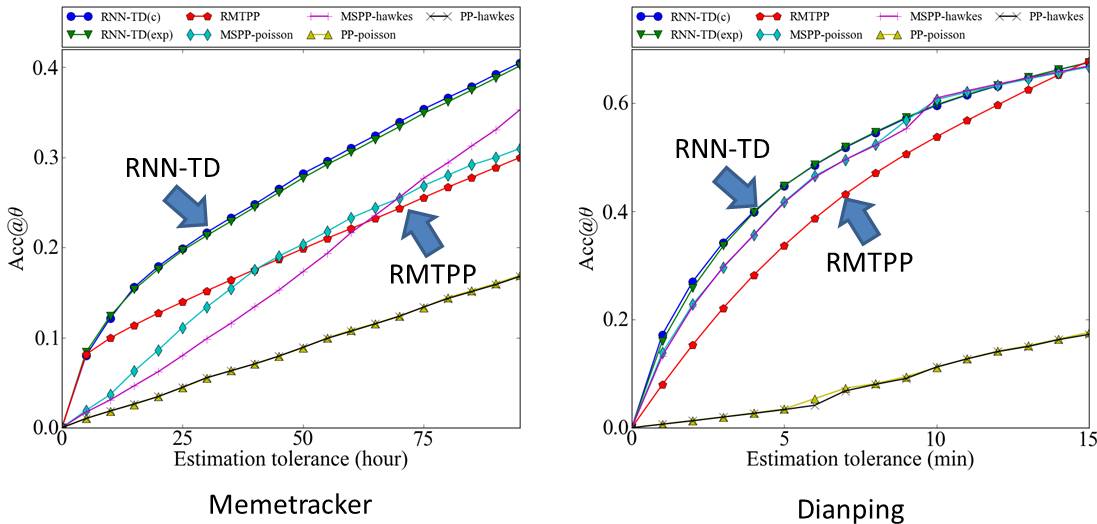

我们在两个实验数据集上比较前后两种框架的差异性:一组为用户博客数据(Memetracker),一组为大众点评的团购消费数据(Dianping)。我们分别采用以上两种框架用来预测下一事件的发生时间,并将其精度展示于图4中。可以看到,考虑解码过程中时间和空间关联关系的后一种框架(RNN-TD),其在预测精度上优于不考虑这种关联关系进行解码的框架(RMTPP)。也就是说,这条增加的连接关系是确实有效的。另外,在预测下一事件类型的任务上,RNN-TD也有轻微的效果提升。

图4 RMTPP和RNN-TD在两组实验数据集上对时间预测的比较结果

后记 说一些文章之外的话,这条在解码过程中增加的连接关系,的确可以在某种程度上解决过去在解码过程中由独立性假设所带来的问题,但也带来了额外的复杂度,因此其适用性受到了约束。另外,在事件的预测上,时间和空间的关联关系导致问题无法在一个较为合理又高效的尺度上进行评价。这些是我们工作的一些疑惑,希望可以在未来的工作中得到有效解决:-)