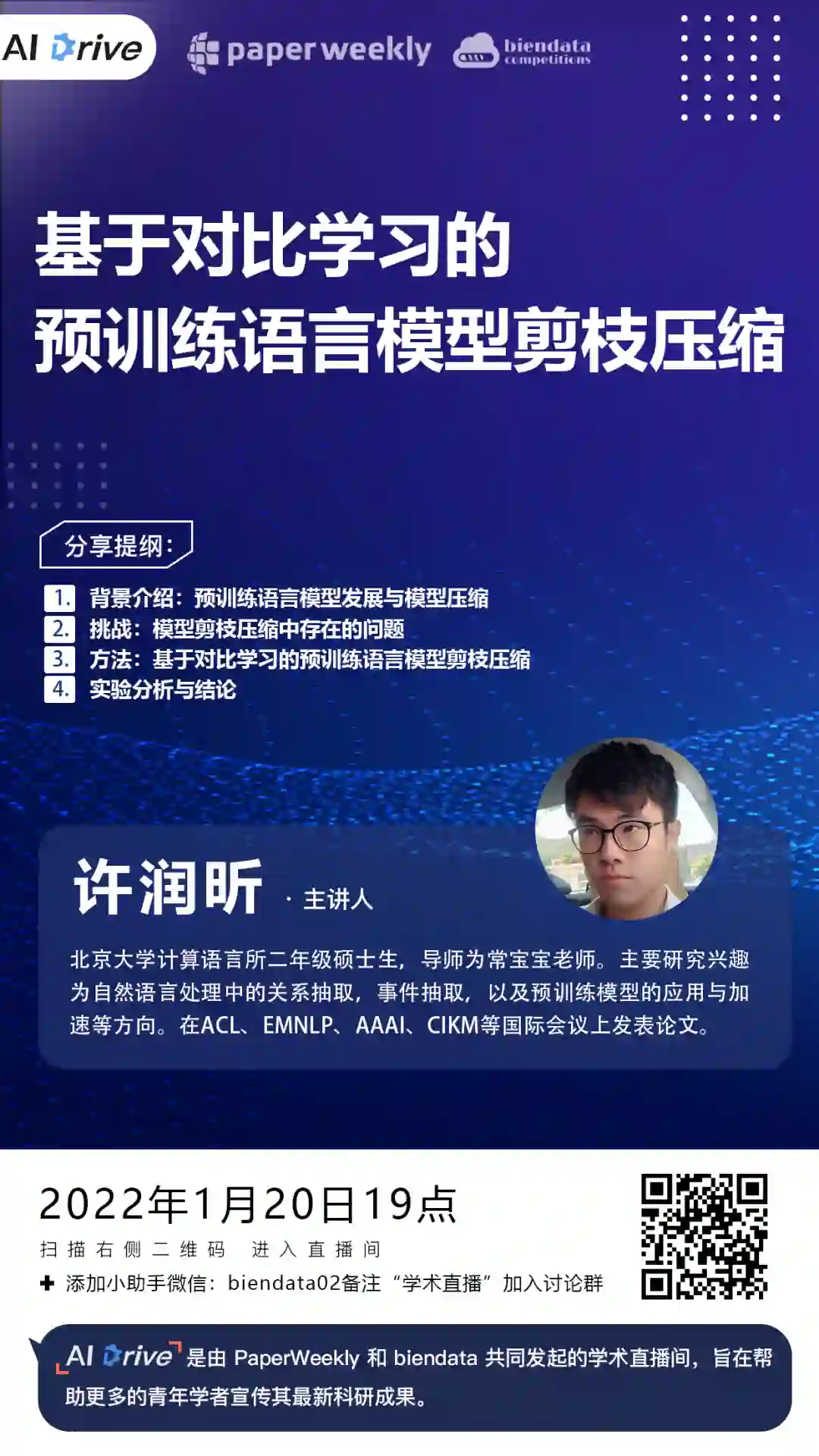

直播预告 | AAAI 2022论文解读:基于对比学习的预训练语言模型剪枝压缩

本期 AI Drive,我们邀请到北京大学计算语言所硕士生许润昕,为大家在线解读其发表在 AAAI 2022 的最新研究成果:From Dense to Sparse: Contrastive Pruning for Better Pre-trained Language Model Compression。对本期主题感兴趣的小伙伴,1 月 20 日(本周四)晚 7 点,我们准时相约 PaperWeekly 直播间。

直播信息

论文标题:

From Dense to Sparse: Contrastive Pruning for Better Pre-trained Language Model Compression

https://arxiv.org/abs/2112.07198

预训练语言模型发展与模型压缩

模型剪枝压缩中存在的问题

基于对比学习的预训练语言模型剪枝压缩

实验分析与结论

嘉宾介绍

许润昕 / 北京大学计算语言所硕士生

直播地址 & 交流群

本次直播将在 PaperWeekly 视频号和 B 站直播间进行,扫描下方海报二维码或点击阅读原文即可免费观看。线上分享结束后,嘉宾还将在直播交流群内实时 QA,在 PaperWeekly 微信公众号后台回复「AI Drive」,即可获取入群通道。

B 站直播间:

合作伙伴

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

登录查看更多

相关内容

专知会员服务

17+阅读 · 2019年11月17日

Arxiv

0+阅读 · 2022年4月15日