针对长序列或基于事件的序列的循环神经网络训练加速(读书报告)

会议:NIPS2016

作者:Daniel Neil, Michael Pfeiffer, and Shih-Chii Liu

【文章链接】

http://papers.nips.cc/paper/6310-phased-lstm-accelerating-recurrent-network-training-for-long-or-event-based-sequences.pdf

【研究背景】

传统的RNN模型无法处理采样频率不同的各种输入数据

【主要贡献】

该工作提出了Phased LSTM model,Phased LSTM model对LSTM增加一个新的time gate,从而使得扩展后的LSTM可以用于处理有着不同采样频率(更新的时间间隔)的时序事件。 这个新增的time gate被一个带频率范围的参数化震荡(a parametrized oscillation with a frequency range)控制,使得记忆细胞仅在单个周期的极小比重的时间内得以更新。 虽然这种震荡使得记忆细胞的更新变得稀疏,在学习长序列的任务上, Phased LSTM network有着比传统LSTMs更快的收敛速度。

任意采样频率的传感器带来的输入可以自然地被Phased LSTM model集成,因此可以对异步的带有定时信息的感知事件进行处理,开创新的调查研究领域。同时,在传统的RNN应用领域中,Phased LSTM model也提升了LSTM的性能。

【背景知识】

LSTM原始文献Hochreiter, S., & Schmidhuber, J. (1997). Long short-term memory. Neural computation, 9(8), 1735-1780.

LSTM的变体Gers, F. A., & Schmidhuber, J. (2000). Recurrent nets that time and count. In Neural Networks, 2000. IJCNN 2000, Proceedings of the IEEE-INNS-ENNS International Joint Conference on (Vol. 3, pp. 189-194). IEEE.

【核心思想】

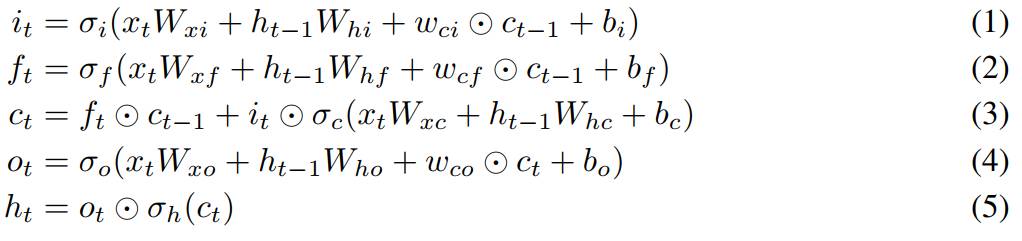

本文的公式(1)(2)(3)(4)(5)是Graves, A. (2013)中定义的公式。而本文作者对公式进行了一些改变。引入周期π、相位偏移(phase shift)s、时间门(time gate)k_t等概念。

一个完整的周期π共有三种阶段,前两个阶段是open的,而第三个阶段是closed的。用k_t表示新的输入对t时刻的记忆细胞的重要程度。在一个周期的第三个阶段,即closed阶段,k_t处于关闭状态,前一个细胞状态被保留。

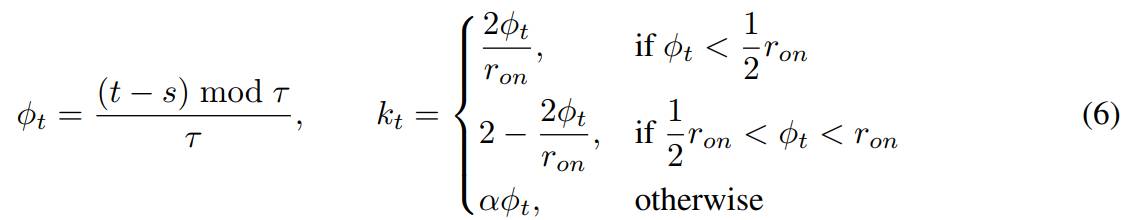

k_t在一个周期内的变化公式如下:

可以看到,在第三个阶段(即closed phase),k_t=αΦ_t,α为leak rate。在训练(training)阶段,α=0.001;在测试阶段,α=0。非零的α使得在closed phase时,也能向记忆细胞传播重要的梯度信息(propagate important gradient information),其作用类似于Delving deep into rectifiers: Surpassing human-level performance on imagenet classification(K. He, X. Zhang, S. Ren, and J. Sun,ICCV2015)中a parametric "leaky" rectified linear unit中的leak。

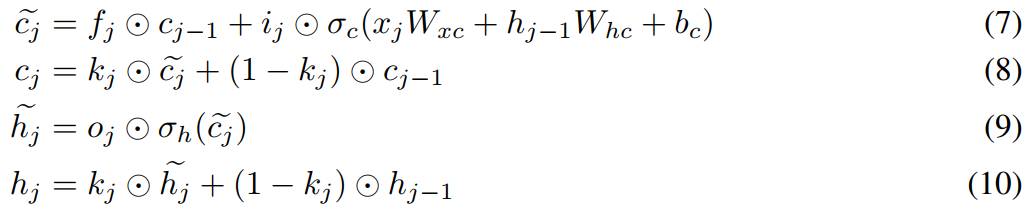

k_t对记忆细胞更新的影响如公式(7)(8)(9)(10)所示:

因此,在第三个阶段,即closed阶段,新的输入对记忆细胞的更新影响很小(训练阶段),或者为零(测试阶段),即不在第三阶段对记忆细胞进行更新。