解耦强化学习的值函数学习

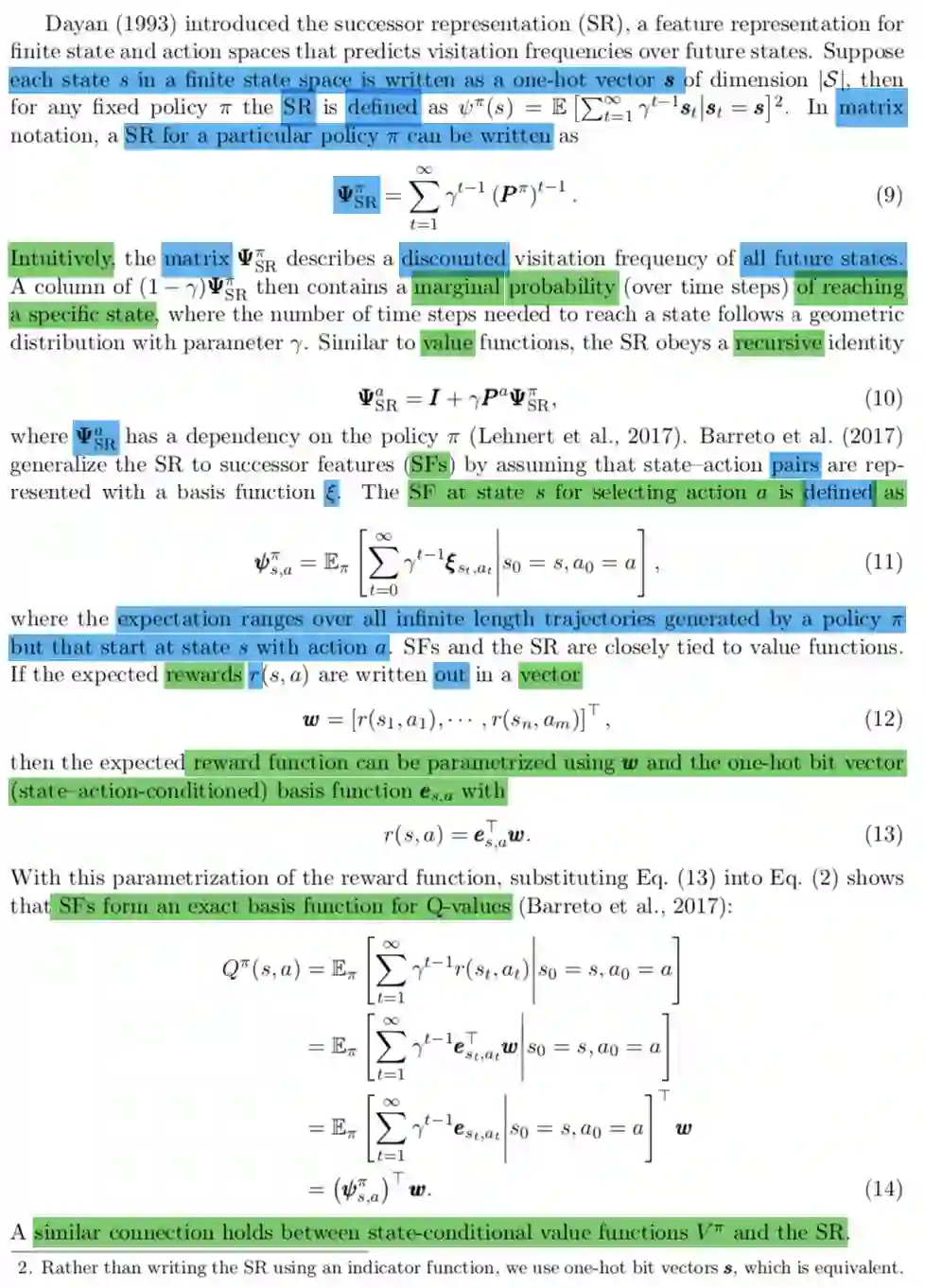

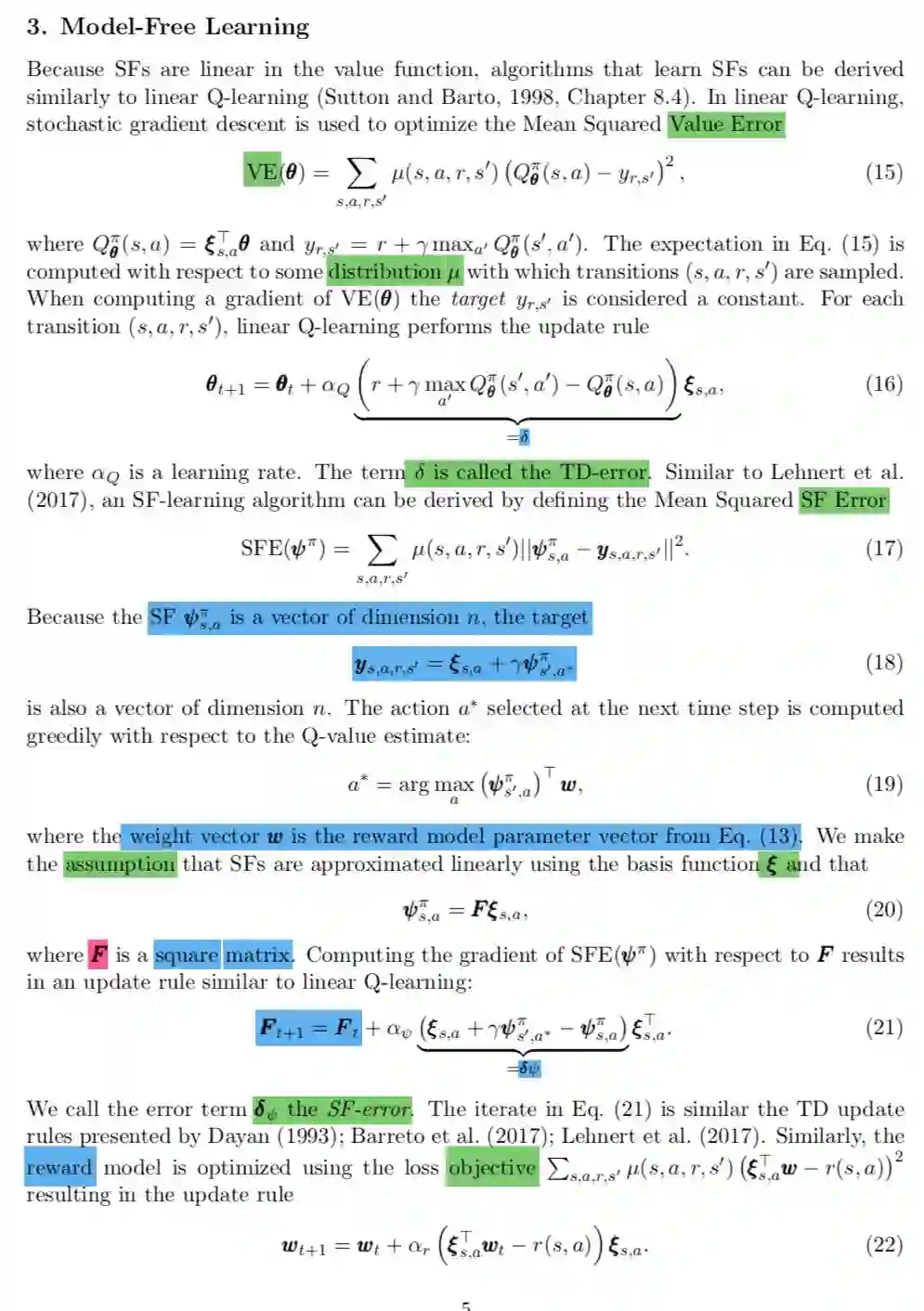

现在AI学习规则还很困难,虽然alphago取得了很大的进展,但是迁移能力很弱,规则一般都涉及到奖励和惩罚,也就是对应到了强化学习的reward函数,人学习规则都比较快,在儿童玩游戏中规则还会经常调整,儿童都能很快的适应,现在强化学习通常是在训练的时候reward规则和整个环境是耦合在一起的,如果可以解耦,AI学习熟悉环境和学习reward分开学习,势必会加快AI的学习,今天介绍的Successor Features就可以一定程度满足这个目的的。

简单来说

ref https://julien-vitay.net/2019/05/successor-representations/

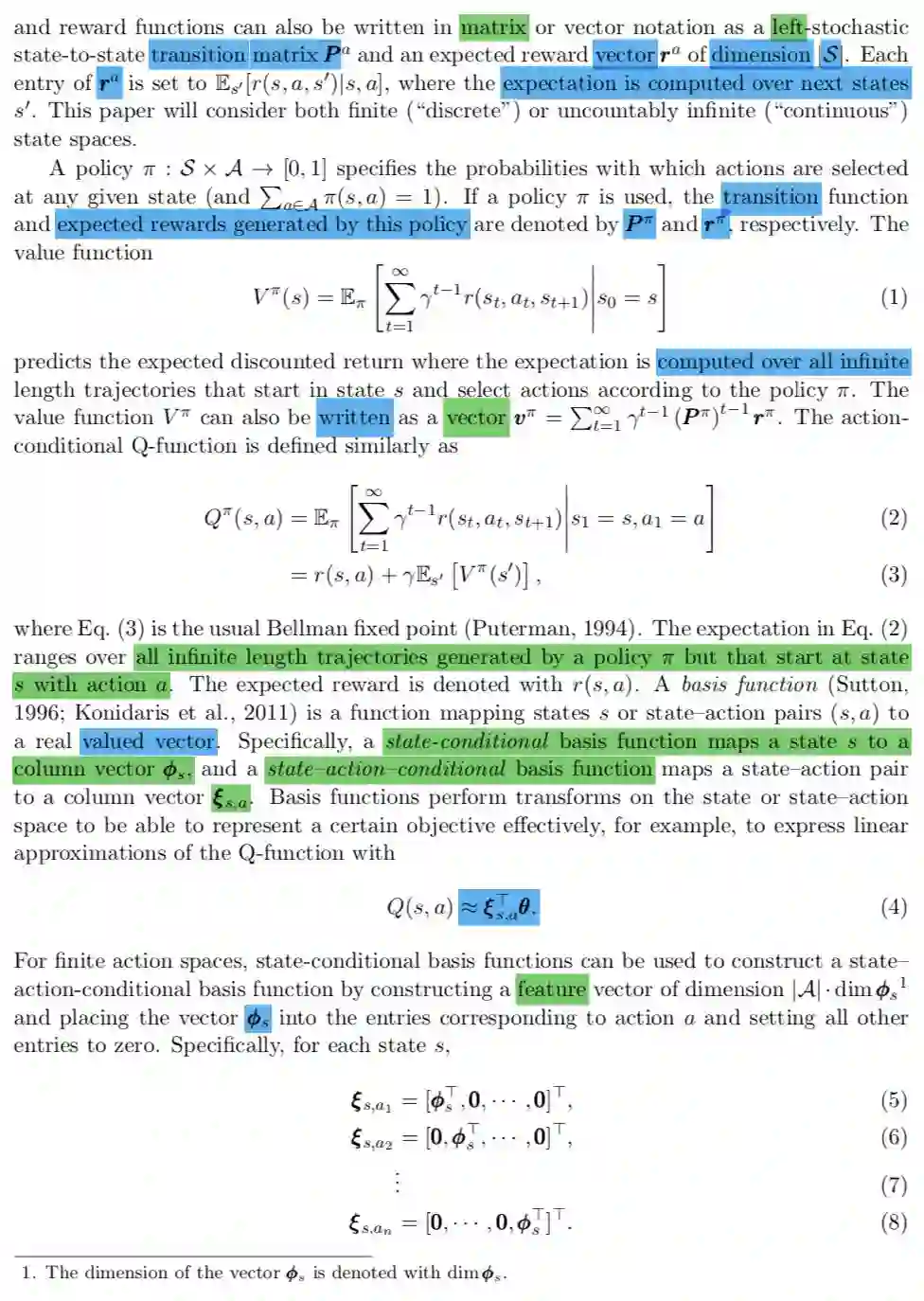

值函数被分解为两部分

reward学习分解为环境的表示学习和收益学习;

今天介绍的paper是:

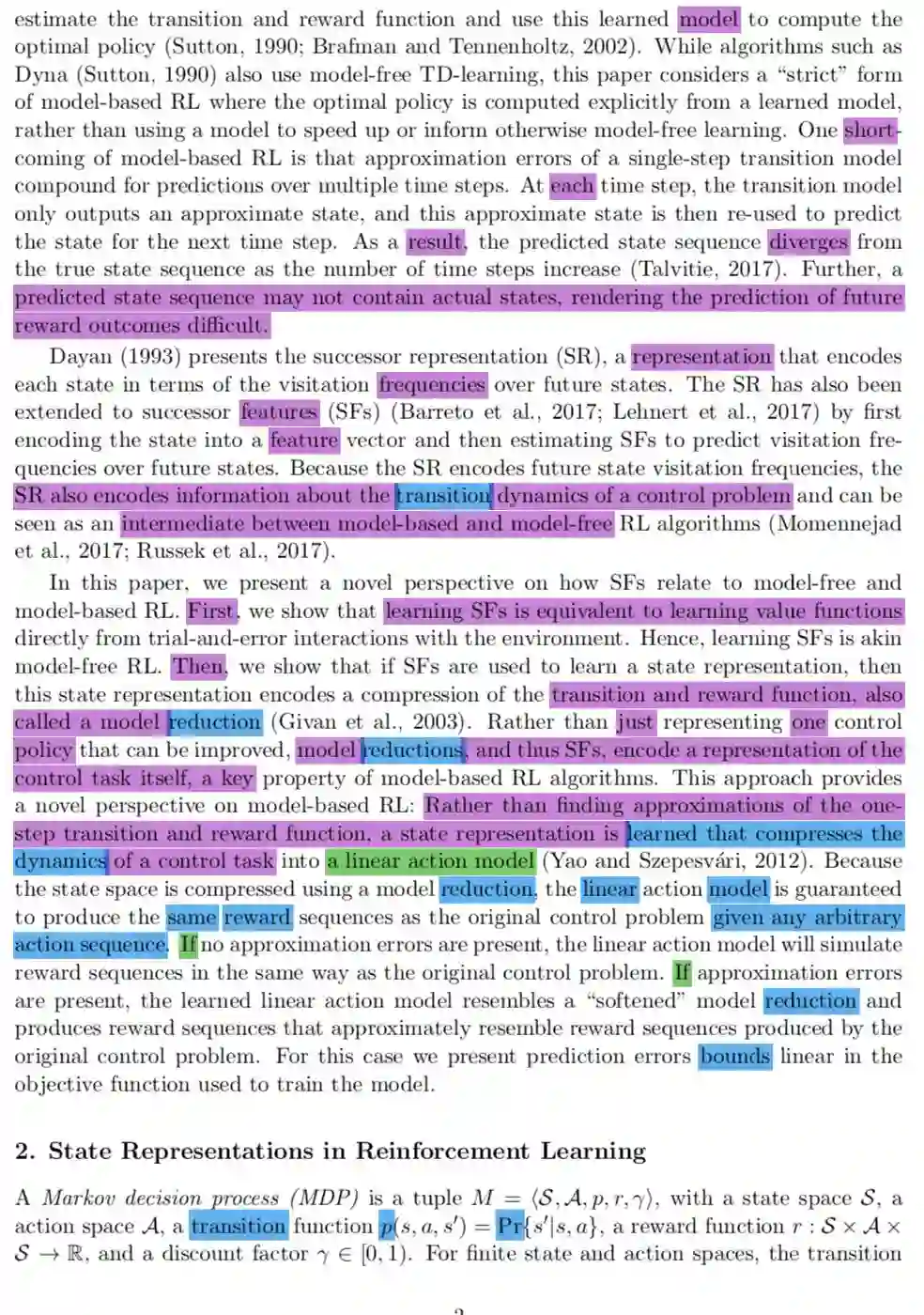

Successor Features Support Model-based and Model-free Reinforcement Learning

这篇文章对model-base学习介绍的几个定理比较新颖,理论推导比较充分,对model-base的表示学习论证非常充分,通过SFs model-base可以学习一个很好的跟reward相关的表示,非常遗憾的是都是很小环境的实验。

从后面的图1 能看到这个方法有比较好的抽象能力;

从图1 能看到这个方法比较好的抽象能力;

欢迎加入打卡群自律学习强化学习,更欢迎支持或加入我们!请参考公众号createAmind菜单说明。

登录查看更多

相关内容

专知会员服务

42+阅读 · 2020年4月11日

Arxiv

4+阅读 · 2018年8月17日

Arxiv

11+阅读 · 2018年7月12日