【泡泡图灵智库】用于鲁棒视觉惯性融合的样条误差加权方法

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Spline Error Weighting for Robust Visual-Inertial Fusion

作者:Hannes Ovren and Per-Erik Forssen

来源:CVPR 2018

播音员:四姑娘

编译:蔡纪源

审核:刘小亮

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——用于鲁棒视觉惯性融合的样条误差加权方法,该文章发表于CVPR 2018。

在传统的视觉惯性融合问题上通常会使用到样条方法,用逆噪声协方差加权来平衡不同的传感器模态。然而,大家往往忽略了样条近似误差,这会导致来自不同模态残差的不一致平衡。在本文中,作者提出了一种基于概率的样条误差加权(spline error weighting, SEW)方法,可以平衡样条拟合中不同类型的残差。与先前的方法相比,所提出的样条误差加权方法还包含了对样条拟合的近似误差的预测。作者通过合成实验证明了预测的有效性,并将其应用于卷帘快门相机的视觉惯性融合上。作者还提出了样条拟合的质量测量方法,可用于自动选择合适的节间距。 实验证明,获得的轨迹质量与所要求的基本一致。最后,通过对权重进行线性缩放,作者证明了所提出的样条误差加权方法可以在尺度和端点误差方面,最小化实际序列中的估计误差。

作者提出的SEW方法使视觉惯性融合在使用卷帘式快门摄像机获取实际序列上变得更加鲁棒。下图1显示了在Handheld 1 数据集上得到的3D结构和连续摄像机轨迹估计。

图1 Handheld 1 数据集上渲染过的模型结果

上:用Meshlab渲染过的模型;下:数据集的样本帧

主要贡献

1. 作者推导了样条误差加权(SEW, spline error weighting)的表达式,并将其应用于连续时间运动恢复结构(CT-SFM, continuous-time structure from motion)问题。通过实验验证了所提出的加权方法能够获得比先前使用逆噪声协方差加权方法更加准确和稳定的轨迹。

2.作者提出了一个基于容许近似误差的合适节间距自动设置标准。 先前的节间距往往通过启发式或者再优化的迭代式方法设置。实验验证了,提出方法得到的近似误差与要求的很接近。

算法流程

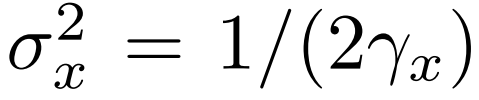

如上式所示,传感器融合问题中,来自不同模态的测量x,y,z可以通过权重γ来平衡。上式可以转成如下求最大概率的问题形式:

对正态分布测量残差有:

其中

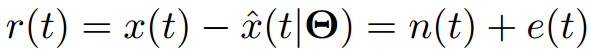

表示残差分布的方差d。在样条方法中,系数向量依赖于节的密度;预测项会导致近似误差e(t)。因此,可以得到下式的残差模型,其中n(t)表示测量噪声。传统方法中仅用测量噪声方差平衡最优化函数,却忽视了e(t)。

作者根据信号频谱推导出了更准确的残差。

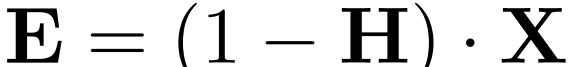

首先,用频率响应函数H(f)表示样条拟合,频率响应函数的离散傅里叶变换用向量H表示,信号的离散傅里叶变换用X表示,那么样条拟合的误差可以用下式表示:

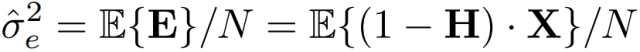

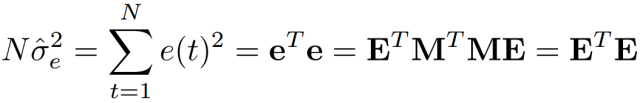

定义逆离散傅里叶变换算子为N*N矩阵M,那误差信号e=ME表示,并且其方差定义如下:

借助帕塞瓦尔理论,可以得到下式:

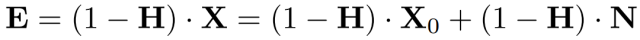

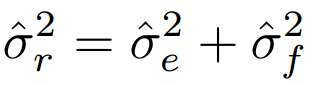

样条拟合的噪声分为两部分,因此误差表达式拆成两部分:

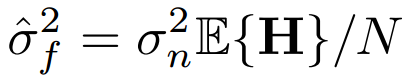

经过滤波的噪声项用F=HN表示,代入其方差,得到下式:

其中,对白噪声而言,滤波后的噪声方差可以用测量噪声和H估计得到,如下式:

因此,最终得到每个模态的权重:

对于节间距∆t的自动选择,作者定义如下质量评价函数:

用Brent提出的有界根搜索法,找到满足下式的∆t

其中q^ 属于(0; 1]

主要结果

文章结果:

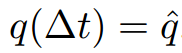

1. 要求的质量值q与样条拟合后获得的实际质量值一致性分析试验。结果显示,除加速度计略微不一致之外,基本实际与期望达到了一致。

图2 加速度计和陀螺仪实验,实际质量与要求的质量对比。其中,蓝色标记是单独的数据点,实线是均值。短虚线表明实际与期望基本一致。

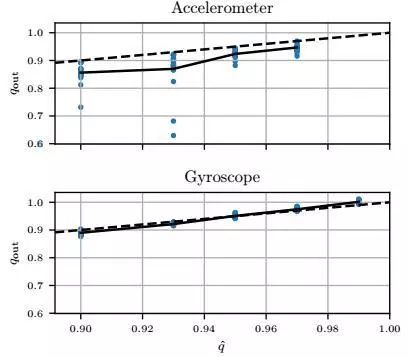

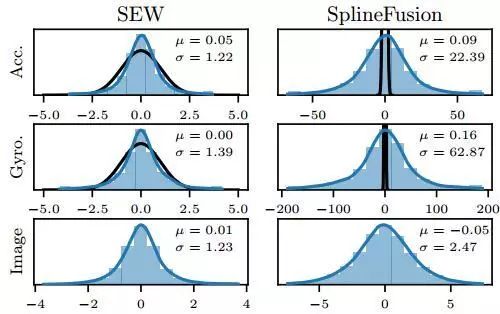

2. 正确的权重对性能的影响。如下图3,SEW方法的权重在最佳频带,得到的误差都很低。相比之下,SplineFusion使用的逆噪声协方差权重,最右边的数据点,始终是一个不好的选择。

图3 IMU残差权重对端点误差和尺度误差的影响。权重因子由式15算得的基础权重相乘得到。虚线表示由SEW选择的权重,小方格代表SplineFusion中的权重。 BC:Bodycam,HH:Handheld

3. 视觉短暂失效对结果的影响。

图4 视觉失效时间端点误差端点失真的影响。横轴表示

视觉观测失效的时长。

4. 与SplineFusio方法进行详尽对比

下列比较试验中,SEW和SplineFusion方法唯一的区别在于节间距和IMU残留权重:对于SplineFusion,我们将样条节间距设置为Δt=0.1秒,

IMU残留权重用测量结果的逆噪声协方差表示。对于SEW方法,节间距和残留权重则使用质量值qacc = 0:97和qgyro = 0:99进行选择,得到的节间距约为0:04秒。

表1 SEW和SplineFusion方法的对比

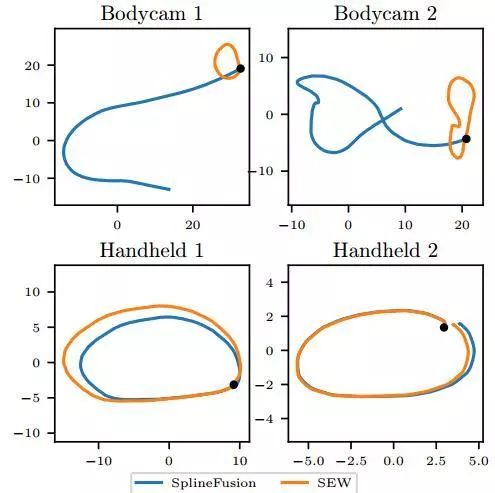

图5 比较SplineFusion和SEW方法获得的轨迹。轨迹都从黑点出发,理想情况下,轨迹应始于并终于相同点。

图6 蓝色表示在Handheld 2数据集上收敛后的残差分布;黑色表示IMU残差期望的标准正态分布N(0,1)的概率分布函数

Abstract

In this paper we derive and test a probability-based weighting that can balance residuals of different types in spline fitting. In contrast to previous formulations, the proposed spline error weighting scheme also incorporates a prediction of the approximation error of the spline fit. We demonstrate the effectiveness of the prediction in a synthetic experiment, and apply it to visual-inertial fusion on rolling shutter cameras. This results in a method that can estimate 3D structure with metric scale on generic first-person videos. We also propose a quality measure for spline fitting, that can be used to automatically select the knot spacing. Experiments verify that the obtained trajectory quality corresponds well with the requested quality. Finally, by linearly scaling the weights, we show that the proposed spline error weighting minimizes the estimation errors on real sequences, in terms of scale and end-point errors.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com