【泡泡一分钟】用于长期视觉定位的时间相关二进制描述符研究

每天一分钟,带你读遍机器人顶级会议文章

标题:Learning Place-and-Time-Dependent Binary Descriptors for Long-Term Visual Localization

作者:Nan Zhang, Michael Warren, and Timothy D. Barfoo

来源:2018 IEEE International Conference on Robotics and Automation (ICRA)

编译:章绩伟

审核:颜青松,陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

基于视觉的导航极易受到自然场景变化的影响。这可能会在地图创建后的不到几个小时内导致定位失败。为了对抗短期照明变化以及长期季节变化,我们建议使用依赖于地点和时间的二进制描述符,以在线方式适应不同的场景。这是通过以两种方式扩展GRIEF演化算法来实现的:除了描述符生成的简要比较之外,使用已知的姿势变化和包含LATCH三元组的对应生成。我们展示了自适应描述符优于单个描述符方案,用于在单实验VT&R系统中进行定位,同时保持二进制描述符的效率。通过使描述功能适应不同的环境条件,它允许系统在需要新体验之前运行更长的时间。在白天到夜晚出现极端光照变化的情况下,与SURF相比,我们获得了40%的内部匹配。在季节性变化的情况下,证明增加了70%。增加的对应性导致沿着路径的更多可局部化的部分,分别在照明和季节性情况下增加25%和150%。

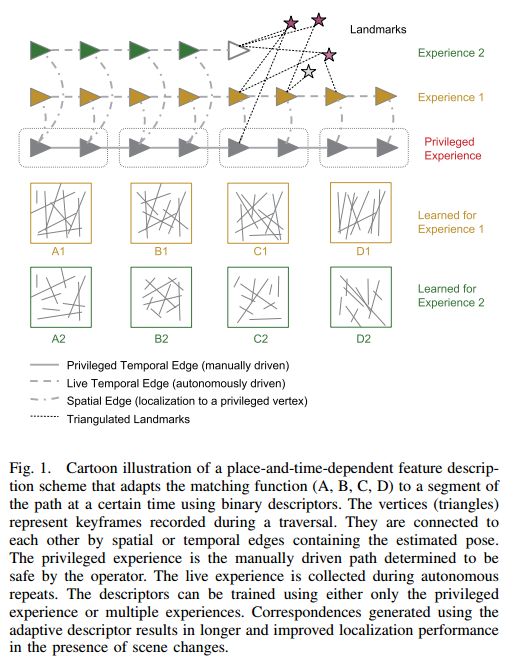

图1 依赖于地点和时间的特征描述方案的卡通图示,其使用二进制描述符使匹配函数(A,B,C,D)在特定时间适应路径的片段。顶点(三角形)表示遍历期间记录的关键帧。它们通过包含估计姿势的空间或时间边缘彼此连接。特权体验是由操作者确定为安全的手动驱动路径。在自主重复期间收集实时体验。可以使用特权体验或多种体验来训练描述符。使用自适应描述符生成的对应关系在场景变化的情况下导致更长且改进的定位性能

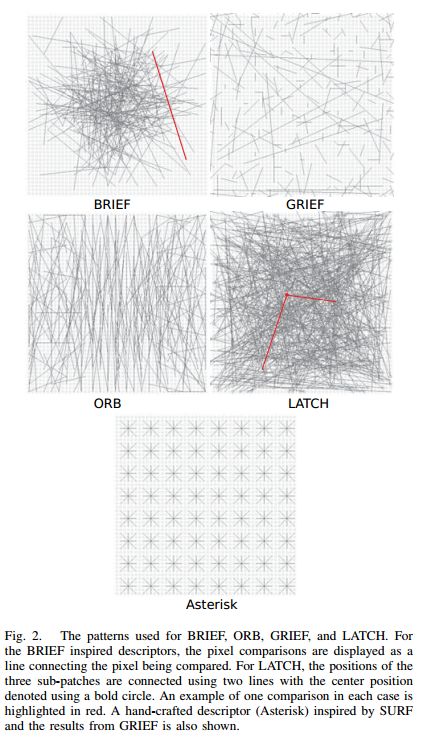

图2 用于BRIEF,ORB,GRIEF和LATCH的模式。对于简要启发描述符,像素比较显示为连接被比较像素的线。对于LATCH,使用两条线连接三个子贴片的位置,其中心位置用粗体圆圈表示。每种情况下一个比较的示例以红色突出显示。还展示了受SURF启发的手工制作的描述符(Asterisk)和GRIEF的结果

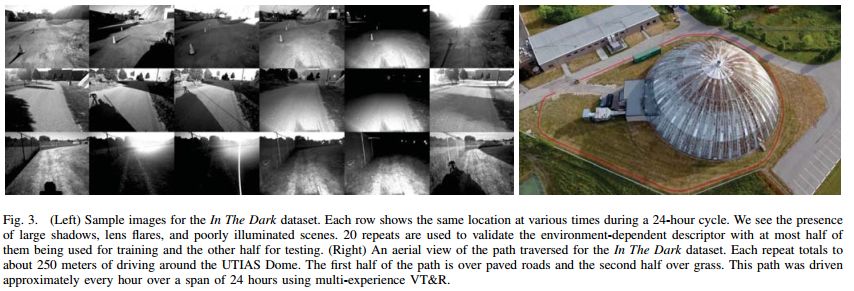

图3 (左)In The Dark数据集的示例图像。每行在24小时循环期间的不同时间显示相同的位置。我们看到存在大阴影,镜头光晕和光线不足的场景。20个重复用于验证依赖于环境的描述符,其中最多一半用于训练,另一半用于测试。(右)“In The Dark”数据集中遍历的路径的鸟瞰图。每次重复总计约为250米左右的UTIAS Dome。路径的前半部分是铺设的道路,后半部分是草地。使用多种体验VT&R,在24小时的范围内大约每小时驱动一条路径

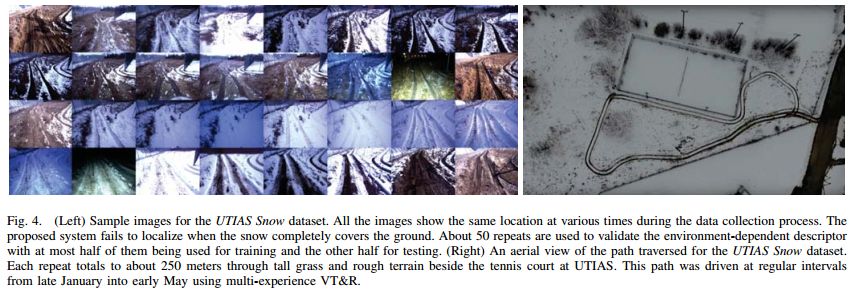

图4 (左)UTIAS Snow数据集的示例图像。所有图像在数据收集过程中的不同时间显示相同的位置。当雪完全覆盖地面时,所提出的系统无法定位。大约50次重复用于验证依赖于环境的描述符,其中最多一半用于训练,另一半用于测试。(右)UTIAS Snow数据集遍历的路径的鸟瞰图。每次重复总计约250米,穿过UTIAS网球场旁的高草和崎岖地形。使用多种体验的VT&R,从1月下旬到5月上旬定期推动这条路径

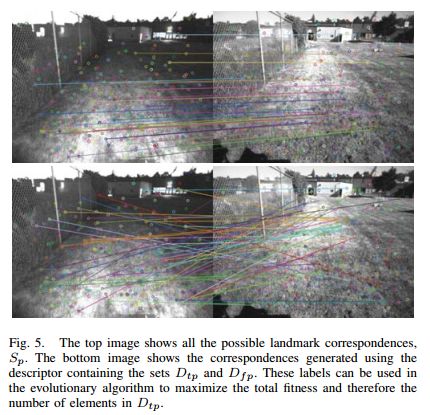

图5 顶部图像显示了所有可能的地标对应关系,Sp。底部图像显示了使用包含集合Dtp和Dfp的描述符生成的对应关系。这些标签可用于进化算法,以最大化总体适应度,从而最大化Dtp中的元素数量

图6 描述符模式随着时间的推移演变为In The Dark和UTIAS Snow超过200次迭代。在两种情况下,总适应度渐近收敛。红点表示进化过程通常终止并保存到图表中的点

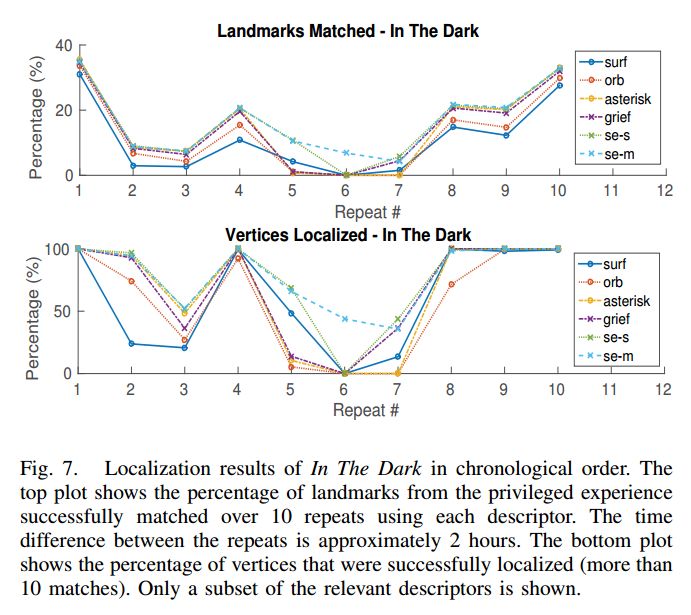

图7 In The Dark数据集的定位结果按时间顺序排列。顶部的图显示了使用每个描述符成功匹配超过10次重复的特权实验的地标百分比。重复之间的时间差约为2小时。底部的图显示了成功定位的顶点百分比(超过10个匹配)。仅显示相关描述符的子集

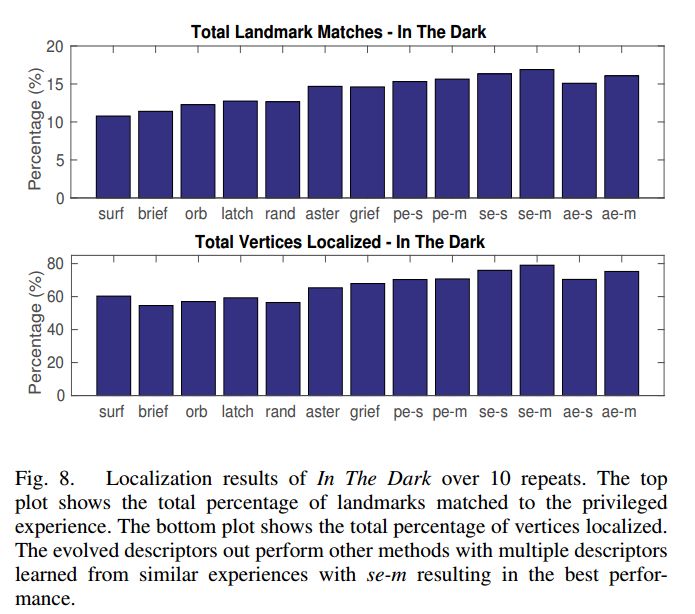

图8 In The Dark数据集的定位结果超过10次重复。上图显示了与特权体验相匹配的地标总百分比。底部的图显示了定位顶点的总百分比。演化的描述符执行其他方法,其中多个描述符从与se-m的类似体验中学习,从而产生最佳性能

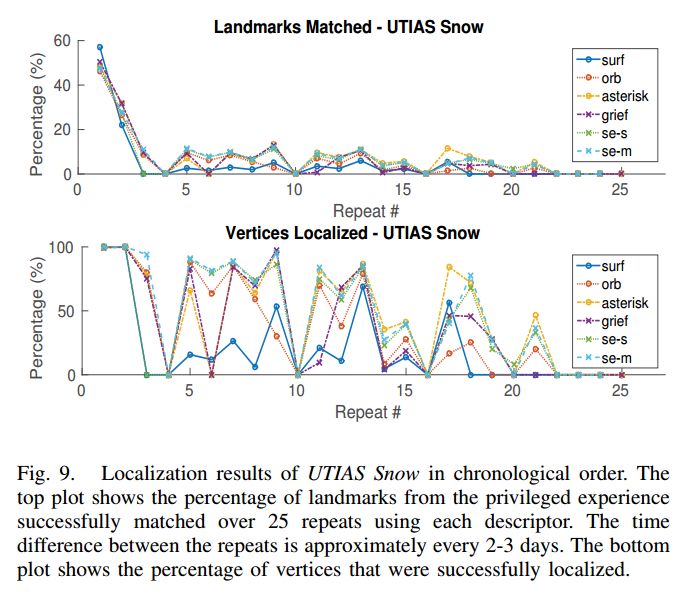

图9 UTIAS Snow数据集的定位结果按时间顺序排列。上图显示了使用每个描述符成功匹配超过25次重复的特权实验的地标百分比。重复之间的时间差大约每2-3天。底部图显示了成功定位的顶点百分比

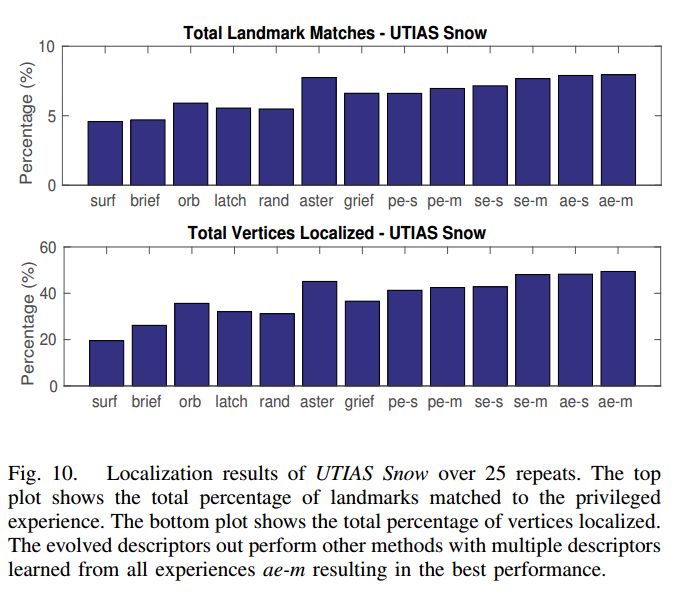

图10 UTIAS Snow数据集的定位结果超过25次重复。上图显示了与特权实验相匹配的地标总百分比。底部图显示了定位顶点的总百分比。演化的描述符执行其他方法,其中多个描述符从所有经验ae-m中学习,从而产生最佳性能

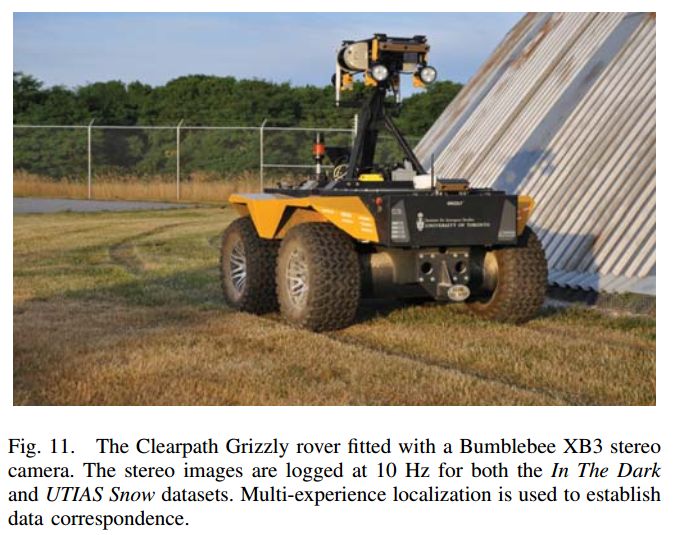

图11 Clearpath Grizzly流浪者配备了Bumblebee XB3立体相机。对于In The Dark和UTIAS Snow数据集,立体图像以10 Hz记录

Abstract

Vision-based navigation is extremely susceptible to natural scene changes. This can result in localization failures in less than a few hours after map creation. To combat short-term illumination changes as well as long-term seasonal variations, we propose using a place-and-time-dependent binary descriptor that adapts to different scenarios in an online fashion. This is achieved by extending the GRIEF [6] evolution algorithm in two ways: correspondence generation using a known pose change and the inclusion of LATCH triplets in addition to BRIEF comparisons for descriptor generation. We show the adaptive descriptor outperforms a single descriptor scheme for localization within a single-experience Visual Teach and Repeat (VT&R) system while maintaining the efficiency of binary descriptors. By adapting the description function to different environmental conditions, it allows the system to operate for a longer period before a new experience is required. In the presence of extreme illumination changes from day to night, we obtain 40% more inlier matches compared to SURF. In the case of seasonal variations, a 70% increase is demonstrated. The increased correspondences result in more localizable sections along the paths, amounting to a 25% and 150% increase in the lighting and seasonal cases, respectively.

如果你对本文感兴趣,请点击点击阅读原文下载完整文章,如想查看更多文章请关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

百度网盘提取码:bgol

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com