终于!吴恩达deeplearning.ai第5课开课了:敲黑板序列模型

机器之心报道

机器之心编辑部

在机器之心周二发布的文章《吴恩达宣布启动 AI Fund:1.75 亿美金进军 AI 创投》中,读者纷纷留言 deeplearning.ai 的第五课什么时候开始。终于,大家翘首期盼的课程今天开课了,同时也意味着该系列课程要结课了。自去年 8 月发布以来,吴恩达创业的第一个项目「深度学习教育课程」终于完整地呈现在人们的眼前。

课程链接:https://www.coursera.org/learn/nlp-sequence-models

和此前四门课程一样,新的课程仍将由吴恩达本人主讲。此外,斯坦福大学讲师 Kian Katanforoosh 与 Younes Bensouda Mourri 也将参与授课。

吴恩达 deeplearning.ai 的五门课程

第一门:神经网络和深度学习

课程学习时间:四周,每周 3-6 小时

第二门:提升深度神经网络—调整超参数、正则化与优化

课程学习时间:三周,每周 3-6 小时

第三门:构建机器学习项目

课程学习时间:两周,每周 3-4 小时

第四门:卷积神经网络

课程学习时间:四周,每周 4-5 小时

第五门:序列模型

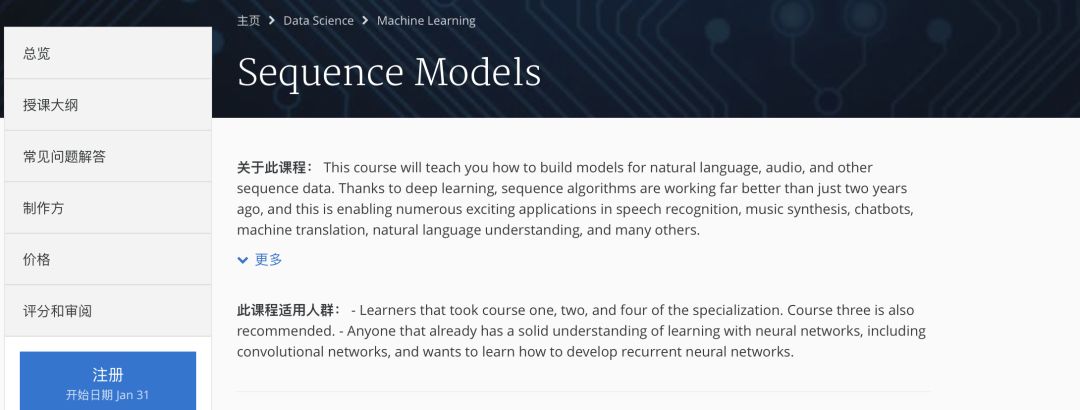

课程简介

本课程将讲授如何构建自然语言、音频和其他序列数据的模型。在深度学习的帮助下,序列算法比两年前效果更好,用于大量有趣的应用,如语音识别、音乐合成、聊天机器人、机器翻译、自然语言理解等。学完本课,你将:

了解如何构建和训练循环神经网络(RNN)及其常用变体,如 GRU 和 LSTM。

使用序列模型处理自然语言问题,如文本合成。

将序列模型应用到音频应用中,如语音识别和音乐合成。

这是 Deep Learning Specialization 课程的第五课,也是最后一课。

适用人群

学完第一、二、四课的学习者。同样推荐大家学习第三课。

已经对神经网络(包括 CNN)具备深厚理解,并想学习如何开发循环神经网络的人。

授课大纲

该课程共分为三部分,学员可分三周完成。

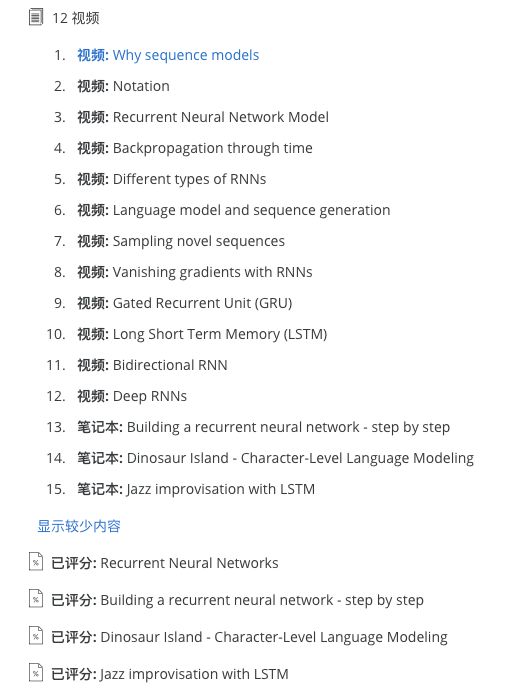

第 1 周:循环神经网络(RNN)

学习循环神经网络。RNN 模型被证明在时序数据上性能非常好。它有多种变体,如 LSTM、GRU 和双向 RNN,本节将对此进行介绍。

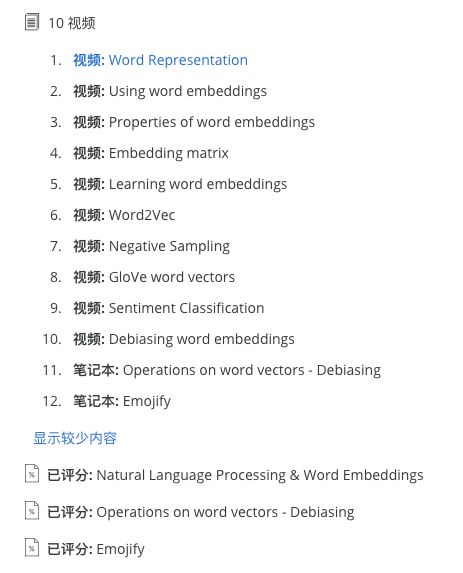

第 2 周:自然语言处理 & 词嵌入

自然语言处理和深度学习的结合非常重要。使用词向量表示和嵌入层可以训练出在多个行业中性能优秀的循环神经网络。应用实例如情感分析、命名实体识别和机器翻译。

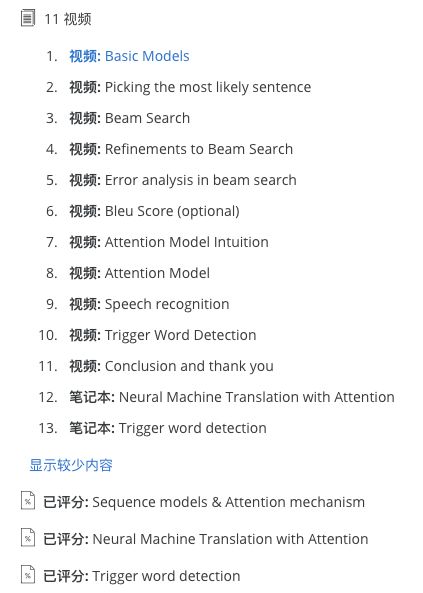

第 3 周:序列模型 & 注意力机制

序列模型可通过注意力机制获得增强。这一算法有助于模型在给定输入序列的情况下了解其注意力的聚焦点。本周,你还将学到有关语音识别的知识,以及如何处理音频数据。

参考资料

在学习该课程之前,机器之心为大家准备了一些学习资料做准备,内容包括循环神经网络的综述论文、LSTM、GRU等循环神经网络变体的介绍、LSTM的原理解读、教程等。

前四课学习笔记

Deeplearning.ai 课程开课以来,一直受到大家的关注,也有众多读者积极的参与到学习中。机器之心在这段时间内也介绍了多篇该系列课程的学习笔记,还未学习前四课的同学可以参考一下文章:

最后,如果大家完成该课程后有课程心得分享,机器之心非常乐意推荐给所有读者,欢迎大家积极投稿。

本文为机器之心报道,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者/实习生):hr@jiqizhixin.com

投稿或寻求报道:editor@jiqizhixin.com

广告&商务合作:bd@jiqizhixin.com