语音合成的里程碑:百度推出首个完全端到端的TTS模型

语音合成,也被称作TTS(text-to-speech),该技术的应用目前已十分广泛了,例如智能家居设备和智能助手等,论智也曾报道过很多相关研究项目。

近日,百度研究院推出了他们有关TTS的成果——ClariNet,成为百度在TTS研究上的又一里程碑。此前基于神经内网络的TTS模型是将优化的文本到声谱图和波形合成模型分开来的,这可能会导致不理想的表现。而ClariNet第一次做到了用完全的端到端TTS模型,直接将文本转换成波形图,并且只需要一个神经网络即可。它的全卷积结构能够从零开始快速地训练。ClariNet在语音的自然度方面成功地超越了其他方法。以下是论智对这篇论文的编译。

论文摘要

WaveNet是DeepMind去年推出的基于深度学习的语音生成模型,它可以生成平行的语音波形,即整个句子中所有的词语都可以同时生成对应的波形。现在,我们提出了一种替代WaveNet的方法,我们从自回归的WaveNet中提取一个高斯逆自回归流(Gaussian Inverse autoregressive flow),并且以闭合形式计算KL散度,简化了训练算法并且提供了非常高效的蒸馏过程。除此之外,我们还提出了首个针对语音合成的文本到波形的神经架构(text-to-wave),这是全卷积的,并且可以快速地从零开始进行端到端训练。除此之外,我们还成功地在模型的隐藏表示中创建了并行波形生成器。

并行波形生成

在模型中,我们用高斯自回归WaveNet作为“老师网络”,将高斯逆自回归流作为“学生网络”。2018年,Oord等人提出了概率密度蒸馏法来降低逆自回归流(IAF)的最大可能学习中的难度。蒸馏过程中,学生网络IAF试着将它自己的样本分布与在自回归的WaveNet中训练的样本相匹配。然而,学生网络IAF的输出逻辑分布和教师网络WaveNet的输出之间的KL散度是不相容的,必须使用蒙特卡罗方法进行大概计算。而最终并行的WaveNet需要在蒸馏过程中进行双次采样:首先要将白噪声输入到学生网络中,然后从学生网络的输出分布中选择多个不同样本对KL散度进行估计。

但是在我们的模型中,加入了高斯设置,密度蒸馏方法只需要一个白噪声样本,然后将其输入封闭的KL散度计算中。我们的学生IAF网络在蒸馏过程中和老师WaveNet使用同一个条件网络(2D卷积层)。

Text-to-Wave架构

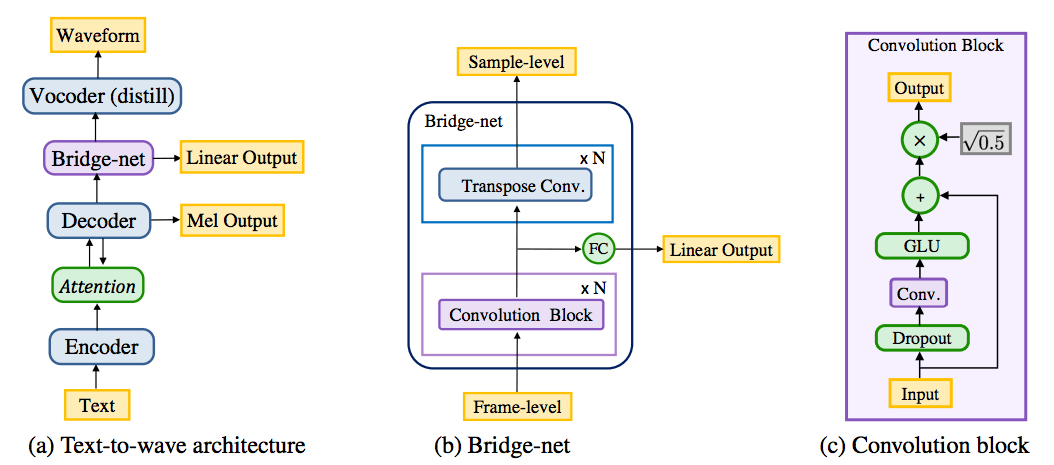

我们的卷积text-to-wave架构如下图所示:

它是基于另一个基于注意力的卷积TTS模型——Deep Voice 3创建的。Deep Voice 3能够将文本特征(例如字符、音素、强调等)转换成波谱特征(例如log-mel声谱和log-linear声谱)。这些波普特征可以输入到训练波形合成的模型中,例如WaveNet。相反,我们直接将从注意力机制中学习到的隐藏表示输入到神经语音编码器中,用端到端的方式从零训练整个模型。

我们所提出的架构包含四个部分:

编码器:一个和Deep Voice 3相同的编码器,它可以将文本特征编写进内部的隐藏表示。

解码器:同样和Deep Voice 3相同,可以用自回归的方式将编码器中的内容加码城log-mel声谱。

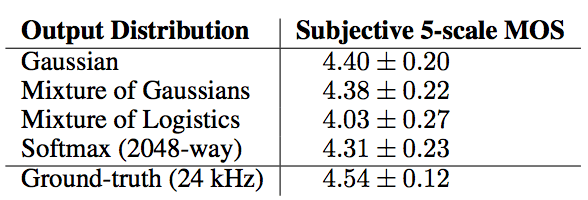

Bridge-net:这是一个卷积中间处理模块,它可以从解码器中处理隐藏表示,并且预测log-linear声谱。与解码器不同的是,它并非是因果联系的,并且可以使用未来的语境。另外,它还可以从框架层到采样层对隐藏表示进行上采样。

语音编码器:高斯自回归WaveNet可以合成波形,但是只能在上采样后的隐藏表示中实现。而它可以由自回归语音编码器的学生IAF网络替换。

实验过程

我们进行了几组实验来评估所提出的并行波形生成方法和text-to-wave结构。我们用了20个小时的英文演讲作为训练数据,下采样后音频变为24kHz。

首先我们测试了生成语音的自然程度,用MOS分数表示:

结果表示,高斯自回归WaveNet和MoGul以及softmax输出水平相当,比MoL要好。

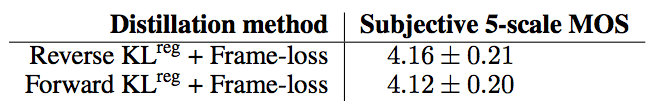

接着我们将一个60层的并行学生网络从20层的高斯自回归WaveNet中进行蒸馏,它包括6个堆叠的高斯逆自回归流,每个流都由一个10层的WaveNet进行参数化。我们测试了前向和逆向KL散度,结果如下:

两种蒸馏方法都得到了不错的分数,我们希望未来加入感知和对比损失后会进一步提升。

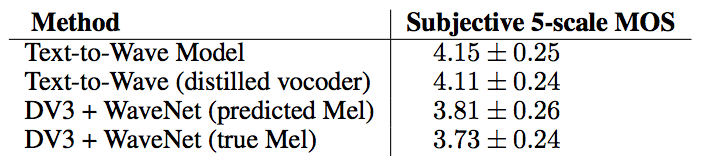

最后我们从零训练了text-to-wave模型,并将其与Deep Voice 3中的同类模型相比,结果如下:

该分数表明text-to-wave模型明显比其他模型表现得好,并且有经过蒸馏的语音编码器的模型呢自回归神经编码器的表现水平相当。

具体的语音合成可以看下面这个例子:

结语

百度在语音合成方面的确做出了许多努力,今年三月,他们还推出了神经语音克隆系统,只需输入少量样本就能合成逼真语音。而今天的ClariNet是语音合成的又一里程碑,是该领域第一个真正的端到端模型,在GPU上取得了更高质量的结果。具体技术细节可查看原论文:arxiv.org/pdf/1807.07281.pdf

更多语音合成案例可查看:clarinet-demo.github.io/