NAACL 2022 | TAMT:通过下游任务无关掩码训练搜索可迁移的BERT子网络

©PaperWeekly 原创 · 作者 | 刘源鑫

单位 | 中科院信工所

研究方向 | 模型压缩

论文标题:

Learning to Win Lottery Tickets in BERT Transfer via Task-agnostic Mask Training

NAACL 2022

https://arxiv.org/abs/2204.11218

https://github.com/llyx97/TAMT

以 BERT 的问世为标志,“预训练+ 下游任务微调”成为了 NLP 任务的一个主流范式。研究趋势显示,持续增长的参数量是预训练语言模型(PLM) 获得成功的一个关键因素。然而,这也增大了 PLM 在下游任务微调和部署的开销。

与此同时,近期关于彩票假设(Lottery Ticket Hypothesis, LTH [1])的研究 [2]发现,基于权重的剪枝(magnitude-based pruning)可以在预训练的 BERT 模型中发现一些 winning ticket 子网络,它们可以迁移到多个下游任务微调,并取得和完整 BERT 相当的效果。

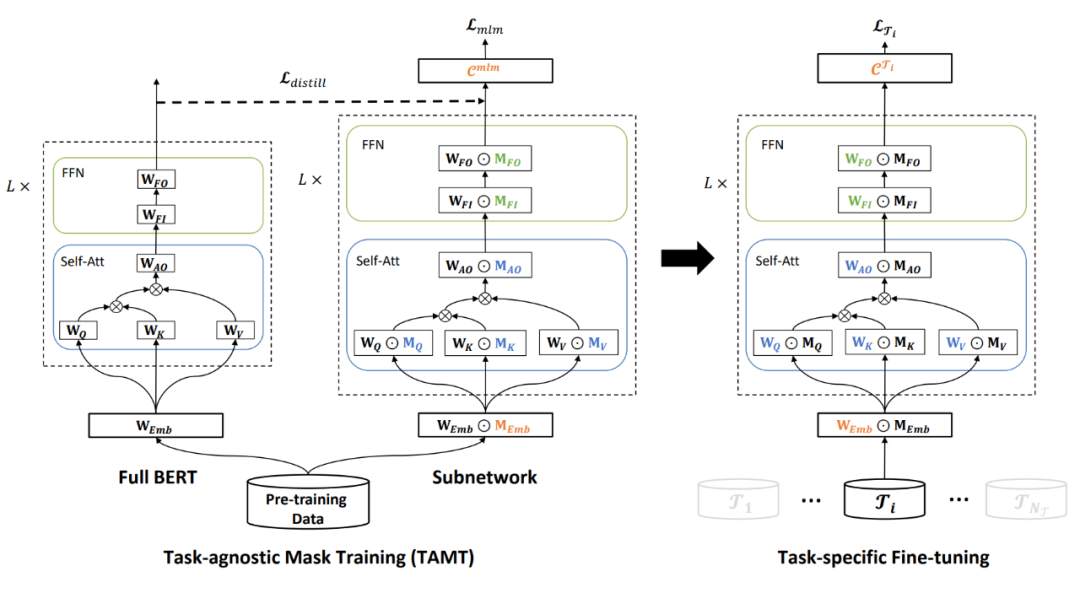

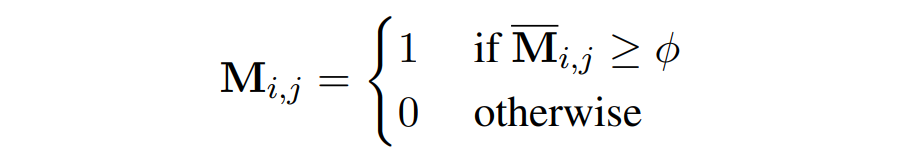

▲ 图2 TAMT在预训练任务上(MLM或知识蒸馏)学习子网络结构,然后将其迁移到不同的下游任务进行微调

其中 和 分别为学习率和损失函数。

实验

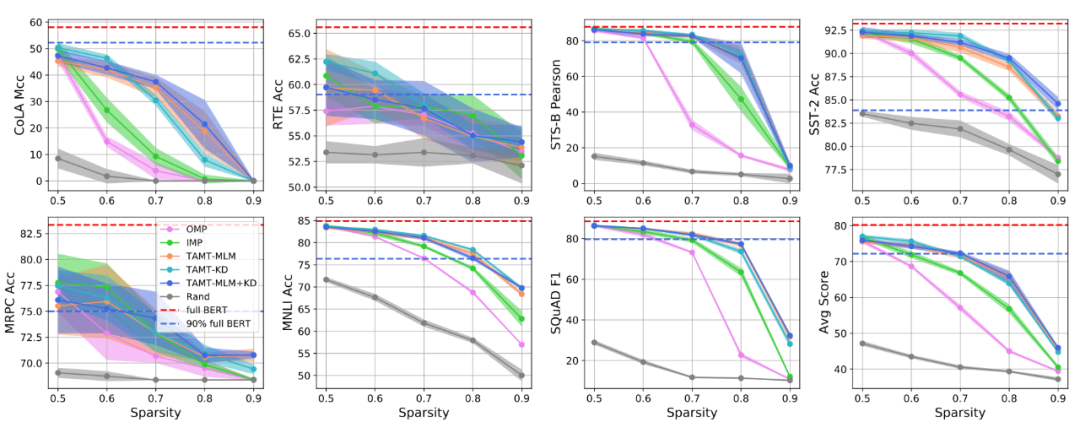

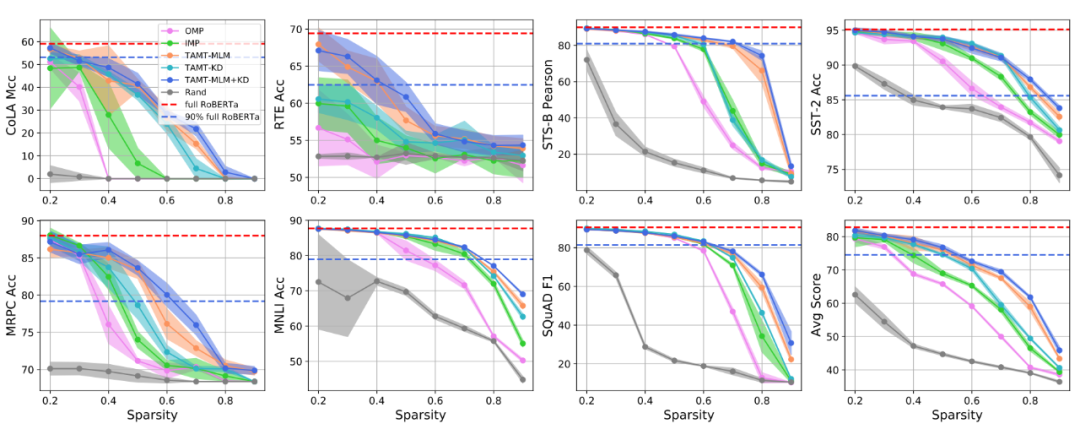

模型:在主实验中,我们选用 BERT-base 和 RoBERTa-base 两种预训练语言模型。在其余实验分析中,我们主要以 BERT-base 为研究对象。

基线方法:我们主要和基于权重剪枝的方法对比,包括 OMP 和在 MLM 任务上进行的迭代权重剪枝(Iterative Magnitude Pruning, IMP)。

▲ 图4 RoBERTa及其子网络的下游任务表现

-

权重剪枝和 TAMT 都明显优于随机子网络,在较低 sparsity 下可以保留完整模型的大部分性能。 -

采用不同训练目标的三种 TAMT 方法都优于 IMP 和 OMP,在较高的 sparsity 下可以找到迁移能力更强的 BERT/RoBERTa 子网络。 不同的 TAMT 训练目标对于 BERT 子网络影响不大,而对于 RoBERTa,TAMT-KD+MLM > TAMT-MLM > TAMT-KD。这说明 MLM 和 KD 两种目标具有一定的一致性,或者至少不是冲突的。

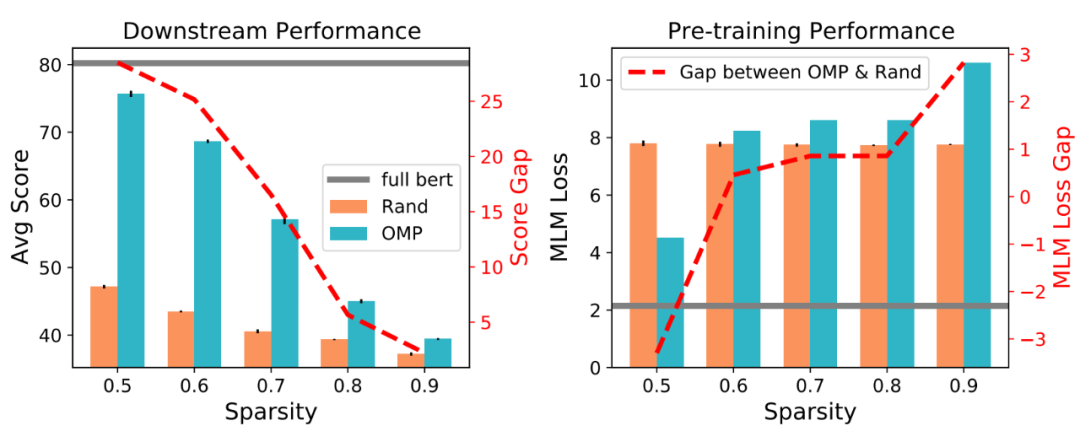

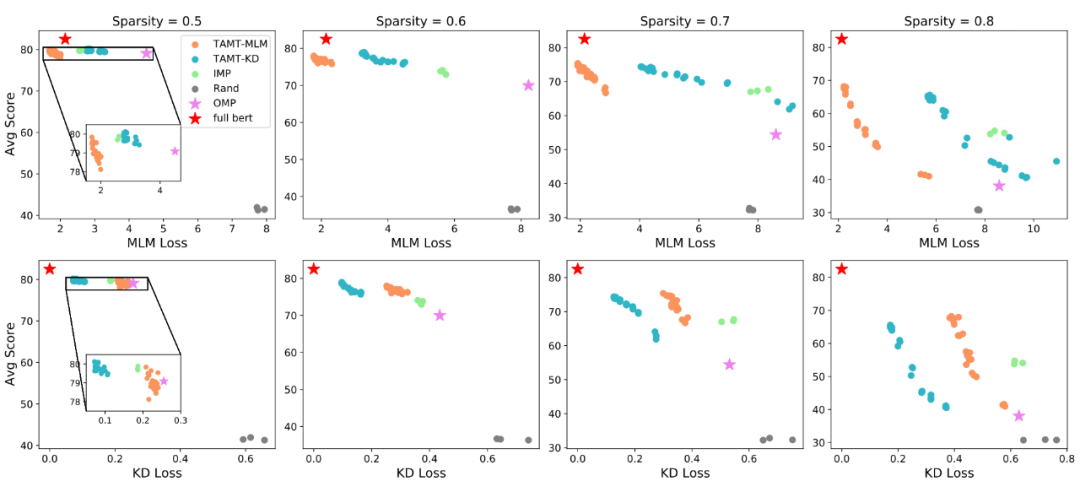

3.3 预训练效果和下游任务效果的关系

▲

图5 预训练任务(MLM及KD)dev loss和下游任务平均性能的关系

▲

图5 预训练任务(MLM及KD)dev loss和下游任务平均性能的关系

为了验证 TAMT 子网络下游任务性能的提升是否真的来源于预训练任务性能的提升(我们的动机),我们计算了 TAMT 过程中子网络在相应任务上的 dev loss,并且将之和下游任务性能联系起来。如图 5 所示,我们发现:

-

TAMT-MLM 和 TAMT-KD 分别具有最低的 MLM 和 KD loss,说明在 TAMT 过程中,子网络结构的确按照我们设定的目标被优化。 -

同时,子网络在下游任务上的性能也随着 TAMT 对其结构的优化而逐渐提升。这说明了 BERT 子网络的预训练任务性能和下游任务(微调后)性能之间的确存在相关性,也证明了我们动机的合理性。

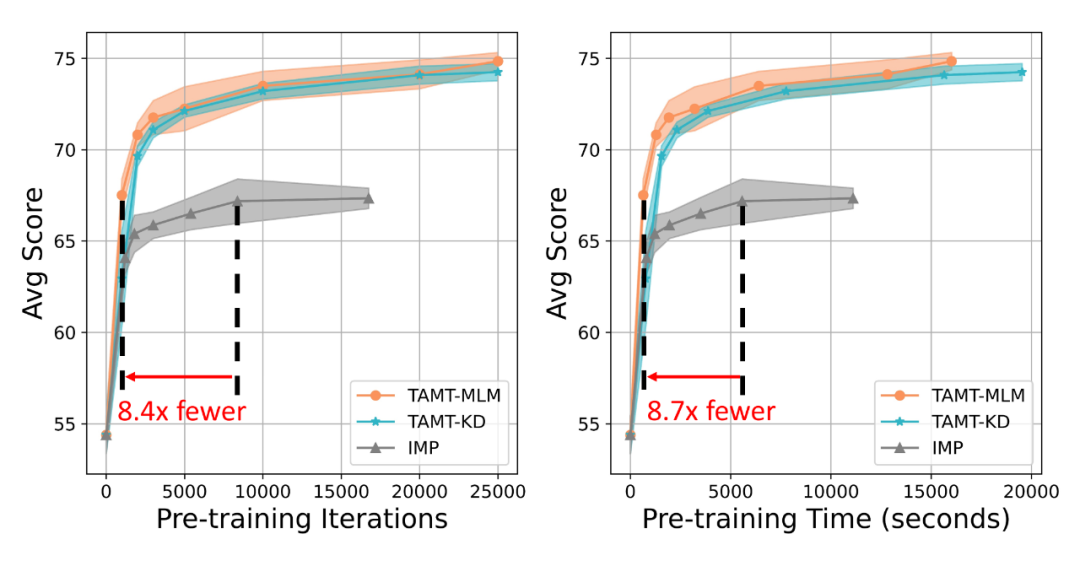

3.4 子网络搜索开销和下游任务效果的关系

![]() ▲ 图6 不同预训练步数(左)和时间(右)下搜索到的子网络(70% sparsity)的下游任务平均性能

▲ 图6 不同预训练步数(左)和时间(右)下搜索到的子网络(70% sparsity)的下游任务平均性能

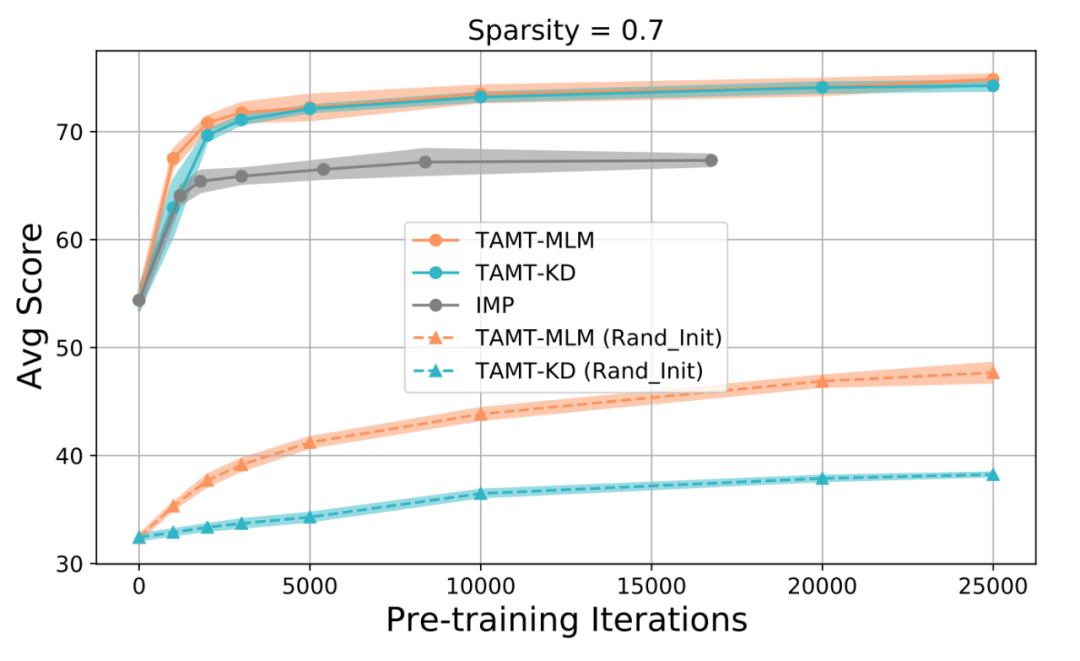

3.5 子网络结构初始化的影响

▲ 图7 OMP初始化和随机初始化的对比

在以上实验中,我们默认采用 OMP 子网络作为 TAMT 的初始化。为了验证这么做的必要性,我们将 OMP 初始化和随机初始化进行对比。如图 7 所示,当 TAMT 以随机子网络为初始化时,随着训练进行下游任务迁移效果仍然可以稳定提升。但是相比于 OMP 初始化,随机初始化训练收敛后的最终结果要差很多。

总结及未来方向

在本文中,我们关注搜索可迁移的 BERT 子网络的问题。我们发现 BERT 子网络的下游任务迁移效果和其在预训练任务上的效果呈正相关。受此启发,我们提出利用下游任务无关掩码训练(TAMT)的方法搜索可迁移的 BERT 子网络。相比于启发式的权重剪枝方法,利用 MLM 或知识蒸馏作为训练目标的 TAMT 可以搜索到下游任务效果更好的 BERT 子网络,这在现有工作的基础上揭示了 BERT 子网络具有更强的下游任务迁移能力。同时 TAMT 在子网络搜索过程中也比迭代权重剪枝更加高效。

在本文中我们关注非结构化子网络,这需要特殊的硬件支持才能实现实际部署中的运算加速。因此在未来工作中可以探究用 TAMT 搜索结构化 BERT 子网络的效果。

TAMT 以及其他方法搜索到的子网络在 90% sparsity 下的效果都还不理想,因此另一个有意义的未来研究方向是探究如何改进 TAMT,从而在更高 sparsity 下搜索到可迁移的 BERT 子网络。

-

为了实现这个目标,一个可行的方向是探究其他下游任务无关训练目标。

参考文献

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧