ResNet最强改进版来了!ResNeSt:Split-Attention Networks

加入极市专业CV交流群,与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度 等名校名企视觉开发者互动交流!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

前言

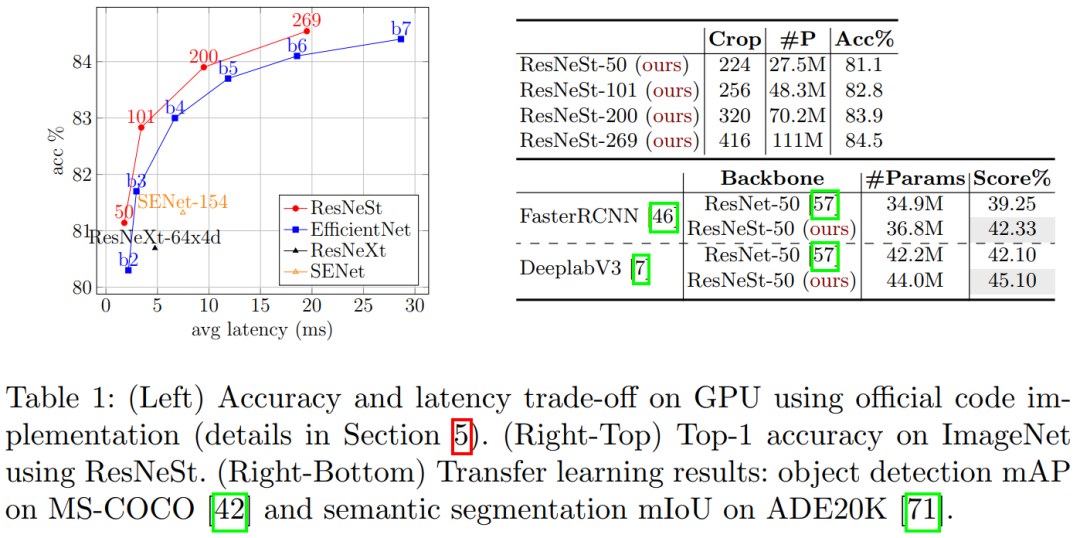

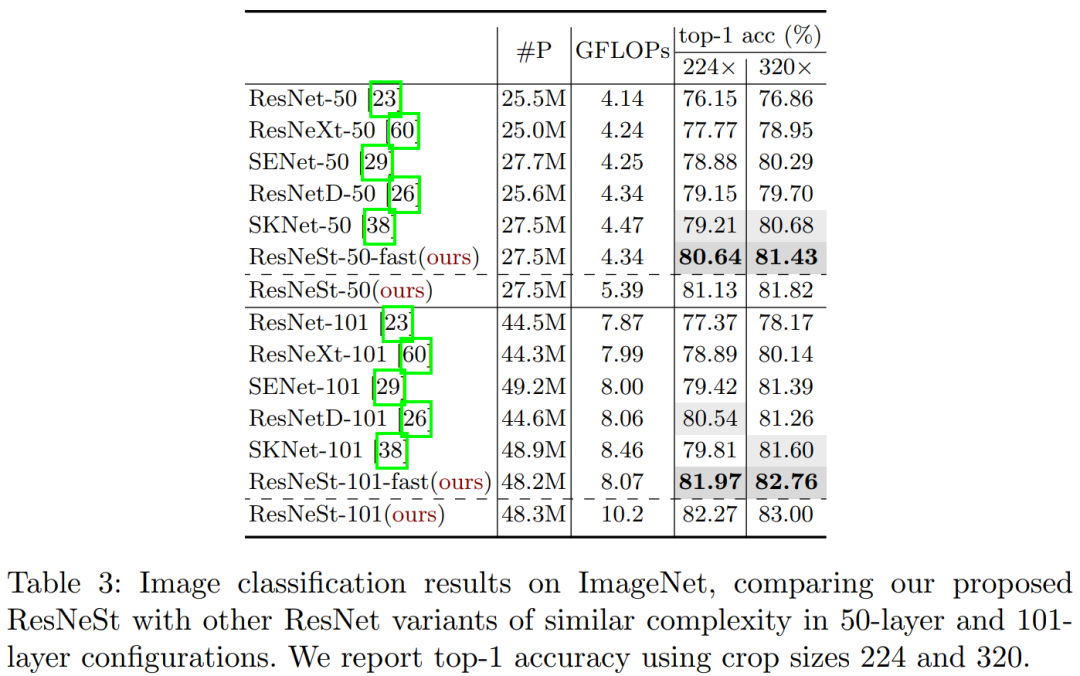

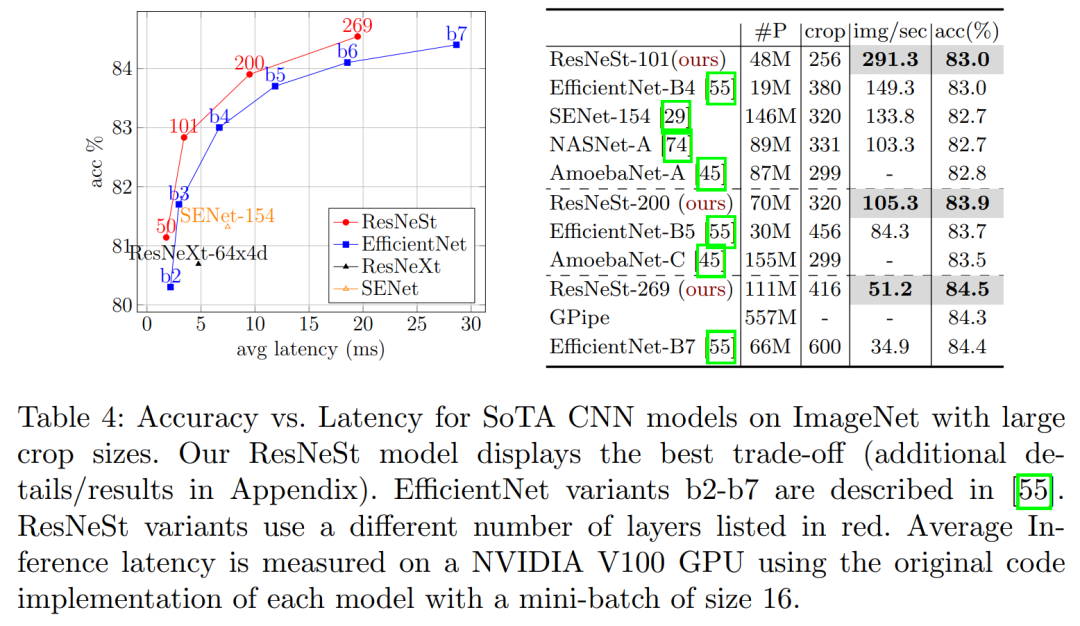

ResNeSt-50 在 ImageNet 上实现了81.13% top-1 准确率

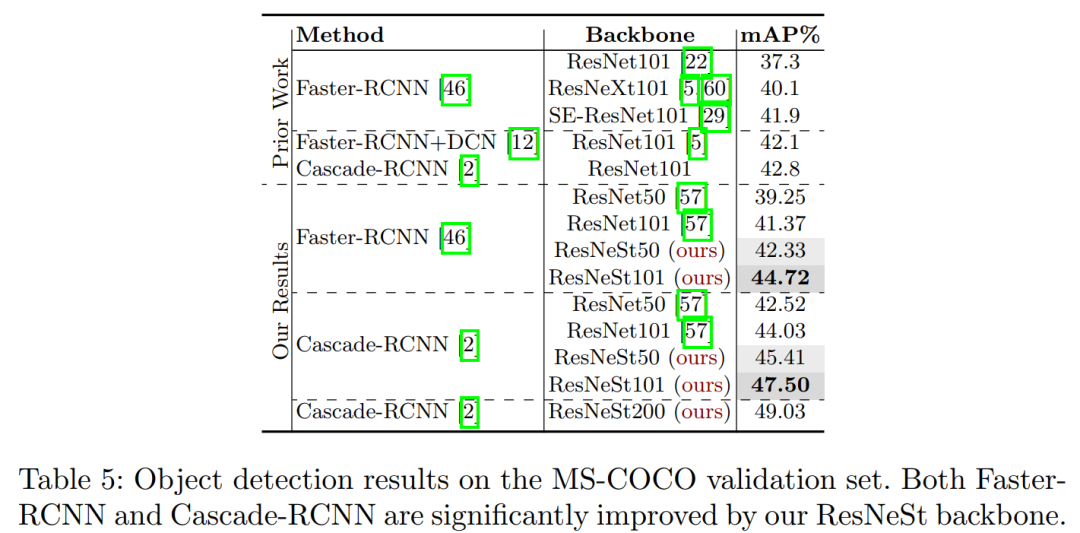

简单地用ResNeSt-50替换ResNet-50,可以将MS-COCO上的Faster R-CNN的mAP从39.25%提高到42.33%!

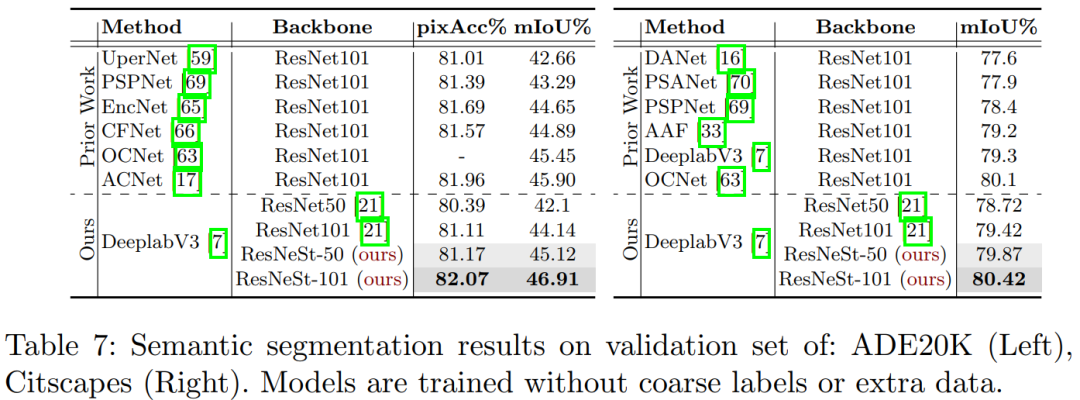

简单地用ResNeSt-50替换ResNet-50,可以将ADE20K上的DeeplabV3的mIoU从42.1%提高到45.1%!

ResNeSt

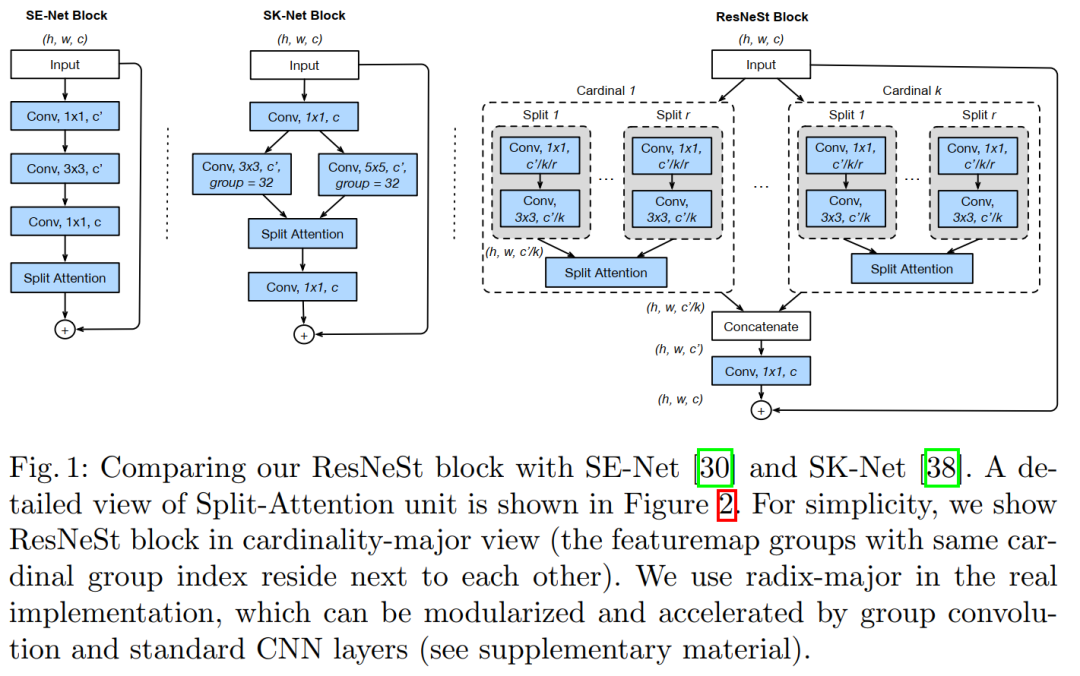

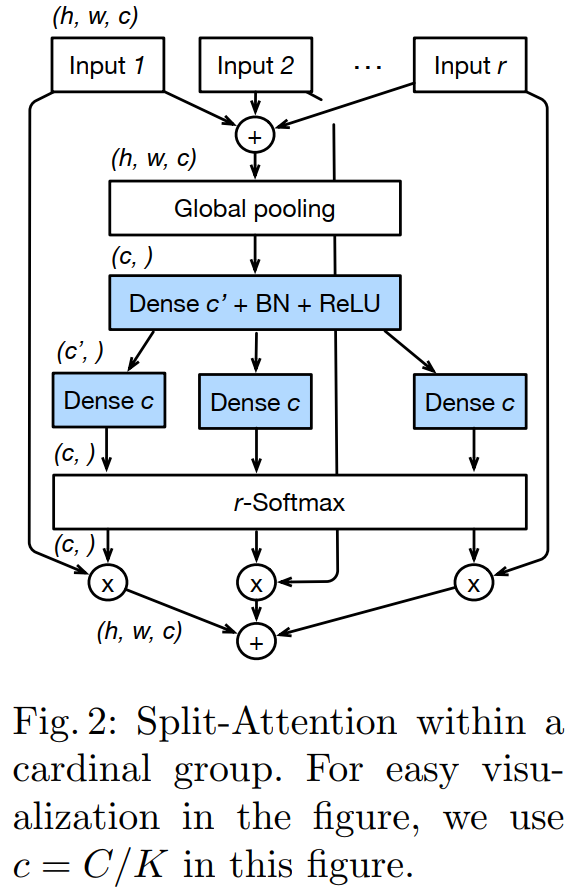

GoogleNet 采用了Multi-path机制,其中每个网络块均由不同的卷积kernels组成。

ResNeXt在ResNet bottle模块中采用组卷积,将multi-path结构转换为统一操作。

SE-Net 通过自适应地重新校准通道特征响应来引入通道注意力(channel-attention)机制。

SK-Net 通过两个网络分支引入特征图注意力(feature-map attention)。

Large Mini-batch Distributed Training

Label Smoothing

Auto Augmentation

Mixup Training

Large Crop Size

Regularization

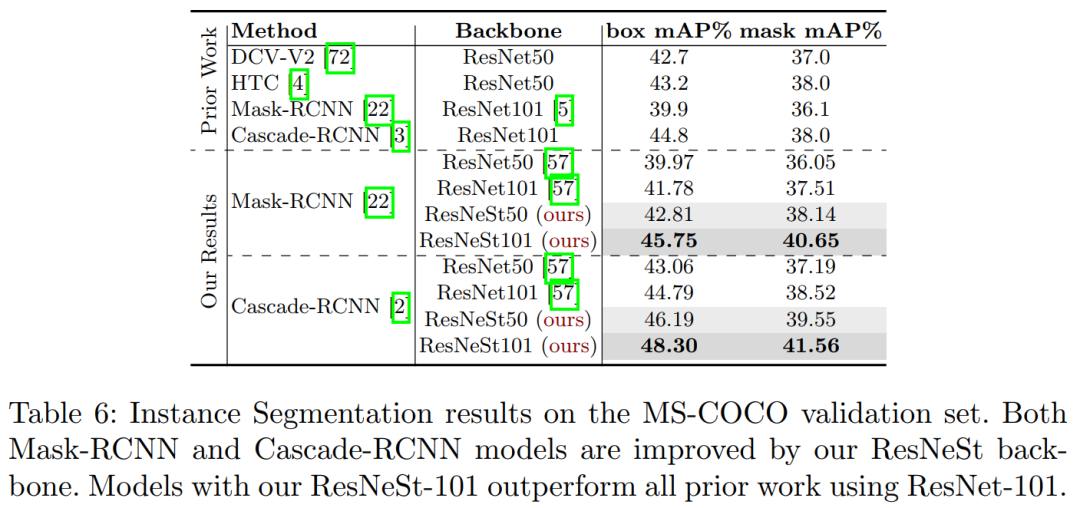

实验结果

论文下载

推荐阅读:

△长按添加极市小助手

△长按关注极市平台,获取最新CV干货

觉得有用麻烦给个在看啦~

登录查看更多

相关内容

专知会员服务

29+阅读 · 2020年3月27日

Arxiv

4+阅读 · 2018年2月19日

Arxiv

4+阅读 · 2018年1月30日