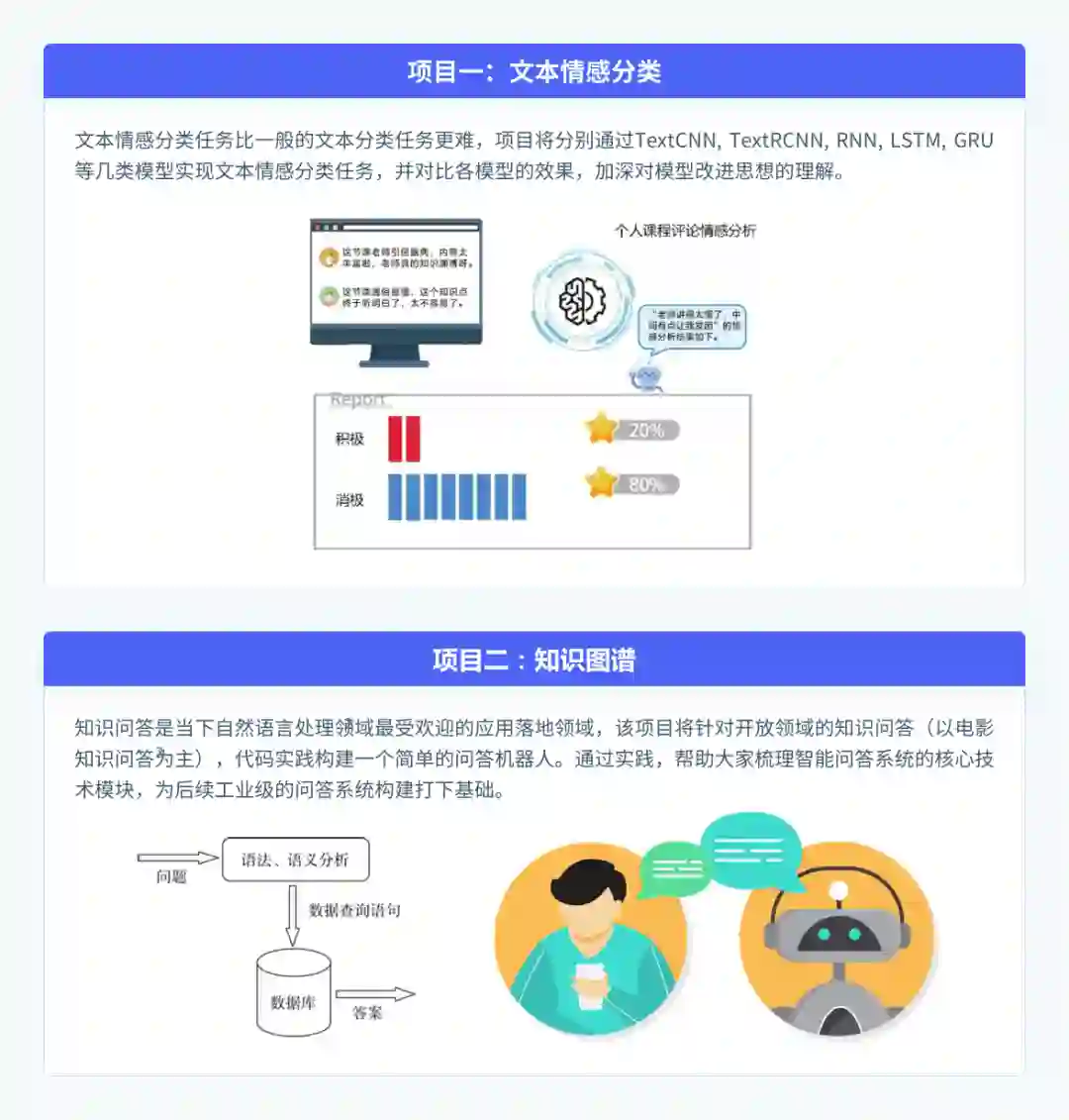

Bert、GPT、RNN、LSTM等模型详解

文末免费领取NLP学习资料

自然语言处理(NLP)是融合计算机科学、人工智能、语言学等学科的交叉领域,是一种更高层次的信号表达形式,也是人工智能最难攻克的领域之一。

随着互联网的快速发展,网络文本,尤其是用户生成的文本呈爆炸性增长,为自然语言处理带来了巨大的应用需求。在过去的五到十年间,RNN, LSTM, Transformer为NLP的发展源源不断地注入动力,近两年比较热的预训练模型,比如Bert系列,GPT系列都是基于Transformer这一基础的。

很多伙伴也纷纷加入了NLP的热潮中,然而大多伙伴在自学时常常会进入误区:

• 对基础理论敬而远之,认为理论太高深了,自己基础不好,学了也白学;

(点击查看大图)

文末免费领取试听课程

抢占优惠名额

原价699元

现在报名,即可优惠 50 元

(部分论文集展示)

登录查看更多

相关内容

专知会员服务

79+阅读 · 2019年12月29日

Arxiv

16+阅读 · 2017年11月20日