干货 | 谷歌2019最火NLP模型Bert应用详解

Q:为什么2019年的NLP会这么的骚!

A:因为在过去的一年 NLP 领域为人工智能行业带来了以下突破性进展:

1. 迁移学习在 NLP 的成功应用;

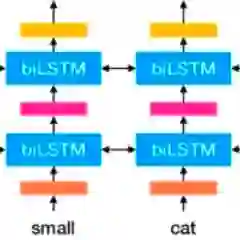

2. ELMo (Embeddings from Language Models),改进了 word2vec 或 GloVe 等Context-Free的Embedding模型。

3. GPT(Generative Pretrained Model),BERT (Bidirectional Encoder Representations from Transformers),MT-DNN(Multi-Task DNN)、GPT-2等基于上下文的预训练NLP模型不断刷新各项NLP任务State-of-Art的榜单。

4. 贪心学院开设了免费的NLP系列公开课!

小编本周联合贪心学院放大招~

本周我们将在公开课中,

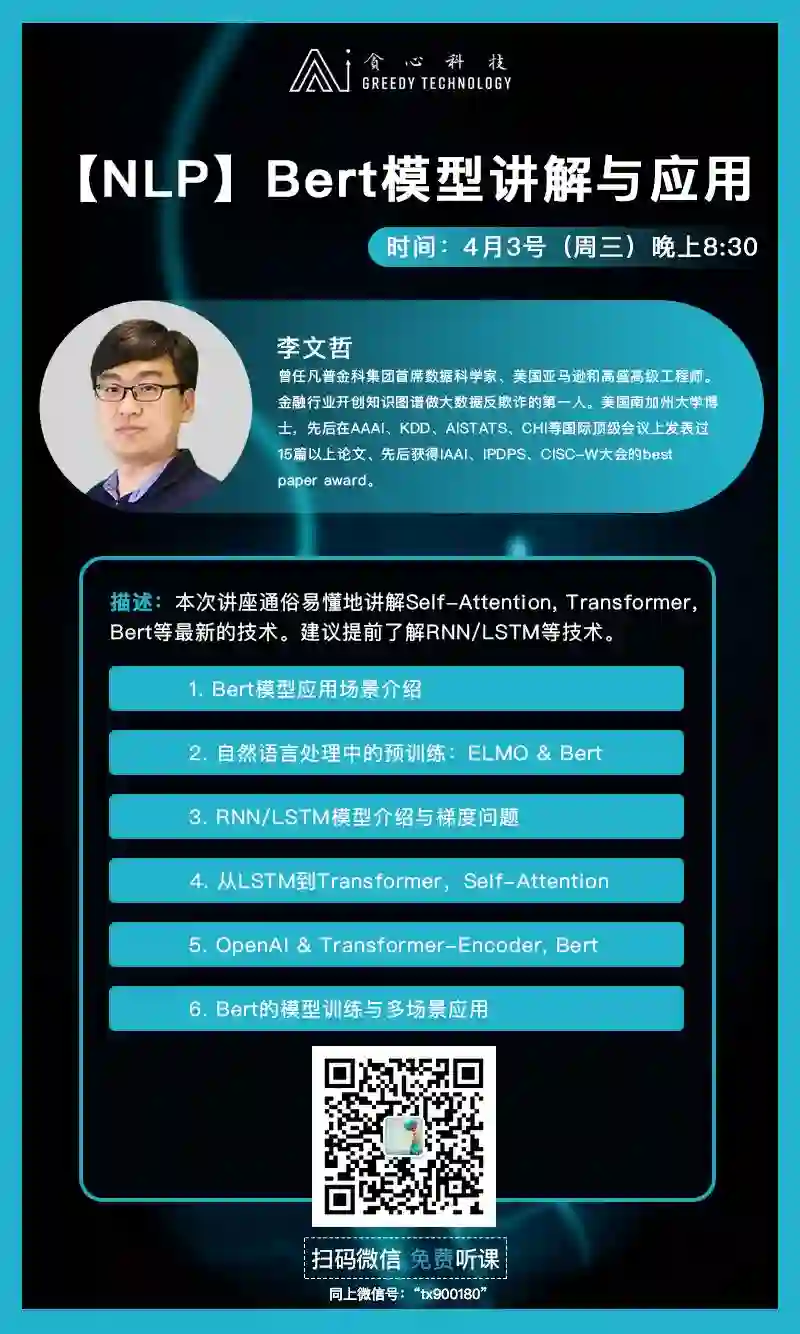

首次为大家讲述2019年NLP领域最火的模型Bert!

Google团队在2018年发布了撼动自然语言处理(NLP)领域的Bert模型。在模型开源后的短短几个月时间里,已经有学者表示Bert为人工智能的发展带来了里程碑式的意义。

然而Bert是否是被吹的神乎其神?它可以被应用在哪些场景?它又有着怎么样的局限性?想要理解Bert模型,首先我们需要把attention和transformer的原理讲清楚。

这节公开课,我们将已经从Bert的诞生开始,带你扒一扒学完就可以去面试Google的Bert模型。

详解2019年最火的NLP模型【Bert】:

Self-Attention, Transformer以及Bert

Bert模型应用场景介绍

自然语言处理中的预训练:ELMO & Bert

RNN/LSTM模型介绍与梯度问题

从LSTM到Transformer, Self-Attention

OpenAI & Transformer-Encoder, Bert

Bert的模型训练与多场景应用

李文哲

贪心科技创始人兼CEO

美国南加州大学博士,曾任凡普金科(爱钱进)首席科学家,美国亚马逊/高盛高级工程师,AI量化投资公司首席科学家兼投资总监。在AAAI, KDD, AISTATS等顶会上发表过15篇以上论文,其中3篇获得Best Paper Award,累计数百次引用。

扫码人有点多,小姐姐忙不过来

请直接添加微信号:tx900180

每期公开课具体主题由学员投票决定

如何搭建一个聊天机器人

-各类架构剖析及实现

聊天机器人的种类与评估

基于检索的方法论

基于模式匹配的方法论

基于意图识别的方法论

基于端到端的方法论

如何给文章自动生成摘要

(Text Summarization)

是自动生成摘要?

主要的应用场景

基于抽取式的方法(Extractive)

实战案例:利用抽取式方法编写简单的Summarizer

基于生成式的方法(Abstractive)

信息抽取领域中的利器

-命名实体识别技术与应用

什么是命名实体识别?

命名实体的应用场景

从文章中识别实体

案例:简历中提取实体

基于自身的场景训练命名实体识别器

作为一名AI从业者,你不得不知道的三个概念:

MLE,MAP和贝叶斯估计

用一个例子来形象地说明三者之间的区别

详谈MLE与MAP

Ridge Regression与LASSO

不同先验概率与正则关系

贝叶斯估计的挑战

浅谈蒙特卡洛算法

更多NLP公开课等你来听.....

文本的表示:从词袋模型到词向量

机器学习中的 MLE vs MAP vs 贝叶斯估计

零基础搭建简单的问答系统

怎么用知识图谱做金融风控系统

利用端到端的学习搭建无人驾驶系统

搭建一个简单的目标检测系统

可解释性:深入浅出深度学习中的可视化

一小时弄清楚什么是卷积神经网络

特征工程:细聊风控中的特征工程技术

自适应系统的核心:Knowledge Tracing

利用Seq2Seq模型来构建机器翻译系统

一个小时弄清凸优化技术以及其应用场景

零基础入门双曲空间中的图嵌入

主题模型LDA的详解

从本质理解深度学习为什么需要“深”?

AI领域的研究怎么做,怎么高效发论文?

公司怎么转型AI,需要什么样的AI人才?

自动化代码的生成、批改、代码嵌入

推荐系统中的常见算法介绍

随机梯度下降法中的收敛理论

SGD, Adagrad, Adam算法的详细比较

一小时实现图像中的风格迁移

一小时实现语音中的情绪识别

图嵌入算法详解以及引用

自适应系统所涉及到的技术要点

用目标检测和跟踪算法分析英雄联盟视频

一小时用Keras搭建人脸识别系统

Google的最新作品BERT模型详解以及实现

一小时实现机器自动写代码系统

(持续更新中。。)

如果数学,编程,PYTHON语言这些基础,你一点都没有,恭喜你,你将收获这四门公开课98%的营养精华!这波稳赚~

扫描海报二维码小姐姐加你进群

参加免费NLP公开课

扫码人有点多,小姐姐忙不过来

请直接添加微信号:tx900180

李文哲: 美国南加州大学博士,曾任凡普金科(爱钱进)首席科学家,美国亚马逊/高盛高级工程师,AI量化投资公司首席科学家兼投资总监。在AAAI, KDD, AISTATS等顶会上发表过15篇以上论文,其中3篇获得Best Paper Award,累计数百次引用。

蓝振忠:美国卡耐基梅龙大学博士。现任Google科学家,曾任美国智能监控公司的首席科学家, 对视频和多媒体的智能分析有深入研究。他曾代表卡耐基梅隆大学在美国国家标准总局(NIST)举办的视频智能分析大赛中连续多年进入前三。先后在NIPS、CVPR、ICCV、IJCAI、ICDM等国际顶级会议上发表过25篇以上的论文,论文引用次数上千。

史源:美国南加州大学博士,美国AI基金创始人,拥有10多年人工智能领域相关研发和研究经历。卡耐基梅隆大学访问学者,先后在 ICML、AAAI、IJCAI、ICDM等国际顶级会议上发表数篇论文,引用次数高达1000。

周景阳:曾任百度资深工程师,国美和凡普金科的技术负责人。是技术领域、数据分析、知识图谱、视觉等领域的专家。

葛瀚骋:美国Texas A&M大学博士,美国亚马逊Alexa部门资深科学家,负责Alexa的智能化以及个性化的研发与应用,曾任职于美国ebay以及NEC北美实验室。主要的研究涉及到Tensor、社交分析、推荐系统等领域,在KDD、AAAI、SIGIR、RecSys等国际顶级会议上发表15篇以上的论文,数百次的引用。

Q: 如何参与之后的公开课?

扫描下面二维码(或海报)小姐姐拉你进群

加入免费AI公开课

扫码人有点多,小姐姐忙不过来

请直接添加微信号:tx900180

我们是谁?: 我们是一家专注于人工智能领域的在线教育公司,由一群有情怀的硅谷科学家来创办。我们提供最专业的AI课程以及每周4-5期的免费AI类公开课。关注此公众号(“贪心科技AI”)可以获得相关的信息。