时隔 5 年,network slimming 原作者团队打造出了 ViT 版的 slimming,入选 CVPR 2022。

卷积网络版的 network slimming 在 ICCV 2017 上被提出,作为神经网络剪枝领域代表性的工作之一,目前已被引用超过 1400 次,五年之后的 CVPR 2022,原作者团队跟 Meta、印度理工学院等机构的研究者联合打造了 ViT 版的 slimming,据悉该工作得到了四个审稿人一致推荐接收!

![]()

是什么原因让 network slimming 的 ViT 版本得到所有审稿人的一致青睐呢,这里还得说一下 network slimming 这种方法的几个特点,即:简单 (simple) + 有效 (effective) + 灵活 (flexible)。通过简单的引入指示因子,slimming 可以边训练边搜索,类似于隐式的参数共享机制,压缩后的目标网络结构通过排序指示因子就可获得,非常高效方便。ViT-Slim 继承了这些优点,同时针对 ViT 主干网络结构的特性做出了几个改进。

在介绍改进前先回顾一下 network slimming 的方法和原理。用一句话概括就是,对于卷积神经网络,每层每个卷积核都用一个重要性系数去表征它对最后预测结果的贡献程度,如果这个系数接近于 0,就认为它是没有贡献并可以被去掉的。作者通过施加一个

![]() 正则使得这些系数变得稀疏,同时作者发现由于通常会将卷积核与批量归一(BN)一起使用,因此可以直接使用 BN 层的缩放系数

正则使得这些系数变得稀疏,同时作者发现由于通常会将卷积核与批量归一(BN)一起使用,因此可以直接使用 BN 层的缩放系数

![]() 作为每层卷积的重要性系数,这样就不需要引入额外的参数了。

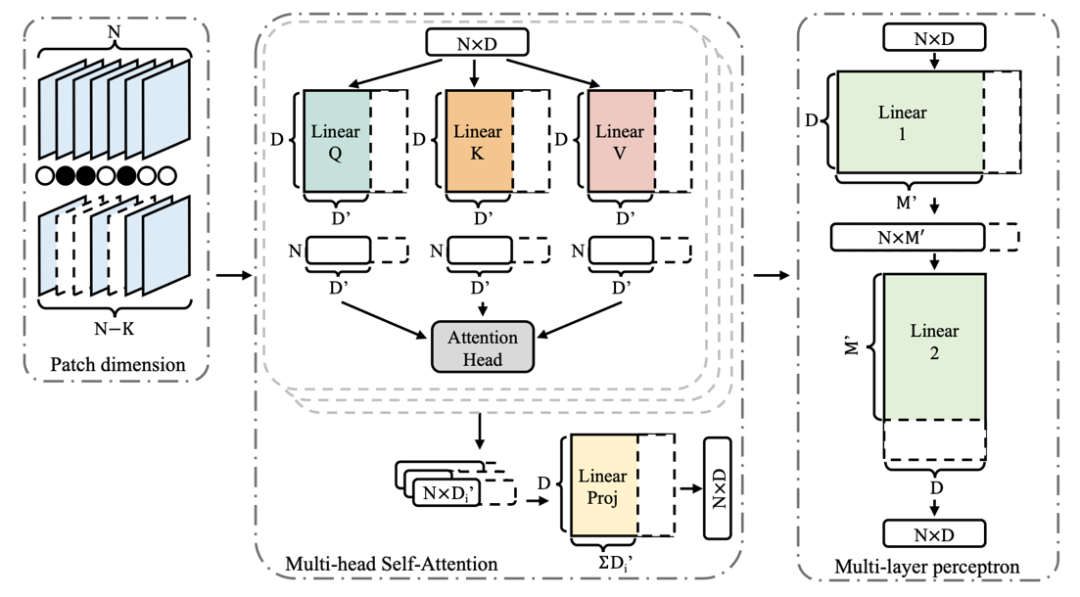

对于 ViT Slimming,需要解决的核心问题是如何在没有 BN 层的情况下设计合适的指示参数来反映不同模块规模对于整个分类性能的重要程度。文章采用的是通过显式地定义可导的 soft mask 来确定每个模块的大小和尺度,整个过程如下图所示。

作为每层卷积的重要性系数,这样就不需要引入额外的参数了。

对于 ViT Slimming,需要解决的核心问题是如何在没有 BN 层的情况下设计合适的指示参数来反映不同模块规模对于整个分类性能的重要程度。文章采用的是通过显式地定义可导的 soft mask 来确定每个模块的大小和尺度,整个过程如下图所示。

![]()

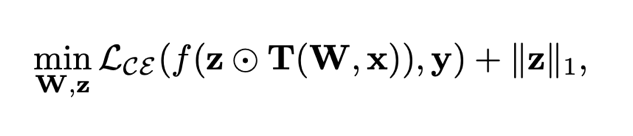

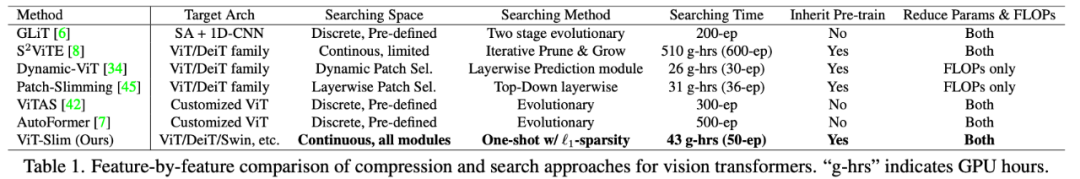

ViT Slimming 同时考虑了 ViT 里面三个模块:输入 tokens,MHSA 和 MLP 模块,它的训练过程可以看成是一个基于权重共享的子网络搜索过程,主干网的权重可以通过加载预训练好的模型参数来加快搜索。训练过程中 soft mask 接近 0 对应的特征相当于动态地被裁剪 / 丢弃了。该方法的优点是只需训练 / 搜索一次,就可以通过排序 mask 得到无数个子网络,非常高效灵活。算法优化函数由原始的 cross-entropy 和

![]() 稀疏正则组成,如下所示:

稀疏正则组成,如下所示:

![]()

其中在 ViT 的 MHSA 模块内部加 soft mask 的处理如下:

![]()

在 MLP 模块加 soft mask 的处理如下:

![]()

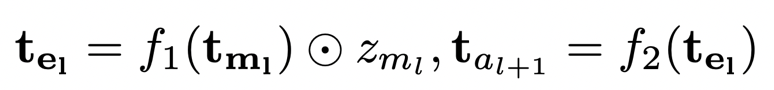

下面是 ViT-Slim 跟其他一些 ViT 压缩或者瘦身方法的区别,主要在于搜索方法以及使用范围的不同。

![]()

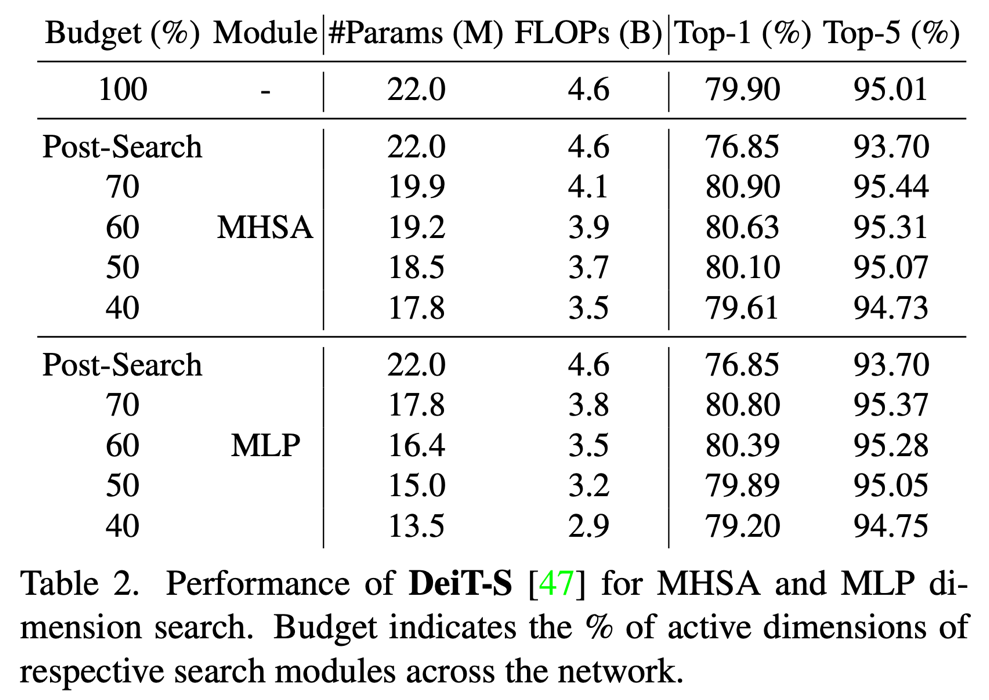

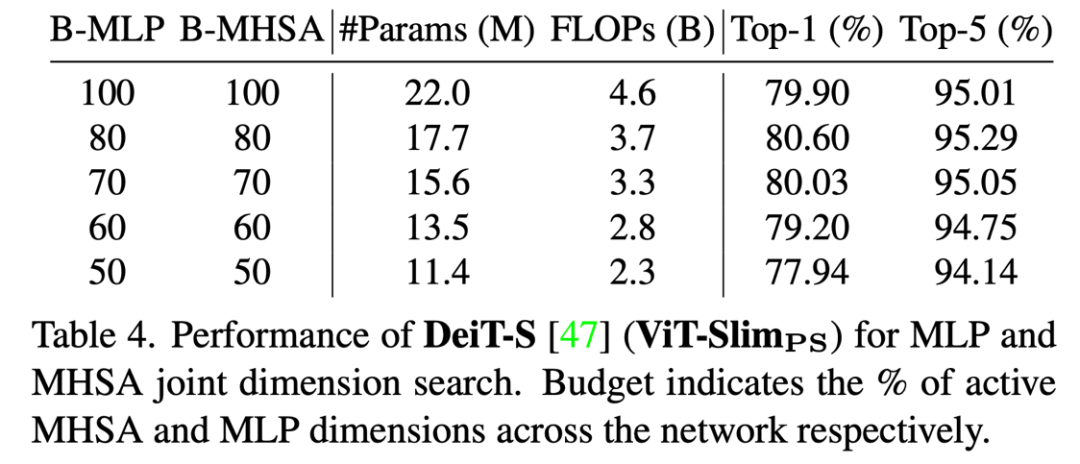

相比其他方法,ViT Slimming 可以同时减少模型参数量和计算量,同时由于可以继承已经正常训练好的模型参数,搜索过程需要的时间非常少,对资源需要也不是很大。

![]()

![]()

![]()

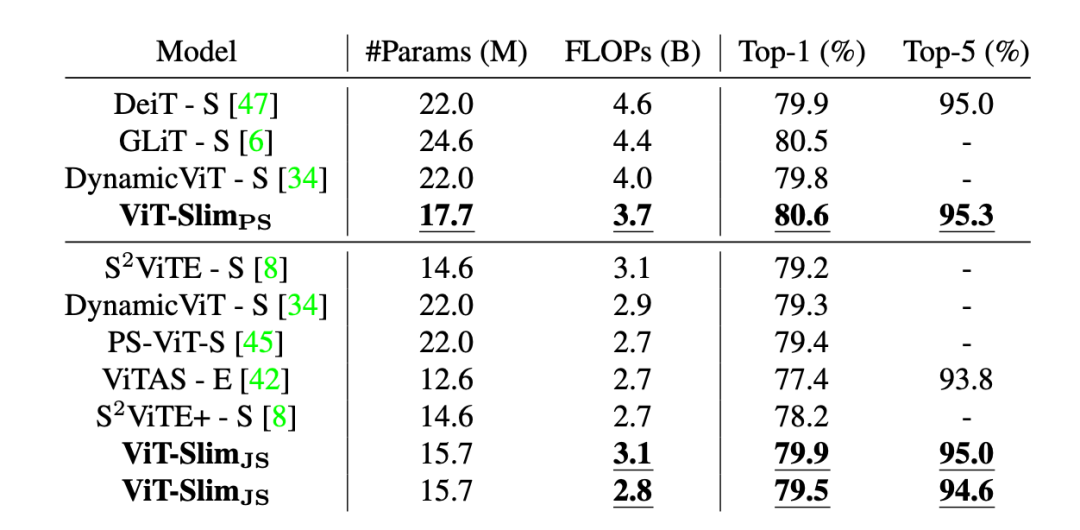

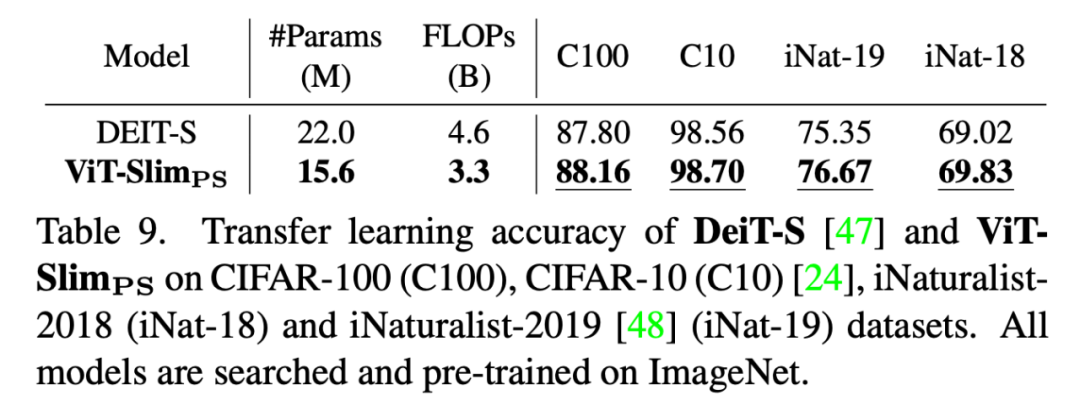

可以看出在更少的参数及计算量的条件下,ViT-Slim 可以得到更好的性能。

![]()

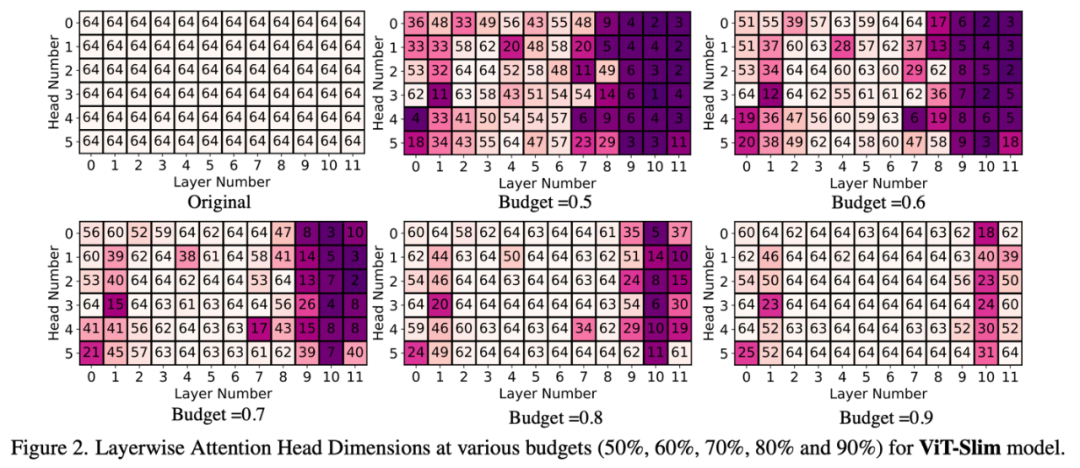

1. 搜索得到的每个 Attention head 结构:

![]()

可以看到搜索得到的 attention head 结构数目呈现中间大,两边小(高层更加明显)的现象。

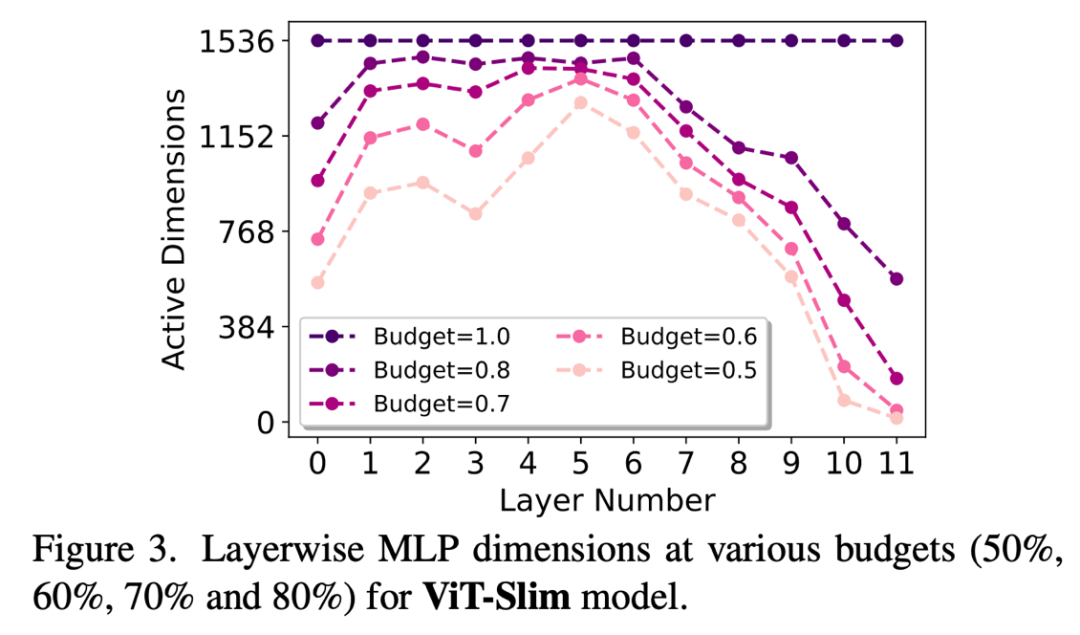

![]()

可以看到搜索得到的 MLP 结构同样呈现中间大,两边小的现象,这也是一个非常有意思的地方。

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

正则使得这些系数变得稀疏,同时作者发现由于通常会将卷积核与批量归一(BN)一起使用,因此可以直接使用 BN 层的缩放系数

正则使得这些系数变得稀疏,同时作者发现由于通常会将卷积核与批量归一(BN)一起使用,因此可以直接使用 BN 层的缩放系数

作为每层卷积的重要性系数,这样就不需要引入额外的参数了。

作为每层卷积的重要性系数,这样就不需要引入额外的参数了。

稀疏正则组成,如下所示:

稀疏正则组成,如下所示: