美国科学家研究出无需训练的神经网络,能帮助机器像人类一样思考

这个被称为储备池计算系统的神经网络,它能够基于当前的对话预测未来的结果。

近日,由密歇根大学电气工程和计算机科学教授 Wei Lu 研究团队在《自然·通信》上发表了一项研究成果。这是一个新型的人工神经网络,被称为储备池计算系统(reservoir computing system),它能在对话之前对接下来想讲的词汇进行预测,并能够基于当前的对话预测未来的结果。

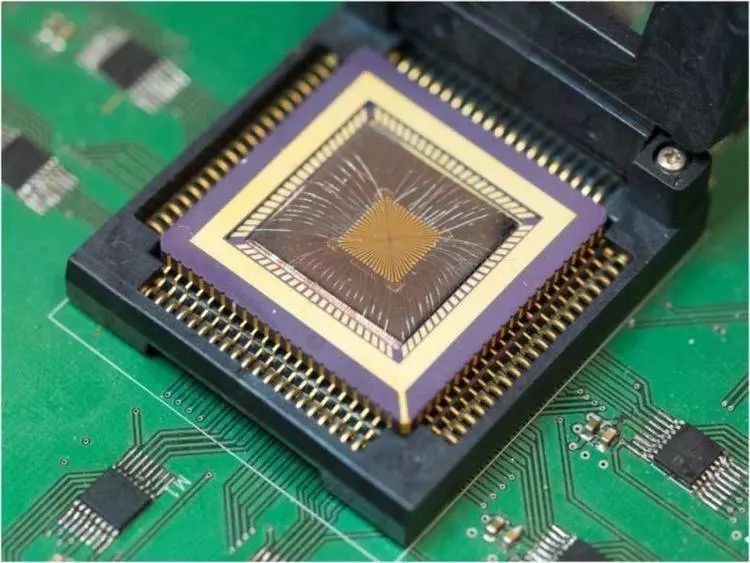

储备池计算系统能够提高典型神经网络的性能,减少训练所需的时间,但在过去,这种改进需要使用更大的光学元件。然而,研究人员使用忆阻器创造了这套系统,其好处在于所需空间较小,可以更容易地集成到现有的硅基电子器件中。

忆阻器全称记忆电阻 (Memristor),是能执行逻辑和存储数据的特殊类型的电阻设备。这和典型的计算机系统形成了对比,后者的逻辑模块和存储模块是分离的,处理器执行逻辑,存储模块保存数据。在这个研究中,Lu 的团队采用了一种近年来新出现的特殊的忆阻器。

最早提出忆阻器概念的人,是加州大学伯克利分校的华裔科学家蔡少棠,他在 1971 年发表的题为《忆阻器:下落不明的电路元件》的论文中预测自然界存在第四种电路元件,并称之为忆阻器。此后,一直没有人验证忆阻器的存在,在当时很难找到合适的材料,也并没有多少人重视这个研究。直到 2008 年,惠普继续推动了忆阻器的研究。

忆阻器是硬件实现人工神经网络突触的最好方式之一。神经网络由神经元或节点、突触组成,通过调整内部大量节点之间相互连接的关系达到处理信息的目的。

神经网络的概念在 70 年代的时候被提出。两位德国的医生和生物学家在解剖猫的时候获得灵感,他们发现,猫的视觉皮层是分阶段发育的,它会从视网膜开始,通过对感官数据的响应来调整其神经连接,每次一层,神经元之间相互连接时有反射弧,当有电流的时候,它就认为这是一个激活状态。这套理论从他们的角度来讲非常切合人脑的识别模式,所以提出神经网络架构。此后,科学家们不断对神经网络进行研究完善。

在训练神经完成一个任务时,需要给神经网络提供大量的问题和对应的答案。在这个被称为监督学习过程中,节点之间的连接权重需调整为更大或更小,以实现结果和正确答案之间的误差最小。

一旦训练完成,神经网络就可以在不知道答案的情况下进行测试。例如,系统可以处理一张新照片,并正确识别一个人脸,因为它已经从其训练集中的其他照片中学习了人脸的特征。Lu 表示,训练一个网络需要划分几天或者几个月的时间,这非常贵。

图像识别只是相对简单的问题,因为它除了静态图像外,不需要任何其他信息。语音识别是更复杂的任务,它高度依赖上下文内容,这需要让神经网络了解刚刚发生了的事情和所说的内容。

Lu 告诉媒体,「当把语言转换成文本或翻译语言时,一个单词的含义甚至发音都会根据之前的音节而有所不同。」这就需要一个循环神经网络,它在网络中结合了循环,带来记忆效应。但是训练这些循环神经网络成本非常昂贵。

然而,使用忆阻器构成的储备池计算系统可以跳过大部分昂贵的训练过程,并且可以提供网络记忆功能,这是因为系统中最关键的组成部分储备池不需要训练。

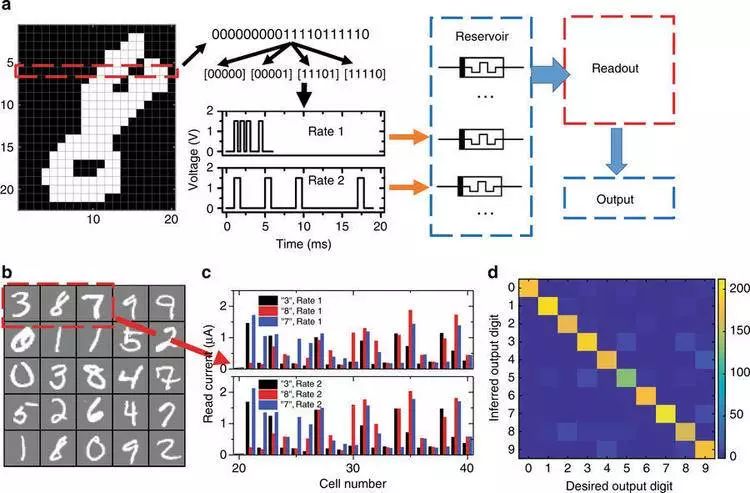

该研究团队使用手写识别测试来验证储备池计算概念,这是神经网络的标准检查程序。然后用像莫尔斯电码那样的电压输入到计算机中。传统的神经网络需要数千个节点,而这个储备池则仅需 88 个忆阻器作为节点,在识别手写版本的数字时,储备池计算系统的准确性达到了 91%。

储备池计算系统特别擅长处理随时间变化的数据,如数据流或文字流,或依赖于过去结果的功能。Lu 计划通过这项研究探索两条未来路径:语音识别和预测分析。

他告诉媒体:「我们可以对自然语言进行预测,所以你甚至不用说全文,我们就可以猜测到你接下来说什么。」

责任编辑:双筒猎枪

头图来源:视觉中国

本文由极客公园原创

转载联系 zhuanzai@geekpark.net