新理论揭开了深度学习的黑匣子。一个被称为“信息瓶颈”的新想法正在帮助解释当今人工智能算法令人困惑的成功,也可能解释人类大脑是如何学习的。

![]()

![]()

Ravid Shwartz-Ziv 纽约大学数据科学中心的CDS研究员,在那里我主要与Gordon Wilson 和 Yann Lecun合作,研究贝叶斯深度网络、信息论和自监督学习。

https://www.ravid-shwartz-ziv.com/

深度神经网络信息流![]()

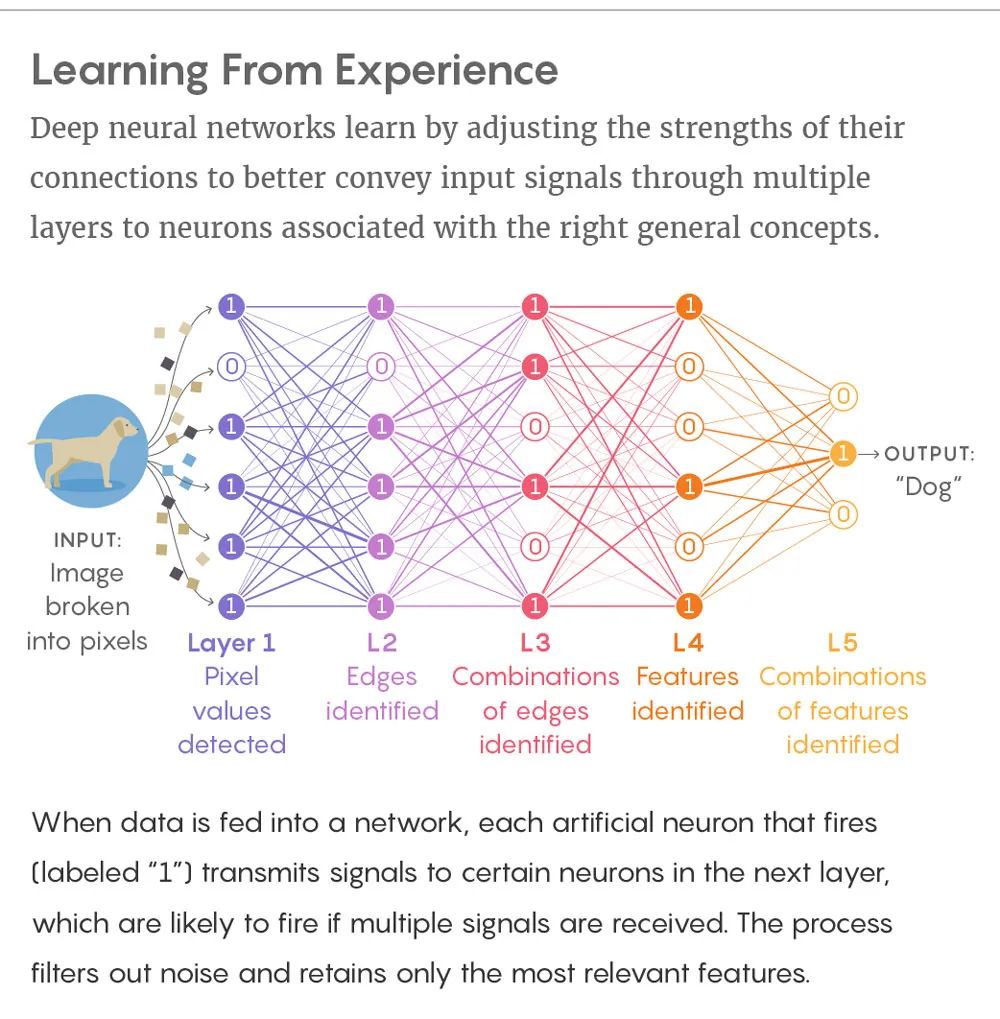

尽管深度神经网络已经取得了巨大的成功,但对它们如何工作或如何构建的全面的理论理解还不存在。深度网络通常被视为黑盒,预测的解释及其可靠性仍不清楚。今天,了解深度神经网络的突破性性能是科学界面临的最大挑战之一。为了更有效地使用这些算法并改进它们,我们需要了解它们的动态行为以及它们学习新表示的能力。

本文通过将信息理论的原理和技术应用到深度学习模型来解决这些问题,以提高我们的理论理解,并使用它来设计更好的算法。本文的主要成果和贡献分为三个部分,具体如下。

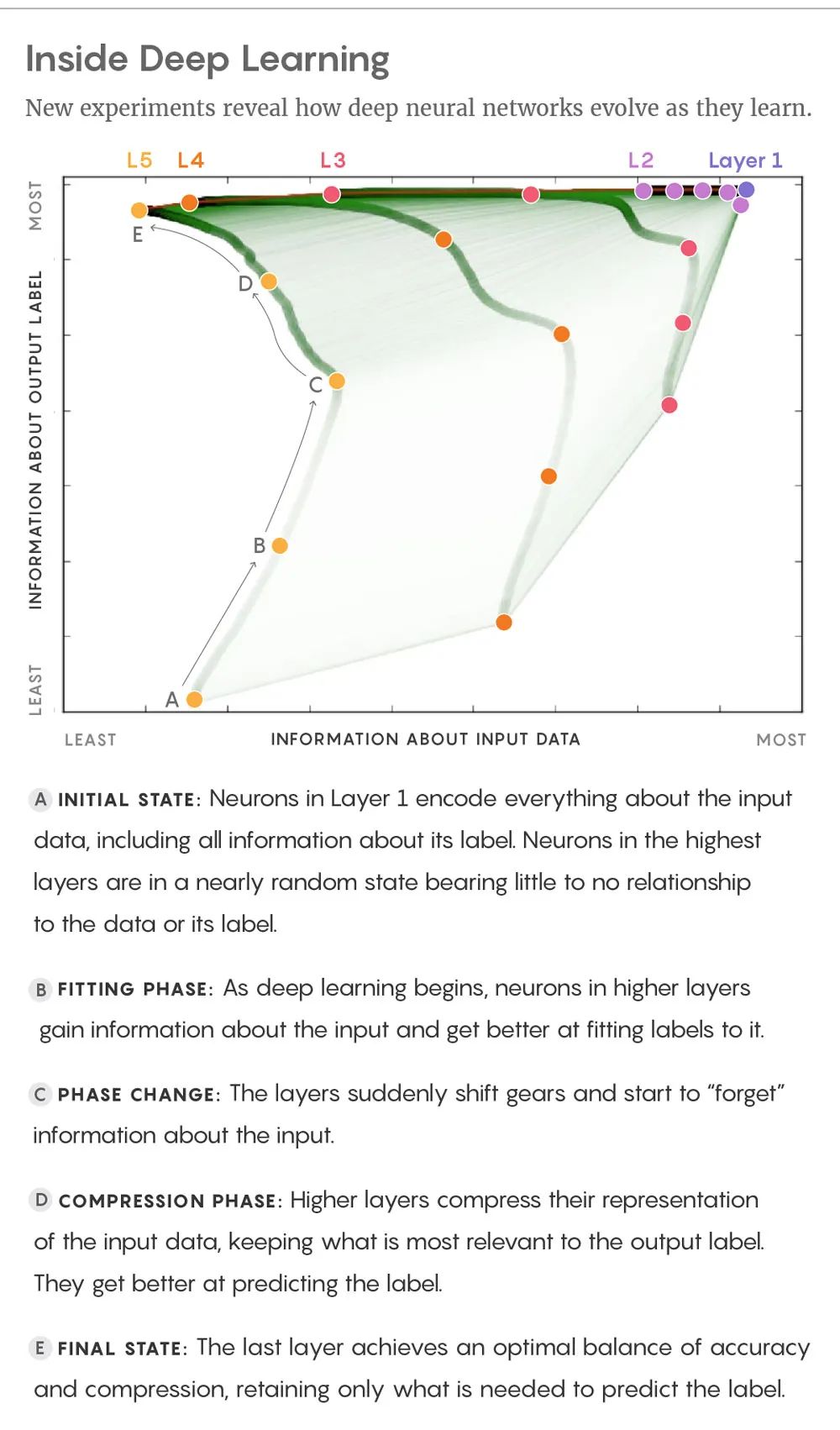

第二章和第三章介绍了深度学习模型的信息理论方法。作为对深度学习系统的解释,我们提出使用信息瓶颈(IB)理论。这种分析网络的新范式揭示了网络的分层结构、泛化能力和学习动态。基于我们的分析,我们发现深度网络优化了每一层输入和输出变量的互信息,导致了每一层压缩和预测之间的权衡。我们对这些网络的分析和数值研究表明,随机梯度下降(SGD)算法遵循IB权衡原则,工作在两个阶段:一个快速经验误差最小化阶段,然后是一个缓慢的表示压缩阶段。这些相位由每一层不同的信噪比(SNRs)来区分。此外,我们证明了SGD由于压缩阶段而达到了这个最优界,并在表示压缩上导出了一个新的高斯界,并将其与压缩时间联系起来。此外,我们的结果表明,网络的层收敛于IB的理论边界,导致编码器和译码器分布之间的自洽关系。

第四章讨论了将IB应用到深度神经网络中最困难的问题之一——在高维空间中估计互信息。尽管互信息在数据科学中是一个重要的数量,但它在历史上给计算带来了挑战。互信息的计算只适用于离散变量或已知概率分布的有限数量的问题。为了更好地估计信息理论量和研究泛化信号,我们研究了几个框架,并利用了最近的理论发展,如神经切线核(NTK)框架。在我们的研究中,我们发现对于无限宽的神经网络的无限集合,我们可以得到许多信息理论量及其界的易于处理的计算。网络的内核可以用一个封闭的形式来描述许多量。通过分析这些推导,我们可以了解网络的重要信息论量,以及压缩、泛化和样本大小之间的关系。

第五章提出了一种新的信息理论框架——双信息瓶颈(dualIB)。尽管IB框架有优点,但它也有几个缺点:IB是完全非参数的,并且只在概率空间上运行。此外,IB公式并不涉及预测看不见的模式的任务,并假定完全访问联合概率。因此,我们开发了dualIB,它解决了IB的一些缺点,通过仅仅在失真函数的项之间切换。dualIB可以解释数据的已知特征,并利用它们对未见过的例子做出更好的预测。我们提供了dualIB自一致方程,使我们能够得到解析解。局部稳定性分析揭示了解的临界点的基本结构,得到了最优模式表示的完全分岔图。我们发现了dualIB目标的几个有趣的性质。首先,当以参数形式表示时,dualIB保留了它的结构。它还优化了平均预测误差指数,从而提高了样本量方面的预测精度。除了dualIB的解析解决方案,我们还提供了一个变分的dualIB框架,该框架使用深度神经网络优化函数。该框架实现了对真实数据集的dualIB的实际实现。利用它,我们对其动力学进行了经验评估,并验证了现代深度神经网络的理论预测。总之,本文提出了一个新的信息论视角来研究深度神经网络,它利用了深度学习和IB框架之间的对应关系。我们独特的视角可以提供许多好处,比如对深度神经网络有更深入的理解,解释它们的行为,并改善它们的性能。同时,我们的研究也开拓了新的理论和实践研究问题。

https://arxiv.org/abs/2202.06749

![]()

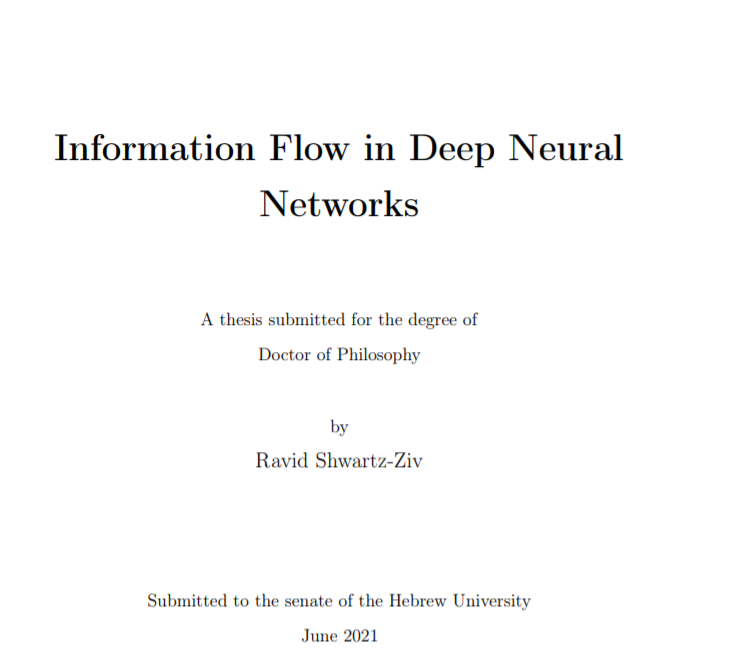

学习表征是计算机视觉、自然语言处理、认知科学和机器学习中许多问题的核心(Bengio et al.; 2013). 分类和预测需要复杂的数据表示,因为要考虑物理参数,如位置、大小、方向和强度(Salakhutdinov等;2013). 然而,目前还不清楚什么构成了良好的表示,以及它与学习和特定问题类型的关系。

通过组合简单神经元的多种转换,深度神经网络(DNN)可以产生更有用(并且在大多数情况下更抽象)的表示。由于它们的通用性和在各个领域的成功,这些系统在过去几年中得到了普及。与传统的机器学习方法相比,DNN的性能在图像、音频和文本等多个领域都有很大的改进(Devlin et al.; 2018; He et al.; 2016; Oord et al.; 2016)。最新的深度学习模型更加复杂,它们的架构也越来越复杂,需要优化的参数也越来越多。例如,ResNet-52网络包含了经过数百万张图片优化的2300万个参数。

![]()

然而,从理论的角度来理解这些性能的原因只是部分的,我们只是对它们有一个启发式的理解。目前还不清楚为什么深度模型在真实世界的数据上表现得如此出色,以及它们的关键组件是什么。另外,当前的度量标准并没有提供对网络内部结构或网络层质量的深入了解。因此,即使该模型非常准确,也很难将其作为进一步科学研究的基础。为了使这些算法更有效并改进它们,我们必须理解它们的潜在动态行为以及它们如何学习表示。在本论文中,我们提出从信息论的角度研究DNN。作为对现代深度学习系统的解释,我们提出了信息瓶颈(IB)理论。我们希望通过这种分析DNN的创新方法来阐明它们的分层结构、泛化能力和学习动态。为了更好地理解DNN,第一个问题是:如何使用信息论的一般理论,特别是IB框架来更好地理解DNN?

香农发明了信息论来确定在噪声信道上传输信息所需的比特数。这一理论后来被证明是衡量变量之间影响的无价方法(Shannon; 1948)。

给定两个随机变量X和Y,它们之间的互信息度量它们的联合概率分布P(X, Y)与其边缘P(X)P(Y)的乘积的散度,以确定它们的相依或独立程度。互信息的概念不同于相关性,它可以捕捉变量之间的非线性统计关系,增强我们分析复杂系统动力学的能力(Kinney and Atwal; 2014)。尽管互信息在数据科学中是一个基本的数量,但它在历史上一直具有挑战性的估计(Paninski;2003)。精确计算只适用于有限数量的具有明确定义的概率分布的问题(例如,指数族)。对于有限的数据样本或一般问题,互信息的计算是不可能的。

这就引出了以下研究问题: 如何计算大规模DNN的互信息?为了得到信息理论量的精确计算和寻找泛化信号,我们研究了几个框架并利用了当前的理论发展,包括神经切线核(NTK)框架(Lee等人;2019)。我们得到了无限宽神经网络的无限集合中信息论量及其界的易于处理的计算。我们的分析表明,核以一种封闭的形式描述了许多量。此外,我们发现输入的压缩有助于该模型家族的泛化。

![]()

虽然IB框架有它的优点,但它也有一些缺点,包括无法保存数据的结构和有限数据的性能不够理想。最后研究的问题是,我们是否可以推导出一个新的框架来解决这些问题,并将其应用到DNN中。

因此,我们开发了双IB (DualIB),它在失真函数中的项之间切换,以解决IB的一些问题。

局部稳定性分析揭示了其底层结构和最优模式表示。我们发现,当以参数形式表示时,DualIB保留了它的结构。此外,它还优化了平均预测误差指数,提高了相对于样本容量的预测精度。DualIB可以在变分框架的帮助下,使用神经网络应用于真实世界的数据集。利用这个框架,我们评估了DualIB的动力学,并验证了理论预测。

https://www.quantamagazine.org/new-theory-cracks-open-the-black-box-of-deep-learning-20170921/

![]()

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

专知,专业可信的人工智能知识分发

,让认知协作更快更好!欢迎注册登录专知www.zhuanzhi.ai,获取70000+AI主题干货知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程资料和与专家交流咨询!

点击“

阅读原文

”,了解使用

专知

,查看获取70000+AI主题知识资源