DINO:目标检测benchmark COCO屠榜的正确姿势

极市导读

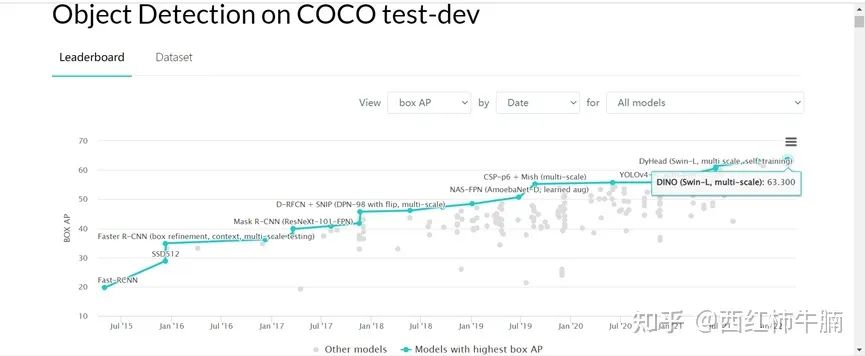

DETR系列的论文又屠榜了,在COCO test-dev达到创纪录的63.3AP!因此作者将2020年以来所有的DETR系列的优势和历程进行了一个梳理,本文只为抛砖引玉,更多的是希望大家能一起进行交流~ >>加入极市CV技术交流群,走在计算机视觉的最前沿

不小心在paperwithcode看到,DETR系列的论文又屠榜了,在COCO test-dev达到创纪录的63.3AP,忍不住想写一下,2020年以来DETR系列的优势和历程(如何灌水的),虽然原作者也经常上知乎,班门弄斧只为抛砖引玉,更多的思想交流吧。

1 DETR干了啥?

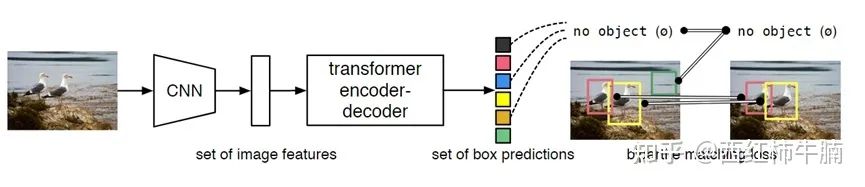

DETR是2020年,由Facebook AI提出,开创性将Transformer引入Detection领域,去掉传统两阶段FasterRCNN和一阶段CenterNet的代表性小技巧(面试最容易考),如RoIpooling,NMS,anchor generation等。

Transformer中attention机制能够有效建模图像中的长程关系(long range dependency),真正实现end-to-end的目标检测新范式。

DETR将目标检测看作一种set prediction问题,并提出了一个十分简洁的目标检测pipeline:backbone CNN提特征,送入Transformer做关系建模,得到的输出通过二分图匹配算法与图片上的ground truth做匹配。

2 DINO能干啥?

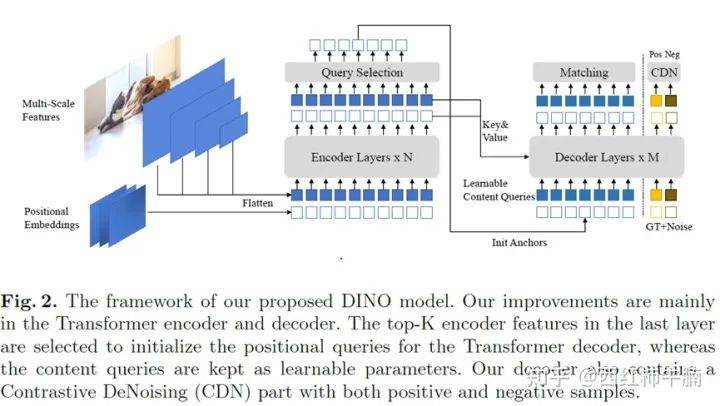

最新屠榜的这篇DINO,是清华大学,香港科技大学等人提出来的,比较奇怪是论文相互引用,作者也几乎是同一套班底,DN-DETR发表在CVPR2022, DAB-DETR发表在ICLR2022,idea有很多相似的地方。

论文的说法是,解决三个问题:

a. Contrastive DeNoising Training

为了改善one-to-one匹配问题,训练的时候正样本和负样本同时加了噪声。添加smaller noise的作为正样本,其他作为负样本,主要目的是去重box。

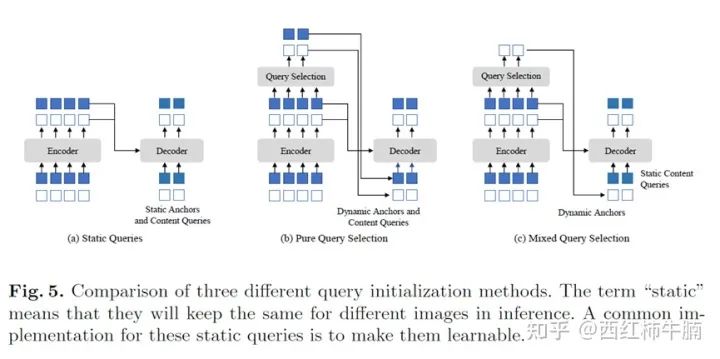

b. Mixed Query Selection

类似于经典的two-stage模型,提出mixed query selection method,有助于改善queries的初始化。

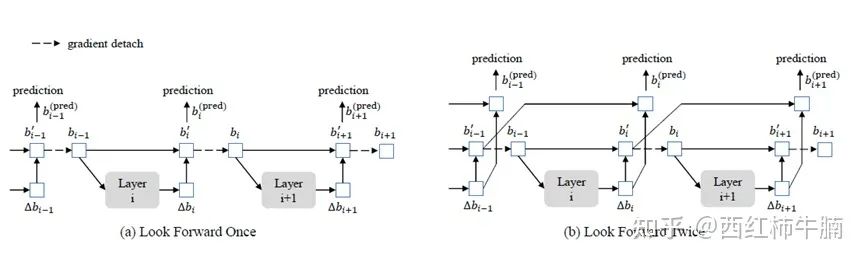

c. Look Forward Twice

类似于经典的FPN,引入非临近层的特征,更像是增加感受一下,提高小目标的表达能力。

想了解DETR系列如何刷榜COCO的,可以看看Awesome Detection Transformer

https://github.com/IDEACVR/awesome-detection-transformer

3 为什么是COCO,objects365&openimages去哪里了?

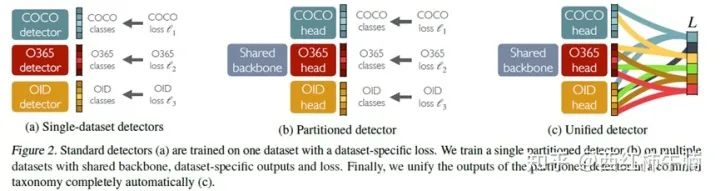

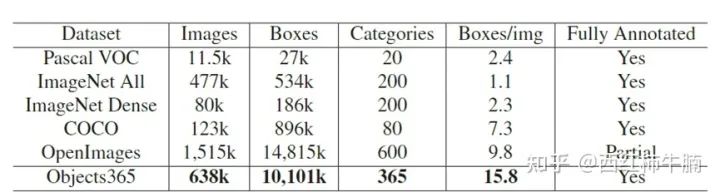

去年的一个工作是用一个backbone,训练openimages& objects365&COCO 1000+目标,说的就是这篇论文Uninet,累的要命,objects365 64w图片,openimages 150w图片,而COCO只有12万,80类检测目标。训练objects365需要32G V100 8卡机一周,而训练COCO只需要32G V100 8卡机二小时,三个分支加一起就得1个月才能训练一遍。发论文需要千百次训练,哪有那么多时间,要是我也愿意在COCO做些文章,万一过拟合也能涨点不是。

4 Detection还要解决那些问题?

1. Transformer需要对特征图上每个位置都参与计算,高分辨率图像必然导致高计算量和空间复杂度,小目标检测一般,目前主要靠多尺度增强小目标的检测能力。

2. Transformer在初始化的时候,attention weights 几乎是平均的,迭代周期长,训练速度也会慢很多。

公众号后台回复“数据集”获取30+深度学习数据集下载~

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~