Graph: 表现再差,也不进行Pre-Training? Self-Supervised Learning真香!

![]() 作者 | 吴龙灿

作者 | 吴龙灿

方向 | 图神经网络、推荐系统

学校 | 东北大学

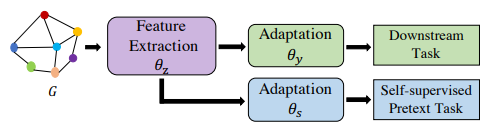

最近图(Graph)数据上面的预训练技术引起了大家的广泛关注。之所以如此,是因为现实世界中绝大多数的数据是无标签的,因此很难直接进行监督学习。若给大量数据进行人工标注需要很大的开销,因此如何在已有数据本身上面开展假定任务(Pretext Task)进行表示学习,成为了近年来研究的热点。

从数据集的角度可以分为:特定Graph数据上面进行预训练,然后应用在这个特定Graph上面的一些下游任务;不同领域Graph数据拿到一起进行预训练,然后应用在其他领域的图数据上面。

1 相关论文

小编整理了最近发表的关于图上进行自监督学习/预训练相关的综述文章。

Strategies for Pre-training Graph Neural Networks. 2020. ICLR

GPT-GNN: Generative Pre-Training of Graph Neural Networks. 2020. KDD

Pre-Training Graph Neural Networks for Generic Structural Feature Extraction. 2020

Self-supervised Learning: Generative or Contrastive. 2020.

Gaining insight into SARS-CoV-2 infection and COVID-19 severity using self-supervised edge features and Graph Neural Networks. 2020. ICML

When Does Self-Supervision Help Graph Convolutional Networks? 2020. ICML

Multi-Stage Self-Supervised Learning for Graph Convolutional Networks on Graphs with Few Labeled Nodes. 2020. AAAI

GCC: Graph Contrastive Coding for Graph Neural Network Pre-Training. 2020. KDD

Self-Supervised Graph Representation Learning via Global Context Prediction. 2020.

Contrastive Multi-View Representation Learning on Graphs. 2020.

Self-supervised Training of Graph Convolutional Networks. 2020.

Self-supervised Learning on Graphs: Deep Insights and New Directions. 2020.

GRAPH-BERT: Only Attention is Needed for Learning Graph Representations. 2020.

Graph Neural Distance Metric Learning with GRAPH-BERT. 2020.

Segmented GRAPH-BERT for Graph Instance Modeling. 2020.

2 参考资料

[KDD2020图神经网络预训练模型]

https://zhuanlan.zhihu.com/p/149222809

[图上自监督学习综述]

https://zhuanlan.zhihu.com/p/150112070

[图神经网络的预训练策略]

https://zhuanlan.zhihu.com/p/124663407

[GNN 教程-图上的预训练任务下篇]

https://archwalker.github.io/blog/2019/08/08/GNN-Pretraining-1.html

推荐阅读