清华十大才女宋晓东教授团队新作,教语言模型更会做数学题

新智元报道

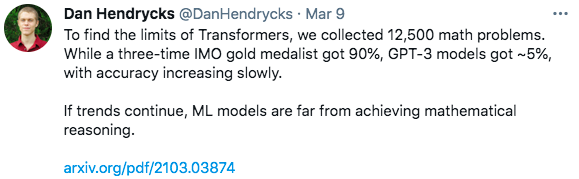

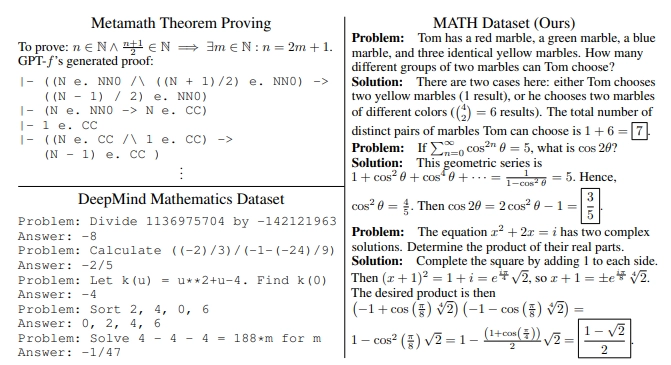

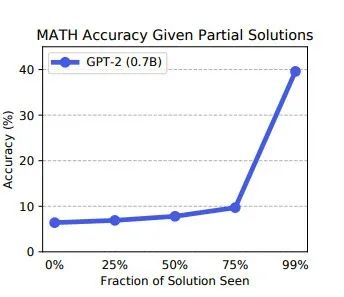

【新智元导读】GPT-3很强大?但做数学题不行。最新研究表明,当GPT-3面对一个包含1.3万道数学题的数据集时,它的完成度远达不到10%. 那么如何提高语言模型的解题能力?加州大学伯克利分校最新的一项研究提供了新思路。

语言模型解决数学问题

全新开源数据集MATH和AMPS

作者介绍

登录查看更多

相关内容

专知会员服务

34+阅读 · 2020年1月15日

Arxiv

6+阅读 · 2019年9月27日