CVPR2020|华南理工,MSRA, 百度联合放大! 让超分性能大幅度提升的对偶回归网络

加入极市专业CV交流群,与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度 等名校名企视觉开发者互动交流!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

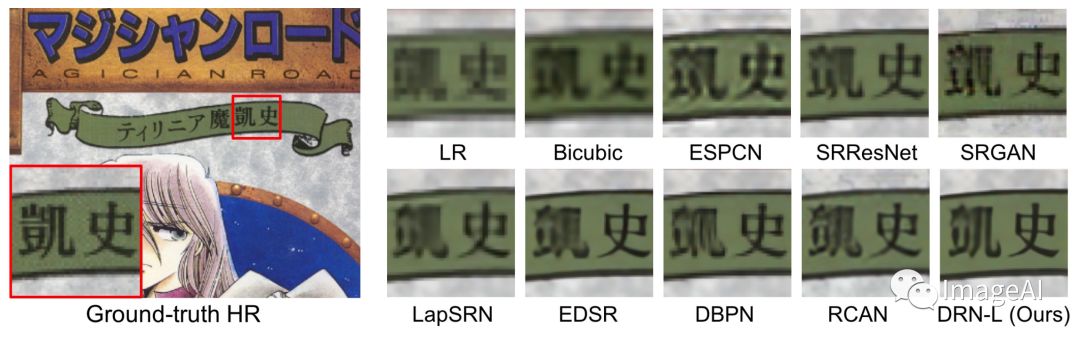

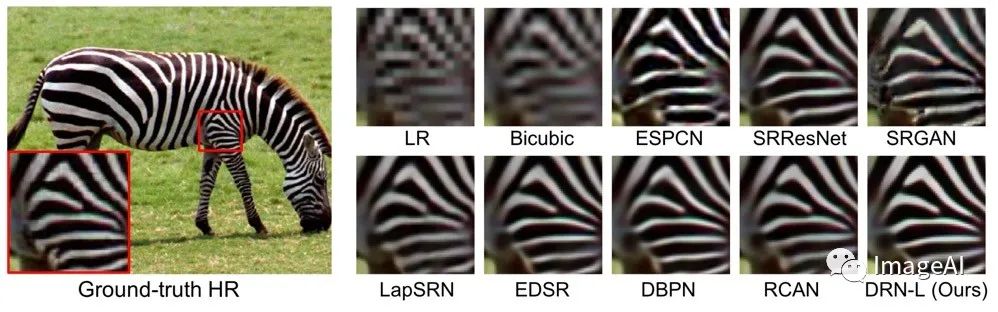

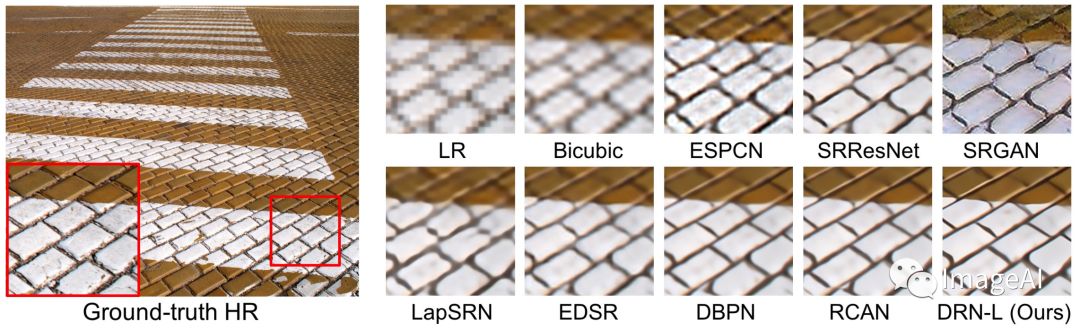

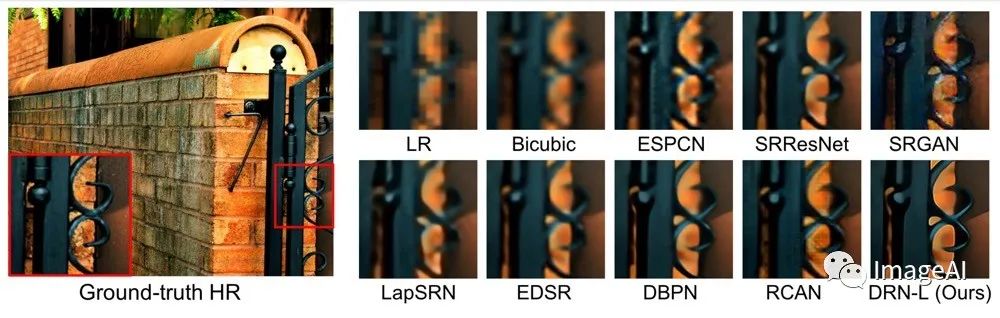

其中超分辨率领域有一篇论文备受瞩目,我们先看看结果👇👇👇:

4倍超分结果:

接下来跟着小编来深扒一下论文是如何实现如此amazing结果的~

以往论文中的诟病

本文的解决方案

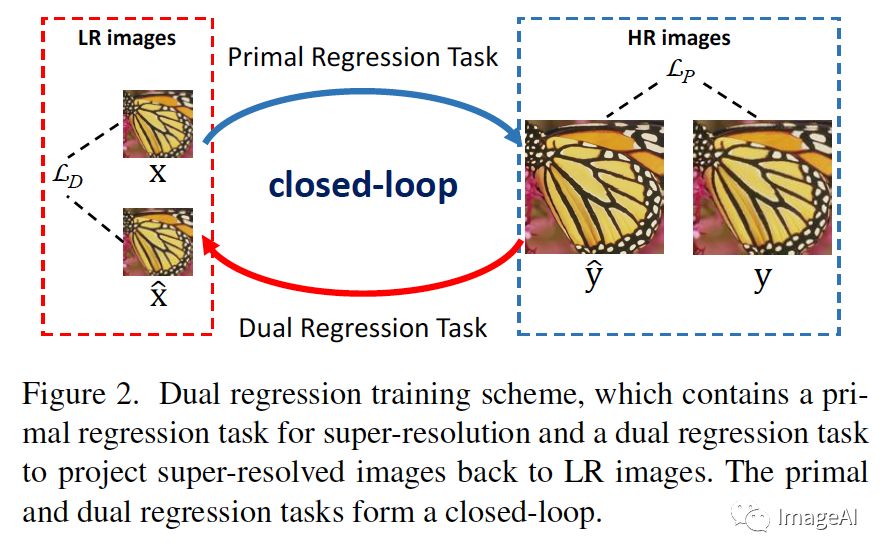

LR->HR是个one to many的过程,那么同样的由HR->LR同样是个one to many的过程。通过本文中提出的闭环学习过程,从理论上理解可以通过两个过程之间的相互约束,形成近似one to one闭环。

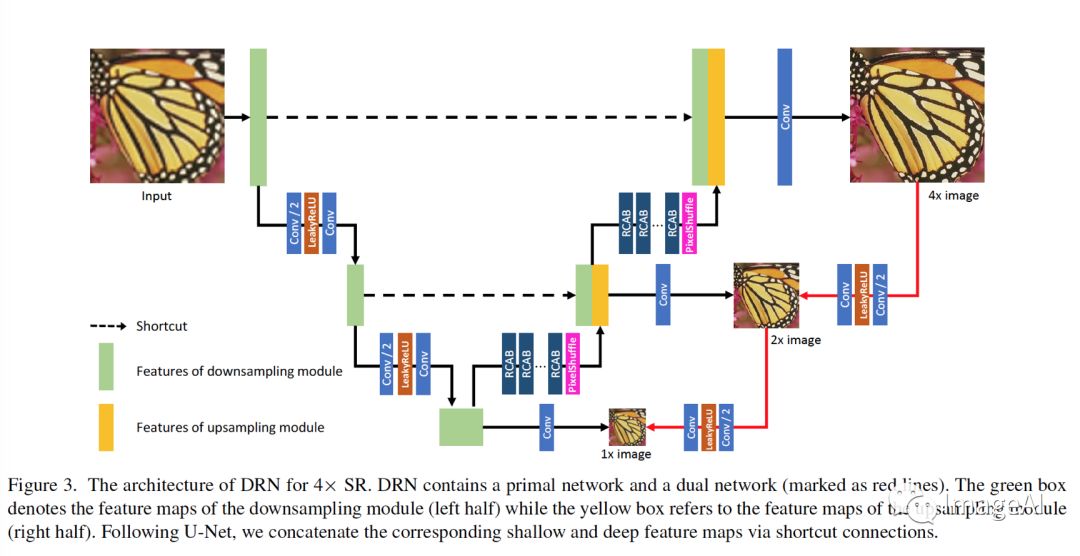

由于真实的data pair难以获取,在本文的Dual Regression Network(DRN)中,采用半监督的方式对网络进行训练。采用data pair的人工模拟对LR->HR训练的同时,利用真实的LR对LR->HR->LR的进行训练。这样可以通过真实的LR data unpair尽可能约束网络的退化核的学习过程,使得其具有一定的泛化性。

本文的超分辨率闭环对偶回归任务

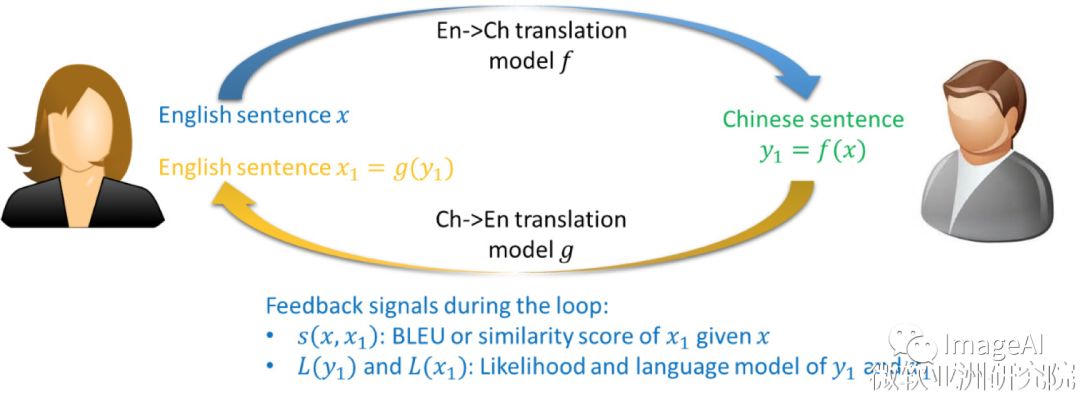

什么是对偶学习?

DRN的闭环模型如何定义?

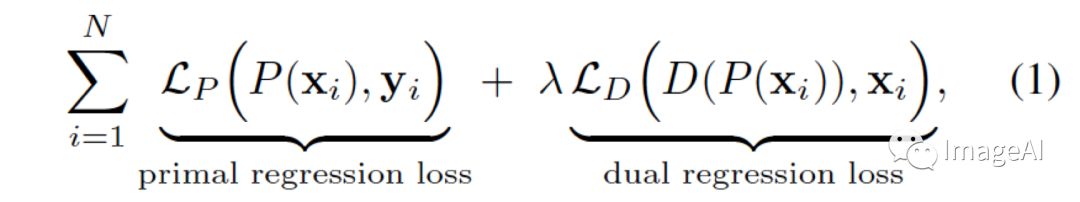

DRN的损失函数如何定义?

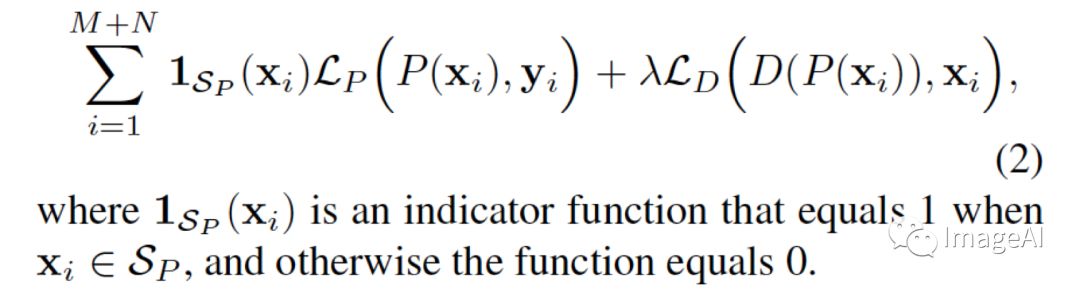

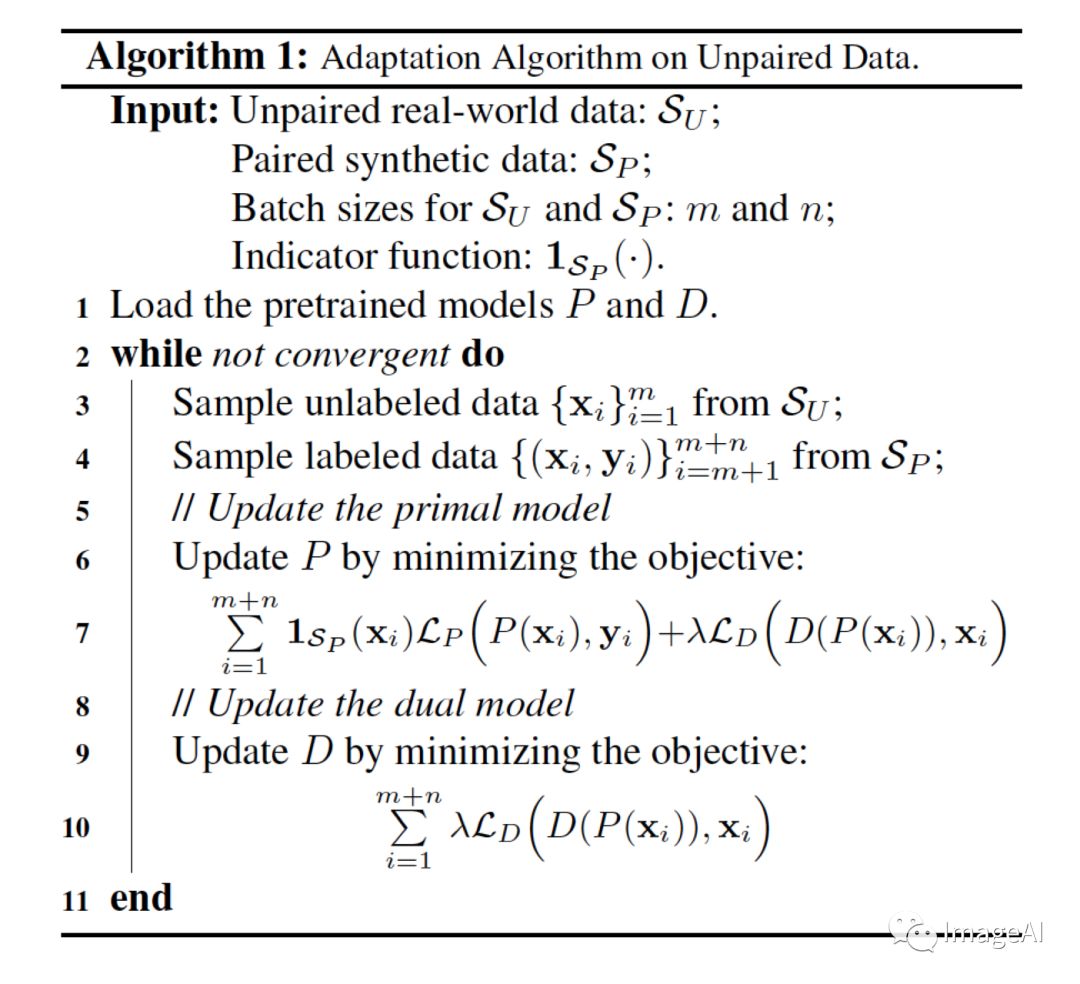

Data Unpair数据如何训练?

实验结果分析:

一.有监督的超分辨率的实验设置和结果:

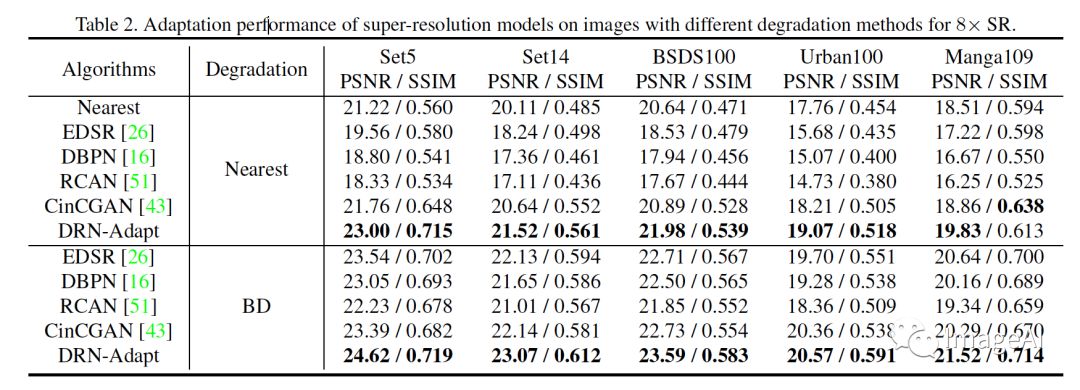

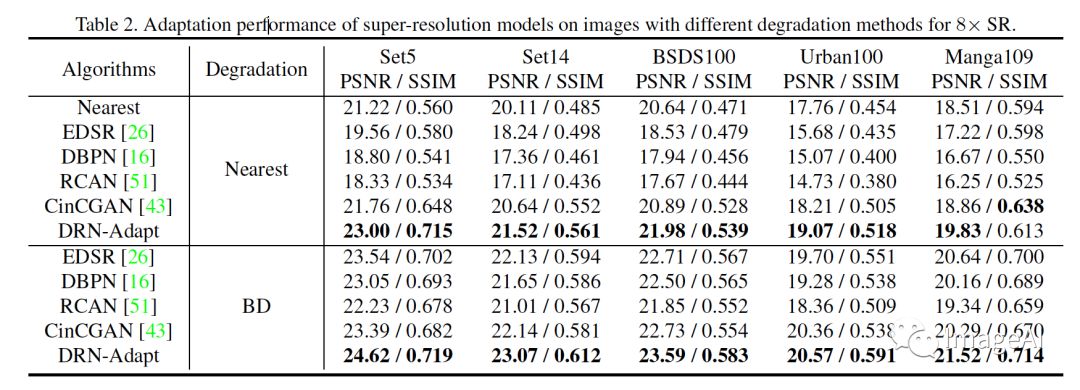

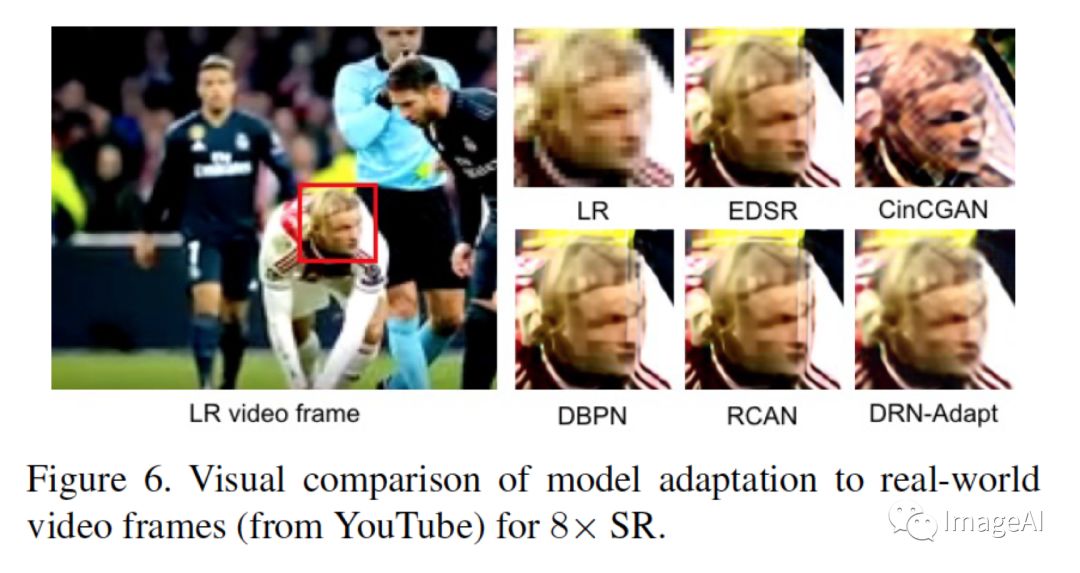

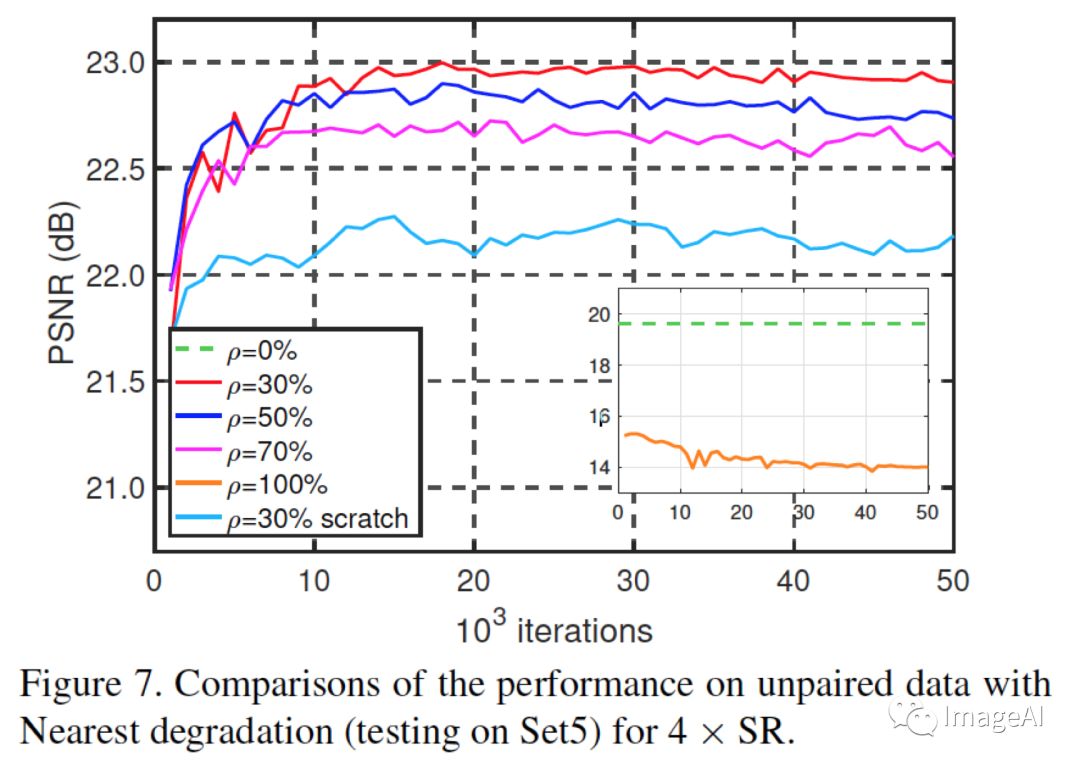

二.半监督的超分辨率的实验设置和结果:

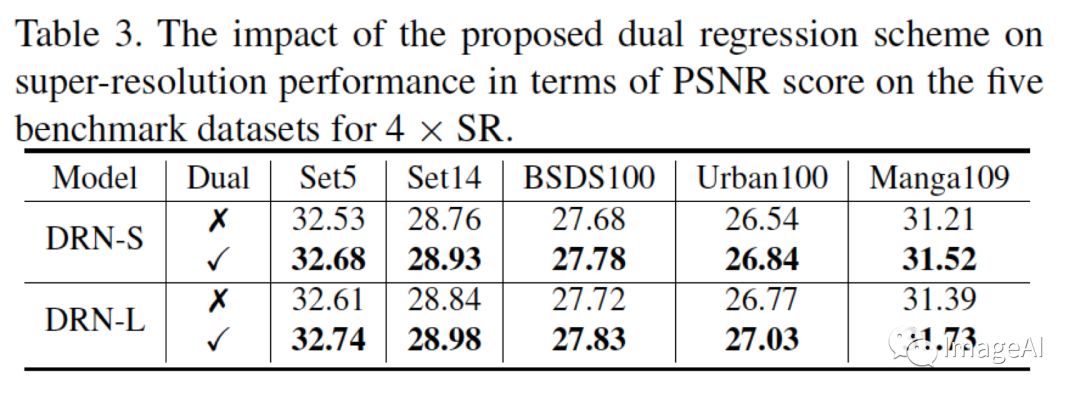

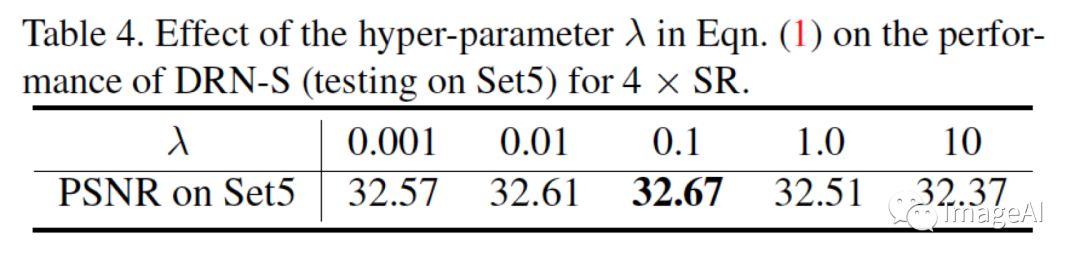

三.消融实验设置和结果:

作者同样进行的实验对比:

从结果上来看,使用Dual Learning的方式在测试集上提升非常显著,充分显示出了对偶学习的优势!

结语

一文读懂 Self-Supervised Learning

解读自监督学习(Self-Supervised Learning)几篇相关paper

Hinton组力作:ImageNet无监督学习最佳性能一次提升7%,媲美监督学习

极市平台视觉算法季度赛,提供真实应用场景数据和免费算力,特殊时期,一起在家打比赛吧!

添加极市小助手微信(ID : cv-mart),备注:研究方向-姓名-学校/公司-城市(如:目标检测-小极-北大-深圳),即可申请加入目标检测、目标跟踪、人脸、工业检测、医学影像、三维&SLAM、图像分割等极市技术交流群,更有每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、行业技术交流,一起来让思想之光照的更远吧~

△长按添加极市小助手

△长按关注极市平台,获取最新CV干货

觉得有用麻烦给个在看啦~

登录查看更多

相关内容

专知会员服务

44+阅读 · 2020年3月26日