1000亿参数!阿里&清华发布最大规模的中文多模态预训练模型M6

应用

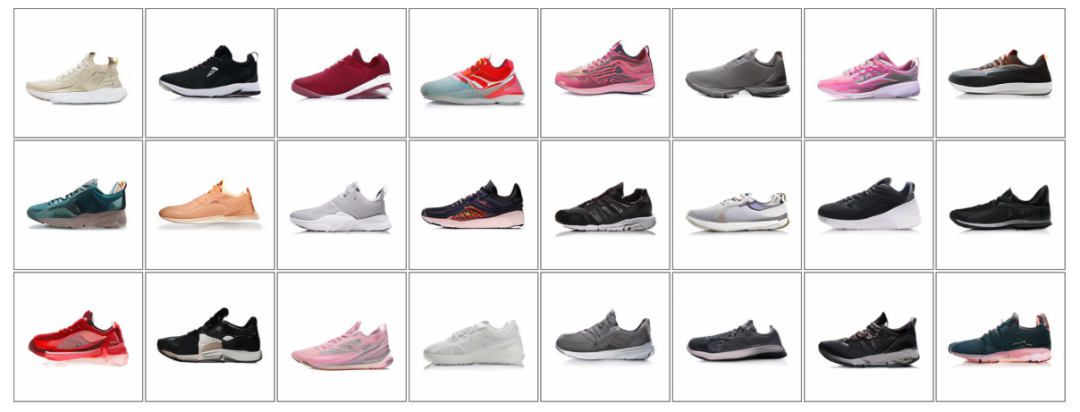

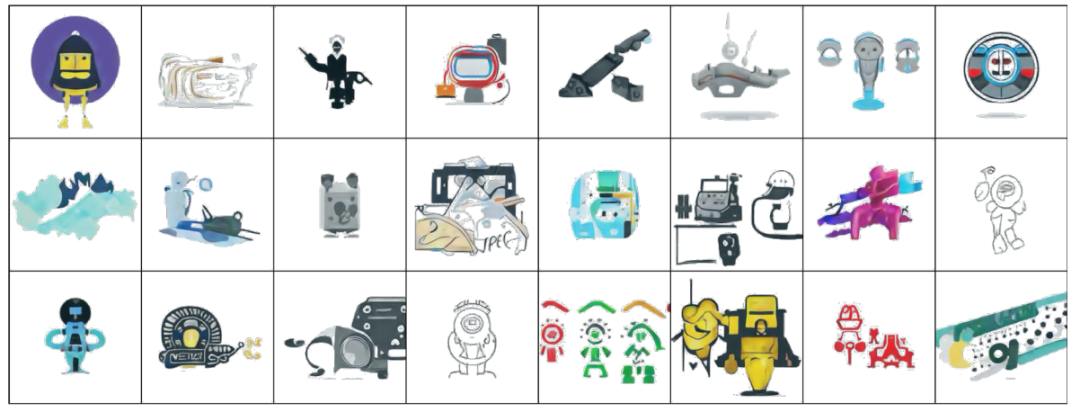

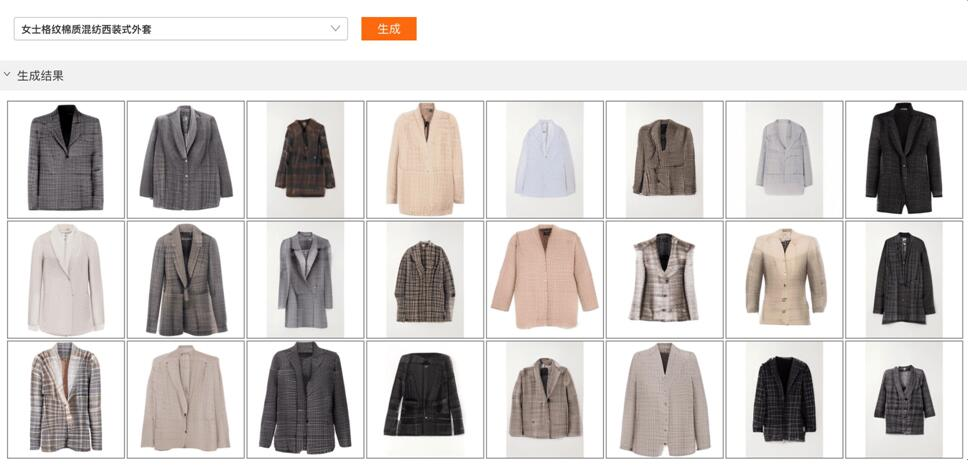

1、文本-图像生成

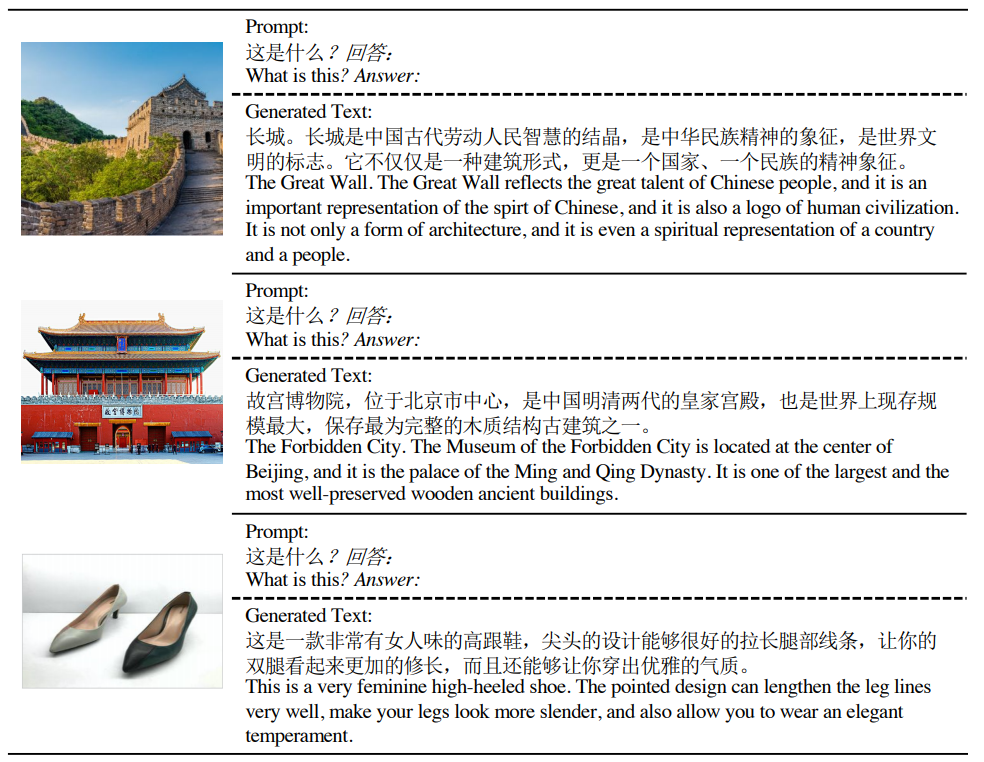

2、视觉问答

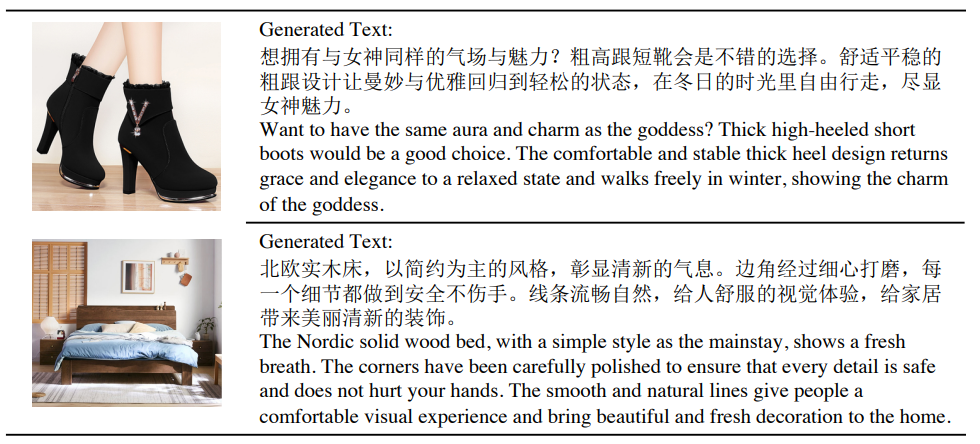

3、图片文字说明

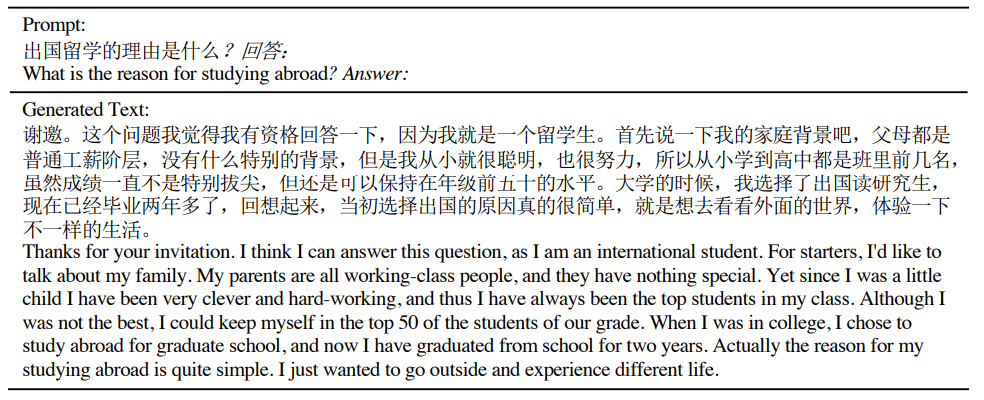

4、问题回答

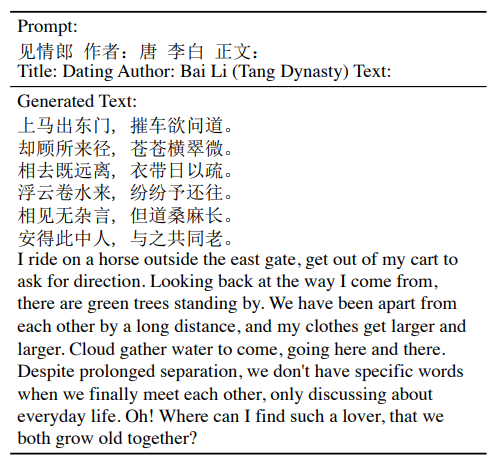

5、诗歌生成

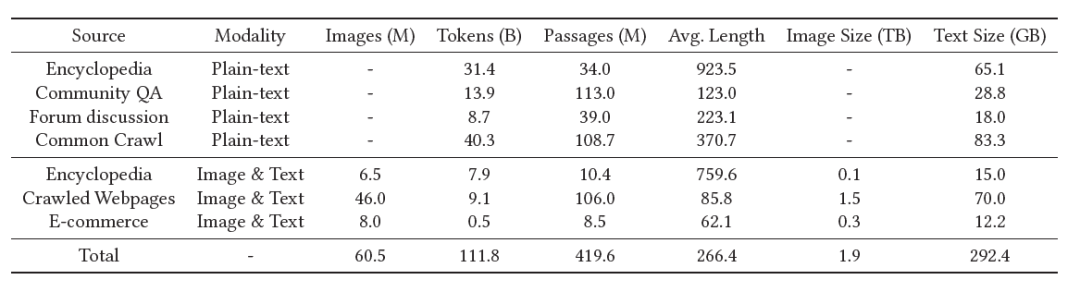

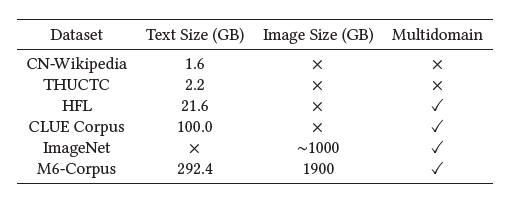

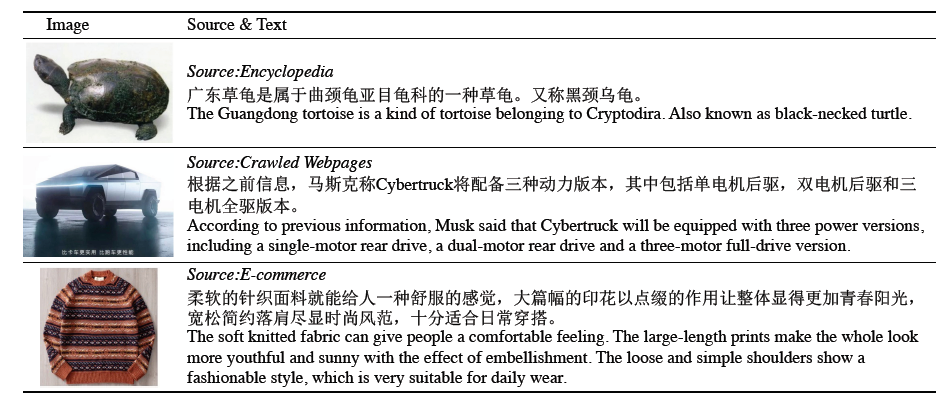

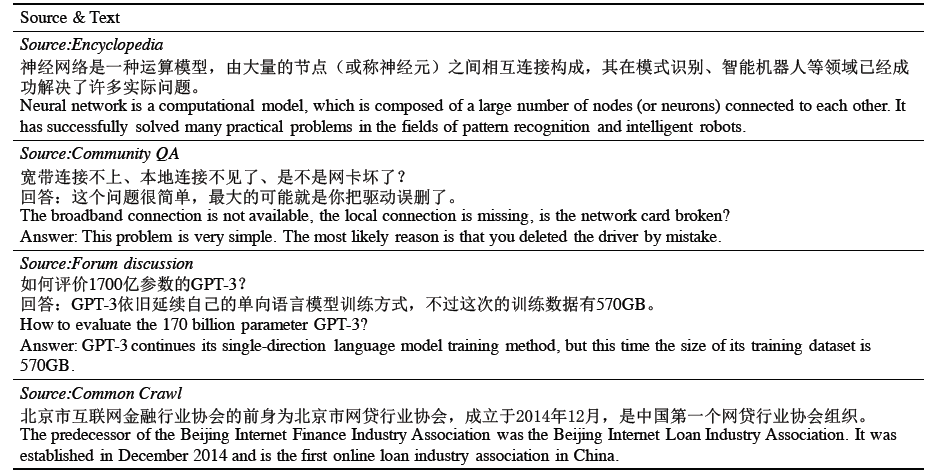

数据集

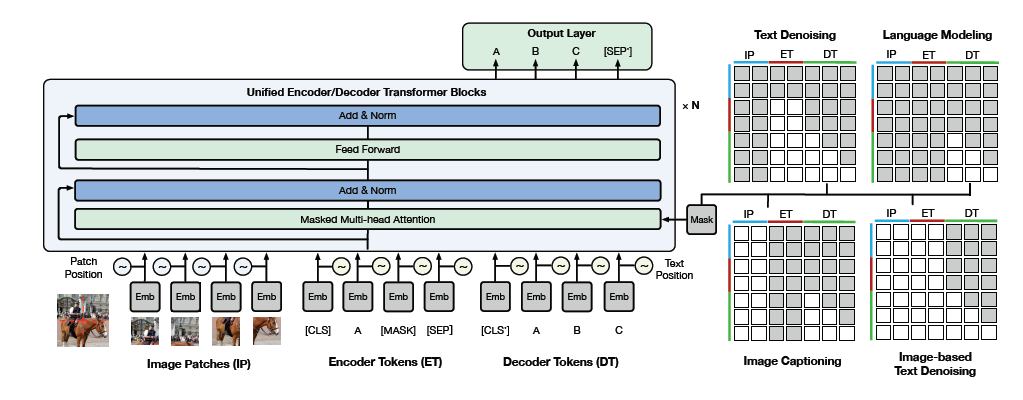

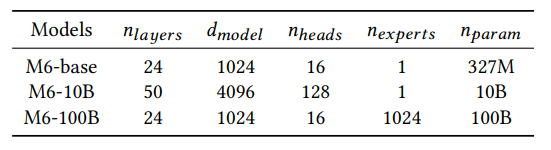

模型架构

总结与讨论

由于微信公众号试行乱序推送,您可能不再能准时收到AI科技评论的推送。为了第一时间收到AI科技评论的报道, 请将“AI科技评论”设为

星标账号

,以及常点文末右下角的“

在看

”。

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年4月25日

Arxiv

0+阅读 · 2021年4月23日