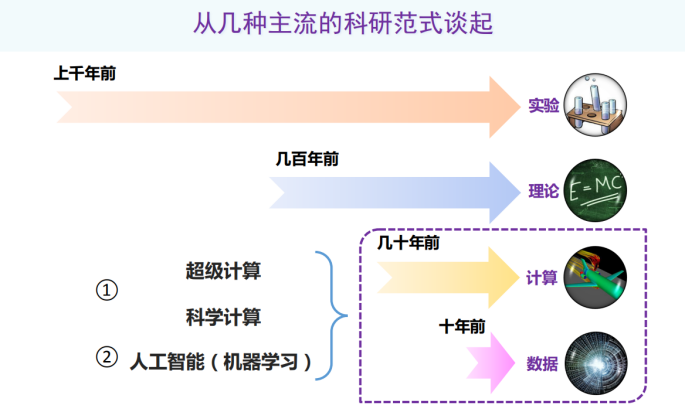

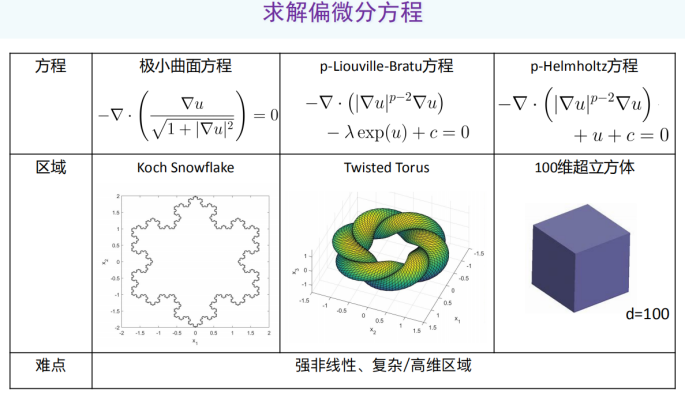

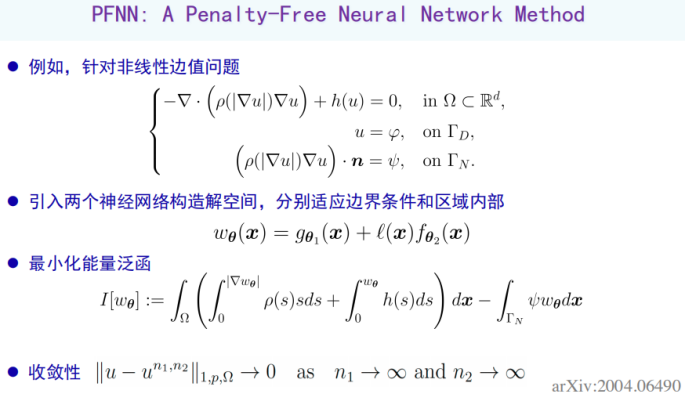

北大杨超:以偏微分方程求解为例,AI如何助力科学计算?

作者 | 未来论坛

编辑 | 蒋宝尚

登录查看更多

相关内容

Arxiv

9+阅读 · 2018年5月31日