基于语言的预训练模型在药物研发中的应用

一、药物发现越来越由软件驱动

在分子机器学习技术的指导下,分子的算法设计越来越普遍。

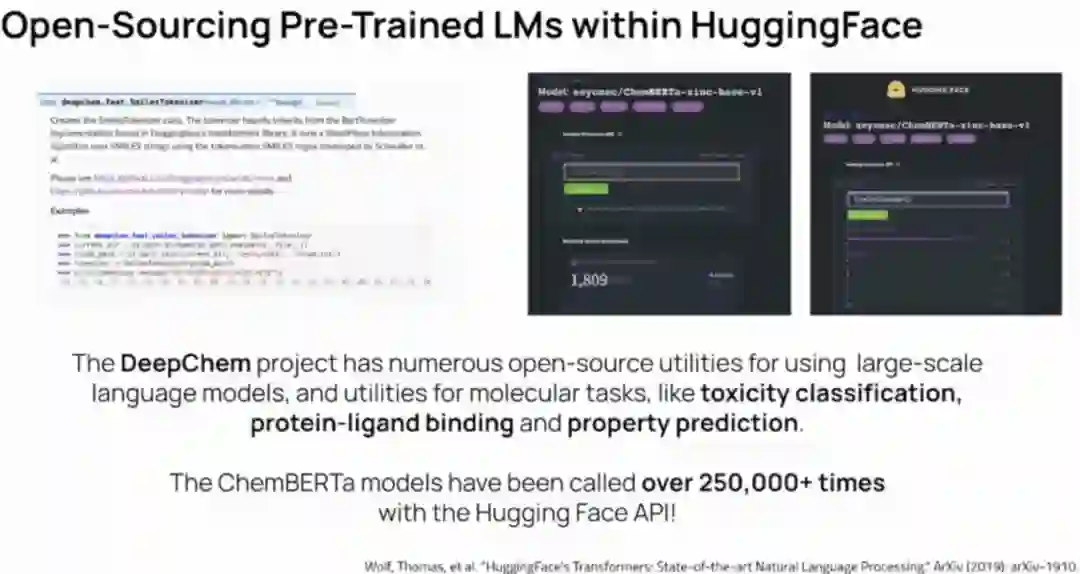

DeepChem项目创建了用于科学深度学习的开发工具。

MoleculeNet为改进和测试分子算法建立了开发的数据集。

youtue视频:

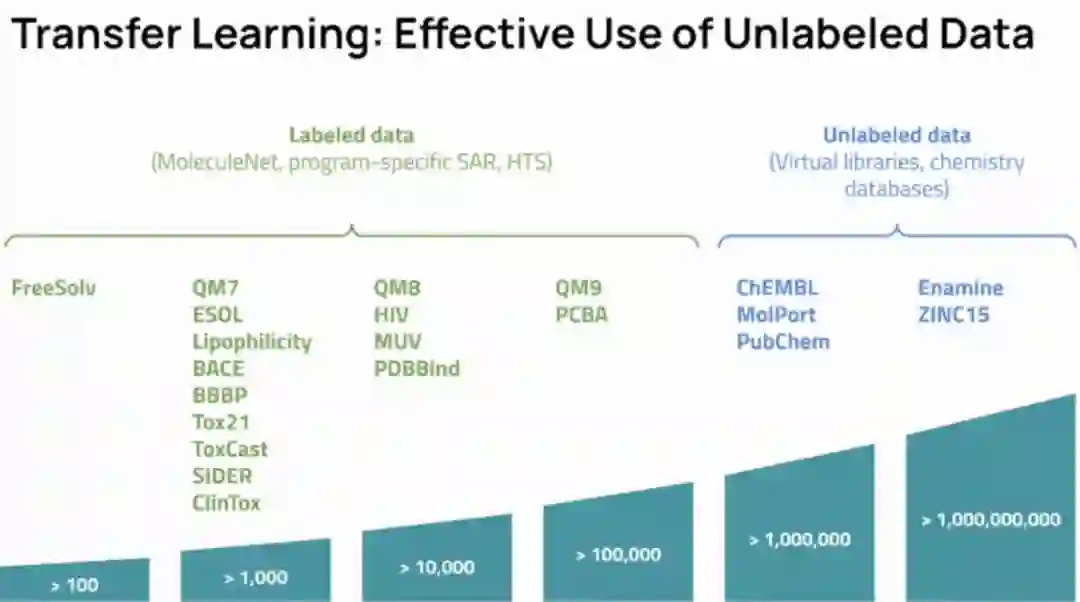

二、有效的迁移学习是分子机器学习面临的重大挑战

(1)DeepChem团队的早期工作曾尝试使用基于图像的体系结构(Chemception)进行迁移学习,但是效果很脆弱。

(2)斯坦福大学的研究探索了基于图的预训练。

(3)其他尝试的大量文献(multitask learning, one shot learning, semi-supervised learning, constrastive learning...)。

三、NLP技术可以在药物发现中进行有效的迁移学习吗?

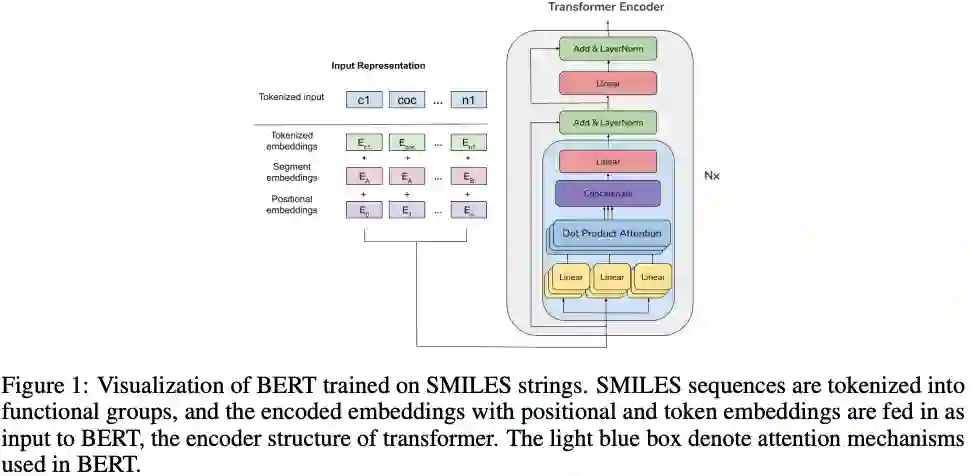

斯坦福大学2020年7月发表了文章"BERT Learns(and Teaches) Chemistry"。这项工作成功的将基于transformer的BERT用在化学结构的表征,作者建议使用注意力从数据驱动的角度研究影响分子子结构的官能团和其他属性,在分子的字符串表示数据集上使用基于transformer的模型(BERT),并分析其attention head的行为。

作者应用模型学习的官能团和原子的表示,在较小的数据集上解决毒性、溶解性、药物相似性和药物合成问题,使用学习的表示作为分子图形结构上的图形卷积和注意模型的特征,以及进行BERT的微调。作者还建议使用注意力可视化作为一种有用的工具,帮助化学从业者和学生快速识别各种化学性质中的重要子结构。

Payne,Josh, et al. "BERT Learns(and Teaches) Chemistry" arXiv 2020

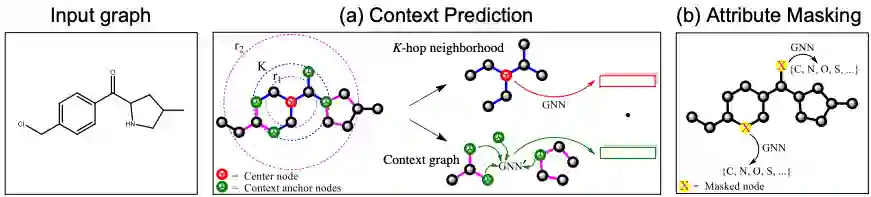

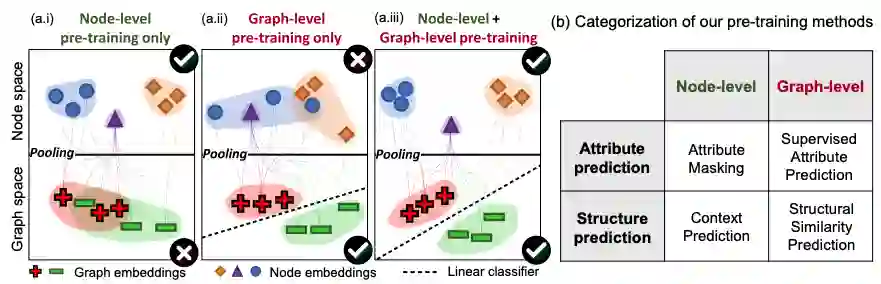

第二篇文章斯坦福和哈佛大学在ICLR2020上发表了“ Strategies for Pretraining Graph Neural Networks”的文章

本文提出了一种在node-level和graph-level同时学习的图神经网络预训练模型,能够很好的得到分子图的局部和全局的表示,实验证明预训练模型在ROC-AUC上超过了非预训练模型9.4%,并在分子性质预测和蛋白质功能预测方面达到了最好的结果。

Weihua Hu,Jure Leskover, et al.Strategies for Pretraining Graph Neural Networks.(ICLR 2020)

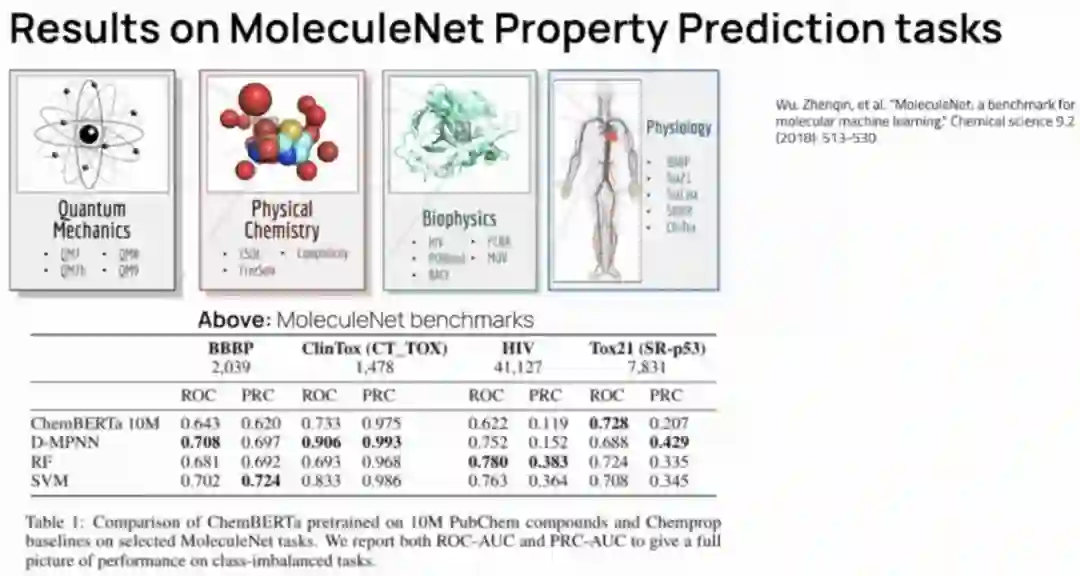

第三篇文章“ChemBERTa: Large-Scale Self-Supervised Pre-Training for Molecular Property Prediction”,ChemBERTa:使用原子填充和掩码原子预测作为预训练任务学习,该模型可以很好的适应预训练数据集的大小,在MoleculeNet上提供有竞争力的下游性能,并能提供有用的基于注意力的可视化模式。

DeepChem是以MoleculeNet作为bechmark做screen,其MoleculeNet元件包括:量子力学(Quantum Mechanics)、物理化学(Physical Chemistry)、生物物理学(biophysics)、物理生理学(Physiology)。

未来方向

(1)更好的预训练策略

Pre-training on RDKit physiochemical descriptors(work in-progress).

(2)Vertical scaling

Pretraining on PubChem 77M,ZINC15, and beyond;

Larger capacity transformer models.

(3)Horizontal scaling

Expand evaluation to all of MolecularNet tasks with ChemBERTa wrapper script;

Multitask datasets;

More systematic hyperparameter tuning during finetuning ;

(4) Transformers<>GNNs

GROVER(NeurIPS 2020)

Transformers are(a special case of)graph neural networks!

参考文献

[1] BERT Learns(and Teaches) Chemistry

[2] Strategies for Pretraining Graph Neural Networks.(ICLR 2020)

[3] ChemBERTa: Large-Scale Self-Supervised Pre-Training for Molecular Property Prediction

[4] The DeepChem Project:https://deepchem.io

入群交流请备注:单位_姓名_职位