清华&南开最新「视觉注意力机制Attention」综述论文,带你全面了解六大类注意力机制方法

【导读】注意力机制是深度学习方法的一个重要主题。清华大学计算机图形学团队和南开大学程明明教授团队、卡迪夫大学Ralph R. Martin教授合作,在ArXiv上发布关于计算机视觉中的注意力机制的综述文章[1]。该综述系统地介绍了注意力机制在计算机视觉领域中相关工作,并创建了一个仓库

https://github.com/MenghaoGuo/Awesome-Vision-Attentions摘要

人类可以自然有效地在复杂的场景中找到显著区域。在这种观察的推动下,注意力机制被引入到计算机视觉中,目的是模仿人类视觉系统的这方面。这种注意力机制可以看作是一个基于输入图像特征的动态权值调整过程。注意力机制在图像分类、目标检测、语义分割、视频理解、图像生成、三维视觉、多模态任务和自监督学习等视觉任务中取得了巨大的成功。本文综述了计算机视觉中的各种注意力机制,并对其进行了分类,如通道注意力、空间注意力、时间注意力和分支注意力; 相关的存储库https://github.com/MenghaoGuo/Awesome-Vision-Attentions专门用于收集相关的工作。本文还提出了注意机力制研究的未来方向。

https://www.zhuanzhi.ai/paper/2329d809f32ca0840bd93429d1cef0fe

引言

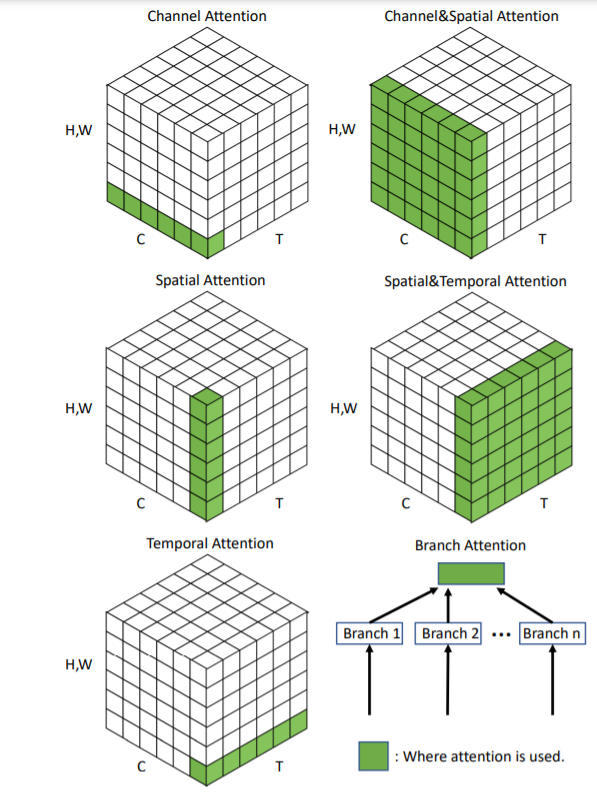

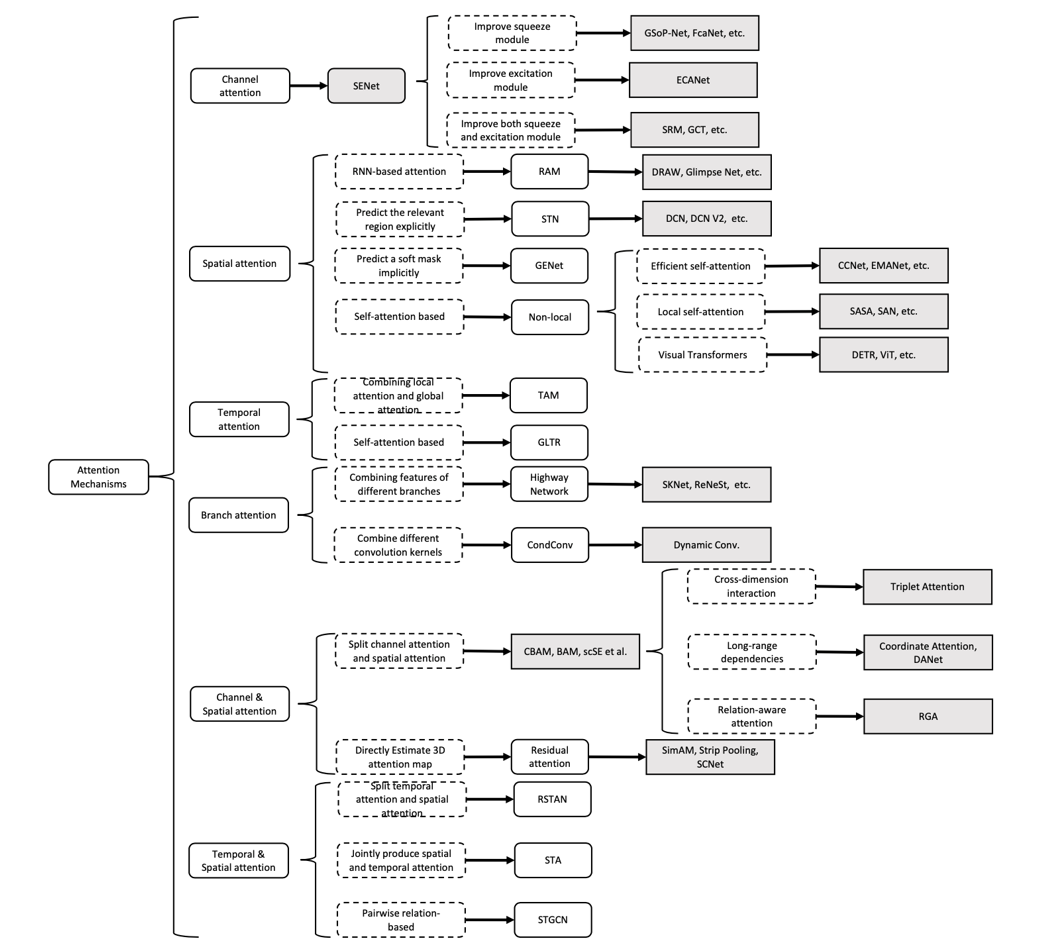

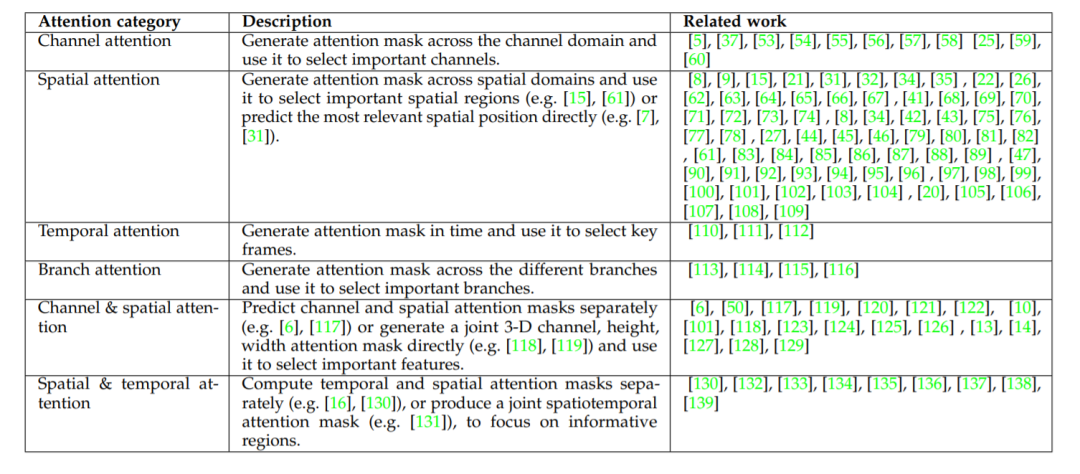

本文的目的是对当前计算机视觉中的注意力方法进行总结和分类。我们的方法如图1所示,并在图2中进一步解释 :它是基于数据域的。有些方法考虑重要数据何时出现的问题,或者它在哪里出现的问题,等等,并相应地尝试查找数据中的关键时间或位置。我们将现有的注意力方法分为六类,其中包括四种基本类别:通道注意力(注意力什么[50])、空间注意力(注意什么地方)、时间注意力(注意力什么时间)和分支通道(注意力什么地方),以及两种混合组合类别:通道&空间注意力和空间&时间注意力。这些观点和相关工作在表2中进行了进一步的简要总结。

对视觉注意力方法的系统综述,包括注意力机制的统一描述、视觉注意机制的发展以及当前的研究;

根据他们的数据域对注意力方法进行分类分组,使我们能够独立于特定的应用程序将视觉注意力方法联系起来

对未来视觉注意力研究的建议。

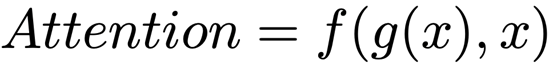

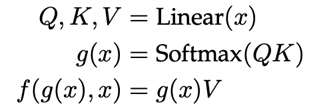

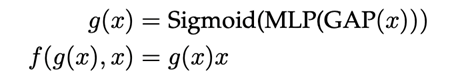

注意力机制可以理解为,计算机视觉系统在模拟人类视觉系统中可以迅速高效地关注到重点区域的特性。对于人类来说,当面对复杂场景的时候,我们可以迅速关注到重点区域,并处理这些区域。对于视觉系统,上述过程可以抽象成下面的式子:

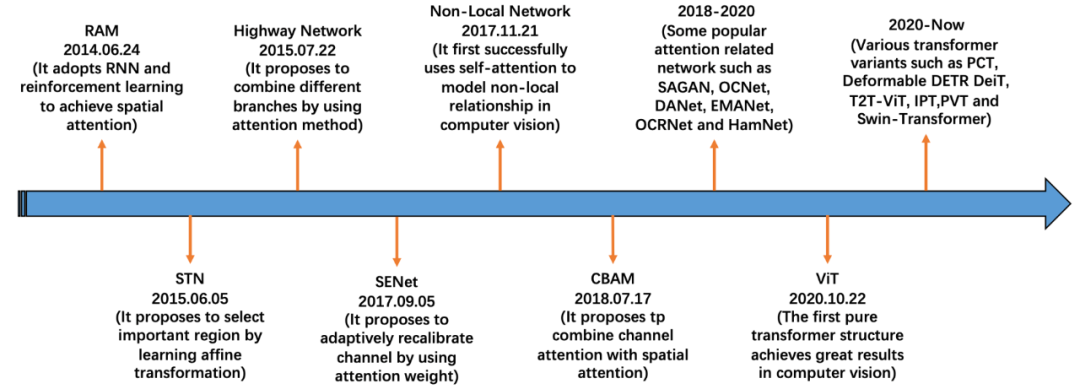

视觉中注意力机制的发展过程如图1所示。

图1 视觉中注意力机制的发展过程

视觉中的注意力机制可以粗略的分成四个部分:第一个部分是开始于 RAM[4],特点是都使用了RNN网络进行产生注意力。第二个部分是开始于 STN[5],特点是显式地预测重要的区域,代表性工作还有DCNs[6, 7] 等。第三个部分是开始于 SENet[3],特点是隐式地预测重要的部分,代表性工作还有CBAM[8] 等。第四个部分是自注意力机制相关的注意力方法,代表性工作有Non-Local[2], ViT[9] 等。图2给出了这些方法的分类树。

简要总结注意力类别及重点相关工作。

-

注意力机制的充分必要条件 -

更加通用的注意力模块 -

注意力机制的可解释性 -

注意力机制中的稀疏激活 -

基于注意力机制的预训练模型 -

适用于注意力机制的优化方法 -

部署注意力机制的模型

M.-H. Guo, T.-X. Xu, J.-J. Liu, Z.-N. Liu, P.-T. Jiang, T.-J. Mu, S.-H. Zhang, R. R. Martin, M.-M. Cheng and S.-M. Hu, Attention Mechanisms in Computer Vision: A Survey,arXiv 2111.07624.

X. Wang, R. Girshick, A. Gupta, K. He, Non-local neural networks, CVPR 2018, 7794-7803.

J. Hu, L. Shen, S. Albanie, G. Sun, E. Wu, Squeeze-and-excitation networks, IEEE TPAMI, 2020,Vol. 42, No. 8, 2011-2023

V. Mnih, N. Heess, A. Graves, K. Kavukcuoglu, Recurrent models of visual attention, NeurIPS 2014,2204-2212.

M. Jaderberg, K. Simonyan, A. Zisserman, K. Kavukcuoglu, Spatial transformer networks, NeurIPS 2015, 2017-2025.

J. Dai, H. Qi, Y. Xiong, Y. Li, G. Zhang, H. Hu, Y. Wei, Deformable convolutional networks, ICCV 2017, 764-773.

参考链接:

https://mp.weixin.qq.com/s/0iOZ45NTK9qSWJQlcI3_kQ

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“ACV” 就可以获取《清华&南开最新「视觉注意力机制Attention」综述论文,带你全面了解六大类注意力机制方法》论文专知下载链接