最新「注意力机制Attention」大综述论文,66页pdf569篇文献

摘要:

在人类中,注意力是所有感知和认知操作的核心属性。考虑到我们处理竞争性信息来源的能力有限,注意力机制选择、调整和关注与行为最相关的信息。

几十年来,哲学、心理学、神经科学和计算机科学都在研究注意力的概念和功能。在过去的六年中,这一特性在深度神经网络中得到了广泛的研究。目前,深度学习的研究进展主要体现在几个应用领域的神经注意力模型上。

本论文对神经注意力模型的发展进行了全面的概述和分析。我们系统地回顾了该领域的数百个架构,识别并讨论了那些显示出重大影响的注意力模型架构。我们亦制订了一套自动化方法体系,并将其公诸于众,以促进这方面的研究工作。通过批判性地分析650部文献,我们描述了注意力在卷积、循环网络和生成模型中的主要用途,识别了使用和应用的共同子组。

此外,我们还描述了注意力在不同应用领域的影响及其对神经网络可解释性的影响。最后,我们列出了进一步研究的可能趋势和机会,希望这篇综述能够对该领域的主要注意力模型提供一个简明的概述,并指导研究者开发未来的方法,以推动进一步的改进。

为了评估注意力在深度神经网络中的广泛应用,我们对该领域进行了系统的综述。在我们的回顾中,我们批判性地分析了650篇论文。作为我们工作的主要贡献,我们强调:

1. 一种可复制的研究方法。在附录中,我们提供了收集数据的详细过程,我们提供了收集论文的脚本,并创建了我们使用的图表;

2. 对该领域的深入概述。我们批判性地分析了650篇论文,从中提取了不同的指标,使用各种可视化技术来突出该领域的总体趋势;

3.我们描述了主要的注意力机制;

4. 我们提出了利用注意力机制的主要神经结构,描述了它们对神经网络领域的贡献;

5. 我们介绍了注意力模块或接口如何在经典的DL架构中应用,扩展了神经网络家族;

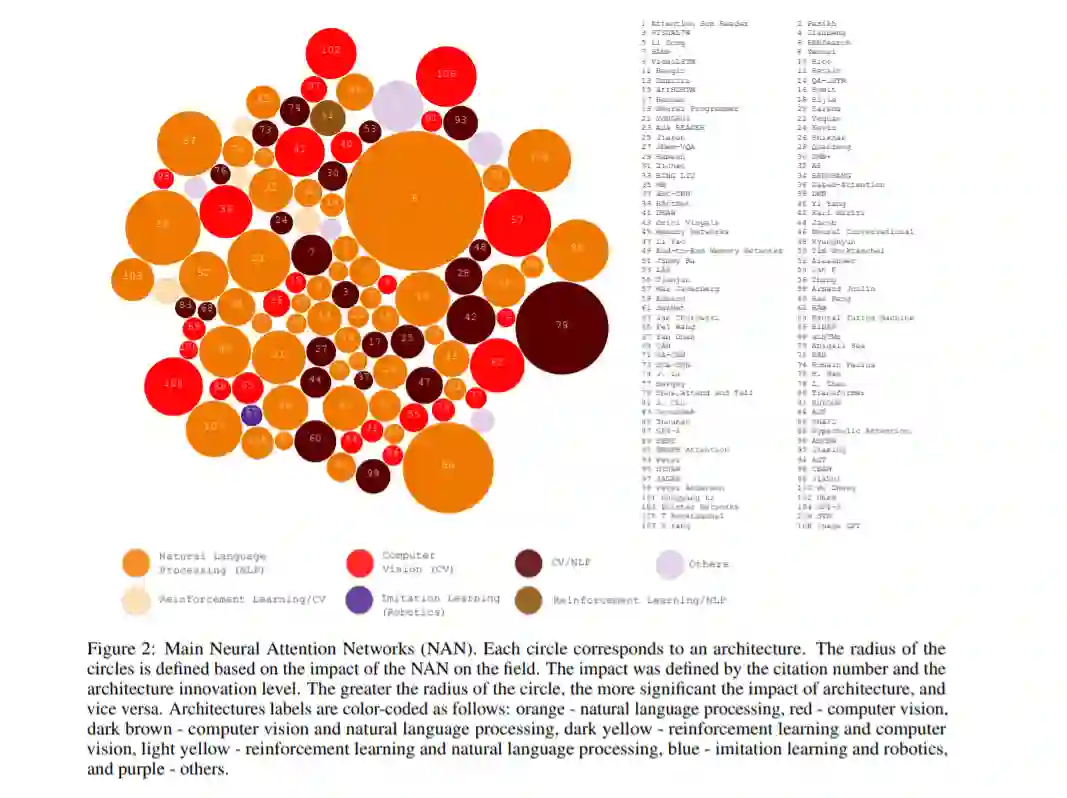

从历史上看,计算注意力系统的研究始于20世纪80年代。直到2014年年中,神经注意力网络(NANs)才出现在自然语言处理(NLP)领域,注意力通过可扩展和直接的网络提供了重大进展,带来了有前景的结果。注意力让我们能够转向复杂的任务,如对话机器理解、情感分析、机器翻译、问答和迁移学习,这些以前都很有挑战性。随后,NANs出现在其他对人工智能同样重要的领域,如计算机视觉、强化学习和机器人技术。目前有许多注意力架构,但很少有具有显著更高的影响,如图2所示。在这张图中,我们描绘了最相关的一组根据引文级别和创新进行组织的作品,其中RNNSearch[44]、Transformer[37]、Memory Networks[38]、“show, attend and tell”[45]和RAM[46]是最重要的发展。

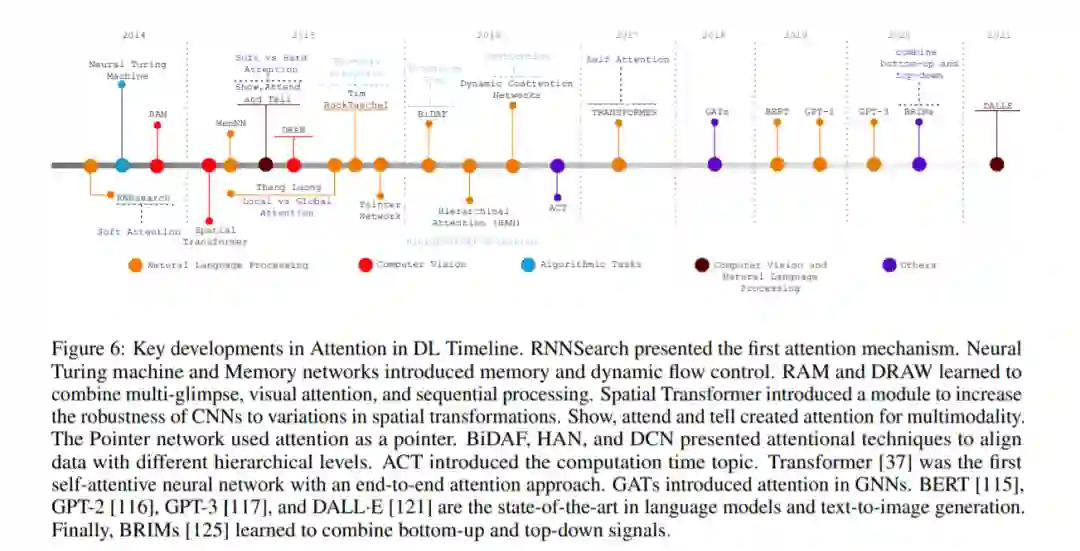

目前,混合模型利用了注意力在深度学习中的主要发展(图6),引起了科学界的兴趣。此外,基于Transformer、GATs和内存网络的混合模型已经出现在多模态学习和其他几个应用领域。双曲线注意力网络(HAN)[122]、双曲线图注意力网络(GHN)[123]、时序图网络(TGN)[124]和基于记忆的图网络(MGN)[87]是最有希望的发展。双曲网络是一种新型的架构,它结合了自注意力、记忆、图形和双曲几何的优点,在激活神经网络以进行高容量的推理,而不是由深度神经网络产生的嵌入。自2019年以来,这些网络作为一个新的研究分支脱颖而出,因为它们在保持神经表示紧凑的同时,代表了神经机器翻译、图形学习和视觉回答问题任务的最先进的泛化。自2019年以来,GATs也因其在从生物学、粒子物理、社会网络到推荐系统等广泛问题中学习复杂关系或互动的能力而受到了很多关注。为了改善节点的表示,并扩大GATs处理动态数据的能力(即随着时间变化的特征或连接),人们提出了结合内存模块和时间维度的架构,如MGNs和TGNs。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“A66” 就可以获取《最新「注意力机制Attention」大综述论文,66页pdf569篇文献》专知下载链接