图学习论坛|从架构到算法,全方位阐述图的最新实践探索!

0

导读

图结构广泛存在于我们的生活中,大到社交网络,小到化学分子结构,而图学习则是指在这些图结构上的机器学习,是目前最火爆的AI研究领域之一。

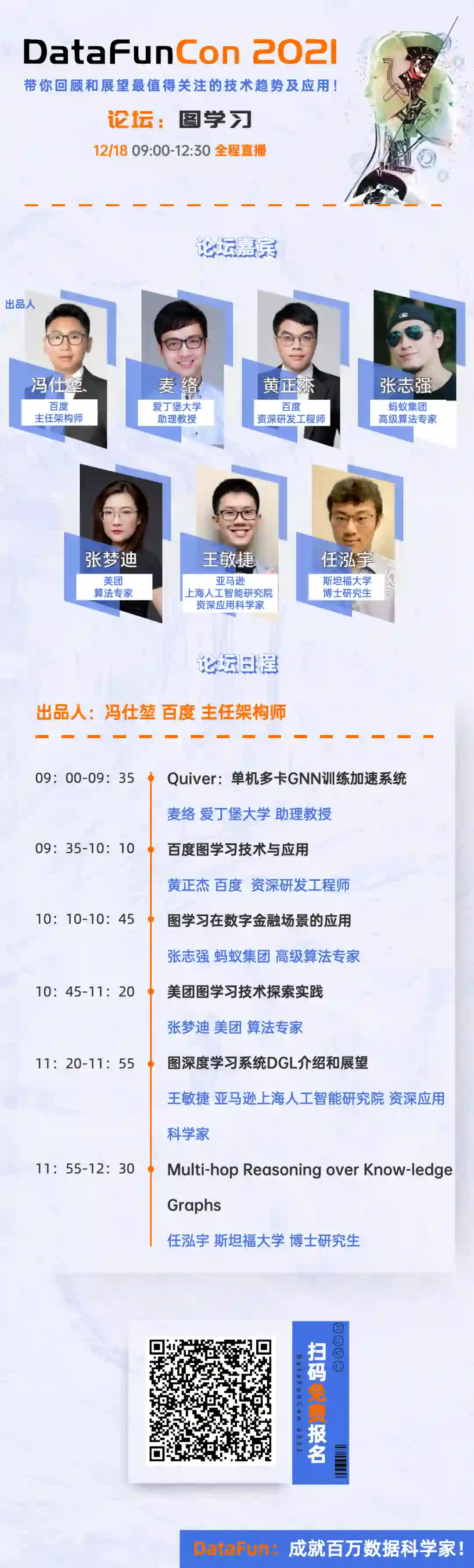

12月18日,9:00-12:30,在DataFunCon大会上,由百度主任架构师冯仕堃老师出品的图学习论坛,将与大家见面,从架构、算法、应用多个维度来全方面阐述图学习技术在学术界和工业界的最新的进展,期待和听众一起总结过去展望未来。

下面,就为大家带来本次论坛的详细介绍:

1

出品人

2

分享嘉宾

1. 麦络 爱丁堡大学 助理教授

演讲议题:Quiver-单机多卡GNN训练加速系统

演讲议题介绍:Sample-Based的图模型训练中,采样和特征聚合成为了较大的性能瓶颈。我们提出了Quiver以大幅度加速图模型的训练中的数据预处理速度。本次分享中,我们将着重介绍我们在Out-Of-Core的GPU图采样以及特征聚合方面的探索和工作, Quiver在单机多卡上的扩展性以及性能都具有非常好的性能。

听众收益:

听众将对使用GPU进行高效的图模型训练数据预处理有较为深刻的理解,并且可以直接借鉴使用在公司内部训练系统的研发

对图学习模型训练中的性能瓶颈有更深刻的理解

新技术/实用技术点:

GPU的Unified Virtual Addressing技术可以把部分CPU内存映射到GPU进程的地址空间,这样GPU上执行的Kernel可以直接访问CPU同学内存。

图划分算法如:Metis划分算法、Random Partition算法。

个人简介:麦络是爱丁堡大学信息学院助理教授,领导大规模AI系统团队。其在帝国理工学院获得博士学位,博士期间获得Google Fellowship资助。麦络在的研究成果多次发表在国际知名的数据库,机器学习和计算机系统会议。其相关的机器学习系统研究成果已经成为知名的开源项目,如Quiver, KungFu和TensorLayer。

2. 黄正杰 百度 资深研发工程师

演讲议题:百度图学习技术与应用

演讲议题介绍:本次分享将会介绍图学习以及图神经网络技术在百度是如何应用落地的。

听众收益:本次议题将会介绍图神经网络和图学习技术在百度应用以及落地。其中包括介绍百度自研的图神经网络框架PGL;图神经网络推荐系统工具Graph4Rec的技术及应用;知识增强文本图模型ERNIE-Sage的技术及应用。

新技术/实用技术点:图神经网络、预训练模型、分布式机器学习

个人简介:黄正杰,百度自然语言处理部资深研发工程师,毕业于中山大学,长期深耕语义表示计算、图学习等领域的研发工作,目前是飞桨图学习框架PGL负责人,并负责相关工作在百度搜索、信息流、商业广告等核心产品的应用落地。在KDDCup-2021图学习比赛获得2个赛道冠军,在人工智能顶级会议KDD、IJCAI等有多篇发表多篇学术论文,拥有多项相关专利。

3. 张志强 蚂蚁集团 高级算法专家

演讲议题:图学习在数字金融场景的应用

演讲议题介绍:蚂蚁集团的数字生活、数字金融场景沉淀了万亿级海量的图结构数据,深入挖掘其中蕴含的信息可带来巨大的经济和社会效益。本次分享主要聚焦过去几年蚂蚁集团自研的图学习技术,包括图学习算法、超大规模图学习系统,以及在数字生活、数字金融等工业场景的应用落地。

听众收益:

了解工业场景下图结构数据的特性,以及如何有针对性地设计工业级图学习算法

了解工业应用对图学习系统的要求,以及如何设计能支撑万亿规模图数据的图学习系统

了解图学习技术如何被应用于金融风控、推荐营销等数字金融场景

新技术/实用技术点:图神经网络、搜索推荐、金融风险分析、图学习系统

个人简介:2016年硕士毕业于北京邮电大学,目前是蚂蚁集团图学习方向技术负责人,高级算法专家。主要研究方向包括图学习算法、系统及其在工业场景的应用,在NIPS、KDD、VLDB、AAAI等国际会议发表论文30余篇,获人工智能学会2020年“吴文俊人工智能科技进步一等奖”。

4. 张梦迪 美团 算法专家

演讲议题:美团图学习技术探索实践

个人简介:张梦迪,担任美团点评NLP中心算法专家,目前主要负责知识推理及表示学习算法研究工作,带领团队围绕美团生活服务场景打造了大规模图表征学习平台、图谱路径解释性服务,支持餐饮、酒旅、电商、配送、金融等业务中关联数据挖掘和利用,在搜索、推荐、广告、调度、风控、运营等系统各链路环节做知识增强,赋能用户、商家、骑手。曾任金融科技公司开放数据负责人、清华大学知识图谱工程室研究助理,联合发起了OpenKG中文开放图谱社区。深耕知识计算领域,发表多篇论文于KDD/ACL/ICDM/DASFFA等国际学术会议,在图谱、搜索、问答相关领域有着丰富的实践经验。

5. 王敏捷 亚马逊上海人工智能研究院 资深应用科学家

演讲议题:图深度学习系统DGL介绍和展望

演讲议题介绍:Deep Graph Library (DGL)是全球领先的图深度学习框架之一,不论在学界还是业界都拥有较高的知名度和大量的用户。本报告会回顾DGL过去近三年的开源历程,介绍围绕DGL所构建的开源项目和系统研究。最后我们将介绍DGL在未来迈向1.0稳定版的一些计划和目标。

听众收益:从浅入深了解什么是图神经网络,其基本原理和应用。学习知名图神经网络引擎DGL的设计理念和系统特点。了解开源项目从立项到持续演进的过程,了解DGL对于开源社区的一些维护心得。

新技术/实用技术点:对深度学习有一定了解。实践过深度学习算法更佳。

个人简介:王敏捷博士毕业于纽约大学计算机系系统研究实验室,研究方向包括深度学习系统,大规模分布式机器学习等深度学习与系统的交叉领域。 发起并参与多项著名开源深度学习系统。 其中包括被英伟达评为“Modern AI Engine”的Minerva系统,成为亚马逊首选深度学习框架的MXNet系统,图神经网络框架DGL,可微编程框架MinPy等。 他同时也是开源社区DMLC的发起人之一,并在2016年获得英伟达博士奖学金。 目前担任亚马逊上海人工智能研究院资深应用科学家,主攻下一代深度学习框架,图神经网络以及开源项目及开源社区建设。

6. 任泓宇 斯坦福大学 博士研究生

演讲议题:Multi-hop Reasoning over Knowledge Graphs

演讲议题介绍:

Learning low-dimensional embeddings of knowledge graphs (KGs) is a powerful approach for predicting unobserved or missing relations between entities. However, an open challenge in this area is developing techniques that can go beyond single link prediction and handle more complex multi-hop logical queries, which might involve multiple unobserved edges, entities, and variables. In this talk I present a framework to efficiently and robustly answer multi-hop logical queries on knowledge graphs. Based on prior work that learns entity and relation embeddings on KGs, our key insight is to embed queries in the latent space and design neural logical operators that simulate the real logical operations. We give rise to the first multi-hop reasoning framework that can handle all first-order logic queries on large-scale KGs. We demonstrate the effectiveness and robustness of our approach in the presence of noise and missing relations for query answering on KGs. Finally, I will introduce an efficient codebase SMORE, the first framework that scales the above algorithms to KGs with over 90 million nodes.

听众收益:

Recent advances in knowledge graph embeddings, neural symbolic reasoning and beyond.

新技术/实用技术点:

Query2box: Reasoning Over Knowledge Graphs In Vector Space Using Box Embeddings. H. Ren, W. Hu, J. Leskovec. ICLR, 2020.

Beta Embeddings for Multi-Hop Logical Reasoning in Knowledge Graphs. H. Ren, J. Leskovec. NeurIPS 2020.

SMORE: Knowledge Graph Completion and Multi-hop Reasoning in Massive Knowledge Graphs. H. Ren, H. Dai, B. Dai, X. Chen, D. Zhou, J. Leskovec, D. Schuurmans. ICML SSL workshop 2021.

个人简介:

Hongyu Ren is a fourth year CS Ph.D. student at Stanford advised by Prof. Jure Leskovec. His research interests lie in the intersection of graph representation learning and neural symbolic reasoning on structured data. His recent work includes learning knowledge representations and advancing multi-hop reasoning on large-scale knowledge graphs. His research is supported by the Masason Foundation Fellowship and Apple PhD Fellowship.

3

活动报名

本次分享全程直播,免费报名,感兴趣的小伙伴欢迎上车!