最新最全《深度元学习》2021综述论文,68页pdf,A Survey of Deep Meta-Learning

深度神经网络在拥有大量数据集和足够的计算资源的情况下能够取得巨大的成功。然而,他们快速学习新概念的能力相当有限。元学习是解决这一问题的一种方法,通过使网络学会如何学习。令人兴奋的深度元学习领域正在高速发展,但缺乏对当前技术的统一、深刻的概述。这项工作就是这样。在为读者提供理论基础之后,我们研究和总结了主要的方法,这些方法被分为i)度量;ii)模型;和iii)基于优化的技术。此外,我们确定了主要的开放挑战,如在异构基准上的性能评估,以及元学习计算成本的降低。

1. 引言

近年来,深度学习技术在各种任务上取得了显著的成功,包括游戏(Mnih et al., 2013; Silver et al., 2016),图像识别(Krizhevsky et al., 2012; He et al., 2015)和机器翻译(Wu et al., 2016)。尽管取得了这些进展,但仍有大量的挑战有待解决,例如实现良好性能所需的大量数据和训练。这些要求严重限制了深度神经网络快速学习新概念的能力,这是人类智能的定义方面之一(Jankowski等人,2011;(Lake等,2017)。

元学习被认为是克服这一挑战的一种策略(Naik and Mammone, 1992; Schmidhuber, 1987; Thrun, 1998)。其关键思想是元学习主体随着时间的推移提高自己的学习能力,或者等价地说,学会学习。学习过程主要与任务(一组观察)有关,并且发生在两个不同的层次上:内部和外部。在内部层,一个新的任务被提出,代理试图快速地从训练观察中学习相关的概念。这种快速的适应是通过在外部层次的早期任务中积累的知识来促进的。因此,内部层关注的是单个任务,而外部层关注的是多个任务。

从历史上看,元学习这个术语的使用范围很广。从最广泛的意义上说,它概括了所有利用之前的学习经验以更快地学习新任务的系统(Vanschoren, 2018)。这个广泛的概念包括更传统的机器学习算法选择和hyperparameter优化技术(Brazdil et al ., 2008)。然而,在这项工作中,我们专注于元学习领域的一个子集,该领域开发元学习程序来学习(深度)神经网络的良好诱导偏差。1从今以后,我们使用术语深元学习指元学习的领域。

深度元学习领域正在快速发展,但它缺乏一个连贯、统一的概述,无法提供对关键技术的详细洞察。Vanschoren(2018)对元学习技术进行了调查,其中元学习被广泛使用,限制了对深度元学习技术的描述。此外,在调查发表后,深度元学习领域也出现了许多令人兴奋的发展。Hospedales等人(2020)最近的一项调查采用了与我们相同的深度元学习概念,但目标是一个广泛的概述,而忽略了各种技术的技术细节。

我们试图通过提供当代深度元学习技术的详细解释来填补这一空白,使用统一的符号。此外,我们确定了当前的挑战和未来工作的方向。更具体地说,我们覆盖了监督和强化学习领域的现代技术,已经实现了最先进的性能,在该领域获得了普及,并提出了新的想法。由于MAML (Finn et al., 2017)和相关技术对该领域的影响,我们给予了格外的关注。本研究可作为深度元学习领域的系统性介绍,并可作为该领域资深研究人员的参考资料。在整个过程中,我们将采用Vinyals(2017)所使用的分类法,该分类法确定了三种深度元学习方法:i)度量、ii)模型和iii)基于优化的元学习技术。

目录内容:

概述

基础

度量元学习

基于模型的元学习

基于优化的元学习

2 理论基础

本节描述元学习领域的一些应用和背景。

2.1 元的概念

本节我们针对两个不同的方法(监督学习和强化学习)对比了常规学习和元学习。

2.1.1 常规监督学习

在强化学习中,我们希望能学习函数:

SL在这里代表“强化学习”。这个模型具有数据特异性,意味着模型可能对数据集

全局最优参数

这里

2.1.2 有监督的元学习

监督型元学习并不需要给定的先验知识

我们可以简短地数学描述一下,首先定义任务的概率分布

其中,

2.1.3 常规强化学习

在强化学习中,我们设置了从先验经验中进行学习的智能体(agent)模块。它依靠Markov Decision Process (MDP)进行建模,继而和环境相互作用。在MDP中,

在每一个时间步

其中我们能得到在MDP状态下可能轨迹的数学期望

此外,在强化学习的现实例子中,要找到全局最优参数

上式中

在MDP算法中,agent指导任何给定时间步

2.1.4 元强化学习

元的概念是有它自己的一组任务集合,或者是一系列MDPs。原本的强化学习是在单个MDP上获得奖励期望最大值,元强化学习是获得多种MDPs奖励期望的最大值。这里,MDPs是从分布

2.1.5 对比于其他领域

上文中我们介绍了在监督学习和强化学习中的元学习基础,接下来我们还需要对机器学习中其他使用元学习提升学习速率的领域进行介绍,主要为迁移学习和多任务学习。

迁移学习:在迁移学习中,人们希望将从先前任务中提取的知识迁移到新的,未知的任务中, 所以它也包含了元学习。在这里我们试图利用元知识来更快地学习新任务。元学习技术的一个关键在于是它们的元目标,它旨在优化多任务分配来提高性能(如前几节所述,通过降低对多任务的损失期望来实现)。迁移学习的目标并不一定一直存在。例如,当在大型数据集上对模型进行预训练,并在较小的数据集上对学习的权重进行微调时,就可能存在没有目标的情况。

多任务学习:另一个相关领域是多任务学习,在多任务学习中一个模型在训练后在多个目标任务中表现出良好的性能。相反的,元学习的目的在于找到一个能快速学会新任务的模型,差别体现在图1中:

2.1 元的设定

在上一节中,我们描述了(元)监督学习和强化学习的学习目标。在这节我们描述一般用来实现这些目标的设置。通常,模型通过使用各种任务来优化元目标,这些任务是在监督学习中的数据集,在强化学习的情况下是(部分可观察的)马尔可夫决策过程。这分三个阶段完成:i)元训练阶段,ii)元验证阶段和iii)元测试阶段,每个阶段都与一组任务相关联。

首先,在元训练阶段,将元学习算法应用于元训练任务。其次,元验证任务可以用于评估未知任务的性能,这些任务没有用于训练。这能有效地评估网络的泛化能力,这个泛化能力的评估用来反馈调整例如元学习算法的超参数。第三,元测试任务对元学习技术进行最终性能评估。

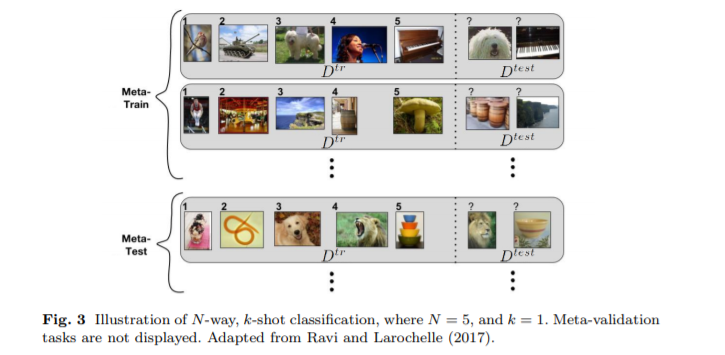

2.2.1 N-way, k-shot Learning

一种常用的元设置实例化叫做N-way, k-shot 分类法(见图2)。

这个设置也能被分为三个阶段——元训练、元验证和评估。每个阶段都有对应的非相交标签集。也就是说:

训练阶段的元学习目标是,以支持集为条件,最小化查询集上模型预测的损失函数。对于给定的任务,模型将从支持集中提取信息并对查询集进行预测。将模型应用于不同的任务,模型将慢慢积累元知识,最终能加快新任务的学习速度。达到这个目的最简单的方法是vanilla neural networks,不过同多位学者所言,更复杂的架构能够有效地优化这类网络。

在元验证和元测试阶段,已经学习到的原信息是固定的,但是模型仍然可以对参数进行针对特定任务的更新。更新完后,我们可以评估模型在测试中的表现。

N-way, k-shot 分类法适用于k值比较小的情况,我们希望模型能从几个样本中快速学习新知识。在这种情况下,可以称其为少样本学习(few-shot learning)。

2.2.2 公共数据集

本节描述了一些能评估元学习算法的数据集。

Omniglot (Lake et al., 2011):数据集包含来自50个不同字母的1623个不同手写字符。每一个字符都是由20个不同的人通过亚马逊的 Mechanical Turk 在线绘制的。

ImageNet (Deng et al., 2009):这是最大的图像分类数据集,包含超过2万个类别和超过1400万个彩色图像。miniImageNet是其微型变体,减少了进行实验的工作量,包含有60000张大小为84×84的彩色图像,共有100个类别,每个类别有600个示例。tieredImageNet是ImageNet数据集的另一个变体。它类似于miniImageNet,有34个类,每个类都有自己的子类。

CIFAR-10 and CIFAR-100 (Krizhevsky, 2009):其他两个图像识别数据集。每个包含有60000张大小为32×32的RGB图像。CIFAR-10和CIFAR-100分别包含10和100个类别,每个类别具有相同数量的示例(分别为6000和600)。CIFAR-100中的每个类也都有一个超类,整个数据集中有20个超类。可以采用CIFAR数据集的许多变体作为样本,例如 CIFAR-FS和FC-100。

CUB-200-2011 (Wah et al., 2011):该数据集包含有大约12000份有200个鸟的种类的RGB图片,每个图片有一些属性标签。

MNIST (LeCun et al., 2010):MNIST是手写数字集,包含有10类(0-9),数据集总共可分为60000份训练数据与10000份测试数据。

Meta-Dataset (Triantafillou et al., 2020):相对于其他数据集,该数据集的各种任务来自不同的数据集(的测试类)。此外,各任务之间的类数量和支持集大小可能不同,支持集中可能存在类不均衡的问题。

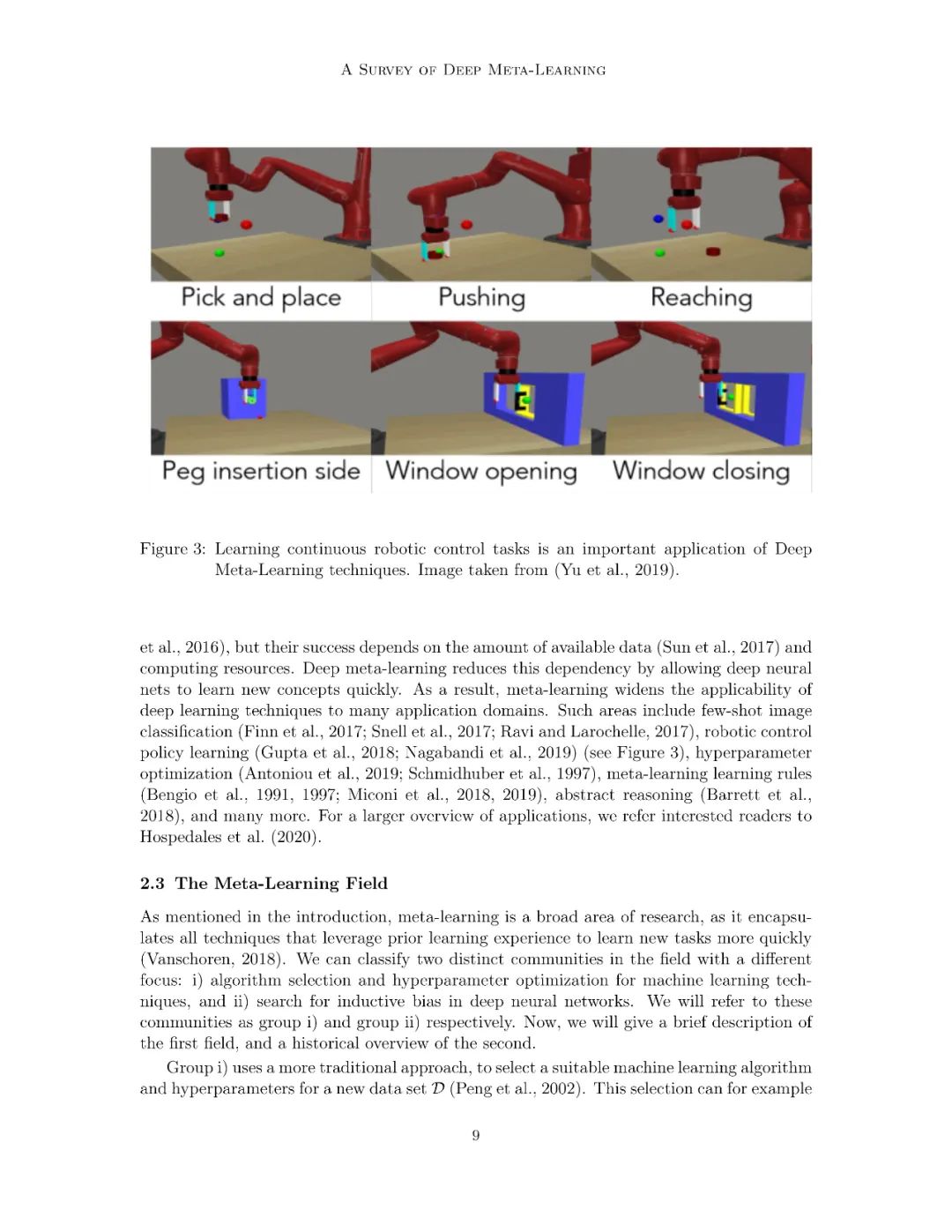

Meta-world (Yu et al., 2019):元强化学习的数据集,包含有50个机器人操纵任务(控制机器人手臂来实现一些预定目标,例如打开门或踢足球)。

2.2.3 元学习的一些应用

深度神经网络已经在图像识别、文本处理、自动游戏等方面有所成就,但是它们的成就是建立在大量有效数据的基础上的。深度元学习降低了任务独立性,但是能让网络更快地学习新概念。因此,元学习广泛地应用于图像分类、机器控制策略学习、超参数优化、元学习规则学习、抽象推理等等方面。

2.3 元学习领域

如同介绍中所说的,元学习在研究中应用广泛,它封装了所有利用先验知识进行学习的技术,从而能更快学习新任务。可以将领域分为两个部分:i)机器学习的算法选择和超参数优化。ii)在深度学习网络中搜索归纳偏倚。接下来我们简单介绍下领域一,再回顾下领域二。

领域一使用的方法更为传统。比如可以在各种数据集上使用已有的模型进行评估,再选择在最相似的数据集上表现得最好的模型。对于很多不同的算法,它们需要大型的已有模型评估数据库。对于此有OpenML计划,研究者可以在其中共享这类信息。但是深度神经网络的兴起打破了这个局面,它为神经网路的体系结构、权重以及激活函数带来了问题。这种方案已经不合适了。

领域二采用的是智能体自我完善的方法,该智能体随着时间的推移,通过发现合适的归纳偏倚来提高学习能力。根据Hospedales等人的观点,可以简单介绍深度元学习的发展历史。Schmidhuber(1987)和Hinton and Plaut(1987)做了开创性的工作。Schmidhuber开发了一种具有自我偏好的学习理论,其中神经网络的权重可以用作模型本身的输入,然后预测权重的更新(Schmidhuber,1987,1993)。同年,Hinton和Plaut(1987)提出在每个神经网络连接中使用两个权重,即慢速权重和快速权重,分别用作长期和短期记忆。后来出现了元学习学习规则的思想(Bengio等,1991,1997)。Hochreiter (2001)等人和Younger(2001)等人提出了使用梯度下降和反向传播的元学习技术。这两部作品对于深度元学习领域非常重要,因为大多数技术都依赖于反向传播。接下来,我们将分别详细地介绍基于指标,模型和优化的三类技术。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DML” 可以获取《最新最全《深度元学习》2020综述论文,59页pdf,A Survey of Deep Meta-Learning》专知下载链接索引