![]()

本文介绍的是CVPR 2020的论文《Fine-grained Video-Text Retrieval with Hierarchical Graph Reasoning》(已开源),文章作者是中国人民大学博士生陈师哲同学,这项工作是陈师哲同学在澳大利亚阿德莱德大学吴琦老师组访问时所完成。

![]()

论文链接:

http://arxiv.org/abs/2003.00392

代码链接:https://github.com/cshizhe/hgr_v2t

互联网上短视频的快速涌现为视频内容的精准检索带来了前所未有的挑战。使用自然语言文本描述对视频进行跨模态检索(Cross-modal Video-Text Retrieval)是最符合自然人机交互的方式之一,能更加全面细粒度地表达用户检索需求,得到了越来越多的研究关注。

当前跨模态检索的主要方法将视频和文本模态映射到联合视觉语义空间以计算跨模态相似度。大部分工作[1,2]使用全局特征向量分别表示视频和文本信息,但是文本和视频中包含了丰富复杂的元素,例如图1中的事件检索涉及了不同的动作、实体、以及动作实体之间的关系等等,使用单一的特征表示很难捕获细粒度的语义信息。少量工作[3]提出细粒度的密集匹配,将视频和文本表示为序列化特征,对每一序列元素进行局部对齐匹配,融合得到全局跨模态相似度,然而仅使用序列化表示忽略了文本或视频内部复杂的拓扑结构,不能准确地表示事件中不同元素之间的关系,使得局部对齐匹配的语义表达能力下降。

![]()

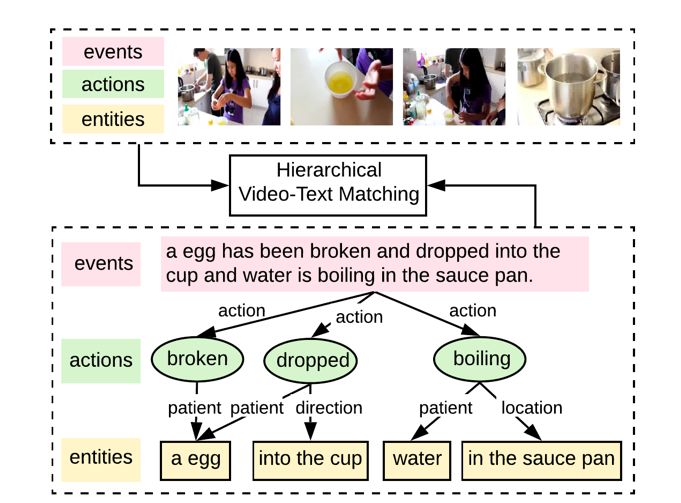

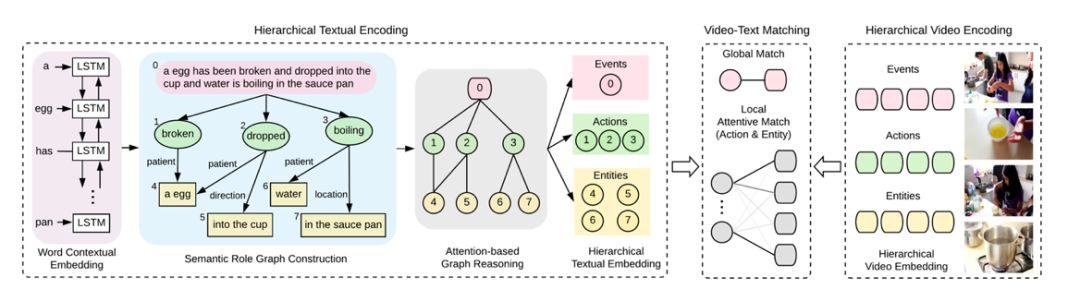

图1:视频文本匹配被分解包括事件(Event)、动作(Action)和实体(Entities)的三个层次,形成整体到局部的结构。一方面,模型可借助局部语义元素增强全局语义匹配;另一方面,全局语义信息也能帮助局部元素的语义理解,增强局部信息的跨模态匹配。

因此,我们提出了层次化图推理模型(Hierarchical Graph Reasoning model, HGR),更好地结合全局和局部密集匹配的优点,并弥补其不足。如图1所示,我们将视频文本匹配分解为三层的语义级别,分别负责刻画全局事件(Event)以及局部的动作(Action)和实体(Entities),以涵盖整体到局部的语义信息。

首先对于文本编码,全局事件由整个句子表示,动作由动词表示,实体则由名词短语表示。不同语义级别不是独立的,它们之间的交互反映了它们在事件中扮演的语义角色(Semantic Role),因此我们建立三层语义级别的语义角色图(Semantic Role Graph),提出利用基于注意力的图推理方法来捕捉图中的交互信息。

然后,不同层次的文本特征用于指导多样化的视频编码,视频也被编码为与事件、动作和实体相关的层次化表示。每一层次级通过注意力机制进行跨模态匹配,最后进行不同层次的融合。

我们在三个视频描述数据集上进行实验,从3个方面证明了所提出模型的有效性: 1) HGR模型在多个数据集中取得更好的跨模态检索结果;2) 在跨数据集实验中,HGR模型具有更强泛化性能;3) 提出了一个新的细粒度二元选择任务,HGR模型更能区分细粒度语义变化和选择更加全面的检索结果。

图2. 层次化图推理模型(Hierarchical Graph Reasoning model, HGR)的整体框架图。

视频文本描述天然具有层次化结构和组合特性[4]。整个句子描述了视频中的全局事件,该全局事件可分解为时序上的多个动作,每个动作又由不同实体及其与动作之间的不同关系构成。这种从整体到局部的结构有利于准确、全面地理解视频文本描述的语义。因此,我们提出基于整体到局部的拓扑结构获取文本描述的层次化表征,以不同层次的文本指导多样化的视频特征生成和进行匹配。

图2为细粒度视频文本检索的层次化图推理(HGR)模型,该模型同时捕获局部语义细节和全局事件结构以匹配视频和文本,主要包括三个部分:

1)层次化文本编码:根据文本构建语义角色图,通过多关系图推理获得层次化文本表示;

2)层次化视频编码:将视频映射到与文本层次相对应的多样化的多层视觉特征;

3)视频文本匹配:分层次进行跨模态对齐匹配,融合不同层次以计算总体相似度。

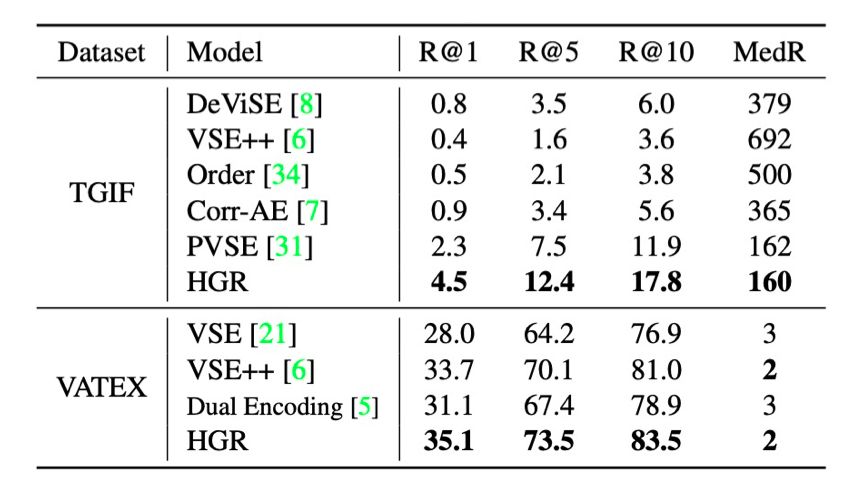

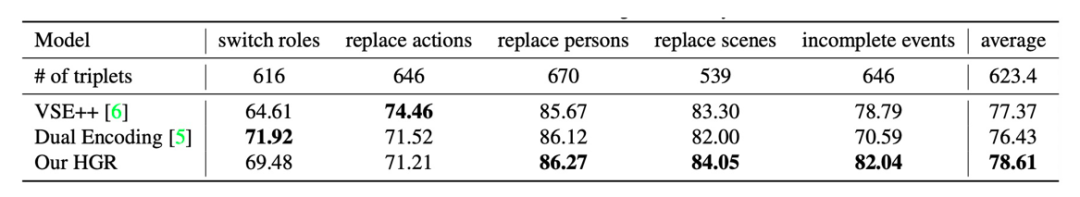

如表1所示,通过使用多层次的文本视频匹配,我们的模型HGR在多个数据集上取得了最好的跨模态检索性能。这表明将视频和文本分解为全局到局部的层次化图结构有益于提高跨模态检索的准确性。

![]()

表1. 在不同数据集上与SOTA模型进行跨模态检索性能比较。

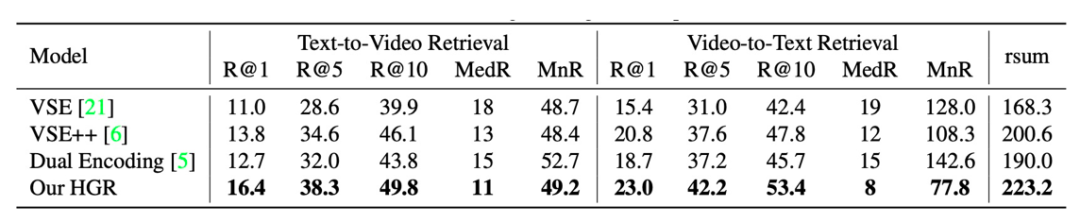

现有跨模态检索模型通常是在同一数据集进行训练和测试。但是,模型对于不同领域数据的泛化性能在实际中至关重要。因此,我们进一步进行跨数据集的泛化性能评估:在一个数据集上训练跨模态检索模型,然后在另一个未见的数据集上测试。表2为实验结果,HGR模型在跨领域的数据集上测试取得了显著更好的效果。这表明,对复杂事件在文本和视频上的多层次分解有益于提高在新领域的泛化能力。

![]()

为了验证模型的细粒度检索能力,我们进一步提出了一个二元选择任务,该任务要求模型从两句相似但语义截然不同的句子中选出更符合视频内容的句子。我们通过对原有视频文本描述修改得到负例,修改方式包括:交换角色、替换动作、 替换人物、 替换场景、 非完整事件。表3展示了不同模型在二元选择任务上的性能。HGR模型在非完整事件识别中的提升最大,通过从整体到局部的多层次融合,模型在检索时可以选择更加全面的句子。

![]()

现有跨模态视频文本检索模型主要基于联合语义空间方法,但是简单的特征表示难以捕获复杂视频和文本中的细粒度语义。

因此,我们提出了HGR模型,将视频和文本分解为包括事件、动作和实体在内的分层语义级别,通过基于注意力图推理生成分层的文本表示,指导多层次视频编码并进行多层次跨模态匹配。

所提出的HGR模型在多个视频文本数据集上具有更好的检索性能,并通过对复杂事件的分解和组合学习取得更好的跨数据集泛化能力和细粒度语义区分能力。

[1] Fartash Faghri, David J Fleet, Jamie Ryan Kiros, and Sanja Fidler. Vse++: Improving visual-semantic embeddings with hard negatives. BMVC, 2018.

[2] Jianfeng Dong, Xirong Li, Chaoxi Xu, Shouling Ji, Yuan He, Gang Yang, and Xun Wang. Dual encoding for zero-example video retrieval. CVPR, pages 9346–9355, 2019.

[3] Youngjae Yu, Jongseok Kim, and Gunhee Kim. A joint sequence fusion model for video question answering and retrieval. ECCV, pages 471–487, 2018.

[4] Michael Wray, Diane Larlus, Gabriela Csurka, and Dima Damen. Fine-grained action retrieval through multiple parts-of-speech embeddings. ICCV, October 2019.

CVPR 2020 系列报道

相关报道:

CVPR 2020接收论文公布:录用1470篇,接收率“二连降”,仅22% !

论文集:

01. 17篇入选CVPR 2020,腾讯优图 9 篇精选论文详解

02. 22篇入选,百度 15 篇 CVPR 2020 精选论文详解

论文解读:

01. [微软] 古有照妖镜,今有换脸识别机,微软 CVPR 2020力作,让伪造人脸无处遁形

02. [港大] PolarMask:将实例分割统一到FCN,有望在工业界大规模应用

03. [牛津大学] RandLA-Net:大场景三维点云语义分割新框架(已开源)

04. [北大&华为] CIFAR-10上做NAS,仅需单卡半天!华为提出基于进化算法和权值共享CARS模型

05. [南京大学] 化繁为简,弱监督目标定位领域的新SOTA - 伪监督目标定位方法

06. [UC 伯克利] 挑战 11 种 GAN的图像真伪,DeepFake鉴别一点都不难

07. [哈斯特帕大学] 学习一个宫崎骏画风的图像风格转换GAN

08. [人大&阿德莱德大学] 看图说话之随心所欲:细粒度可控的图像描述自动生成

09.[北京大学]PQ-NET:序列化的三维形状生成网络

10. 视觉-语言导航新篇章:真实场景下的远程物体定位导航任务

11. 室内设计师失业?针对语言描述的自动三维场景设计算法

12. 深度视觉推理2.0:组合式目标指代理解

13. 浙大李俊成:用无监督强化学习方法来获得迁移能力

![]()

![]() 点击“

阅读原文” 查看 CVPR 系列论文解读

点击“

阅读原文” 查看 CVPR 系列论文解读

点击“

阅读原文” 查看 CVPR 系列论文解读

点击“

阅读原文” 查看 CVPR 系列论文解读