腾讯优图25篇CVPR解读:视觉对抗学习、视频深度理解等

新智元推荐

新智元推荐

来源:腾讯优图实验室

【新智元导读】CVPR 2019录取1299篇论文,其中腾讯优图实验室喜提25篇,本文带来这25篇视觉领域前沿论文的摘要解读。

CVPR 2019 即将于六月在美国长滩召开,本届大会总共录取来自全球论文 1299 篇。CVPR 作为计算机视觉领域级别最高的研究会议,其录取论文代表了计算机视觉领域在 2019 年最新和最高的科技水平以及未来发展潮流。

CVPR 官网显示,今年有超过 5165 篇的大会论文投稿,录取 1299 篇论文,比去年增长了 32%(2017 年录取 979 篇)。

其中,腾讯有超过 58 篇论文被本届 CVPR 大会接收,其中腾讯优图实验室 25 篇、腾讯 AI Lab 33 篇。

被收录的论文涵盖深度学习优化原理、视觉对抗学习、人脸建模与识别、视频深度理解、行人重识别、人脸检测等热门及前沿领域。本文带来腾讯优图实验室以及其他优图联合高校实验室的 25 篇 CVPR论文的解读。

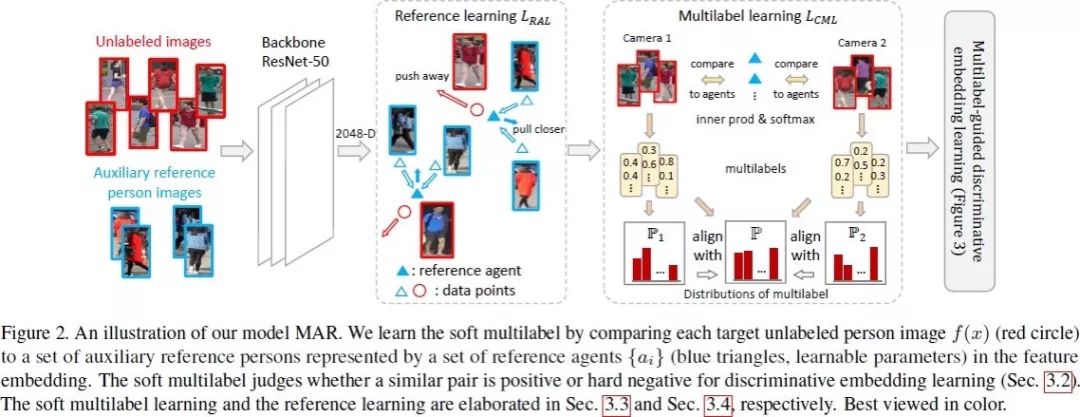

1. Unsupervised Person Re-identification by Soft Multilabel Learning

软多标签学习的无监督行人重识别

相对于有监督行人重识别(RE-ID)方法,无监督 RE-ID 因其更佳的可扩展性受到越来越多的研究关注,然而在非交叠的多相机视图下,标签对(pairwise label)的缺失导致学习鉴别性的信息仍然是非常具有挑战性的工作。

为了克服这个问题,我们提出了一个用于无监督 RE-ID 的软多标签学习深度模型。该想法通过将未标注的人与辅助域里的一组已知参考者进行比较,为未标注者标记软标签(类似实值标签的似然向量)。

基于视觉特征以及未标注目标对的软性标签的相似度一致性,我们提出了软多标签引导的 hard negative mining 方法去学习一种区分性嵌入表示(discriminative embedding)。由于大多数目标对来自交叉视角,我们提出了交叉视角下的软性多标签一致性学习方法,以保证不同视角下标签的一致性。为实现高效的软标签学习,引入了参考代理学习(reference agent learning)。

我们的方法在 Market-1501 和 DukeMTMC-reID 上进行了评估,显著优于当前最好的无监督 RE-ID 方法。

2. Visual Tracking via Adaptive Spatially-Regularized Correlation Filters

基于自适应空间加权相关滤波的视觉跟踪研究

本文提出自适应空间约束相关滤波算法来同时优化滤波器权重及空间约束矩阵。

首先,本文所提出的自适应空间约束机制可以高效地学习得到一个空间权重以适应目标外观变化,因此可以得到更加鲁棒的目标跟踪结果。

其次,本文提出的算法可以通过交替迭代算法来高效进行求解,基于此,每个子问题都可以得到闭合的解形式。

再次,本文所提出的跟踪器使用两种相关滤波模型来分别估计目标的位置及尺度,可以在得到较高定位精度的同时有效减少计算量。大量的在综合数据集上的实验结果证明了本文所提出的算法可以与现有的先进算法取得相当的跟踪结果,并且达到了实时的跟踪速度。

3. Adversarial Attacks Beyond the Image Space

超越图像空间的对抗攻击

生成对抗实例是理解深度神经网络工作机理的重要途径。大多数现有的方法都会在图像空间中产生扰动,即独立修改图像中的每个像素。

在本文中,我们更为关注与三维物理性质(如旋转和平移、照明条件等)有意义的变化相对应的对抗性示例子集。可以说,这些对抗方法提出了一个更值得关注的问题,因为他们证明简单地干扰现实世界中的三维物体和场景也有可能导致神经网络错分实例。

在分类和视觉问答问题的任务中,我们在接收 2D 输入的神经网络前边增加一个渲染模块来拓展现有的神经网络。我们的方法的流程是:先将 3D 场景(物理空间)渲染成 2D 图片(图片空间),然后经过神经网络把他们映射到一个预测值(输出空间)。这种对抗性干扰方法可以超越图像空间。在三维物理世界中有明确的意义。虽然图像空间的对抗攻击可以根据像素反照率的变化来解释,但是我们证实它们不能在物理空间给出很好的解释,这样通常会具有非局部效应。但是在物理空间的攻击是有可能超过图像空间的攻击的,虽然这个比图像空间的攻击更难,体现在物理世界的攻击有更低的成功率和需要更大的干扰。

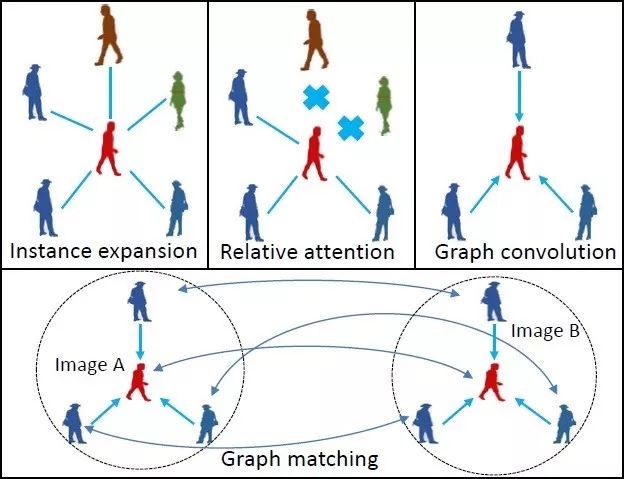

4. Learning Context Graph for Person Search

基于上下文图网络的行人检索模型

本文由腾讯优图实验室与上海交通大学主导完成。

近年来,深度神经网络在行人检索任务中取得了较大的成功。但是这些方法往往只基于单人的外观信息,其在处理跨摄像头下行人外观出现姿态变化、光照变化、遮挡等情况时仍然比较困难。

本文提出了一种新的基于上下文信息的行人检索模型。所提出的模型将场景中同时出现的其他行人作为上下文信息,并使用卷积图模型建模这些上下文信息对目标行人的影响。我们在两个著名的行人检索数据集 CUHK-SYSU 和 PRW 的两个评测维度上刷新了当时的世界纪录,取得了 top1 的行人检索结果。

5. Underexposed Photo Enhancement using Deep Illumination Estimation

基于深度学习优化光照的暗光下的图像增强

本文介绍了一种新的端到端网络,用于增强曝光不足的照片。

我们不是像以前的工作那样直接学习图像到图像的映射,而是在我们的网络中引入中间照明,将输入与预期的增强结果相关联,这增强了网络从专家修饰的输入/输出图像学习复杂的摄影调整的能力。

基于该模型,我们制定了一个损失函数,该函数采用约束和先验在中间的照明上,我们准备了一个3000 个曝光不足的图像对的新数据集,并训练网络有效地学习各种照明条件的丰富多样的调整。

通过这些方式,我们的网络能够在增强结果中恢复清晰的细节,鲜明的对比度和自然色彩。我们对基准 MIT-Adobe FiveK 数据集和我们的新数据集进行了大量实验,并表明我们的网络可以有效地处理以前的困难图像。

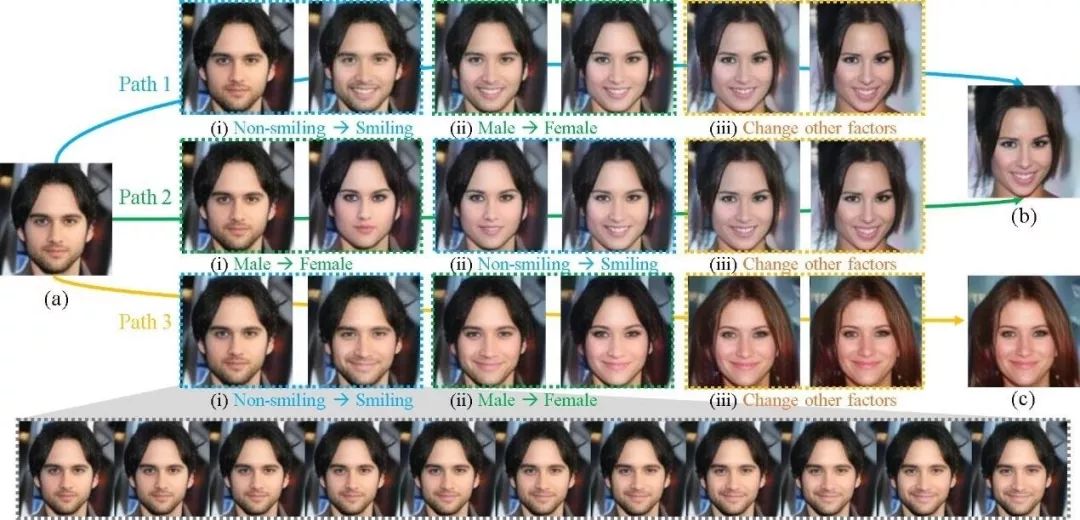

6. Homomorphic Latent Space Interpolation for Unpaired Image-to-image Translation

基于同态隐空间插值的不成对图片到图片转换

生成对抗网络在不成对的图像到图像转换中取得了巨大成功。循环一致性允许对没有配对数据的两个不同域之间的关系建模。

在本文中,我们提出了一个替代框架,作为潜在空间插值的扩展,在图像转换中考虑两个域之间的中间部分。

该框架基于以下事实:在平坦且光滑的潜在空间中,存在连接两个采样点的多条路径。正确选择插值的路径允许更改某些图像属性,而这对于在两个域之间生成中间图像是非常有用的。我们还表明该框架可以应用于多域和多模态转换。广泛的实验表明该框架对各种任务具有普遍性和适用性。

7. X2CT-GAN: Reconstructing CT from Biplanar X-Rays with Generative Adversarial Networks

基于生成对抗网络的双平面 X 光至 CT 生成系统

当下 CT 成像可以提供三维全景视角帮助医生了解病人体内的组织器官的情况,来协助疾病的诊断。但是 CT 成像与 X 光成像相比,给病人带来的辐射剂量较大,并且费用成本较高。传统 CT 影像的三维重建过程中围绕物体中心旋转采集并使用了大量的 X 光投影,这在传统的 X 光机中也是不能实现的。

在这篇文章中,我们创新性的提出了一种基于对抗生成网络的方法,只使用两张正交的二维 X 光图片来重建逼真的三维 CT 影像。核心的创新点包括增维生成网络,多视角特征融合算法等。

我们通过实验与量化分析,展示了该方法在二维 X 光到三维 CT 重建上大大优于其他对比方法。通过可视化 CT 重建结果,我们也可以直观的看到该方法提供的细节更加逼真。在实际应用中, 我们的方法在不改变现有 X 光成像流程的前提下,可以给医生提供额外的类 CT 的三维影像,来协助他们更好的诊断。

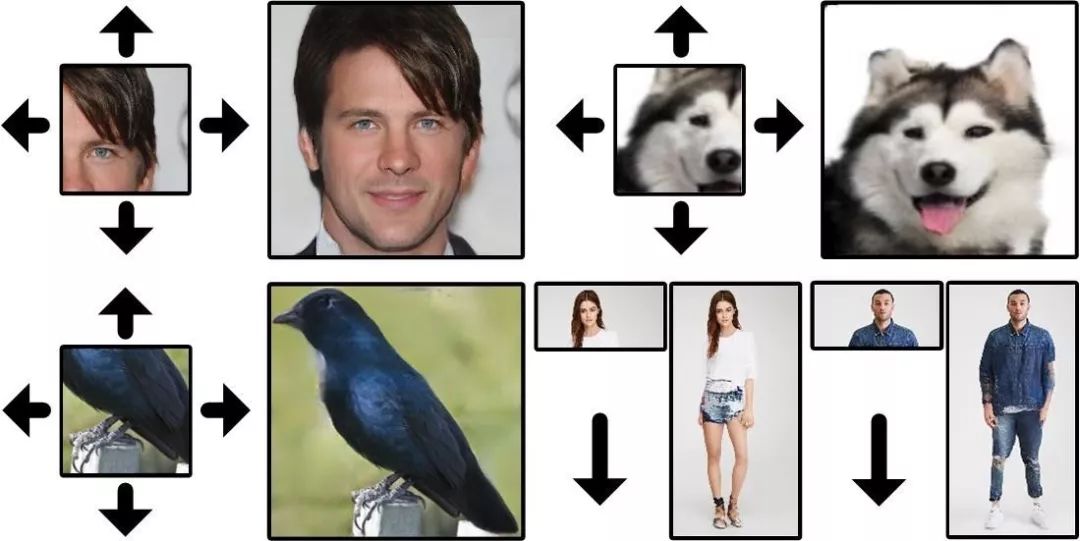

8. Semantic Regeneration Network

语义再生网络

本文研究了使用深度生成模型推断视觉上下文的基本问题,即利用合理的结构和细节扩展图像边界。这个看似简单的任务实际上面临着许多关键的技术挑战,并且具有其独特的性质。任务里两个主要问题是扩展尺寸和单面约束。我们提出了一个具有多个特殊贡献的语义再生网络,并使用多个空间相关的损失来解决这些问题。

本文最终的实验结果包含了高度一致的结构和高品质的纹理。我们对各种可能的替代方案和相关方法进行了广泛的实验。最后, 我们也探索了我们的方法对各种有趣应用的潜力,这些应用可以使各个领域的研究受益。

9. Towards Accurate One-Stage Object Detection with AP-Loss

利用 AP 损失函数实现精确的一阶目标检测

一阶的目标检测器通常是通过同时优化分类损失函数和定位损失函数来训练。而由于存在大量的锚框,分类损失函数的效果会严重受限于前景-背景类的不平衡。

本文通过提出一种新的训练框架来解决这个问题。我们使用排序任务替换一阶目标检测器中的分类任务,并使用排序问题的中的评价指标 AP 来作为损失函数。由于其非连续和非凸,AP 损失函数不能直接通过梯度下降优化。

为此,我们提出了一种新颖的优化算法,它将感知机学习中的误差驱动更新方案和深度网络中的反向传播算法结合在一起。我们从理论上和经验上验证了提出的算法的良好收敛性。

实验结果表明,在不改变网络架构的情况下,在各种数据集和现有最出色的一阶目标检测器上,AP 损失函数的性能相比不同类别的分类损失函数有着显著提高。

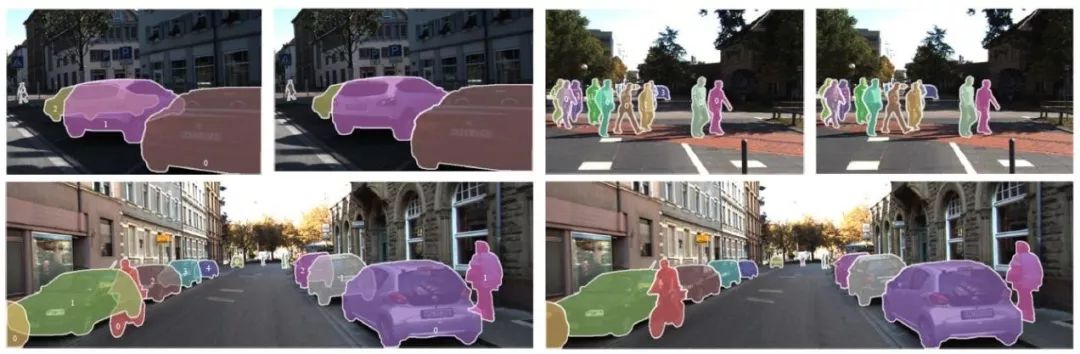

10. Amodal Instance Segmentation through KINS Dataset

通过 KINS 数据集进行透视实例分割

透视实例分割是实例分割的一个新方向,旨在模仿人类的能力对每个对象实例进行分割包括其不可见被遮挡的部分。此任务需要推理对象的复杂结构。尽管重要且具有未来感,但由于难以正确且一致地标记不可见部分,这项任务缺乏大规模和详细注释的数据,这为探索视觉识别的前沿创造了巨大的障碍。

在本文中,我们使用 8 个类别的更多实例像素级注释来扩充 KITTI,我们称之为 KITTI INStance 数据集(KINS)。我们提出了通过具有多分支编码(MBC)的新多任务框架来推理不可见部分的网络结构,该框架将各种识别级别的信息组合在一起。大量实验表明,我们的 MBC 有效地同时改善透视和非透视分割。KINS 数据集和我们提出的方法将公开发布。

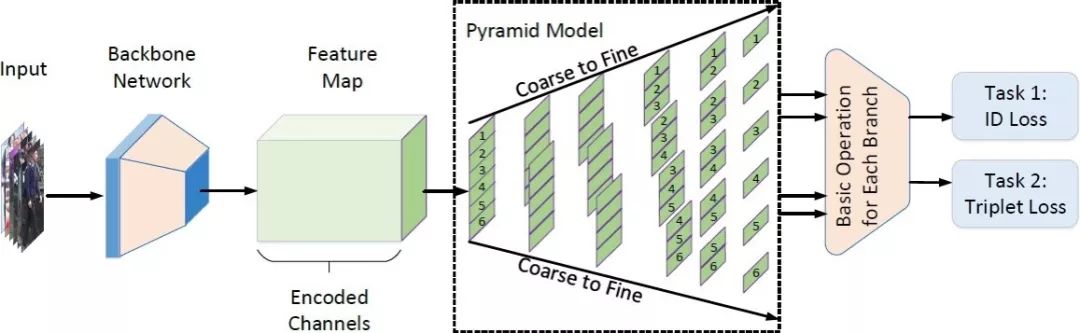

11. Pyramidal Person Re-IDentification via Multi-Loss Dynamic Training

基于多损失动态训练策略的金字塔式行人重识别

大多数已提出的行人重识别方法高度依赖于精准的人体检测以保证目标间的相互对齐。然而在复杂的实际场景中,现有模型尚难以保证检测的精准性,不可避免地影响了行人重识别的性能。

在本文中,我们提出了一种新的由粗及细的金字塔模型,以放宽对检测框的精度限制,金字塔模型整合了局部、全局以及中间的过渡信息,能够在不同尺度下进行有效匹配, 即便是在目标对齐不佳情况下。

此外,为了学习具有判别性的身份表征,我们提出了一种动态训练框架,以无缝地协调两种损失函数并提取适当的信息。我们在三个数据库上达到了最好的效果。值得一提的,在最具挑战性的 CUHK03 数据集上超过当前最佳方法 9.5 个百分点。

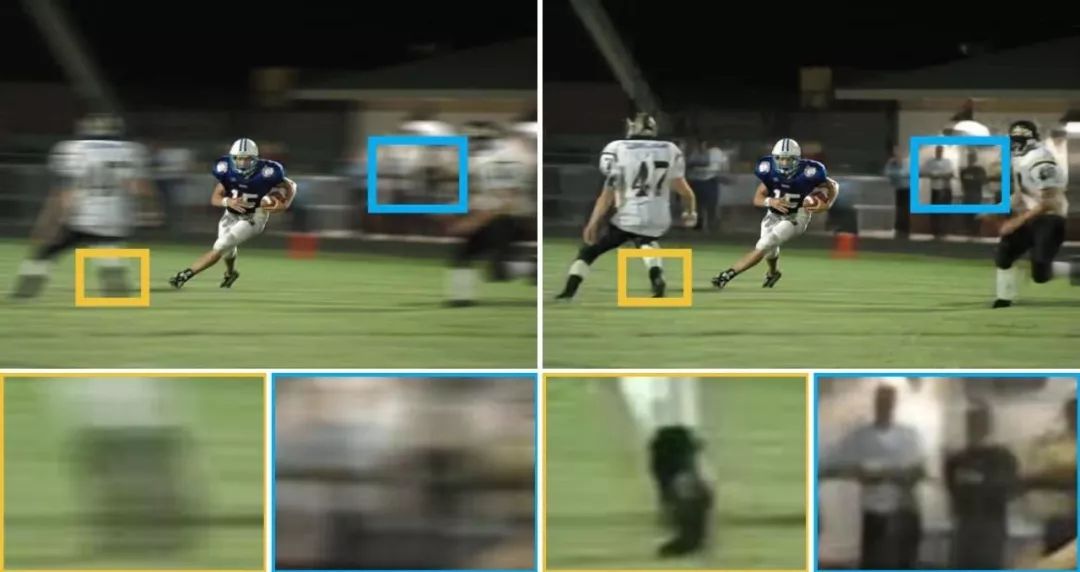

12. Dynamic Scene Deblurring with Parameter Selective Sharing and Nested Skip Connections

基于选择性参数共享和嵌套跳跃连接的图像去模糊算法

动态场景去模糊是一个具有挑战的底层视觉问题因为每个像素的模糊是多因素共同导致,包括相机运动和物体运动。最近基于深度卷积网络的方法在这个问题上取得了很大的提高。

相对于参数独立策略和参数共享策略,我们分析了网络参数的策略并提出了一种选择性参数共享的方案。在每个尺度的子网络内,我们为非线性变换的模块提出了一种嵌套跳跃连接的结构。此外,我们依照模糊数据生成的方法建立了一个更大的数据集并训练出效果更佳的去模糊网络。

实验表明我们的选择性参数共享,嵌套跳跃链接,和新数据集都可以提高效果,并达到最佳的去模糊效果。

13. Learning Shape-Aware Embedding for Scene Text Detection

一种基于实例分割以及嵌入特征的文本检测方法

由于复杂多变的场景,自然场景下的任意形状文本的检测十分具有挑战性,本文主要针对检测任意形状的文本提出了解决方案。

具体地,我们将文本检测视作一个实例分割问题并且提出了一个基于分割的框架,该框架使用相互独立的连通域来表示不同的文本实例。为了区分不同文本实例,我们的方法将图片像素映射至嵌入特征空间当中,属于同一文本实例的像素在嵌入特征空间中会更加接近彼此,反之属于不同文本实例的像素将会远离彼此。

除此之外,我们提出的Shape-Aware 损失可以使得模型能够自适应地去根据文本实例复杂多样的长宽比以及实例间的狭小缝隙来调整训练,同时加以我们提出的全新后处理算法,我们的方法能够产生精准的预测。我们的实验结果在三个具有挑战性的数据集上(ICDAR15、MSRA-TD500 以及 CTW1500)验 证了我们工作的有效性。

14. PointWeb: Enhancing Local Neighborhood Features for Point Cloud Processing

PointWeb: 通过局部近邻特征增强点云处理

本文提出一种新的在局部近邻点云中提取上下文特征的方法: PointWeb。与之前的方法不同,为了明确每个基于局部区域特性的点特征,我们密集地连接在局部近邻里的所有点, 这样可以更好地表征该区域。

我们提出了“自适应特征调整”模块(AFA),计算两点之间的相互作用。对于每个局部区域,通过特征差分图计算点对之间对应每个元素影响程度的“影响图”。根据自适应学习到的影响因子,每个特征都会被相同区域内的其他特征“推开”或“拉近”。调整过的特征图更好地编码区域信息,类似点云分割和分类的点云识别任务,将从中受益。

实验结果表明我们的模型在语义分割和形状分类数据集上,超出当前最优的算法。代码和训练好的模型将同论文一起发布。

15. Associatively Segmenting Instances and Semantics in Point Clouds

联合分割点云中的实例和语义

一个 3D 点云精细和直观的描述了一个真实场景。但是迄今为止怎样在这样一个信息丰富的三维场景分割多样化的元素,仍然很少得到讨论。

在本文中,我们首先引入一个简单且灵活的框架来同时分割点云中的实例和语义。进一步地,我们提出两种方法让两个任务从彼此中受益,得到双赢的性能提升。具体来说,我们通过学习富有语义感知的实例嵌入向量来使实例分割受益于语义分割。同时,将属于同一个实例的点的语义特征融合在一起,从而更准确地对每个点进行语义预测。我们的方法大幅超过目前最先进的 3D 实例分割方法,在 3D 语义分割上也有显著提升。

代码和模型已经开源:https://github.com/WXinlong/ASIS.

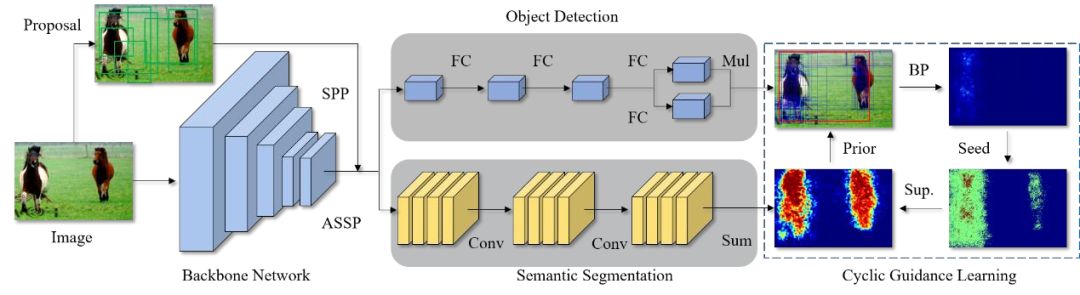

16. Cyclic Guidance for Weakly Supervised Joint Detection and Segmentation

基于循环指导的弱监督联合检测和分割

本文由腾讯优图实验室与厦门大学纪荣嵘教授团队主导完成。

我们首次提出使用多任务学习机制联合弱监督检测和分割任务,并基于两个任务各自的互补失败模式来改进对方。这种交叉任务的增强使得两个任务更能逃离局部最小值。

我们的方法 WS-JDS 有两个分支并共享同一个骨干模型,分别对应两个任务。在学习过程中,我们提出循环指导范式和特地的损失函数来改进双方。实验结果表明该算法取得了的性能提升。

17. ROI Pooled Correlation Filters for Visual Tracking

基于感兴趣区域池化的相关滤波跟踪研究

基于 ROI 的池化算法在样本被提取的感兴趣区域进行池化操作,并已经在目标检测等领域取得了较大的成功。该池化算法可以较好的压缩模型的尺寸,并且保留原有模型的定位精度,因此非常适合视觉跟踪领域。尽管基于 ROI 的池化操作已经被不同领域证明了其有效性,其在相关滤波领域仍然没有得到很好的应用。

基于此,本文提出了新颖的具有ROI 池化功能的相关滤波算法进行鲁棒的目标跟踪。通过严谨的数学推导,我们证明了相关滤波中的 ROI 池化可以通过在学习到的滤波器上引入附加的约束来等效实现,这样就使得我们可以在不必明确提取出训练样本的情况下完成池化操作。我们提出了一个高效的相关滤波算法,并给出了基于傅立叶的目标函数求解算法。

我们在 OTB-2013、OTB-2015 及 VOT-2017 上对所提出的算法进行测试,大量的实验结果证明了本文所提出算法的有效性。

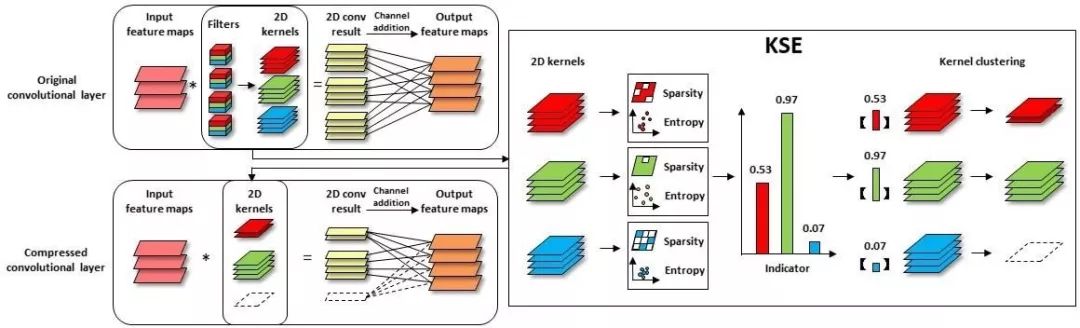

18. Exploiting Kernel Sparsity and Entropy for Interpretable CNN Compression

基于卷积核稀疏性与密度熵的神经网络压缩方法

本文由腾讯优图实验室与厦门大学纪荣嵘教授团队主导完成。

我们从神经网络的解释性角度出发,分析卷积神经网络特征图的冗余性问题,发现特征图的重要性取决于它的稀疏性和信息丰富度。但直接计算特征图的稀疏性与信息丰富度,需要巨大计算开销。

为克服此问题,我们建立了特征图和其对应二维卷积核之间的联系,通过卷积核的稀疏性和密度熵来表征对应特征图的重要程度,并得到判定特征图重要性的得分函数。在此基础上,我们采用较为细粒度压缩的卷积核聚类代替传统的剪枝方式压缩模型。大量的实验结果表明,我们所提出的基于卷积核稀疏性与密度熵的压缩方法可以达到更高的压缩率和精度。

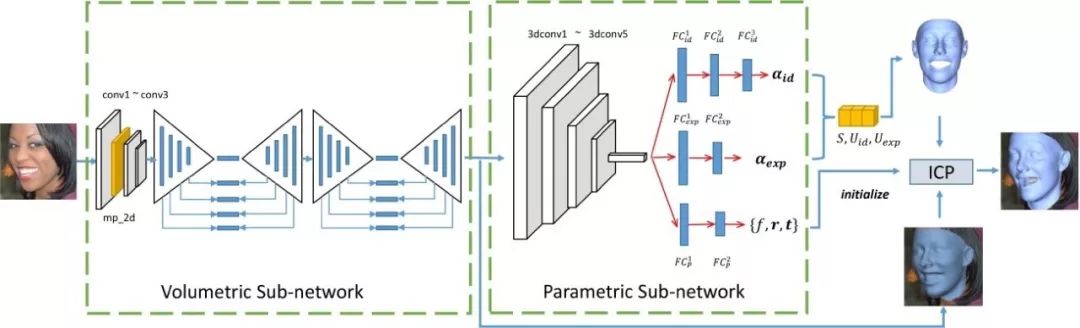

19. MMFace: A Multi-Metric Regression Network for Unconstrained Face Reconstruction

MMFace: 用于无约束三维人脸重建的多度量回归网络

本文提出了一个用于进行无约束三维人脸重建的多度量回归网络。

其核心思想是利用一个体素回归子网络从输入图像生成一个人脸几何结构的中间表达,再从该中间表达回归出对应的三维人脸形变模型参数。我们从包括人脸身份、表情、头部姿态,以及体素等多个度量对回归结果进行了约束,使得我们的算法在夸张的表情,大头部姿态、局部遮挡、复杂光照环境都有很好的鲁棒性。

相比于目前的主流算法,我们的方法在公开的三维人脸数据集LS3D-W 和 Florence 上都得到了显著的提升。此外,我们的方法还直接应用到对视频序列的处理。

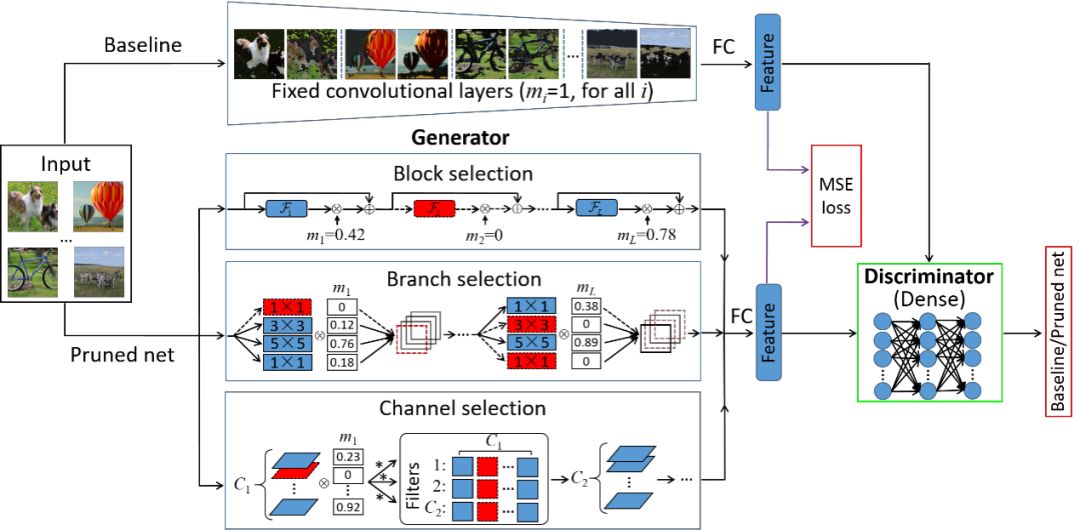

20. Towards Optimal Structured CNN Pruning via Generative Adversarial Learning

基于生成对抗学习的最优结构化卷积神经网络剪枝方法

本文由腾讯优图实验室与厦门大学纪荣嵘教授团队主导完成。

我们提出了一种基于生成对抗学习的最优结构化网络剪枝方法,利用无监督端对端训练剪枝网络中冗余的异质结构,有效解决了传统结构化剪枝方法存在剪枝效率低、缺乏松弛性、强标签依赖等问题。该方法对每个模型结构引入了软掩码,并对其加入稀疏限制,使其表征每个结构的冗余性。

为了更好学习模型参数和掩码,我们利用无类别标签生成对抗学习框架,构建新的结构化剪枝目标函数,并利用快速的迭代阈值收缩算法解决该优化问题,稳定移除冗余结构。通过大量的实验结果表明,相比于目前最先进的结构化剪枝方法,我们所提出的剪枝方法可以获得更好的性能。

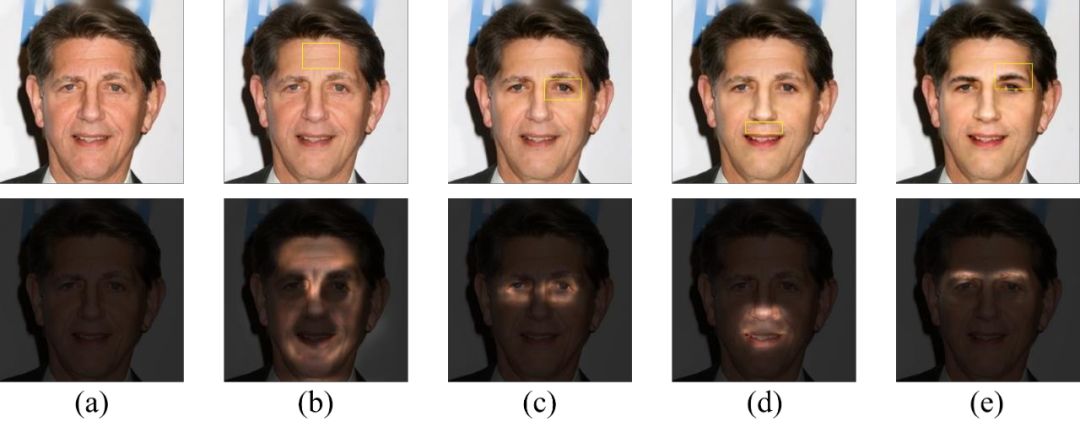

21. Semantic Component Decomposition for Face Attribute Manipulation

基于语义成分分解的人脸属性编辑

最近,基于深度神经网络的方法已被广泛研究用于面部属性编辑。然而,仍然存在两个主要问题,即视觉质量不佳以及结果难以由用户控制。这限制了现有方法的适用性,因为用户可能对不同的面部属性具有不同的编辑偏好。

在本文中,我们通过提出一个基于语义组件的模型来解决这些问题。该模型将面部属性分解为多个语义成分,每个语义成分对应于特定的面部区域。这不仅允许用户基于他们的偏好来控制不同部分的编辑强度,而且还使得有效去除不想要的编辑效果。此外,每个语义组件由两个基本元素组成,它们分别确定编辑效果和编辑区域。此属性允许我们进行更细粒度的交互式控制。实验表明,我们的模型不仅可以产生高质量的结果,还可以实现有效的用户交互。

22. Memory-Attended Recurrent Network for Video Captioning

一种针对视频描述的基于记忆机制的循环神经网络

传统的视频描述生成的模型遵循编码-解码 (encoder-decoder) 的框架,对输入的视频先进行视频编码,然后解码生成相应的视频描述。这类方法的局限在于仅能关注到当前正在处理的一段视频。而在实际案例中,一个词或者短语可以同时出现在不同但语义相似的视频中,所以基于编码-解码的方法不能同时抓取一个词在多个相关视频中的上下文语义信息。

为了解决这个局限性,我们提出了一种基于记忆机制的循环神经网络模型,设计了一种独特的记忆结构来抓取每个词库中的词与其所有相关视频中的对应语义信息。因此,我们的模型可以对每个词的语义有更全面和深入的理解,从而提高生成的视频描述的质量。另外,我们设计的记忆结构能够评估相邻词之间的连贯性。充足的实验证明我们的模型比现有的其他模型生成的视频描述质量更高。

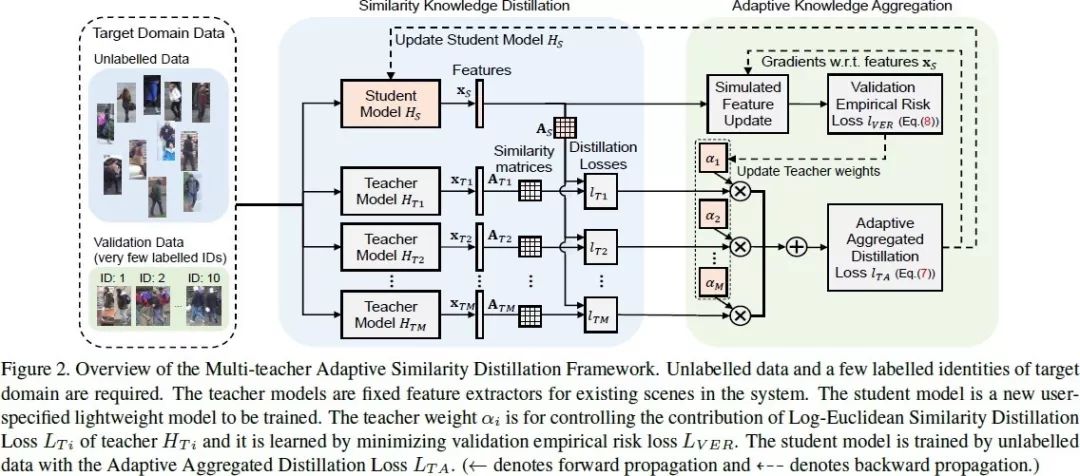

23. Distilled Person Re-identification: Towards a More Scalable System

蒸馏的行人重识别:迈向更具可扩展性的系统

行人重识别(Re-ID),作为面向非交叠相机视角下的行人比对技术,在具备丰富标签数据下有监督学习领域的研究已取得了长足的进步。然而可扩展性问题仍然是系统走向大规模应用的瓶颈。

我们从三个方面考虑 Re-ID 的可扩展性问题:(1)减少标签规模来降低标注成本,(2)复用已有知识来降低迁移成本(3)使用轻量模型来降低预测成本。

为解决这些问题,我们提出了一种多教师自适应的相似度蒸馏框架,仅需要少量有标注的目标域身份, 即可将多种教师模型中的知识迁移到订制的轻量级学生模型,而无需利用源域数据。为有效选择教师模型,完成知识迁移,我们提出了 Log-Euclidean 的相似度蒸馏损失函数,并进一步整合了 Adaptive Knowledge Aggregator。大量的实验评估结果论证了方法的可扩展性,在性能上可与当前最好的无监督和半监督 Re-ID 方法相媲美。

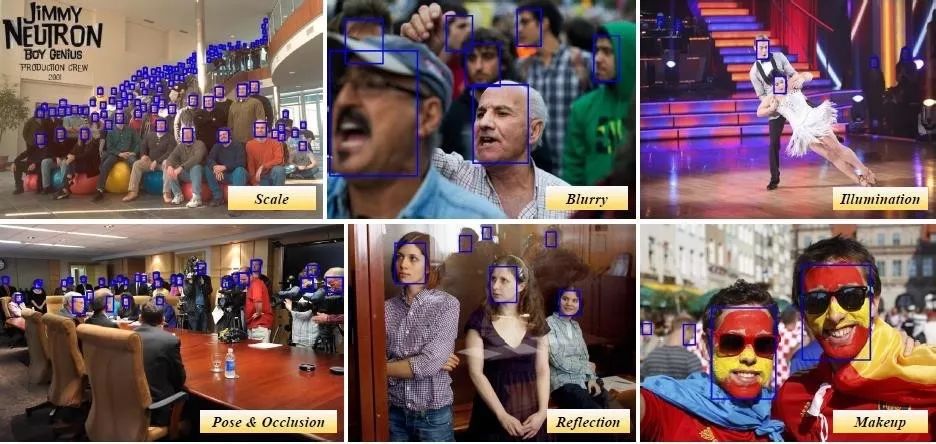

24. DSFD: Dual Shot Face Detector

双分支人脸检测器

本文由南京理工大学计算机科学与工程学院 PCALab 与腾讯优图实验室合作完成。

近年来,卷积神经网络在人脸检测中取得了很大的成功。然而这些方法在处理人脸中多变的尺度,姿态,遮挡,表情,光照等问题时依然比较困难。

本文提出了一种新的方法,分别处理了人脸检测方向的三个关键点,包括更好的特征学习,渐进式的损失函数设计以及基于锚点分配的数据扩充。

首先,我们提出了一种特征增强单元,以增强特征能力的方式将单分支扩展到双分支结构。其次,我们采用渐进式的锚点损失函数,通过给双分支不同尺度的锚点集更有效地促进特征学习。最后,我们使用了一种改进的锚点匹配方法,为回归器提供了更好的初始化数据。

由于上述技术都与双分支的设计相关,我们将本文方法命名为双分支人脸检测器。我们在两个著名的人脸检测数据集 WIDER FACE 和 FDDB 的 5 个评测维度上均刷新了当时的世界纪录,取得了 Top1 的人脸检测结果。

25. 3D Motion Decomposition for RGBD Future Dynamic Scene Synthesis

基于 3D 运动分解合成 RGBD 未来动态场景

视频中未来时刻的帧,是由相机自身运动和场景中物体运动后的 3D 场景投影到 2D 形成的。因此,从根本上说,精确预测视频未来的变化,需要理解场景的 3D 运动和几何特性。

在这篇文章中,我们提出了通过 3D 运动分解来实现的 RGBD 场景预测模型。我们首先预测相机运动和前景物体运动,它们共同用来生成 3D 未来场景,然后投影到 2D 相机平面来合成未来的运动、RGB 图像和深度图。我们也可以把语义分割信息融入系统,以预测未来时刻的语义图。

我们在 KITTI 和 Driving 上的结果说明,我们的方法超过了当前最优的预测 RGBD 未来场景的方法

更多阅读

【加入社群】

新智元AI技术+产业社群招募中,欢迎对AI技术+产业落地感兴趣的同学,加小助手微信号:aiera2015_2 入群;通过审核后我们将邀请进群,加入社群后务必修改群备注(姓名 - 公司 - 职位;专业群审核较严,敬请谅解)