【泡泡一分钟】基于视频修复的时空转换网络

每天一分钟,带你读遍机器人顶级会议文章

标题:Spatio-Temporal Transformer Network for Video Restoration

作者:Yinlong Liu, Chen Wang, Zhijian Song, Manning Wang

来源:Proceedings of the European Conference on Computer Vision (ECCV 2018)

编译:王凯东

审核:陈世浪,颜青松

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权。

摘要

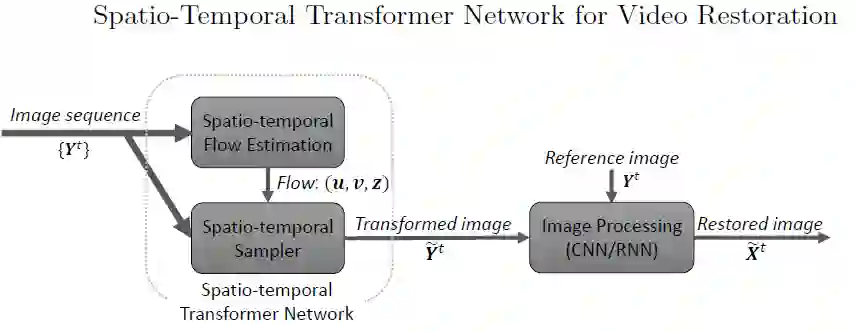

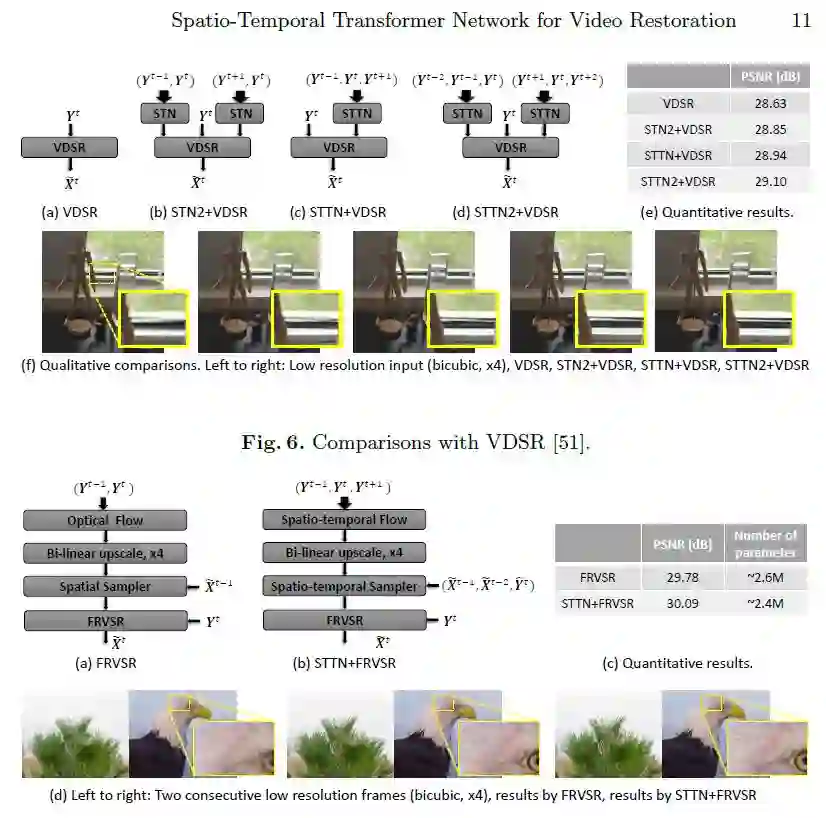

最新的视频修复方法融合了光流估计网络来利用时间信息,然而这些网络仅仅考虑了一对连续框架也因此不能捕获大范围的时序依赖并在几个时间步骤内建立一致性。为了解决这些问题,我们提出了一个新型时空转换网络(STTN),它能够快速处理多个框架也因此成功减少了在光流估计中共有的不良闭合问题。

本文作者提出的时空转换网络(STTN)包含了一个可以在时间和空间中估计光流的模块与一个可以应用估计流选择性扭曲目标框架的重新采样层。在我们的实验中,我们说明了该网络的高效性并给出了在视频超分辨与视频去模糊技术中的最新修复结果。

Abstract

State-of-the-art video restoration methods integrate optical flow estimation networks to utilize temporal information. However, these networks typically consider only a pair of consecutive frames and hence are not capable of capturing long-range temporal dependencies and fall short of establishing correspondences across several timesteps. To alleviate these problems, we propose a novel Spatio-temporal Transformer Network (STTN) which handles multiple frames at once and thereby manages to mitigate the common nuisance of occlusions in optical flow estimation. Our proposed STTN comprises a module that estimates optical flow in both space and time and a resampling layer that selectively warps target frames using the estimated flow. In our experiments, we demonstrate the efficiency of the proposed network and show state-of-the-art restoration results in video super-resolution and video deblurring.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com