2011年冬天,麻省理工学院计算神经科学博士后研究员丹尼尔-亚明斯(Daniel Yamins)常常会为了研究他的计算机视觉项目熬到深夜。那时候的他正在苦心设计一个系统,用于识别图片中变化的物体。其实人类可以轻松做到这些的,但对于机器来说,这是个艰难的任务。而丹尼尔预想中的解决方案模仿自生物大脑,而这就是深度神经网络。

丹尼尔后来在采访中说:「我非常清楚地记得,当我们找到一个真正可以用于解决难题的神经网络的时候是凌晨两点,因为不忍叫醒同事,我一个人独自在剑桥的寒风中走来走去。」单单在人工智能领域,这绝对是里程碑似的成就,但这并不是亚明斯和他的同事们的主要目标。对他们和众多神经科学家来说,这恰恰是研究大脑功能模型的关键时刻。

丹尼尔和他的团队目前在斯坦福大学有独属的实验室,致力于用深度神经网络来解构生物大脑,并试图理解生物大脑内的任务分配。目前大多数人都知道大脑不同的区域负责我们生活中不同的任务,但其实大脑的复杂性远远不止如此。比如,大脑有一个区域可以识别一般的物体,但也有一个区域是专门用来识别人类的面孔。这背后的原因非常值得探索。而目前的深度神经网络研究正在表明,这种更加细致的任务分区可能也是生物大脑用来处理信息的最高效的方式。

![]() 图示:现任斯坦福大学的计算神经科学家丹尼尔-亚明斯(Daniel Yamins)

同样,研究人员已经证明,最擅长对语音、音乐和模拟气味进行分类的深度网络,其架构似乎与大脑的听觉和嗅觉系统几乎相同。这样的相似之处也出现在深度网络中,它们可以观察一个二维场景,并推断其中三维物体的基本属性,这也有助于解释生物感知为何如此的既快速又异常地丰富。所有这些结果都暗示着,生物神经系统的结构是它能高效处理信息的原因。

其实很多神经科学家长期以来一直对大脑和深层神经网络之间的类比持怀疑态度,因为它们的工作原理可能是难以捉摸的,因此这些成功就更加出乎意料了。「老实说,在我的实验室里,之前没有人用深层网络做任何事情,」麻省理工学院神经科学家南希-坎维舍说,「而现在,他们中的大多数人反而常常去训练神经网络模型。」

图示:现任斯坦福大学的计算神经科学家丹尼尔-亚明斯(Daniel Yamins)

同样,研究人员已经证明,最擅长对语音、音乐和模拟气味进行分类的深度网络,其架构似乎与大脑的听觉和嗅觉系统几乎相同。这样的相似之处也出现在深度网络中,它们可以观察一个二维场景,并推断其中三维物体的基本属性,这也有助于解释生物感知为何如此的既快速又异常地丰富。所有这些结果都暗示着,生物神经系统的结构是它能高效处理信息的原因。

其实很多神经科学家长期以来一直对大脑和深层神经网络之间的类比持怀疑态度,因为它们的工作原理可能是难以捉摸的,因此这些成功就更加出乎意料了。「老实说,在我的实验室里,之前没有人用深层网络做任何事情,」麻省理工学院神经科学家南希-坎维舍说,「而现在,他们中的大多数人反而常常去训练神经网络模型。」

深度网络和视觉

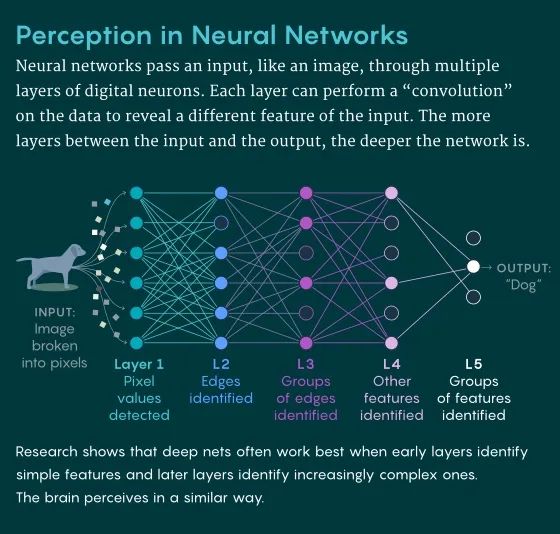

人工智能里的神经网络是由相互连接的感知器构建的,感知器是一种生物神经元的简化数学模型。在这种神经网络里至少有两层感知器,一层是输入层,一层是输出层。在输入和输出之间再夹入一个或多个 「隐藏」层,我们就得到了一个 「深度」神经网络;而隐藏层的数量越多,这个神经网络就越深。

通过训练深度网络的模型,我们可以得到数据中的模型,例如代表猫或狗的图像的模型。这种训练包括使用算法反复调整感知器之间的连接强度,使网络学会将预先给定的输入(图像的像素)与正确的标签(猫或狗)联系起来。一旦经过训练,深层网络就能够对一个它以前没有见过的输入进行分类。如下图所示:

在这种总体的结构和功能中,深度网络会很渴望模仿大脑,其中神经元之间连接的调整强度则反映了学习上的关联性。而神经科学家们经常会指出这种类比的重要局限性,例如,单个神经元可能比 「哑巴」感知器更广泛地处理信息,而深度网络会经常依赖于感知器之间的一种被称为反向传播的通信,而这种通信似乎在生物神经系统中不会发生。当然,虽然有些许不足,但对于计算神经科学家来说,深度网络仍然是对大脑部分进行建模的最佳选择。

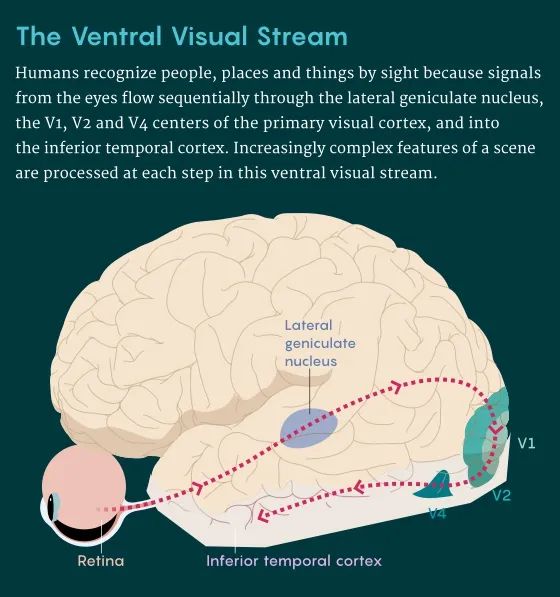

开发视觉系统计算模型的研究人员也受到了我们对灵长类动物视觉系统了解的影响,特别是负责识别人、地方和事物的路径,称为腹侧视觉流。(另一条独立的路径,即背侧视觉流,处理用于看清运动和事物位置的信息)。在人类中,这条腹侧路径从眼睛开始,然后进入丘脑中的侧膝状核(一种感觉信息的中继站)。外侧膝状核连接到初级视觉皮层的V1区域,其下游是V2和V4区域,最后通向下颞皮层(非人灵长类动物的大脑有同源结构)。

在神经科学领域,视觉信息加工是分层次,分阶段的进行。前期阶段处理的是视野中的低级特征(如边缘、轮廓、颜色和形状),而复杂的表象,如整个物体和面孔,则是在下颞皮层后期才出现的。

这些神经科学上的知识则指导了丹尼尔和他的团队对深度网络的设计。他们的深度网有隐藏层,其中一些隐藏层则进行了 「卷积」,即对图像的每一部分都应用相同的滤波器。每个卷积都能捕捉到图像的不同基本特征,比如边缘。更基本的特征在网络的早期阶段就被捕获了,而更复杂的特征则会在更深的阶段被捕获,就像灵长类动物的视觉系统一样。当像这样的卷积神经网络(CNN)被训练成对图像进行分类时,它从随机初始化的滤波器值开始,学习当前任务所需的正确值。

该团队的四层CNN可以识别5,760张照片逼真的3D图像中描绘的八类物体(动物、船、汽车、椅子、脸、水果、飞机和桌子)。照片中的物体在姿势、位置和比例上有很大的差异,而深网对这些变化中物体的识别能力也相当接近人类。

而丹尼尔不知道是,计算机视觉世界里酝酿的一场革命也将独立验证他和他的团队正在采取的方法。在他们完成了他们的CNN构建后不久,另一个名为AlexNet的CNN在一次年度图像识别大赛上崭露头角。AlexNet也是基于分层处理架构,在早期阶段捕捉基本的视觉特征,在更高的阶段捕捉更复杂的特征;它曾用120万张标签图像进行模型训练,呈现了1000个类别的物体。在2012年的比赛中,AlexNet击溃了所有其他测试算法。根据比赛的指标,AlexNet的错误率只有15.3%,而最接近的竞争对手的错误率为26.2%。随着AlexNet的胜利,深度网络成为AI和机器学习领域的重要方法。

然而,丹尼尔和他的团队在追求神经科学的学术成果。他们想知道,如果他们的CNN模仿了视觉系统,它是否能预测对新图像的生物神经反应。为了找出答案,他们首先建立了他们的CNN中人工神经元组的活动如何对应于两只猕猴腹侧视觉流中近300个部位的活动。然后,他们使用CNN来预测当猴子被展示不属于训练数据集的图像时,这些大脑站点将如何响应。「我们不仅得到了良好的预测......而且还有一种解剖学上的一致性,」丹尼尔说。CNN的早期、中间和后期层分别预测了早期、中间和高级脑区的行为,这说明「形式跟着功能走」!

而当该成果在2014年发表时,引起了学术界的轰动。

识别声音

在丹尼尔团队的研究结果出现后,人们开始寻找其他更好的大脑深层网络模型,特别是对于比灵长类视觉系统研究得更少的区域。例如,「我们对听觉皮层,尤其是人类的听觉皮层仍然没有很好的理解,」麻省理工学院的神经科学家乔希-麦克德莫特说。而深度学习能否帮助产生关于大脑如何处理声音的假说呢?

而这就是麦克德莫特的目标。他的团队,包括亚历山大-凯尔和亚明斯,开始设计深层网来分类两种类型的声音:语音和音乐。首先,他们假设了一个耳蜗的模型--内耳中的传声器官,其工作原理被定义得非常详细—即处理音频,并将声音分类为不同的频率通道,作为卷积神经网络的输入。CNN经过训练,既能识别语音音频片段中的单词,又能识别混有背景噪音的音乐片段的类型。该团队寻找到了一种深层网络架构,它可以在不需要大量资源的情况下准确执行这些任务。

![]() 麻省理工学院的神经科学家乔希-麦克德莫特

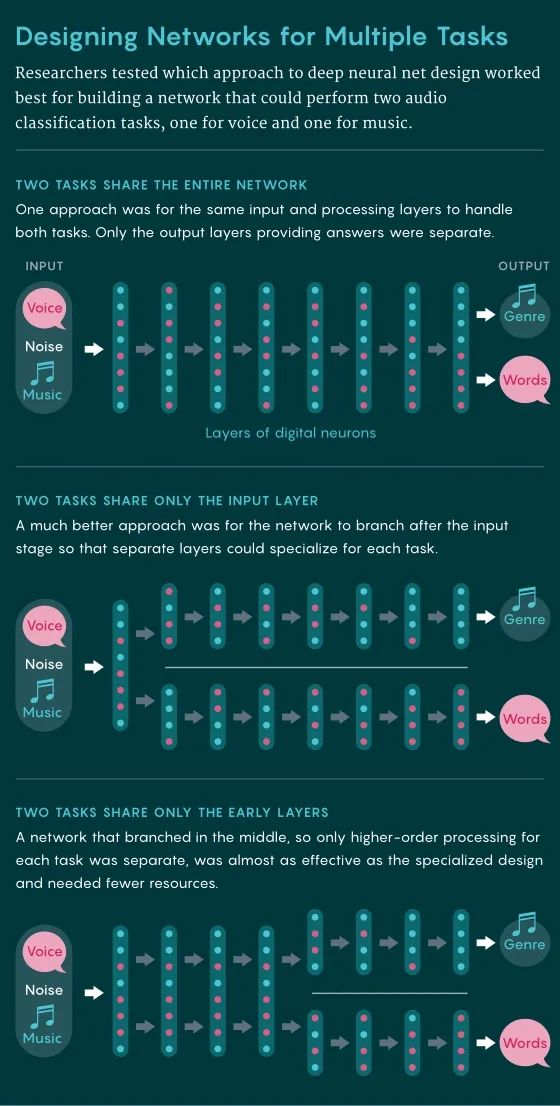

麦克德莫特的预想中有三套可能成功的架构。

深层网络的两个任务可以只共享输入层,然后分裂成两个不同的网络。

在另一个极端,任务可以在所有处理过程中共享同一个网络,而只在输出阶段分裂。

或者可以是介于两者之间的几十种变体之一,网络的某些阶段是共享的,而其他阶段则是不同的。

不足为奇的是,输入层之后有专门路径的网络胜过完全共享路径的网络。然而,一个混合网络--在输入阶段后有7个公共层,然后有两个独立的网络,每个网络有5层--几乎和完全独立的网络一样好。最终麦克德莫特团队选择了混合网络,认为它是用最少的计算资源达到最佳效果的网络。三种架构如图所示:

当他们将该混合网络与真人的反应进行对比时,这种模型表现得非常好。它也与一些研究人员早期的实验结果相吻合,这些结果表明,非初级听觉皮层也具有处理音乐和语音的不同区域。而在2018年发表的一项关键测试中,该模型预测了人类主体的大脑活动。该模型的中间层预计了初级听觉皮层的反应,而更深的层则预计了听觉皮层的更高区域。这些预测大大优于之前非基于深度学习设计的模型。

「科学的目标是能够预测系统要做什么,」麦克德莫特说。「这些人工神经网络让我们更接近神经科学的这个目标。」

麻省理工学院神经科学家南希-坎维舍尔最初对深度学习能否用于她自己的研究持怀疑态度,但麦克德莫特的模型给了她灵感。之前,南希最著名的一项研究的是关于下颞皮层的一个区域,纺锤形脸部区域(FFA),专门用于识别人脸。当受试者盯着人脸的图像时,FFA的活跃度明显高于看房屋等物体的图像。而问题是,为什么大脑会将人脸的处理与其他物体的处理隔离开来呢?

从传统意义上来说,回答这种「为什么」的问题对生物神经科学来说是很困难的。因此,南希的团队,转向深度网络寻求帮助。他们使用了AlexNet的计算机视觉后继者--一种被称为VGG的更深的卷积神经网络,并在特定任务中训练了两个独立的深度网络模型:识别人脸,和识别物体。

该团队发现,为识别人脸而训练的深度网络模型在识别物体方面表现很不理想,反之亦然,这恰恰说明了这些网络对人脸和物体的表示方式截然不同。

接下来,该团队就这两个任务训练了一个单一的网络模型。他们发现,该网络内部组织了自己的网络,在网络的后期阶段隔离了对人脸和物体的处理。「VGG在后期阶段会自发地分离更多,」南希说。因此它不必在早期阶段进行分离。而这与人类视觉系统的组织方式保持一致,即分支只发生在腹侧视觉通路的共享早期阶段(侧膝状核和V1和V2区域)的下游。「我们发现,在对这两项任务进行训练的深层网中自发地出现了面部和物体处理的功能专业化,就像在人脑中一样。最让我兴奋的是,我认为我们现在有办法回答关于为什么大脑是这样的问题。」

麻省理工学院的神经科学家乔希-麦克德莫特

麦克德莫特的预想中有三套可能成功的架构。

深层网络的两个任务可以只共享输入层,然后分裂成两个不同的网络。

在另一个极端,任务可以在所有处理过程中共享同一个网络,而只在输出阶段分裂。

或者可以是介于两者之间的几十种变体之一,网络的某些阶段是共享的,而其他阶段则是不同的。

不足为奇的是,输入层之后有专门路径的网络胜过完全共享路径的网络。然而,一个混合网络--在输入阶段后有7个公共层,然后有两个独立的网络,每个网络有5层--几乎和完全独立的网络一样好。最终麦克德莫特团队选择了混合网络,认为它是用最少的计算资源达到最佳效果的网络。三种架构如图所示:

当他们将该混合网络与真人的反应进行对比时,这种模型表现得非常好。它也与一些研究人员早期的实验结果相吻合,这些结果表明,非初级听觉皮层也具有处理音乐和语音的不同区域。而在2018年发表的一项关键测试中,该模型预测了人类主体的大脑活动。该模型的中间层预计了初级听觉皮层的反应,而更深的层则预计了听觉皮层的更高区域。这些预测大大优于之前非基于深度学习设计的模型。

「科学的目标是能够预测系统要做什么,」麦克德莫特说。「这些人工神经网络让我们更接近神经科学的这个目标。」

麻省理工学院神经科学家南希-坎维舍尔最初对深度学习能否用于她自己的研究持怀疑态度,但麦克德莫特的模型给了她灵感。之前,南希最著名的一项研究的是关于下颞皮层的一个区域,纺锤形脸部区域(FFA),专门用于识别人脸。当受试者盯着人脸的图像时,FFA的活跃度明显高于看房屋等物体的图像。而问题是,为什么大脑会将人脸的处理与其他物体的处理隔离开来呢?

从传统意义上来说,回答这种「为什么」的问题对生物神经科学来说是很困难的。因此,南希的团队,转向深度网络寻求帮助。他们使用了AlexNet的计算机视觉后继者--一种被称为VGG的更深的卷积神经网络,并在特定任务中训练了两个独立的深度网络模型:识别人脸,和识别物体。

该团队发现,为识别人脸而训练的深度网络模型在识别物体方面表现很不理想,反之亦然,这恰恰说明了这些网络对人脸和物体的表示方式截然不同。

接下来,该团队就这两个任务训练了一个单一的网络模型。他们发现,该网络内部组织了自己的网络,在网络的后期阶段隔离了对人脸和物体的处理。「VGG在后期阶段会自发地分离更多,」南希说。因此它不必在早期阶段进行分离。而这与人类视觉系统的组织方式保持一致,即分支只发生在腹侧视觉通路的共享早期阶段(侧膝状核和V1和V2区域)的下游。「我们发现,在对这两项任务进行训练的深层网中自发地出现了面部和物体处理的功能专业化,就像在人脑中一样。最让我兴奋的是,我认为我们现在有办法回答关于为什么大脑是这样的问题。」

识别气味

同时,更多这样的证据也在解决气味感知的研究中出现了。

去年,哥伦比亚大学的计算神经科学家Robert Yang和他的团队设计了一个深网来模拟果蝇的嗅觉系统。

气味处理的第一层涉及到了嗅觉感觉神经元,每个神经元只表达大约50种气味受体中的一种。所有同一类型的感觉神经元,平均约有10个,伸向下一层加工层次中的一个神经群。 因为在这一层中,大脑的每一侧大约有50个这样的神经簇,这就建立了感觉神经元的类型和相应的神经簇之间的一对一映射。神经簇与下一层的神经元有多个随机连接,这一层称为凯尼恩层,它有大约2500个神经元,每个神经元接收大约7个输入。凯尼恩层被认为参与了气味的高级表征。最后一层约有20个神经元,提供了苍蝇用来指导其气味相关行动的输出(Yang提醒说,还没有人知道这个输出是否有资格作为气味的分类)。

为了探索一个计算模型来模仿这个过程,Yang的团队首先创建了一个数据集来模仿气味,因为气味激活神经元的方式与图像不同。如果你把两张猫的图像叠加起来,逐个像素添加,得到的图像可能看起来一点都不像猫。然而,如果你把两个苹果的气味混合在一起,很可能还是会闻到苹果的味道。「这是我们用来设计嗅觉任务的一个关键性见解,」杨说。

他们用四层结构构建了这种嗅觉处理深度网络:三层模拟果蝇中的处理层和一个输出层。当Yang和同事训练这个网络对模拟的气味进行分类时,他们发现这个网络收敛了与果蝇大脑中看到的大致相同的连接性:从第1层到第2层的一对一映射,然后从第2层到第3层的稀疏和随机(7比1)映射。

这种相似性表明,进化和深网都已经达到了最优解。但Yang仍然对他们的结果持谨慎态度。「也许我们在这里只是运气好,也许它并不具有普遍性,」他说,「下一步的测试将是优化深度网络,可以预测一些尚未研究的动物嗅觉系统中的连接性,然后由神经科学家证实。「这将为我们的理论提供更严格的测试。」

不仅是黑盒子

深度网络最为人诟病的地方,除了它们无法对偏离训练数据集太远的数据进行泛化,还是因为它是黑盒子(只知道输入和输出对应关系,而不知道它的内部结构

)。

通过研究塑造深网的数百万甚至数十亿个参数来解释深网的决策是不可能的。

深网模型对大脑的某些部分是不是仅仅是将一个黑盒子替换成另一个黑盒子?

在Yang看来,并不尽然。

「它还是比大脑更容易研究。」

去年,DiCarlo的团队发表了成果,对深层网络的不透明性和所谓的不能泛化进行了研究。研究人员使用AlexNet的一个版本对猕猴的腹侧视觉流进行建模,并找出了人工神经元单元与猴子V4区域神经部位的对应关系。然后,利用计算模型,他们合成了能预测会引起猴子不自然的活动图像。在一项实验中,当这些「不自然」的图像给猴子看时,它们提升了68%的神经部位的活动,超过了它们平时的水平;在另一项实验中,这些图像推动了一个神经元的活动,而抑制了附近神经元的活动。这两种结果都是能被神经网络模型预测的。

对研究人员来说,这些结果表明,深网确实可以推广到大脑,而且并非完全不可理解。而深网和大脑之间在结构和性能上的趋同并不一定意味着它们的工作方式是一样的;也有一些方式可以证明它们不是这样的。但可能是这两种类型的系统有足够的相似性,所以可以遵循某种广义上的相同管理原则。

深度神经网络的局限性

麦克德莫特认为这些深网研究也具有潜在的医疗价值。

当人们失去听力时,通常是由于耳朵的变化,而大脑的听觉系统必须应对这种受损的信息输入。

「所以,如果我们有很好的模型来说明听觉系统的其他部分在做什么,我们就会有更好的想法来实际帮助人们更好的听觉。

」不过,他对深层网能够提供的东西还是持谨慎态度。

「我们一直在相当努力地尝试理解神经网络作为模型的局限性。」

在这些限制演示中,麦克德莫特实验室的研究生詹妮尔和其他人专注于「同色异谱」

,这是物理上的一种概念,指不同的输入信号,在系统中产生相同的表示。

例如,两个音频元器具有不同的波浪形式,但对人类来说,声音是一样的。

利用听觉系统的深层网络模型,该团队设计了自然音频信号的元器;

这些元器以音频片段的方式激活了神经网络的不同阶段。

如果神经网络能准确地模拟人类的听觉系统,那么元器的声音也应该是一样的。

但事实并非如此。在神经网络的早期阶段,人类能识别出与相应音频片段产生相同激活的声音。然而,这对于网络深层阶段具有匹配激活的声音并不成立:这些声音对人类来说听起来却像噪音。「因此,即使在某些情况下,这类模型在复制人类行为方面做得非常好,但它们也有一些非常错误的地方,」麦克德莫特说。

麻省理工学院的认知神经科学家乔什表示,虽然所有这些深网模型都是「真正具有进步意义的步骤」,但它们主要是在做分类或归类任务。然而,我们的大脑所做的工作远不止于对外界的事物进行分类。我们的视觉系统可以理解表面的几何形状和场景的3D结构,它可以推理出潜在的因果因素--例如,它可以实时推断出一棵树的消失只是因为有一辆车从它面前经过。

为了理解大脑的这种能力,曾在麻省理工学院工作、现在在耶鲁大学工作的伊尔克尔

与乔什及其同事合作,建立了一种被称为高效逆向图形模型的东西。

它从描述要在背景上渲染的人脸的参数开始,比如人脸的形状、质地、光线方向、头部姿势等等,再用计算机图形程序根据这些参数创建一个三维场景;

然后,经过不同阶段的处理,它产生从某一位置观看该场景的二维图像。

研究人员利用生成模型中的3D和2D数据,训练了一个修改版的AlexNet,以从一个不熟悉的2D图像中预测3D场景的可能参数。

「系统学会了从效果到原因,从2D图像到产生它的3D场景的倒推,」乔什说。

该团队通过验证其对猕猴下颞皮层活动的预测来测试他们的模型。他们向猕猴展示了175张图像,显示了7种姿势中的25个个体,并记录了来自 「脸部斑块」的神经信号,即专门用于脸部识别的视觉处理区域。他们还将这些图像展示给他们的深度学习网络模型。在网络中,第一层人工神经元的激活代表了2D图像,最后一层的激活代表了3D参数。

「在这一过程中,它经历了一堆转换,似乎基本上可以让你从2D到3D」,乔什说。他们同时发现,网络的最后三层与猕猴面部处理网络的最后三层对应得非常好。这表明,大脑不仅使用生成模型和识别模型的组合来识别和描述对象,而且推断出场景中固有的因果结构,这一切都在瞬间完成。乔什也承认,他们的模型并不能证明大脑是这样工作的。「但它确实打开了一扇门,让我们能以更理智的方式去探索,它应该是......激励我们去成功解析生物大脑!」

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

图示:现任斯坦福大学的计算神经科学家丹尼尔-亚明斯(Daniel Yamins)

图示:现任斯坦福大学的计算神经科学家丹尼尔-亚明斯(Daniel Yamins)

麻省理工学院的神经科学家乔希-麦克德莫特

麻省理工学院的神经科学家乔希-麦克德莫特