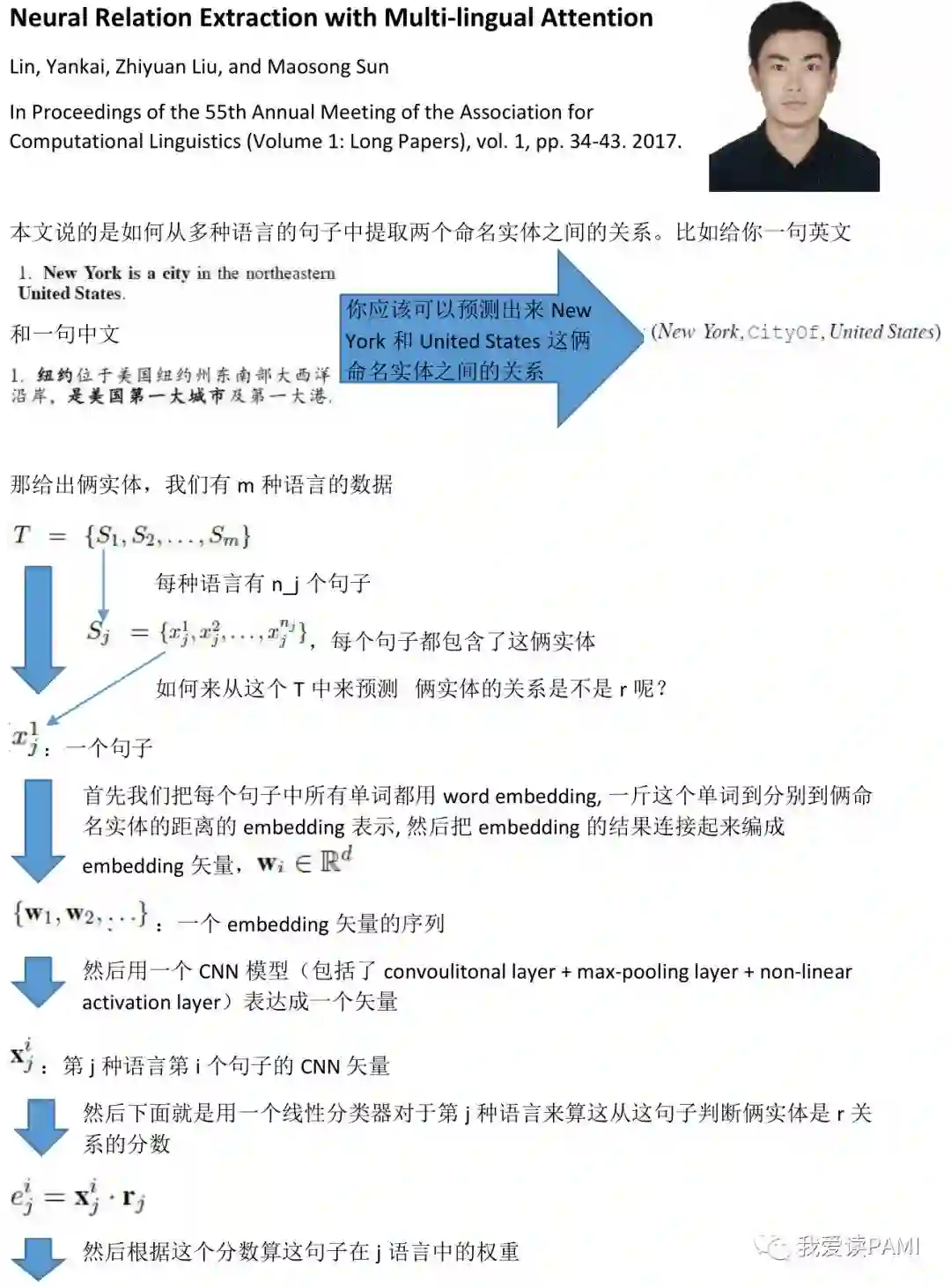

暗通沟渠:Multi-lingual Attention

你看这个句子中有俩命名实体,我们要从中提取他们之间的关系。关系提取呢,可以从一种语言中提取,也可以从多个语言中提取。本文讲的就是如何在多种语言中暗通沟渠,预测俩实体之间的关系。作者是清华的牛逼博士生, Yankai Lin。

Neural Relation Extraction with Multi-lingual Attention

Lin, Yankai, Zhiyuan Liu, and Maosong Sun

In Proceedings of the 55th Annual Meeting of the Association for

Computational Linguistics (Volume 1: Long Papers), vol. 1, pp. 34-43. 2017.

登录查看更多

相关内容

Attention机制最早是在视觉图像领域提出来的,但是真正火起来应该算是google mind团队的这篇论文《Recurrent Models of Visual Attention》[14],他们在RNN模型上使用了attention机制来进行图像分类。随后,Bahdanau等人在论文《Neural Machine Translation by Jointly Learning to Align and Translate》 [1]中,使用类似attention的机制在机器翻译任务上将翻译和对齐同时进行,他们的工作算是是第一个提出attention机制应用到NLP领域中。接着类似的基于attention机制的RNN模型扩展开始应用到各种NLP任务中。最近,如何在CNN中使用attention机制也成为了大家的研究热点。下图表示了attention研究进展的大概趋势。