EMNLP 2019开源论文:针对短文本分类的异质图注意力网络

作者丨纪厚业

单位丨北京邮电大学博士生

研究方向丨异质图神经网络及其应用

本文由北邮和南洋理工联合发表在自然语言处理顶会 EMNLP 2019 上并开源了代码和数据(http://shichuan.org/ )。

论文动机

短文本分类在新闻及微博等领域得到了广泛的应用。但是,目前的文本分类算法主要集中于长文本分类并且无法直接应用于短文本分类。这是由于短文本分类的两个独有挑战:

1. 数据的稀疏和歧义:短文本通常不超过 10 个词,提供的信息非常有限。经典的 Bi-LSTM+Attention 往往无法有效的捕获短文本中的语义信息。

2. 标签数量较少:传统的监督学习无法有效工作,尤其是传统深度学习算法需要大量的监督数据。

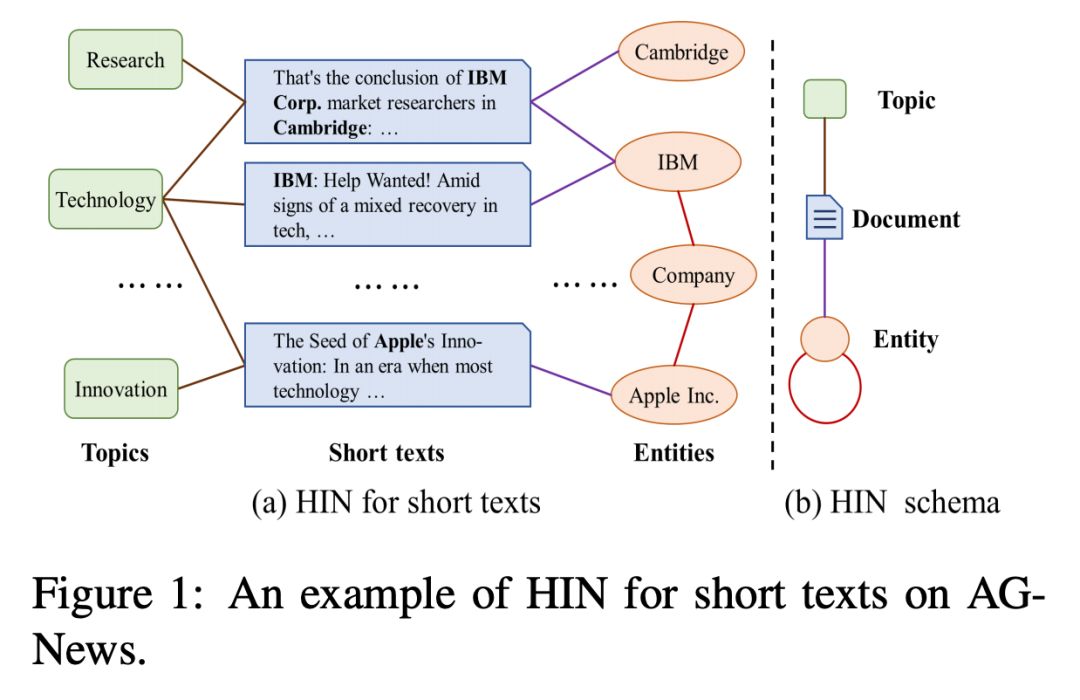

针对上述两个挑战,本文创新地将短文本建模为异质图(见 Figure 1),通过图数据的复杂交互来解决数据稀疏和歧义带来的挑战。同时,本文提出了一种异质图注意力 HGAT 来学习短文本的表示并进行分类。HGAT 是一种半监督学习算法可以更好的适用于标签数量较少的场景,如短文本的分类。

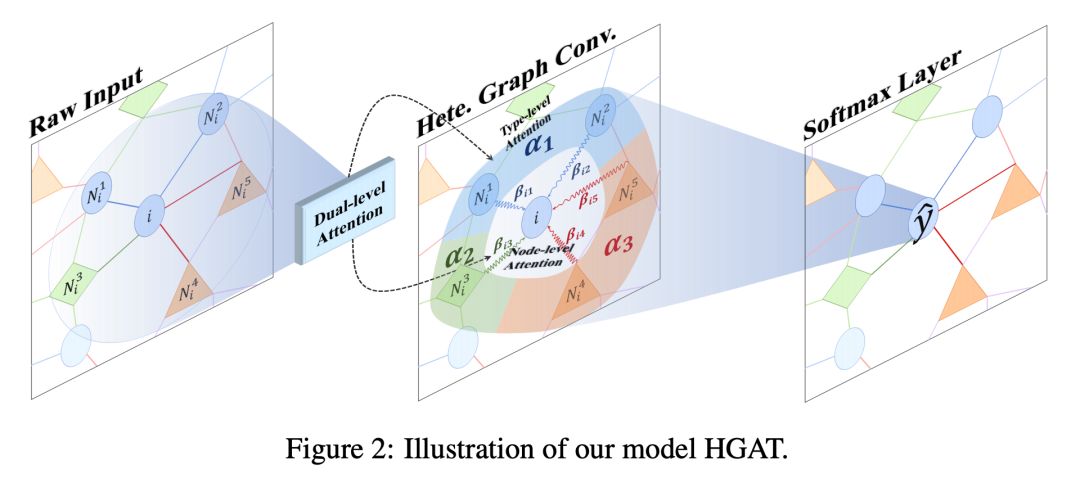

HGAT

本文提出 Heterogeneous Graph Attention Network 来学习短文本异质图的表示。考虑到短文本所建模的异质图的特点,HGAT设计了 dual-level attention mechanism,包括 node level 和 type level,来更好的学习短文本的表示。模型架构图如 Figure 2 所示。

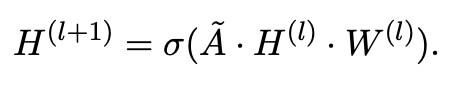

GCN & Heterogeneous GCN

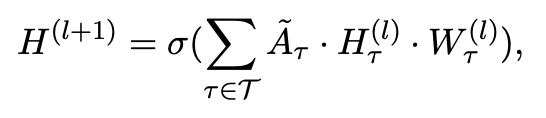

本文首先对图神经网络和异质图神经网络进行了简单回顾。GCN 作为一种经典的图卷积神经网络,通过聚合邻接信息来更新节点表示。GCN 的核心更新公式如下:

其中,

代表对称归一化邻接矩阵,

代表第 l 层的投影矩阵。这里基于

来聚合邻居,每个邻居的重要性都是一样的。那么能不能学习邻居的重要性并加权融合来更好的学习节点表示呢?

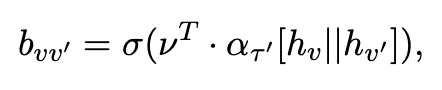

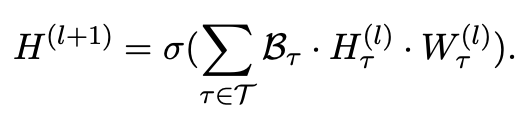

Heterogeneous GCN 与 GCN 最大的区别是需要考虑多种异质关系的融合。Heterogeneous GCN 的核心更新公式如下:

可以看出,和 GCN 更新公式的最大区别是这里考虑了 T 种异质关系并进行了多关系的融合。这里对于多关系的融合是比较简单的,那么能不能加权融合呢?

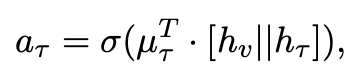

Node Level Attention

显而易见,每个节点的邻居应该具有不同的重要性。Node level attention 可以学习邻居的重要性并通过加权聚合来学习节点的表示。Node level attention 首先将节点及其邻居的表示拼接起来,然后通过单层 MLP 和注意力向量将其转化为注意力分数。

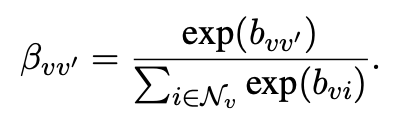

这里将注意力分数通过 softmax 归一化得到了注意力权重

。

最后,基于所学习到的注意力权重来聚合邻居。

可以看出,node level attention 将 Heterogeneous GCN 中的替换成了

。这样,噪音邻居的权重会较低而相对比较重要的邻居的权重会较高。

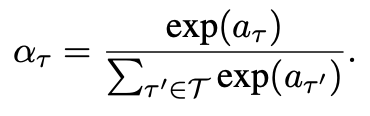

Type Level Attention

Type level attention 目标是学习多种关系的重要性并进行融合节点在多个关系下的表示。这里首先定义了节点 v 在关系 T 下的表示

如下式所示:

然后,通过 softmax 来对注意力分数进行归一化:

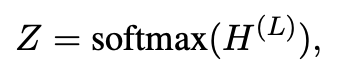

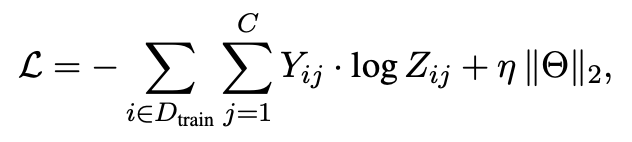

Model Training

最后,我们将最后一层的节点(短文本)表示取出来并通过交叉熵来进行训练。

需要注意的是,HGAT 是半监督算法,这里的 loss 也是在少量标签数据上计算的。

实验

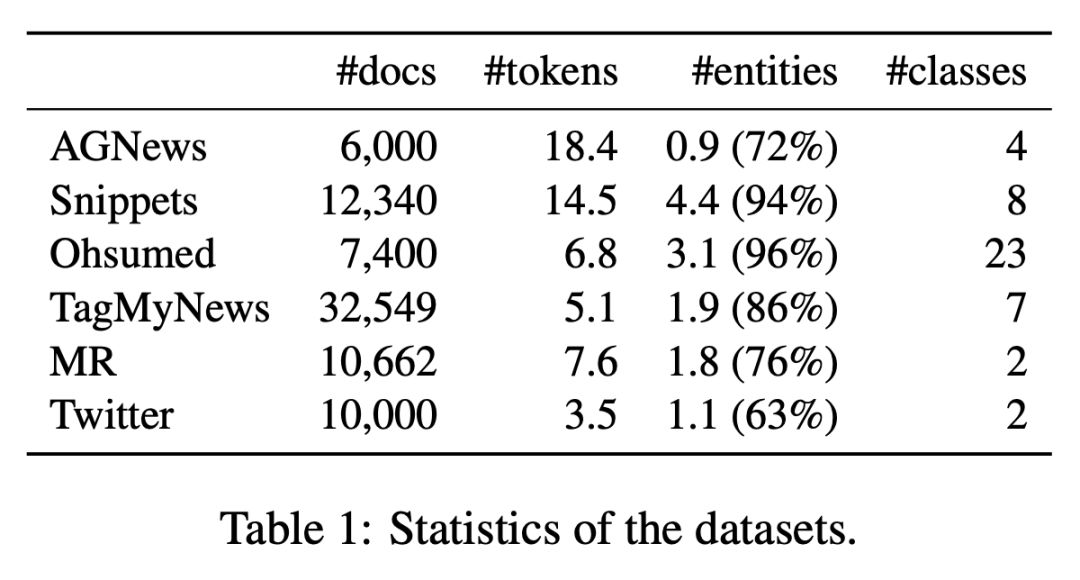

本文在 6 个数据集上进行了大量实验。数据集描述见 Table 1。

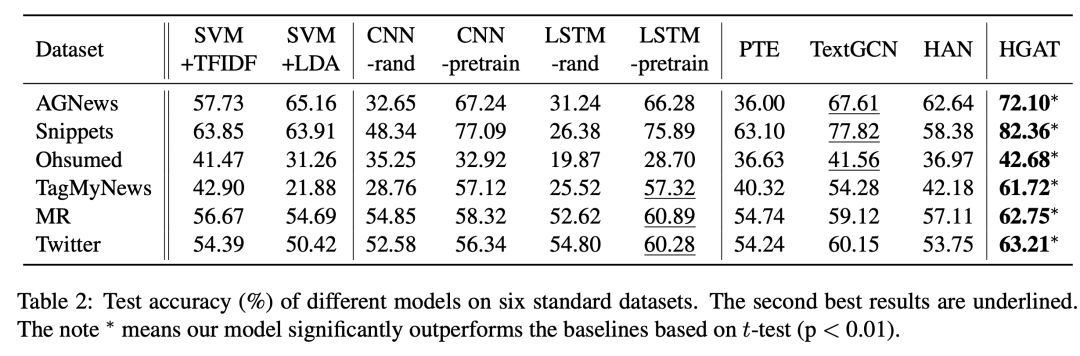

Baseline 的选择也较为全面,包括同样将文本数据建模为图的 TextGCN 和异质图神经网络 HAN。

对比结果见 Table 2,可以看出本文所提出的 HAN 有明显的优势。经典的 LSTM 和 CNN 在短文本分类上表现并不好。

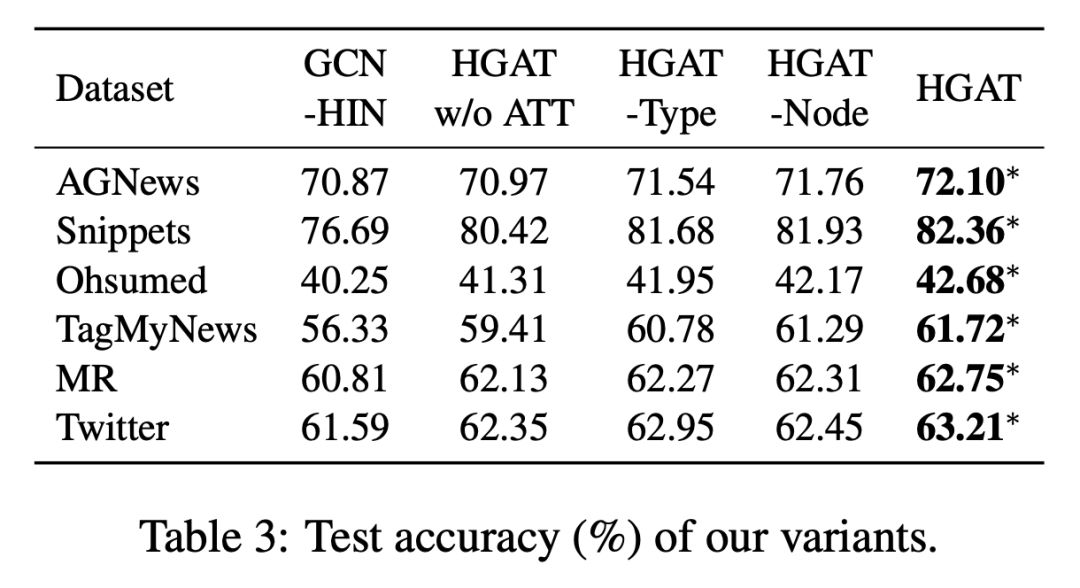

另外,本文也测试了 HGAT 的多个变种,如 Table 3 所示。

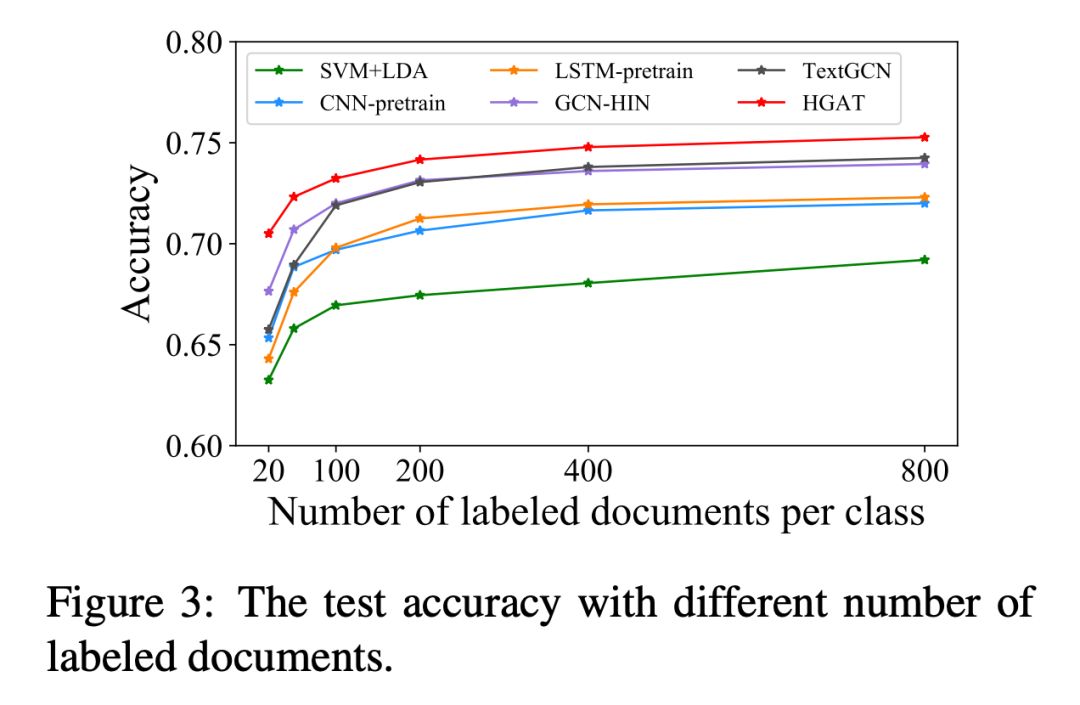

最后,作者也测试标签数量对模型效果的影响,见 Figure 3. 可以看出,随着标签数量的增加,所有模型的表现都有不同程度的提升。

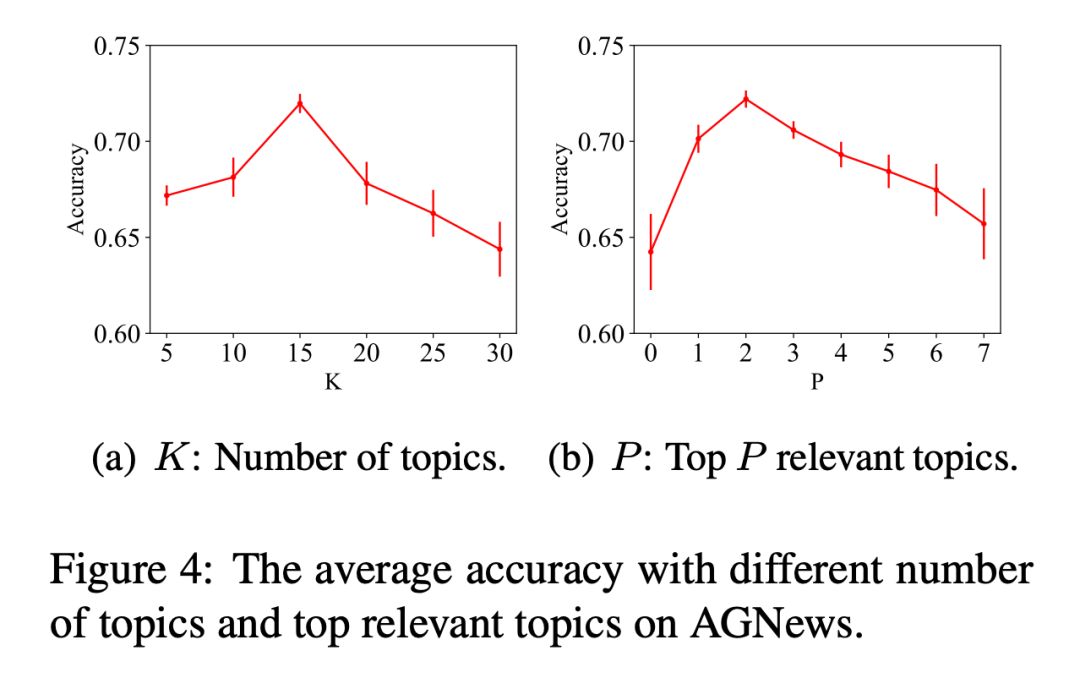

作者也尝试了不同的构图方式对模型的影响,见 Figure 4.

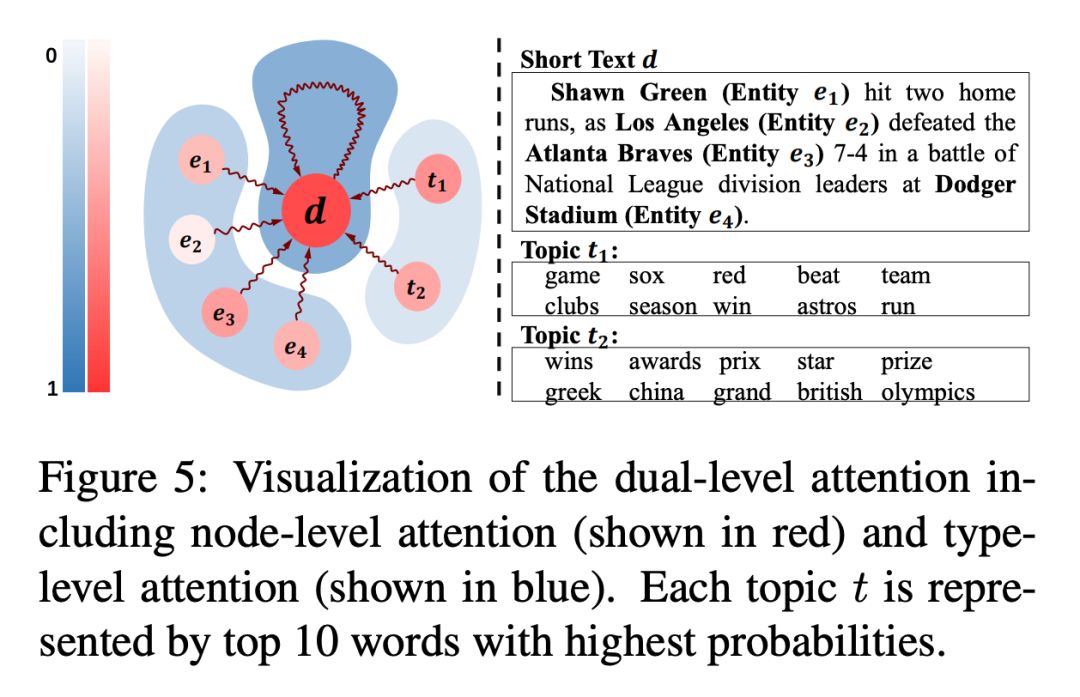

最后,作者通过一个 case study 来说明 attention 的作用,见 Figure 5. 受益于注意力机制,HGAT 有较好的可解释性。

总结

本文创新地将短文本分类转化为异质图建模来解决数据稀疏和歧义的问题。同时,HGAT 通过层次注意力机制更好的实现了信息聚合,所学习到的短文本的表示更加准确。最后,大量的实验验证了本文所提出算法的有效性。

图神经网络已经成为深度学习领域最热门的方向之一,也在很多领域得到了广泛的应用。除了短文本分类,图像和推荐领域也可以尝试引入图神经网络甚至是异质图神经网络。

PaperWeekly携手图灵教育

送出5本HanLP作者最新力作

本书作者是自然语言处理类库 HanLP 作者何晗。截至 2019 年 10 月初,该项目的 GitHub Star 数已达 15 K,超过了宾夕法尼亚大学的 NLTK、斯坦福大学的 CoreNLP、哈尔滨工业大学的 LTP。

作者汇集多年经验,从基本概念出发,逐步介绍中文分词、词性标注、命名实体识别、信息抽取、文本聚类、文本分类、句法分析这几个热门问题的算法原理与工程实现。书中通过对多种算法的讲解,比较了它们的优缺点和适用场景,同时详细演示生产级成熟代码,助你真正将自然语言处理应用在生产环境中。

长按识别下方小程序码

即可参与本次抽奖

开奖时间:10月25日 13:00

10.31-11.1 北京智源大会

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 下载论文 & 源码