HAN:基于双层注意力机制的异质图深度神经网络

本文授权转载自公众号:PaperWeekly

这是一个推荐、解读、讨论和报道人工智能前沿论文成果的学术平台,致力于让国内外优秀科研工作得到更为广泛的传播和认可。

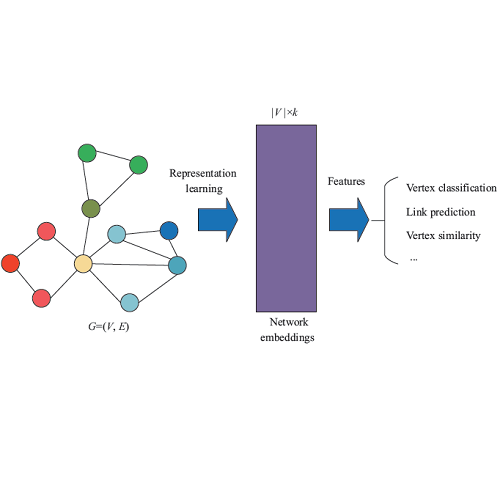

图神经网络是近年来图数据挖掘领域的热门研究方向之一,被誉为是新一代深度学习。图神经网络可以将端到端学习与归纳推理相结合,有望解决深度学习无法进行关系推理的问题。

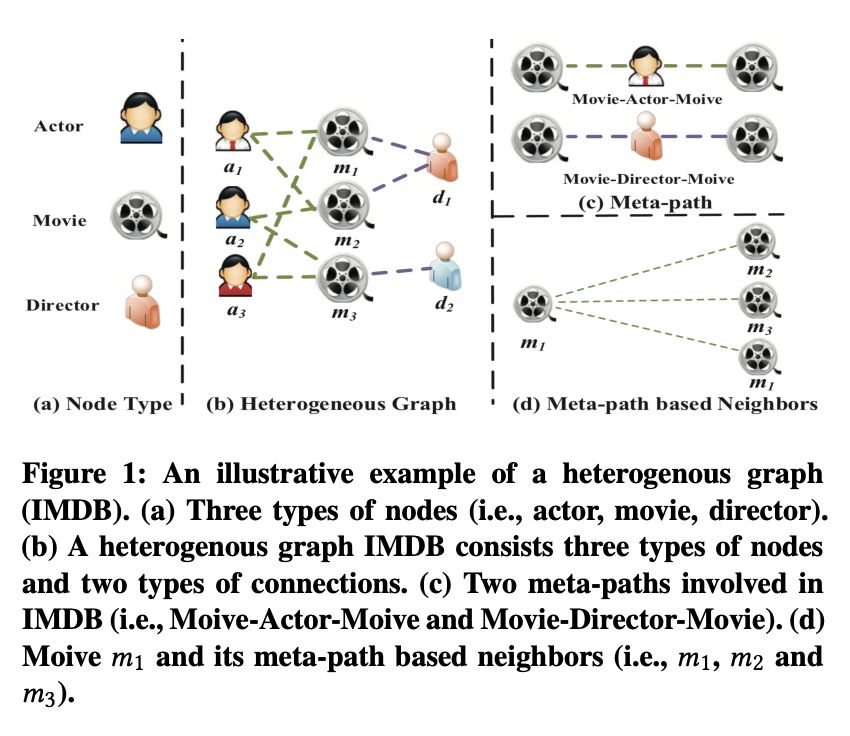

以 Graph Convolutional Network,Graph Attention Network 为代表的图神经网络已经引起了学术界与工业界的广泛关注。然而,目前的图神经网络主要针对同质图(节点类型和边类型单一)设计,但真实世界中的图大部分都可以被自然地建模为异质图(多种类型的节点和边,如图 1 所示,IMDB 数据中包含三种类型的节点 Actor、Movie 和 Director,两种类型的边 Actor-Movie 和 Movie-Director)。

相对于同质图神经网络,异质图神经网络具有更强的现实意义可以更好的满足工业界需求。如阿里巴巴正在建设亿级节点十亿级边的异质图神经网络平台 AliGraph 来满足整个阿里集团各种商业化场景需求。因此亟需展开面向异质图的图神经网络模型研究,而异质图的异质性却又给设计图神经网络带来了巨大的挑战。

在设计异质图神经网络的时候,从异质图的复杂结构出发,需要满足下面三个要求:

1. 异质性:考虑不同节点和不同关系的差异。不同类型节点有其各自的特点,节点的属性空间也不尽相同。如何处理不同类型节点并保留各自的特性是设计异质图神经网络时迫切需要解决的问题;

2. 语义级别注意力:学习元路径重要性并进行融合。异质图中的一个基本结构是元路径结构,对于某个具体任务,不同元路径表达的语义不同,因此对任务的贡献也不同。如何设计针对元路径的注意力机制是异质图神经网络中的一个基本问题;

3. 节点级别注意力:学习节点邻居的重要性并进行融合。节点的邻居多种多样甚至还有一些噪声邻居。针对不同任务,邻居的重要性也会有所差异。如何设计针对不同类型邻居的注意力机制是异质图神经网络的一个基本问题。

本文首次提出了基于注意力机制的异质图神经网络 Heterogeneous Graph Attention Network(HAN),可以广泛地应用于异质图分析。HAN 利用语义级别注意力和节点级别注意力来同时学习元路径与节点邻居的重要性,并通过相应地聚合操作得到最终的节点表示。

模型

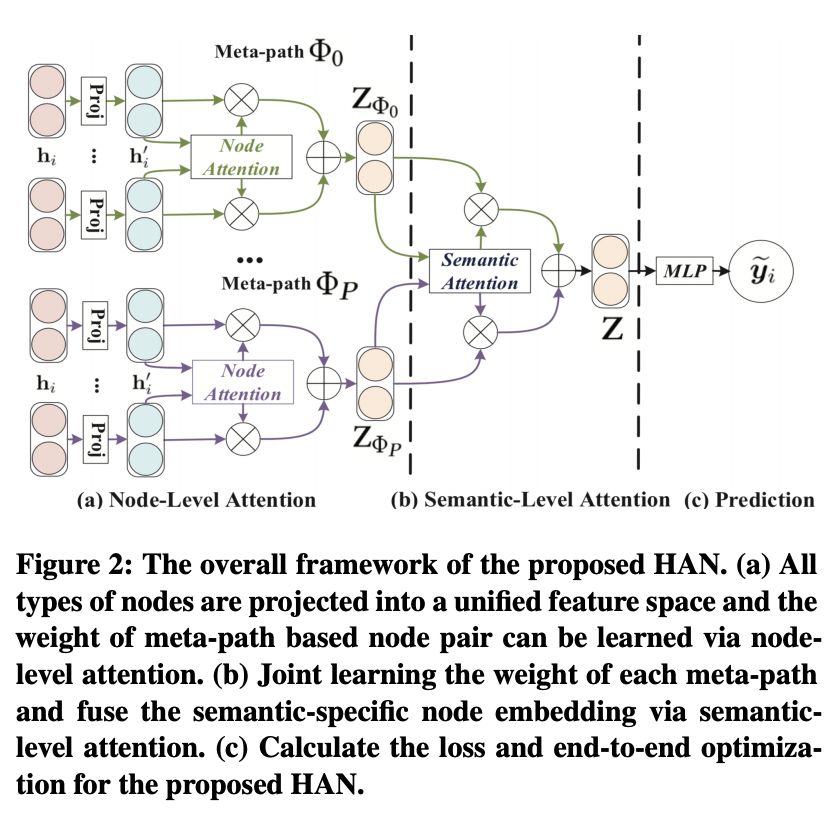

模型整体架构如图 2 所示。模型主要分为 3 个模块:1)节点级别注意力模块。2)语义级别注意力模块。3)预测模块。

首先,通过节点级别的注意力来学习邻居的权重并聚合得到一条具体元路径下的节点表示。然后,通过语义级别的注意力来学习多条元路径的权重并对节点表示进行加权融合。最后根据特定任务来优化整个模型。

节点级别注意力

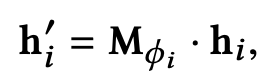

给定某条元路径,我们可以利用节点级别注意力来学习特定语义下(Semantic-specific)的节点表示。我们首先将不同类型的节点属性通过投影矩阵变换到统一的属性空间。

其中,是投影矩阵,

和

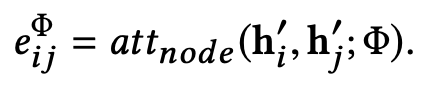

分别是投影前后的节点特征。这里基于自注意力机制(self-attention)设计了节点级别注意力。具体来说,节点级别注意力将节点对的表示拼接起来并利用注意力向量来学习节点与其邻居间的重要性。

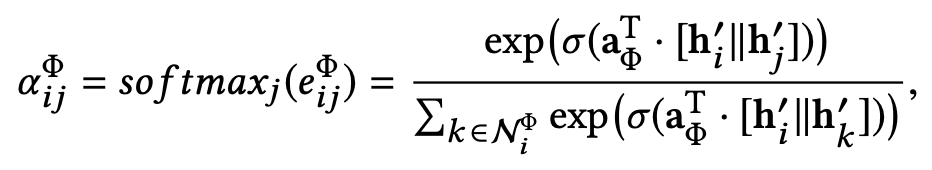

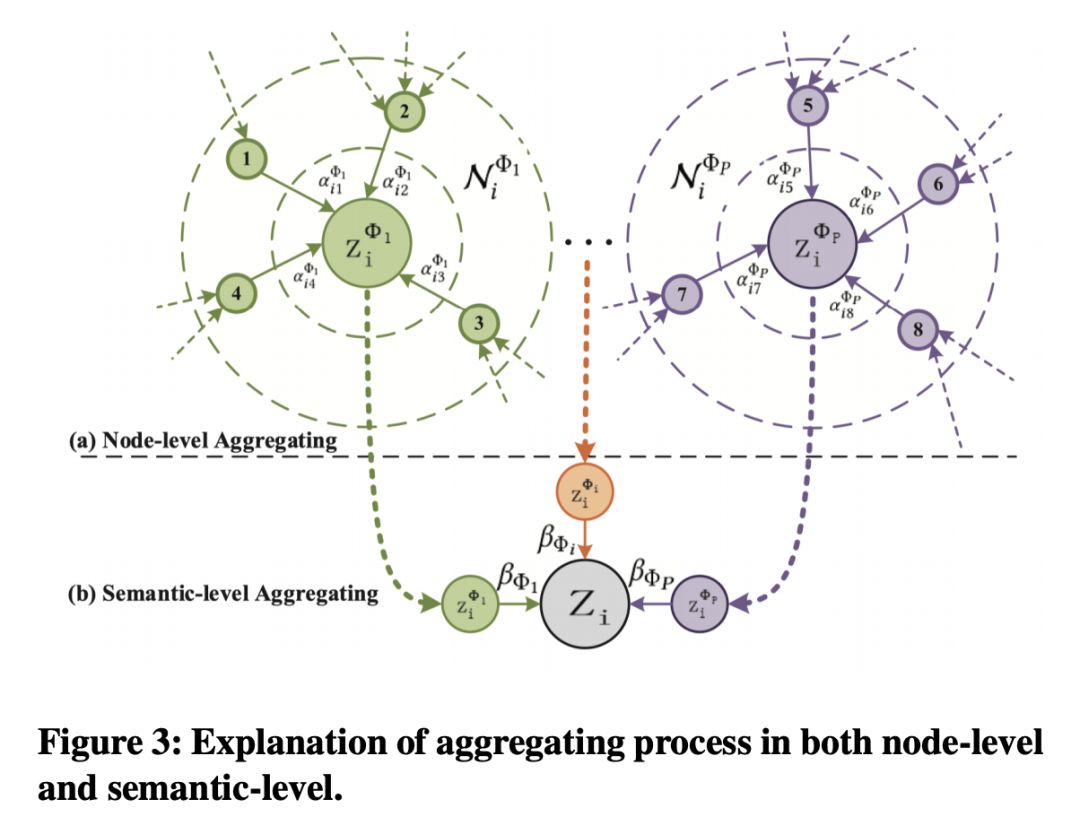

其中,是节点对 (i, j) 的注意力权重。注意这里的注意力是非对称的,这也符合图数据的实际特性。最后,通过节点级别的聚合操作(如图 3 (a) 所示)来学习 Semantic-specific 的节点表示。每个节点的表示都是由其邻居表示加权融合得到。

其中,是节点在某条元路径下的表示。给定某条元路径,节点级别注意力可以学习到节点在某个语义下的表示。但是,在实际异质图中往往存在多条不同语义的元路径,单条元路径只能反映节点某一方面的信息。为了全面的描述节点,我们需要融合多条元路径的语义信息。

语义级别注意力

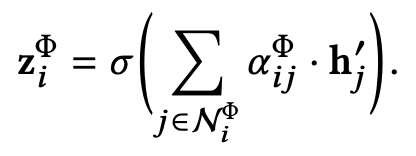

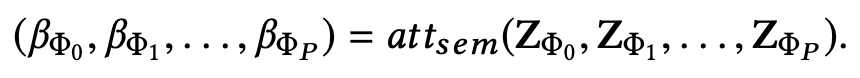

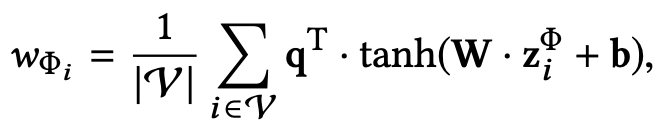

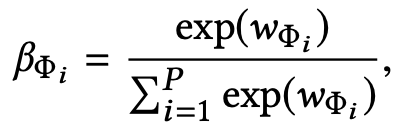

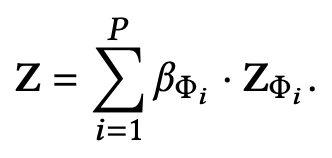

给定元路径集合,节点级别注意力用来学习到不同语义下的节点表示。进一步,我们可以利用语义级别注意力来学习语义的重要性并融合多个语义下的节点表示。语义级别注意力的形式化描述如下:

其中,

通过对多个语义进行加权融合(融合过程如图 3 (b) 所示),可以得到最终的节点表示。需要注意的是,这里的元路径权重是针对特定任务优化的。不同任务需要的语义信息不尽相同,元路径的加权组合形式也会有所差异。

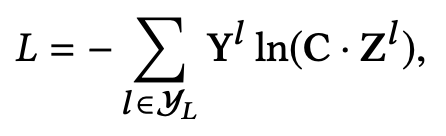

最后,我们基于半监督的分类 loss 来优化整个模型。

实验结果

本文在三个数据集上做了大量充分的实验(包括节点分类,节点聚类,可视化)来验证模型的有效性。同时为了验证节点级别和语义级别的作用,作者分别去除节点和语义级别助理并进行实验。最后,作者通过对节点和语义级别的注意力机制进行了分析来说明 HAN 的可解释性。

本文的代码可见:

https://github.com/Jhy1993/HAN

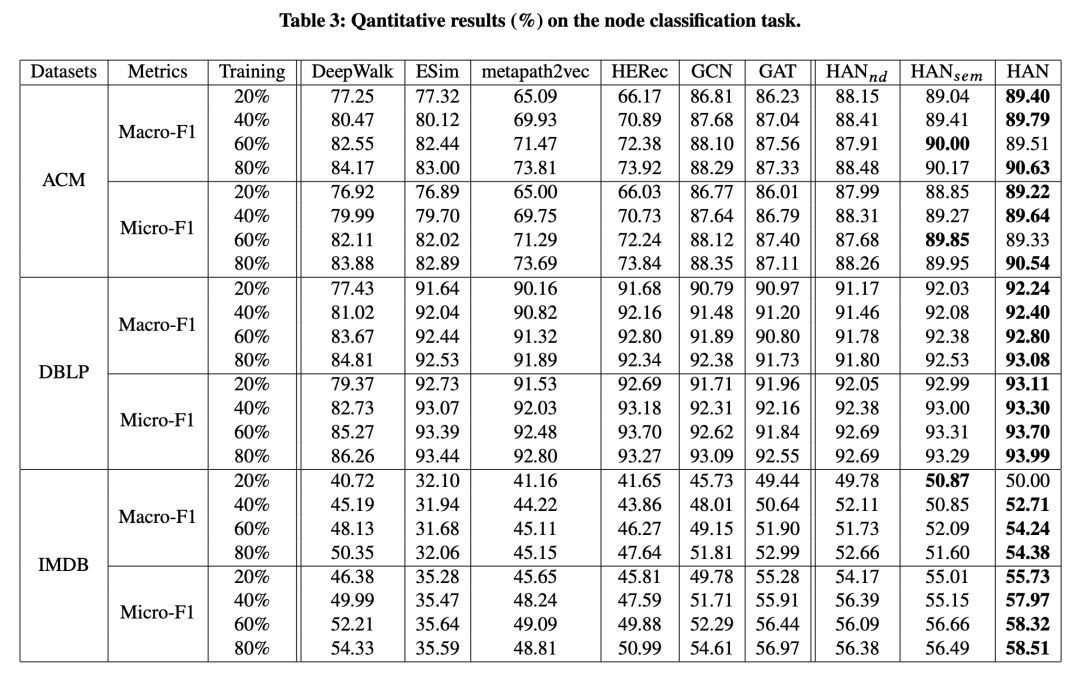

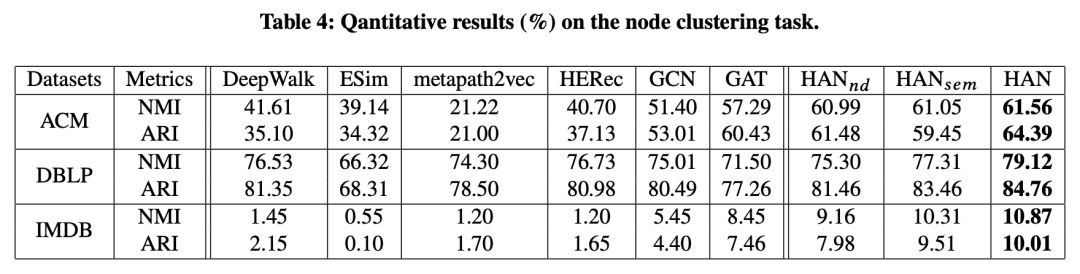

表 3 和表 4 分别为节点分类和聚类实验,可以看出:相对于当前最优算法,本文所提出的模型表现更好。同时,去除节点级别和语义级别注意力后,模型的效果有不同程度的降低。这验证了节点级别注意力和语义级别注意力的有效性。

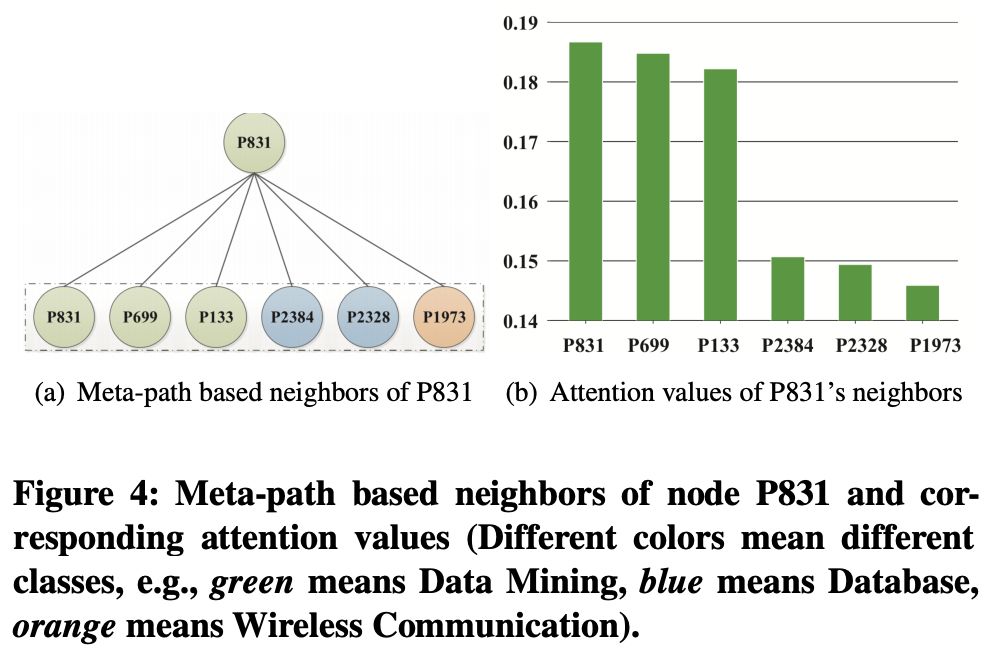

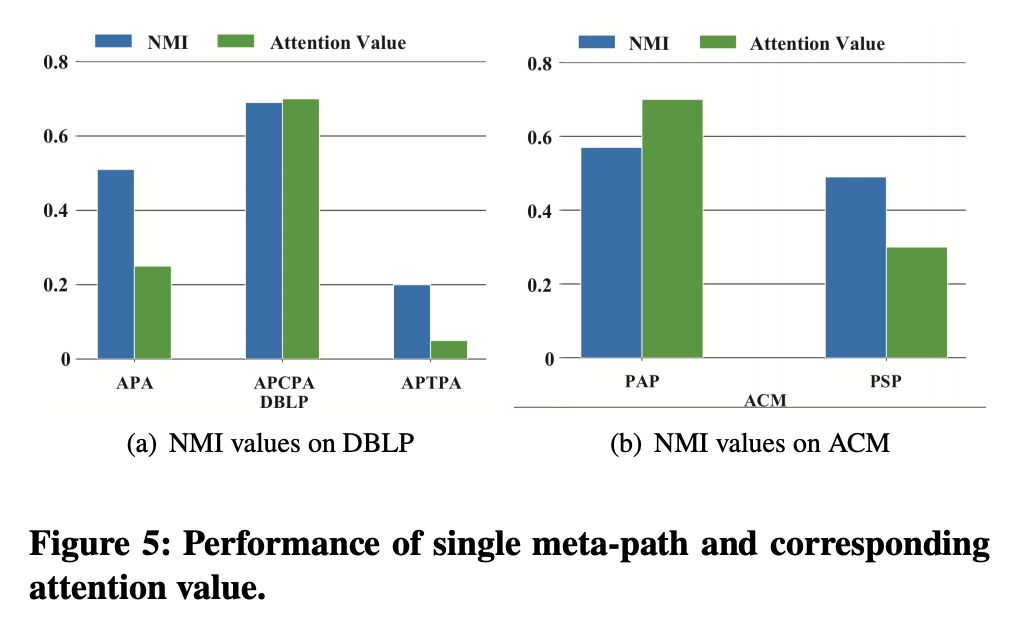

我们还进一步分析了层次注意力的合理性。节点级别和语义级别注意力分析分别如图 4 和图 5 所示。可以看出:节点级别注意力赋予了同类型的邻居更高的权重。在语义级别,对较为重要的元路径,也就是该条元路径在聚类任务上具有较大的 NMI 值,HAN 会赋予他们相应较大的权重,因此 HAN 可以自动选取较为重要的节点邻居及元路径。

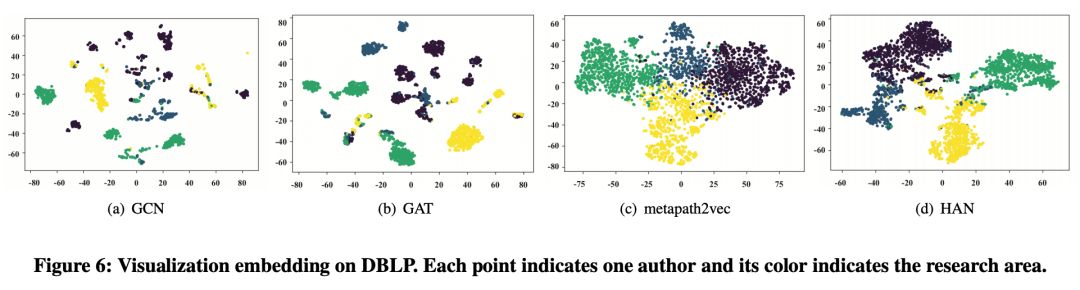

图 6 展示了各个算法可视化结果。我们可以清楚地看到:HAN 所学习到的节点表示具有更强的表示能力,可以清晰的将不同领域的作者分为 4 类。

总结

异质图在真实世界无处不在,异质图的分析也是数据挖掘的热门方向。作者设计了一种异质图神经网络,同时在节点和语义级别利用注意力机制来对邻居信息和语义信息进行加权融合,进而学习到更加细致全面的节点表示。同时,通过对两层的注意力机制进行分析,所提模型具有较好的可解释性。

现实生活中,很多场景均可以被建模为异质图,如淘宝网就可以建模为用户,商品和商家交互的异质图。本文所提出的异质图注意力网络 HAN 具有广泛的适用性,可以根据不同场景(如商品推荐和异常账户检测)的需求设计不同的损失函数来学习节点表示。

按照本文的思路,未来可以进一步尝试利用 meta-graph 或者 motif 来抽取不同的结构信息或者针对不同场景的差异化需求设计相应的图神经网络。更多关于异质图分析的论文及相关代码数据见 www.shichuan.org。

关于作者

纪厚业,北京邮电大学计算机科学与技术专业博士研究生。目前研究方向为网络表示学习和图神经网络。

王啸,北京邮电大学计算机学院助理教授。2016年获得天津大学计算机应用技术专业博士学位,美国圣路易斯华盛顿大学联合培养博士,曾在清华大学计算机系任博士后。主要研究社会网络分析、数据挖掘与机器学习。在WWW、AAAI、IJCAI、KDD、TKDE等国际顶级学术会议及期刊上发表论文30余篇,曾担任KDD、AAAI、IJCAI等国际学术会议程序委员会成员。

石川,北京邮电大学计算机学院教授、博士研究生导师、智能通信软件与多媒体北京市重点实验室副主任。主要研究方向:数据挖掘、机器学习、人工智能和大数据分析。IEEE/ACM会员、中国计算机学会高级会员、人工智能学会高级会员、中国人工智能学会知识工程与分布智能专业委员会常务委员、中国计算机学会人工智能与模式识别专委会委员、中国中文信息学会社会媒体处理专委会委员。近五年来,以第一或者通讯作者发表高水平学术论文50余篇,包括数据挖掘领域的顶级期刊和会议IEEE TKDE、ACM TIST、KDD、AAAI、IJCAI、WWW、CIKM等。在Springer出版异质信息网络方向第一部英文专著。申请国家发明专利十余项,国际专利1项,已授权4项,相关研究成果应用到阿里巴巴、腾讯和华为等知名企业。获得ADMA2011和ADMA2018等国际会议最佳论文奖、CCF-腾讯犀牛鸟基金及项目优秀奖,并指导学生获得顶尖国际数据挖掘竞赛IJCAI Contest 2015 全球冠军。获得北京市高等学校青年英才计划支持和北京市“师德先锋”称号。

主办单位

推荐阅读

基础 | TreeLSTM Sentiment Classification

原创 | Simple Recurrent Unit For Sentence Classification

原创 | Attention Modeling for Targeted Sentiment

欢迎关注交流

欢迎关注交流