【CMU】图卷积神经网络中的池化综述,Pooling in Graph Convolutional Neural Network

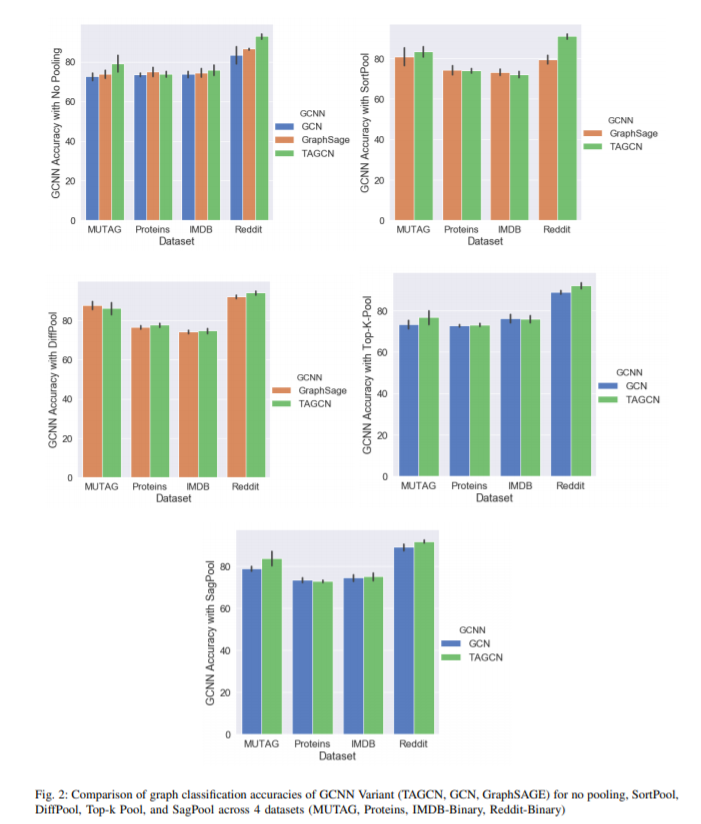

图卷积神经网络(GCNNs)是深度学习技术在图结构数据问题上的一种强大的扩展。我们对GCNNs的几种池方法进行了实证评估,并将这些图池化方法与三种不同架构(GCN、TAGCN和GraphSAGE)进行了组合。我们证实,图池化,特别是DiffPool,提高了流行的图分类数据集的分类精度,并发现,平均而言,TAGCN达到了可比或更好的精度比GCN和GraphSAGE,特别是对数据集较大和稀疏的图结构。

https://arxiv.org/abs/2004.03519

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“PGCN” 就可以获取《【CMU】图卷积神经网络中的池化综述,Pooling in Graph Convolutional Neural Network》专知下载链接

登录查看更多

相关内容

专知会员服务

49+阅读 · 2020年2月15日

专知会员服务

76+阅读 · 2020年1月16日

专知会员服务

95+阅读 · 2019年11月8日

Arxiv

4+阅读 · 2018年12月28日