Dropout到底在干啥?看完这篇文章,你就知道了

【导读】Dropout是非常常用的深度学习组件,一般用来做模型正则化或模型压缩,然而,Dropout到底是怎么做的?它有哪些变体?CNN和RNN中Dropout该怎么用?看完这篇文章,你就都知道了。

论文链接: https://arxiv.org/pdf/1904.13310.pdf 论文题目: Survey of Dropout Methods for Deep Neural Networks

深度神经网络是当代人工智能和信号处理领域的一个重要课题。它们的大量参数使得它们特别容易过度拟合,在实践中需要正则化方法。Dropout是2012年推出的一种避免过度拟合的技术,随后被应用于2012年的大尺度视觉识别挑战赛 (Large Scale Visual Recognition Challenge) ,该挑战赛彻底改变了深度学习研究。原方法在每次训练迭代中省略概率为0.5的神经网络中的每个神经元,在测试中包含所有神经元。该技术被证明可以显著提高在各种任务上的结果。

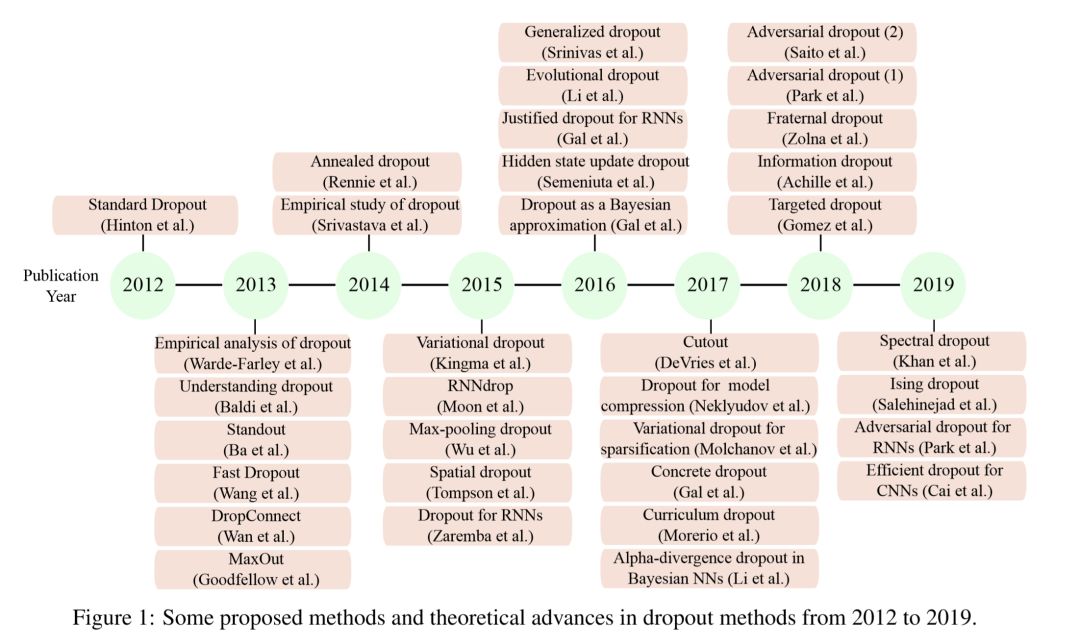

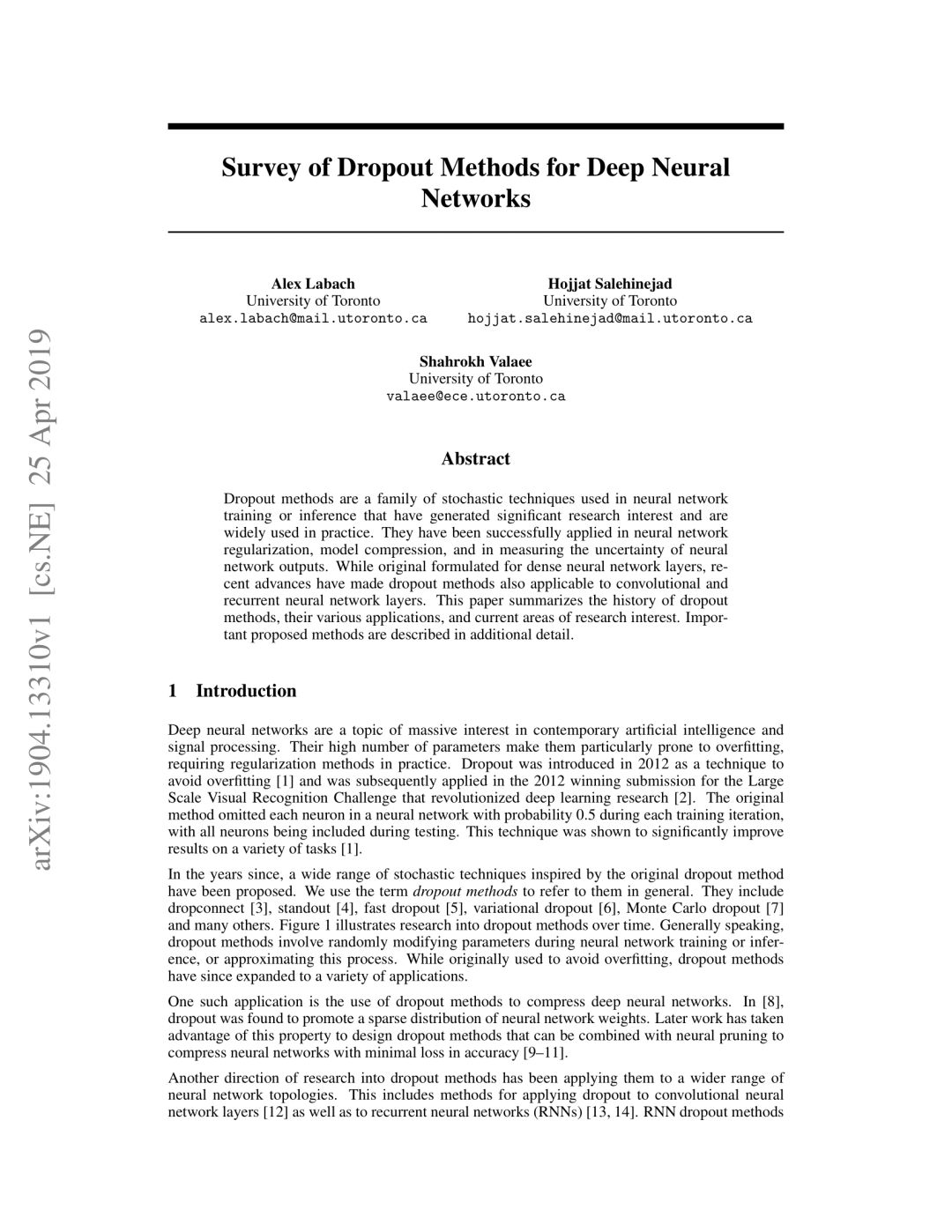

近年来,受原始dropout方法的启发而提出的各种随机技术得到了广泛的应用。我们通常使用术语dropout方法来指代它们。其中包括dropconnect、standout、fast dropout、变分dropout、Monte Carlo dropout等。上图展示了对随时间推移的辍学方法的研究。一般来说,dropout方法是在神经网络训练、推理或近似过程中随机修改参数。虽然最初用于避免过度拟合,但dropout方法已经扩展到各种应用程序中。

本篇文章将上述dropout方法进行了一一分析。

请关注专知公众号(点击上方蓝色专知关注)

后台回复“dropout” 就可以获取《Survey of Dropout Methods for Deep Neural Networks》的下载链接~

【部分文章】

-END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~

专知《深度学习:算法到实战》课程全部完成!530+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程