【机器学习】一文读懂线性回归、岭回归和Lasso回归

,

,

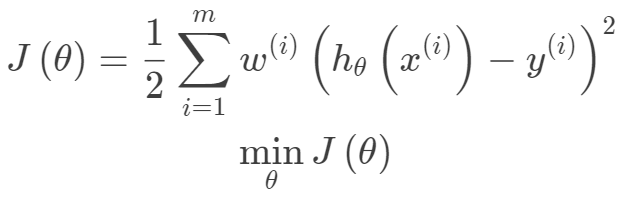

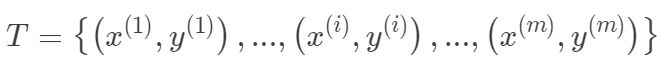

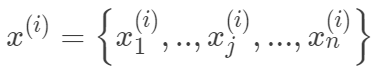

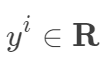

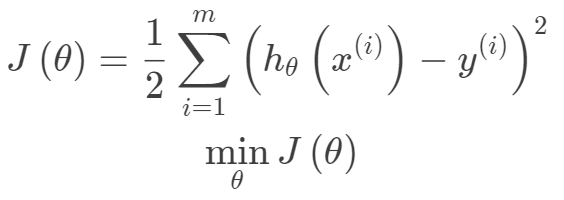

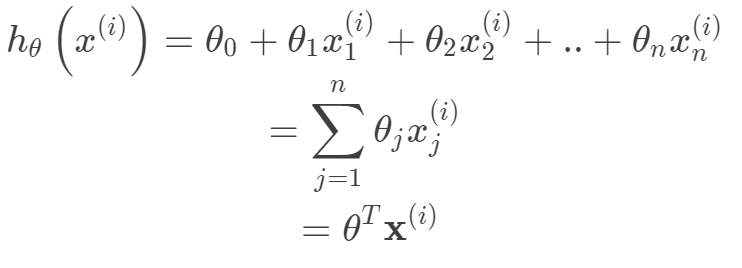

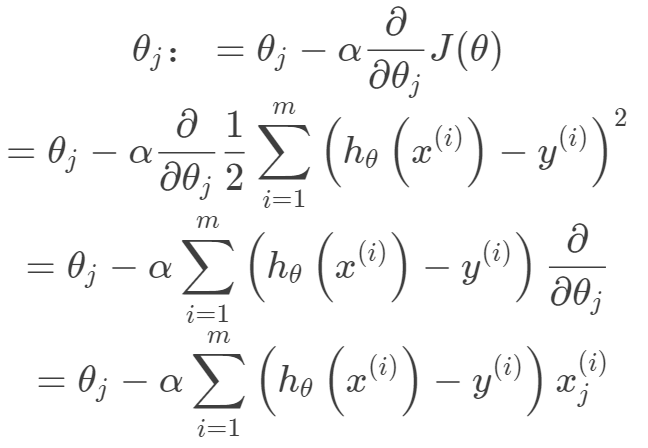

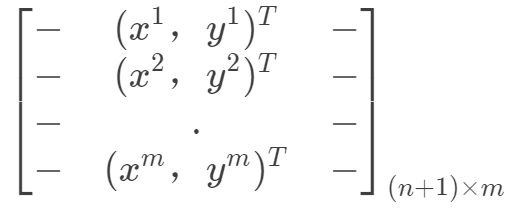

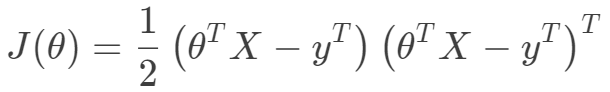

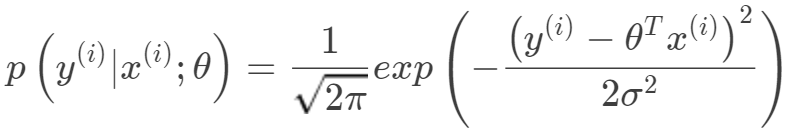

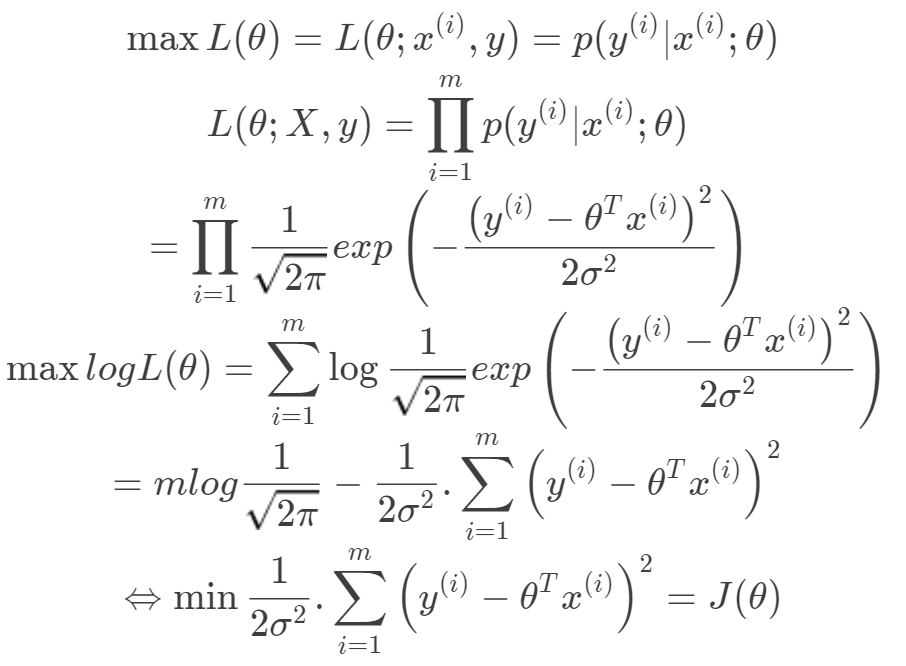

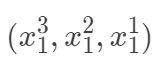

。其中m为训练集样本数,n为样本维度,y是样本的真实值。线性回归采用一个高维的线性函数来尽可能的拟合所有的数据点,最简单的想法就是最小化函数值与真实值误差的平方(概率解释-高斯分布加最大似然估计)。即有如下目标函数:

。其中m为训练集样本数,n为样本维度,y是样本的真实值。线性回归采用一个高维的线性函数来尽可能的拟合所有的数据点,最简单的想法就是最小化函数值与真实值误差的平方(概率解释-高斯分布加最大似然估计)。即有如下目标函数:

,

,

,构成如下数据矩阵。

,构成如下数据矩阵。

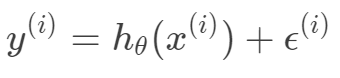

,那么预测值

,那么预测值

与真实值

与真实值

之间有如下关系:

之间有如下关系:

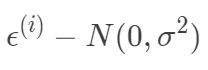

独立同分布均值为0,方差为σ的高斯分布

独立同分布均值为0,方差为σ的高斯分布

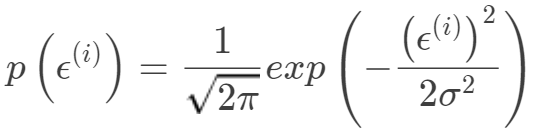

,所以有:

,所以有:

满足以均值为

满足以均值为

,方差为

,方差为

的高斯分布。

的高斯分布。

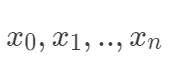

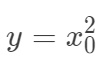

值得注意的是线性模型的表示能力有限,但是并不一定表示线性模型只能处理线性分布的数据。这里有两种常用的线性模型非线性化。对于上面的线性函数的构造,我们可以看出模型在以

,而实际上回归值是

,而实际上回归值是

等,我们同样可以采用线性模型,因为我们完全可以把输入空间映射到高维空间

等,我们同样可以采用线性模型,因为我们完全可以把输入空间映射到高维空间

,其实这也是核方法以及PCA空间变换的一种思想,凡是对输入空间进行线性,非线性的变换,都是把输入空间映射到特征空间的思想,所以只需要把非线性问题转化为线性问题即可。另外一种是局部线性思想,即对每一个样本构建一个加权的线性模型。

,其实这也是核方法以及PCA空间变换的一种思想,凡是对输入空间进行线性,非线性的变换,都是把输入空间映射到特征空间的思想,所以只需要把非线性问题转化为线性问题即可。另外一种是局部线性思想,即对每一个样本构建一个加权的线性模型。

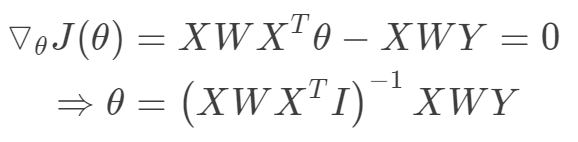

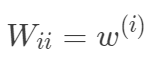

考虑到线性回归的表示能力有限,可能出现欠拟合现象。局部加权线性回归为每一个待预测的点构建一个加权的线性模型。其加权的方式是根据预测点与数据集中点的距离来为数据集中的点赋权重,当某点距离预测点较远时,其权重较小,反之较大。由于这种权重的机制引入使得局部加权线性回归产生了一种局部分段拟合的效果。

由于该方法对于每一个预测点构建一个加权线性模型,都要重新计算与数据集中所有点的距离来确定权重值,进而确定针对该预测点的线性模型,计算成本高,同时为了实现无参估计来计算权重,需要存储整个数据集。

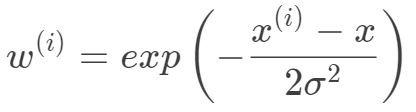

一般选择下面的权重函数,权重函数选择并非因为其类似于高斯函数,而是根据数据分布的特性,但权重函数的选取并不一定依赖于数据特性。

其中

/**

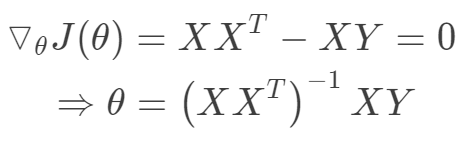

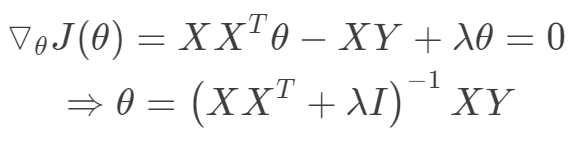

线性回归函数的实现,考虑一般的线性回归,最小平方和作为损失函数,则目标函数是一个无约束的凸二次规划问题,

由凸二次规划问题的极小值在导数为0处取到,且极小值为全局最小值,且有闭式解。根据数学表达式实现矩阵之间的运算求得参数w。

**/

int regression(Matrix x,Matrix y)

{

Matrix xT=x.transposeMatrix();

Matrix xTx=xTx.multsMatrix(xT,x);

Matrix xTx_1=xTx.niMatrix();

Matrix xTx_1xT=xTx_1xT.multsMatrix(xTx_1,xT);

Matrix ws;

ws=ws.multsMatrix(xTx_1xT,y);

cout<<"ws"<<endl;

ws.print();

return 0;

}/**

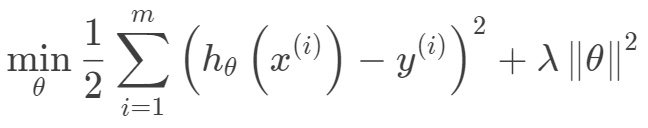

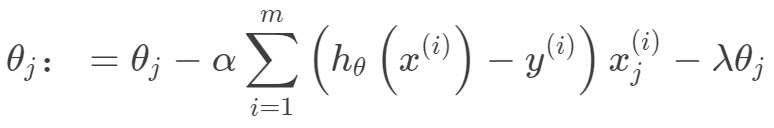

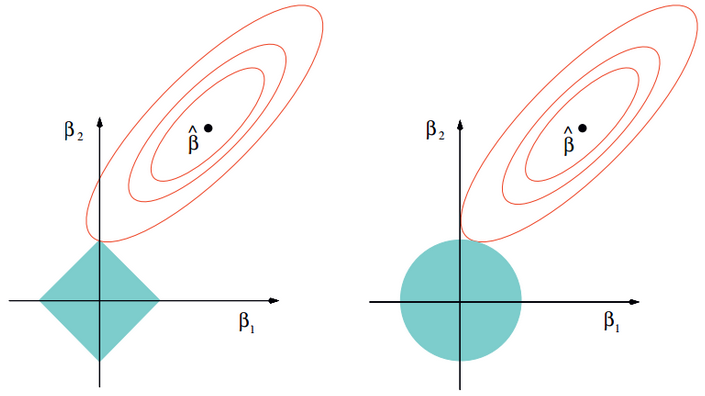

下面的岭回归函数只是在一般的线性回归函数的基础上在对角线上引入了岭的概念,不仅有解决矩阵不可逆的线性,同样也有正则项的目的,

采用常用的二范数就得到了直接引入lam的形式。

**/

int ridgeRegres(Matrix x,Matrix y,double lam)

{

Matrix xT=x.transposeMatrix();

Matrix xTx=xTx.multsMatrix(xT,x);

Matrix denom(xTx.row,xTx.col,lam,"diag");

xTx=xTx.addMatrix(xTx,denom);

Matrix xTx_1=xTx.niMatrix();

Matrix xTx_1xT=xTx_1xT.multsMatrix(xTx_1,xT);

Matrix ws=ws.multsMatrix(xTx_1xT,y);

cout<<"ws"<<endl;

ws.print();

return 0;

}C、局部加权线性回归

/**

局部加权线性回归是在线性回归的基础上对每一个测试样本(训练的时候就是每一个训练样本)在其已有的样本进行一个加权拟合,

权重的确定可以通过一个核来计算,常用的有高斯核(离测试样本越近,权重越大,反之越小),这样对每一个测试样本就得到了不一样的

权重向量,所以最后得出的拟合曲线不再是线性的了,这样就增加的模型的复杂度来更好的拟合非线性数据。

**/

//需要注意的是局部加权线性回归是对每一个样本进行权重计算,所以对于每一个样本都有一个权重w,所以下面的函数只是局部线性回归的一个主要辅助函数

Matrix locWeightLineReg(Matrix test,Matrix x,Matrix y,const double &k)

{

Matrix w(x.row,x.row,0,"T");

double temp=0;

int i,j;

/**

根据测试样本点与整个样本的距离已经选择的核确定局部加权矩阵,采用对角线上为局部加权值

**/

for(i=0;i<x.row;i++)

{

temp=0;

for(j=0;j<x.col;j++)

{

temp+=(test.data[0][j]-x.data[i][j])*(test.data[0][j]-x.data[i][j]);

}

w.data[i][i]=exp(temp/-2.0*k*k);

}

Matrix xT=x.transposeMatrix();

Matrix wx=wx.multsMatrix(w,x);

Matrix xTwx;

xTwx=xTwx.multsMatrix(xT,wx);

Matrix xTwx_1;

xTwx_1=xTwx.niMatrix();

Matrix xTwx_1xT;

xTwx_1xT=xTwx_1xT.multsMatrix(xTwx_1,xT);

Matrix xTwx_1xTw;

xTwx_1xTw=xTwx_1xTw.multsMatrix(xTwx_1xT,w);

Matrix ws = xTwx_1xTw * y;

return ws;

}https://github.com/myazi/myLearn/blob/master/LineReg.cpp

— 完 —

登录查看更多