【谷歌草绘RNN瞄准超级AI】源自壁画的飞跃,AI 学会归纳抽象概念

新智元编译

来源:theatlantic.com

作者:ALEXIS C. MADRIGAL

译者:张易

【新智元导读】人类自从开始在洞穴的岩壁上画出简单的草图,认知能力就产生了飞跃——归纳抽象的能力大大提高。现在,谷歌的 Magenta 项目也在致力于这一研究。名为 SketchRNN 的 AI 系统,能够“以和人类相似的方式归纳抽象的概念”,画出事物的草图。这一方面反映了谷歌尝试理解人类本质特征并用 AI 进行模拟的通用 AI 研究方向,一方面又很可能确实成为 AI 智能飞跃的奠基工作,是“迄今为止最令人兴奋的项目”。

人类自从开始在岩石上作画,认知能力就产生了一个飞跃——现在,计算机也在学着做同样的事情。

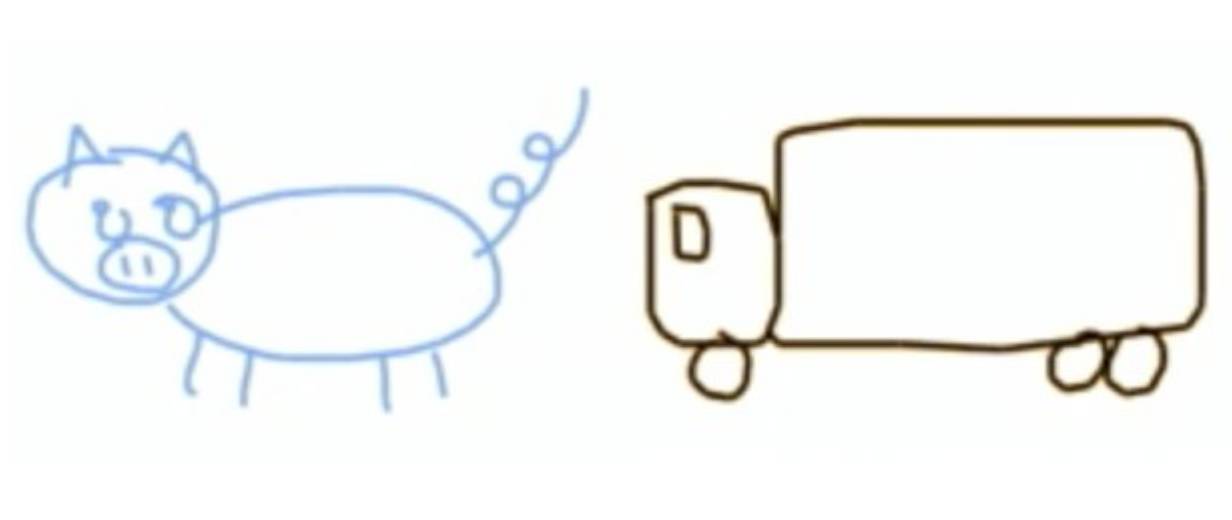

想象一下,有个人让你画一只猪,再画一辆卡车。也许你会这么画:

挺简单。但接着,想象你被要求画一个“猪卡车”。作为一个人类,你会凭直觉去理解如何混合这两种事物的显著特征,最后你可能会画出这么个东西:

瞧它那个小卷猪尾巴,还有眼睛似的圆车窗、分不清是车轮还是蹄子的两个圈。如果这幅画是你画的,我,你的人类同胞,会主观地把它当成是“猪卡车”的绝妙写照。

直到不久前,还只有人类能做出这种概念整合的把戏,但现在不同了。上面那张猪卡车的作者实际上是一个称为 SketchRNN 的 AI 系统,它是谷歌 AI 是否能创造艺术作品的研究项目的一部分。项目被称为“Project Magenta”,由 Doug Eck 牵头。

上周,我在位于山景城的谷歌大脑团队的办公室里拜访了 Eck。Magenta 项目正在那里展开。Eck 智慧、随性、谦和。他 2000 年从印第安那大学拿到了计算机科学的博士学位,此后则从事音乐及机器学习相关的工作。他先是在 AI 的温床——蒙特利尔大学——做教授,之后去了谷歌。一开始在谷歌音乐工作,后来调到了谷歌大脑参与 Magenta 项目的研究。

Eck 一开始开发能够进行艺术创作的 AI 工具还只是一时兴起。“但一番思索之后,”他说:“就变成了‘我们当然该做这个,这真的很重要!’”

如他和谷歌同事 David Ha 所写到的那样, SketchRNN 的意义不仅在于学习如何作画,更在于学习“以和人类相似的方式归纳抽象的概念。”他们不是想创造一台能够画猪的机器。他们想创造的是能够识别和输出“猪的概念”的机器,即使它同时被输入了一些和家畜无关的提示词,比如卡车。

这里有个隐含论据:当人类画画时,他们会对世界进行抽象的概括。他们勾勒出了“猪”的总体概念,而不是任何特定的一只。也就是说,我们的大脑如何存储“猪的概念”和我们如何画猪之间有一个联系。学习如何画猪,也许会学到一些人类抽象综合的能力。

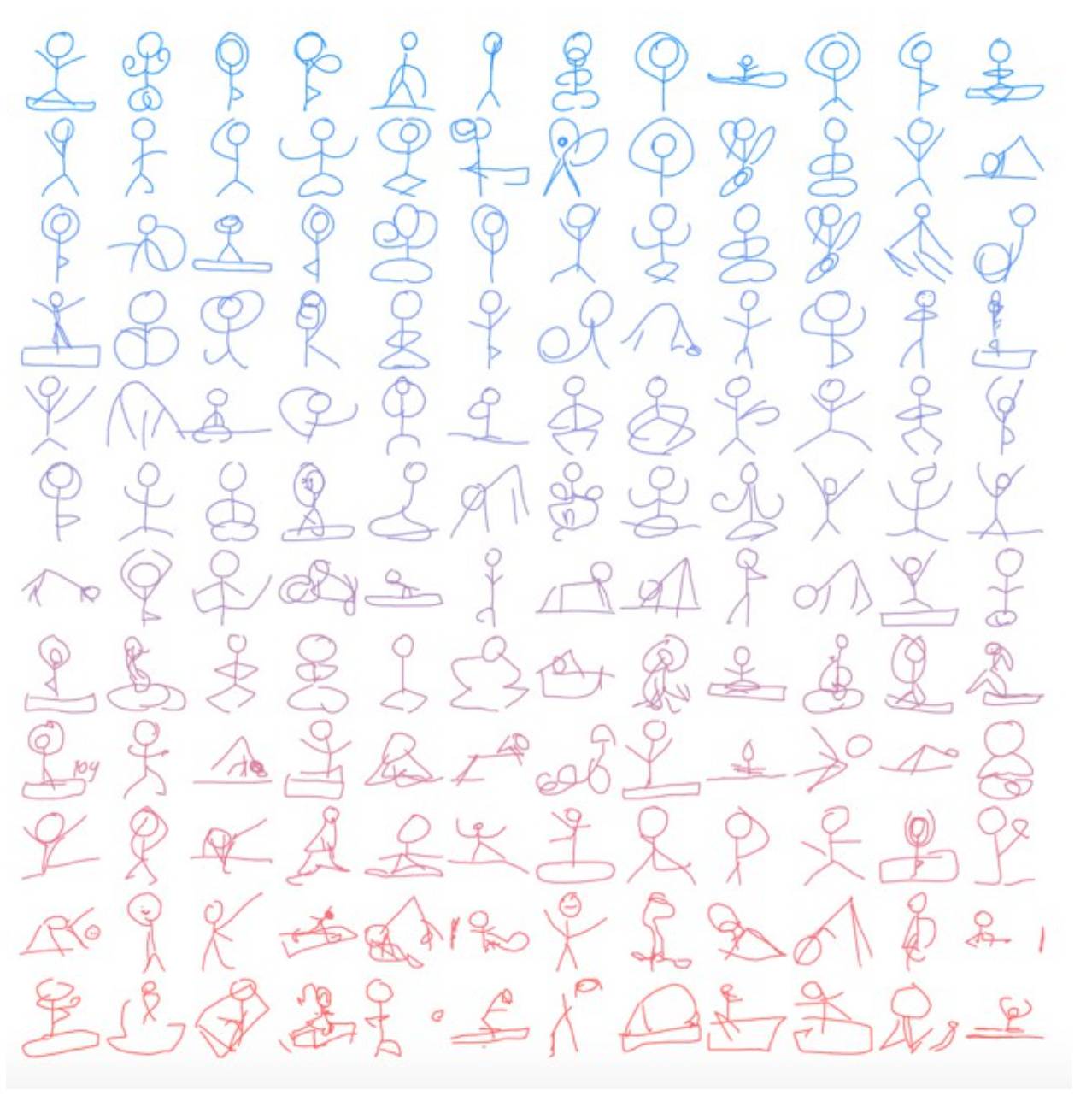

以下是软件的工作原理。谷歌开发了一个名为“快,画!”的游戏,当人们玩的时候,就生成了大量的人造图像数据库,包括猪、雨、消防车、瑜伽体式、花园和猫头鹰。

当我们绘图时,我们会将丰富、多彩、纷繁的世界浓缩成(数字)画笔的几个动作。这些简单的线条是 SketchRNN 的基础数据集。每一类绘画——猫、瑜伽体式、雨,都可使用谷歌开源的 TensorFlow 软件库来训练特定类型的神经网络。这与那些常见于新闻报道的基于图片的工作不同。那些教会机器绘制梵高或者 DeepDream 风格的画作,或画出任意形状并添加猫的特征等的项目,在人类看来,都较为怪诞。他们绘制的作品近似人类的画作,但又不完全符合人类对现实世界的感知。

SketchRNN 输出的作品则完全没有怪诞感。“他们看上去都很像回事”,Eric 跟我讲,“不能说‘非常像人画的’,但是比那些像素生成的图片看起来像回事多了”。

这是Magenta 团队的核心理念。“人类认知世界的方式是将人类所见提炼为抽象的概念,而非像素网络“,Eric 和 Ha 在论文中描述道,”小时候起我们就发展出了通过用铅笔或蜡笔在纸上画图来交流的能力“。

如果人类有这样的能力,谷歌希望机器也能具备这样的能力。去年谷歌CEO Sundar Pichai 提出了“AI First“的目标。AI是谷歌”集成全球范围内的信息并使人人皆可访问并从中受益“这一公司使命的自然延伸。如今的变化是谷歌所集成的信息均围绕着AI,并使人人皆可访问并从中受益。Magenta 就是谷歌收集并尝试理解人类特性的广泛尝试中的一环。

机器学习是谷歌采用的各类工具的概括性的术语。机器学习,常缩写为ML,指的是通过给计算机输入标记过的数据“训练“其学会完成各种任务的计算机编程方式。一种特定的机器学习方式就是使用大致基于人类大脑连接系统建模的神经网络。各种节点(人造神经元)以不同的权重彼此连接。

近年来,多层次的神经网络已经被证明在解决复杂问题方面成效卓著,特别是在翻译和图像识别/处理领域。谷歌已经在这些新架构上重建了许多它的核心服务。通过模拟人类大脑的已知功能,这些神经网络具有识别输入(例如图像)中的不同模式的连接层。低级别层可能包含识别简单特性如明暗的神经元,高级别层则可能够识别如狗脸、汽车或蝴蝶。

使用上述结构和机器构建神经网络极为高效。极其复杂的计算问题简化成为一种模型的调校及训练以及一些图像处理单元的短期计算。如同 Gideon Lewis-Kraus 在纽约时报文章中描述的,谷歌翻译是一个耗时十年构建的复杂系统,然而使用深度学习系统仅用九个月就完成了重建。“ AI 系统一夜之间就取得了原有系统终其使用寿命一生能取得的改善”。

正因如此,神经网络的用法和类型已经爆炸式增长。对于 SketchRNN ,他们使用的是循环神经网络,用于处理输入序列。他们使用一系列人类绘制不同事物时使用的线条来训练神经网络。

描述训练的最简单方法是将其作为一种编码方式。输入数据(草图)后,神经网络尝试在所处理的数据中总结出一些概括性的规则。这些概括性的规则就是数据的模型,被存储在描述网络中神经元特性的数学中。

这种配置被生动地称为潜在空间或 Z 区,猪、卡车或者瑜伽体式的特性都被存储其中。取样则是要求系统绘制出它被训练的内容,SketchRNN 就会绘制出一幅猪、卡车或瑜伽体式的草图。它所画的就是它所学的。

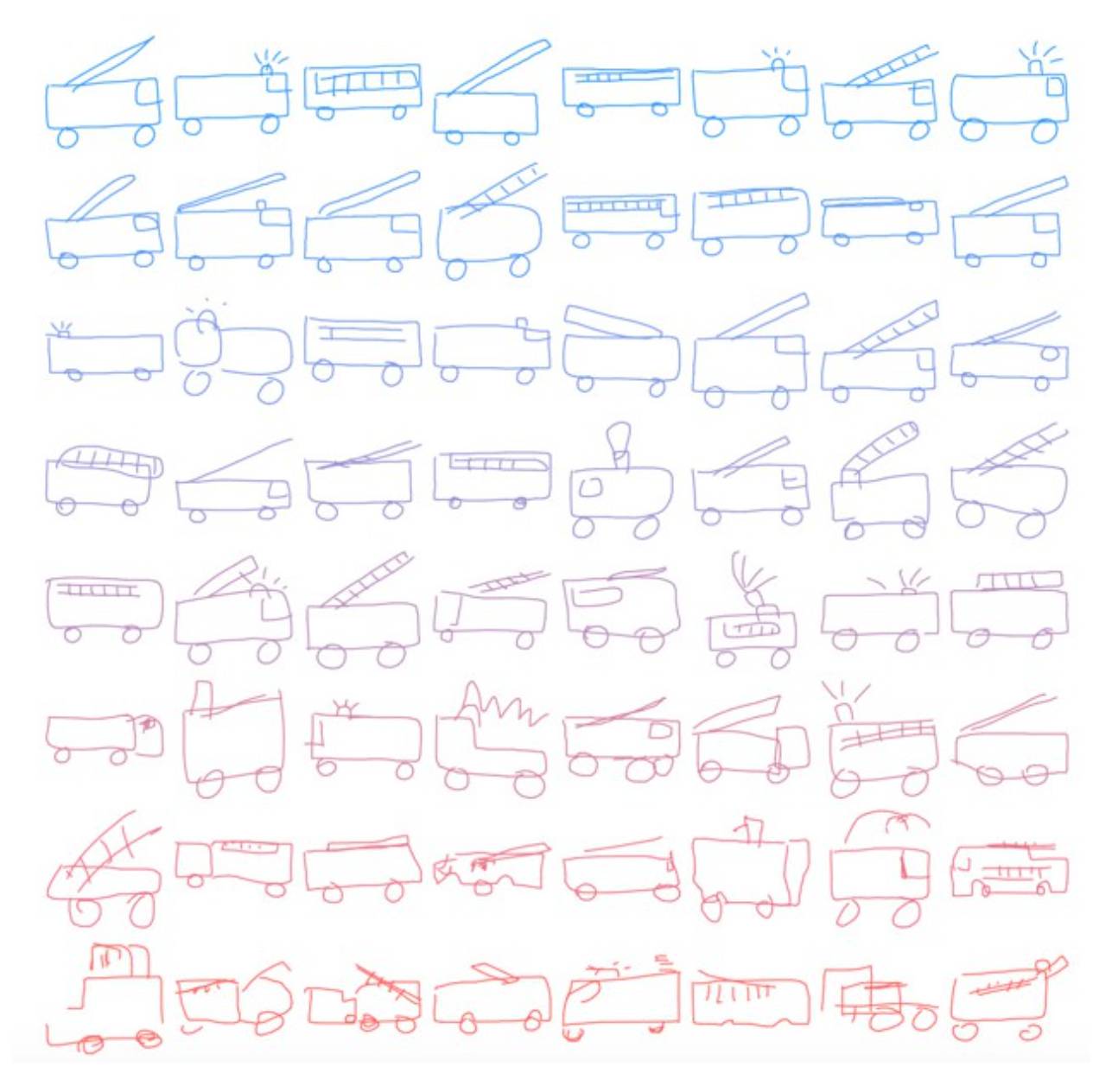

SketchRNN 可以学习什么?以下是训练生成消防车的神经网络。在模型中,有一个名为“温度”的变量,由研究人员将输出的随机性上调或下调。在以下图像中,较蓝的图像温度被调低,较红的图像“更热”。

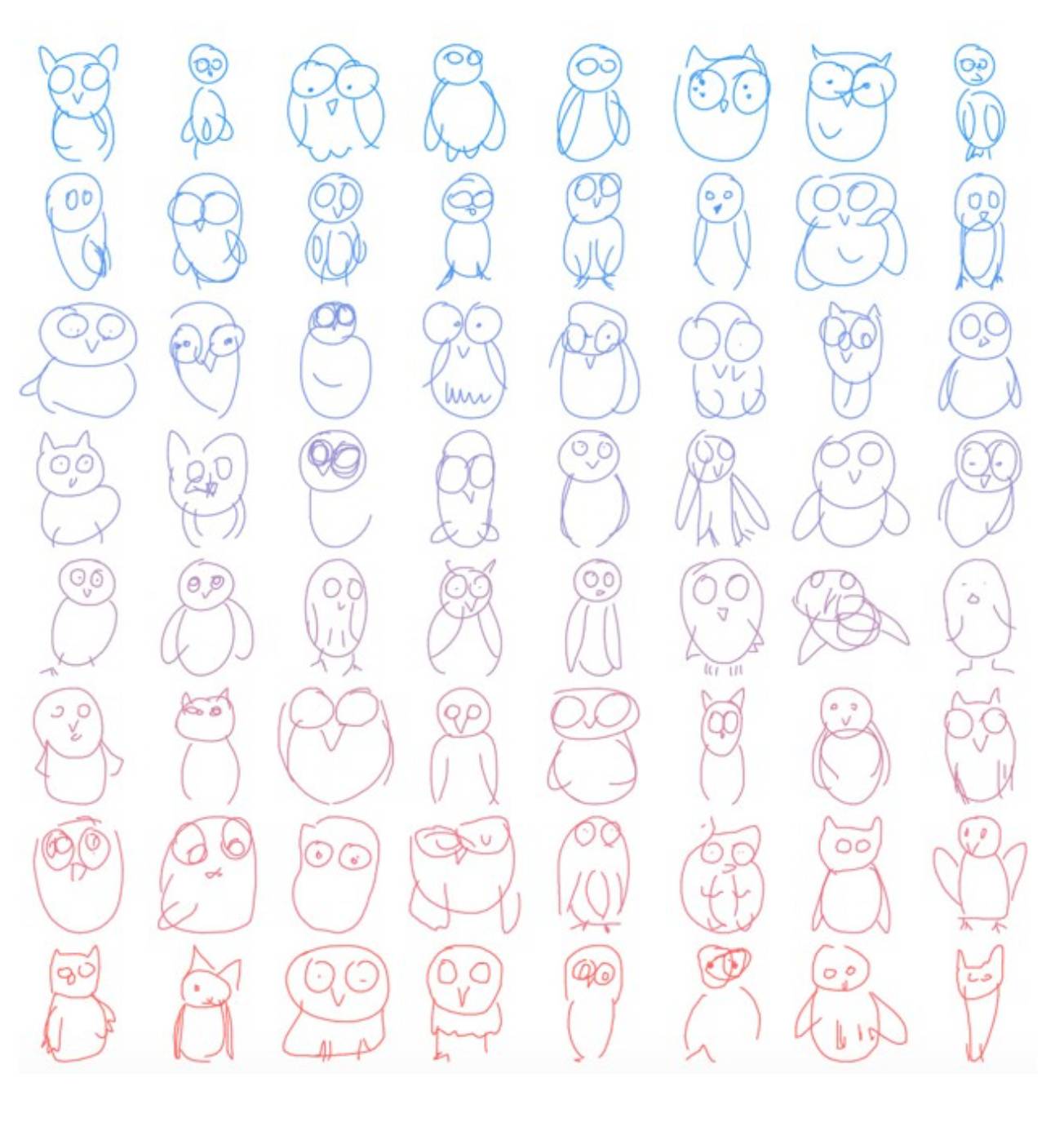

或者也许你想看猫头鹰:

而最好的例子就是瑜伽体式:

现在这些看起来都像人类的画作了,但它们并非人类所画。它们是人类作画这种行为的重建。有些画得不错,有些则不怎么好,但是如果来和 AI 玩看图猜词应该是足够管用了。

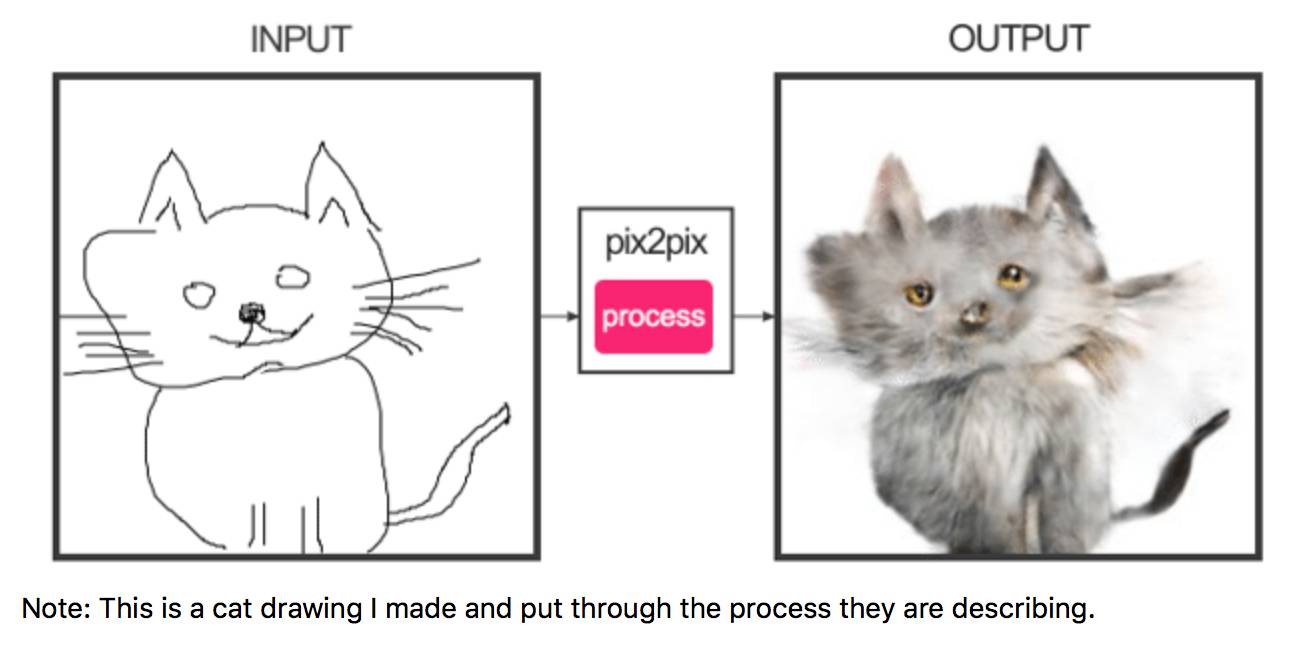

SketchRNN也可以接收人类绘图形式的输入。你输入一些数据,它试图提炼规则。在一个接受猫数据训练的模型工作中,如果输入三只眼睛的猫图片会发生什么呢?

看到了吗?在从模型到右边的各种输出(再次显示不同的“温度”),它去掉第三只眼睛!原因何在?因为模型已经学到,猫有三角形的耳朵,两绺胡须,一个圆形的脸,而且只有两只眼睛。

当然,这个模型并不知道究竟耳朵是什么,猫胡子是否会动,甚至脸是什么,对于人眼会通过光子改变人视网膜特定细胞中的视紫质形状来传输图像至人脑也一无所知。它对所绘制的一切所指为何全无概念。

但它确实对于人们如何认知猫、猪、瑜伽或帆船有所了解。

“当我们开始生成或绘制一幅帆船的图画时,该模型可能会用数百个来自该图的其他帆船的模型进行填充。”谷歌的 Eck 告诉我。“它们对我们来说都有意义,因为这个模型已经从所有这些训练数据中提取出了柏拉图式的帆船——我这么说你可能不太高兴,但这就是‘你的帆船’。这不是一个特定的帆船,而是帆船的概念。”

话一出口,他似乎就后悔他出言自大。“我估计我会招来不少攻击”,他说,“但作为一副草图,已经很像样了”。(大西洋月刊的 Ian Bogost 跟我讲,“从哲学的角度看,这是纯粹的唯物论。”)

作为人工智能运动的一部分,这是迄今为止最令人兴奋的技术项目,至少对身在其中的人来说是这样,其他许多人也有这种感觉。

我的意思是,根据雨的画训练一个网络。然后输入一个蓬松的云的草图,于是,它画出了这个:

雨落到了你输入模型中的云的外面。那是因为很多人画雨时会先画云,然后画从云中落下的场面。所以如果神经网络看到一朵云,它就会让雨从该形状的底部落下。(有趣的是,虽然数据是一系列的线条,但如果你从雨开始,模型就不会产生云)

Eck 认为这些画最有意思的一点是它们只有如此少的信息,却包含了那么多东西。“你画一个笑脸,只用寥寥几笔。”他说。这几笔勾勒和高分辨率的照片表示的脸完全不同,然而3 岁的孩子都可以告诉你它是一张脸,还能看出是幸福还是悲伤。Eck 认为它是某种压缩,一种编码,由 SketchRNN 解码,然后可以随意重新编码。

OpenAI 的研究员 Andrej Karpathy 表示:“我非常支持 SketchRNN 的工作,这真的很酷,它已经成为 AI 研究的关键节点。但他也指出,他们对模型中线条的重要性做了一些非常强烈的假设,这意味着它们对于开发 AI 的全局不太有用。

“我们开发的生成模型通常会尽可能地与数据集的细节无关,而且无论你放入什么数据,都应该可以工作,无论是图像,音频,文本或其他任何内容。”他说,“除了图像,这些都不是由线条组成的。”

他补充说:“他们做出了强烈的假设,把它们编入模型,并在特定领域获得了令人印象深刻的成果,这一点我完全理解。”

Eck 和 Ha 正在建立一个更类似玩国际象棋的 AI,而不是可以弄清和玩任何游戏的 AI。这在Karpathy 看来,这一研究的适用范围似乎有限。

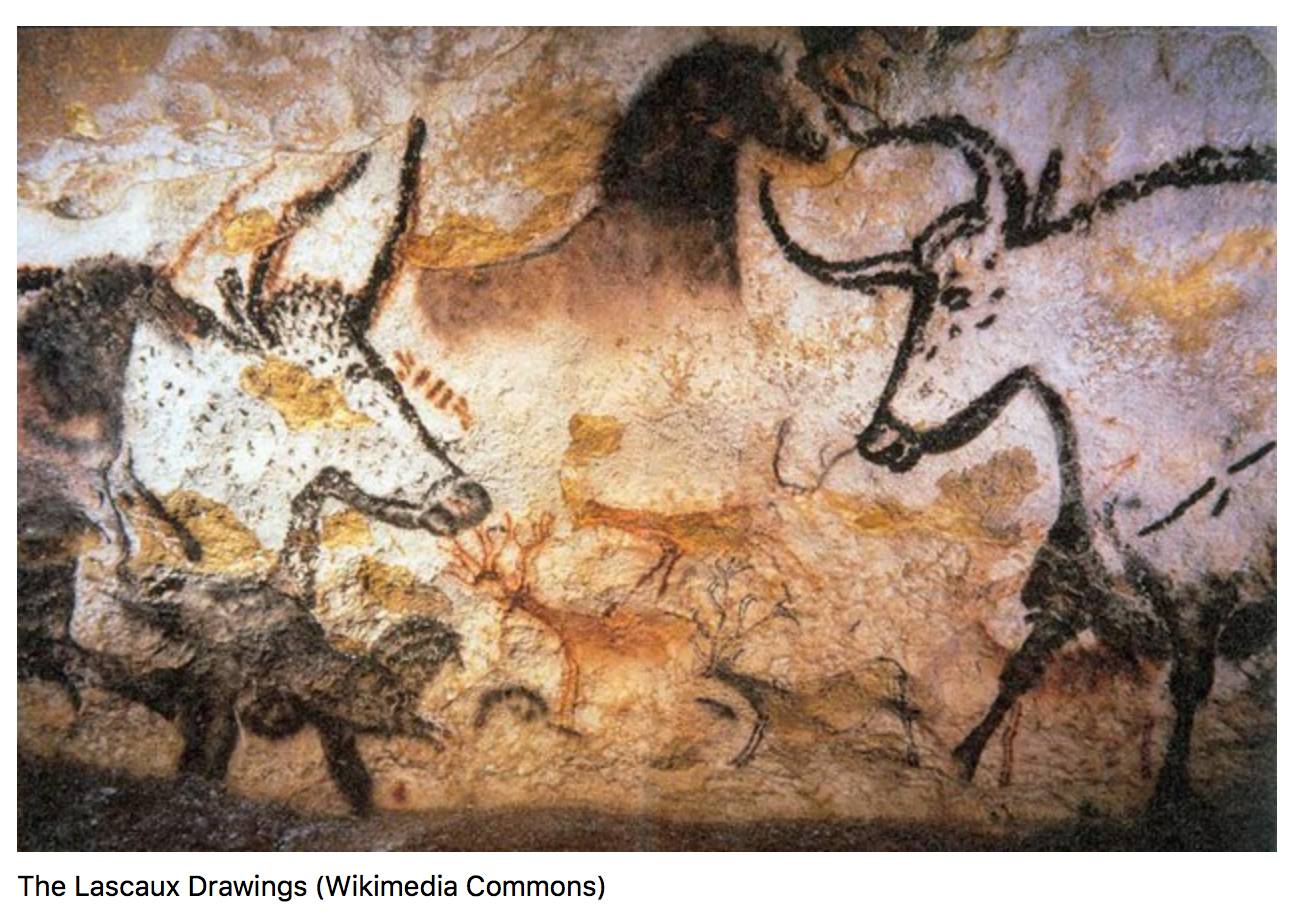

但有理由认为线条绘画是人类思考方式的基础。谷歌员工并不是唯一被草图的力量所吸引的研究人员。2012年,乔治亚理工学院的James Hays 与柏林Technische Universität 的Mathias Eitz 和Marc Alexa 合作,创建了一个草图数据集,以及一个用于识别它们的机器学习系统。

对于他们来说,草图是一种“普遍交流”的形式,所有具有标准认知功能的人都可以做到这一点。他们写道:“自史前时代以来,人们已经以素描般的岩画或洞穴绘画呈现了视觉世界。这样的象形文字比语言出现早了数十万年,今天绘制和识别草图的能力是普遍存在的。”

他们提及了多伦多大学神经科学家Dirk Walther 在“美国科学院论文集”上发表的一篇论文。论文指出,简单抽象的草图会以类似真实刺激的方式激活我们的大脑。Walther 和他的合著者假设这些线条的绘画“捕捉到了我们自然世界的本质”,即使从像素层面看,一条猫的草图看起来也完全不像一只猫的照片。

如果我们大脑中的神经元是以神经网络模仿的分层的方式工作,草图可能是一种方法,可以在特定存储层上提取剥离出的对象概念,也就是Walther 所说的“本质”。也就是说,它们传递了我们的祖先在过去10 万年间的某个时间点上,在演化为现代形式时所产生的新的思考方式。草图,无论是在洞穴墙壁上还是在餐巾纸的背面,可能是从马到马的概念的飞跃,从日常的经历到抽象,符号性的思想,以及在此之上的现代的人。

大多数现代生活源于这一转化:语言,金钱,数学,甚至是计算本身。因此,如果草图最终在创造强人工智能方面发挥重要作用,也毫不奇怪。

不过,当然,对于人类来说,草图是对真实事物的描绘。我们可以很容易地理解那抽象的四条线和事物本身之间的关系。这个概念对我们来说是有意义的。对于SketchRNN,草图是线条的序列,是通过时间形成的形状。机器的任务是提取图纸中描绘的东西的精华,并尝试用它们来了解世界。

SketchRNN团队正在许多方面进行探索。他们可能会建立一个系统,试图通过人类反馈来实现更好的绘画。他们可以用多种草图来训练模型。也许他们会找到一种方式,看他们训练的用于认识猪的概念的模型,能否泛化到逼真的图像上。我很想看到他们的模型中插入其他一些模块,比如已经接受了猫的照片训练的组件。比如使用加州大学伯克利分校创建的神经网络“knows about the textureof cats ”在草图上着色,将让他们在猫的绘画上更加细化。

他们承认,SketchRNN只是“第一步”,还有很多要学习的东西。这些素描解码器发现自己面对的是人类漫长的历史,艺术中反馈的人类历史与技术时代步调并不一致。

纽约客的 Judith Thurman 写道,在欧洲洞穴绘画中,旧石器时代的艺术大多没有变化,“25000 年来几乎没有创新或革新”,她指出:“这已经是有记录的人类历史的四倍”。

一个学者告诉 Thurman,艺术深入人心,文化则更稳定。

计算机,特别是新的 AI 技术,正在破坏人类长久以来擅长的东西。九十年代人类输给了跳棋机,然后是国际象棋,最近则是围棋。

但是,最近的一些 AI 的进展并不是由于最先进技术的进展(尽管其进步速度也非常快)。对于Eck 来说,他们正在努力追寻的是人类如何思考的基石,并延伸到“我们是谁”这一问题。“艺术真正核心的部分是它基本的人性,这也是人类赖以相互沟通的基础。”Eck 对我说。

从深度学习的全局来看,所有人都在致力于研究人类生活的基本机制——我们是如何看的,是如何运动,是如何交谈的,我们如何认识面孔,我们如何将单词构成故事,我们如何玩音乐——这看起来不像在勾勒一个特定的人,而是在描绘人性的轮廓。

现在,这是一个低分辨率的、寥寥数笔的草图,但从草图中,不难看到聚集的智能。

原文地址:https://www.theatlantic.com/technology/archive/2017/06/google-drawing/529473/