Transformer论文引用破4万,两位作者离开谷歌创业

机器之心报道

编辑:张倩

「在谷歌,我们训练出了越来越大的 Transformer,梦想着有朝一日构建一个通用模型来支持所有 ML 用例。 但是,这其中有一个明显的局限: 用文本训练出的模型可以写出很棒的散文,但它们无法在数字世界中采取行动。 你不能要求 GPT-3 给你订机票,给供应商开支票,或者进行科学实验。 」

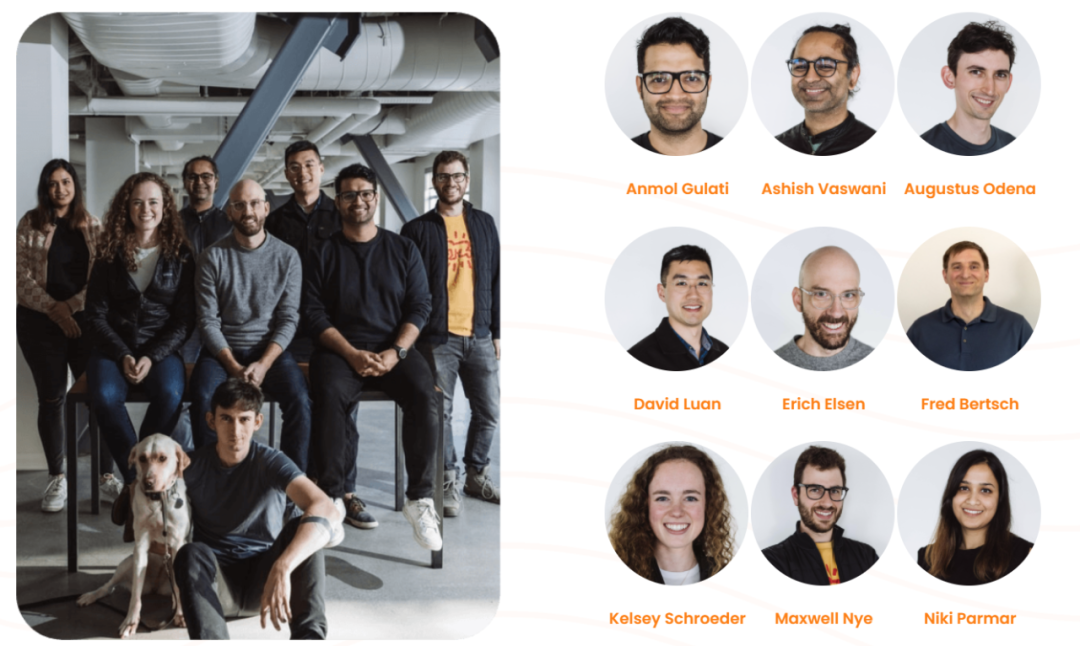

前谷歌大脑研究工程师 Anmol Gulati,他参与了谷歌的大规模语音和语言建模研究;

前谷歌大脑研究科学家 Augustus Odena,他参与构建了谷歌的代码生成模型;

前 OpenAI 加州实验室工程副总裁 David Luan,后来也加入过谷歌大脑,他是 GPT-2、PaLM (https://mp.weixin.qq.com/s/-Annt2JkAhgv9YxYpc7pXQ) 的论文作者之一,还参与了 GPT-3 的部分工作;

在 DeepMind、谷歌大脑、百度都工作过的 Erich Elsen,他是机器学习和高性能计算交叉领域的研究人员,在 DeepMind 参与领导大模型的训练工作,致力于提高训练效率;

前谷歌大脑软件工程师 Fred Bertsch,他是数据和协作人工智能系统方面的专家;

前谷歌 ML 产品经理 Kelsey Schroeder,她曾领导谷歌大模型生产基础设施产品;

曾在谷歌大脑实习的 MIT 博士 Maxwell Nye,他的研究重点是使用深度学习和符号技术来自动编写代码。在谷歌实习期间,他曾使用非常大的语言模型(> 1000 亿个参数)来编写和理解 Python 程序。

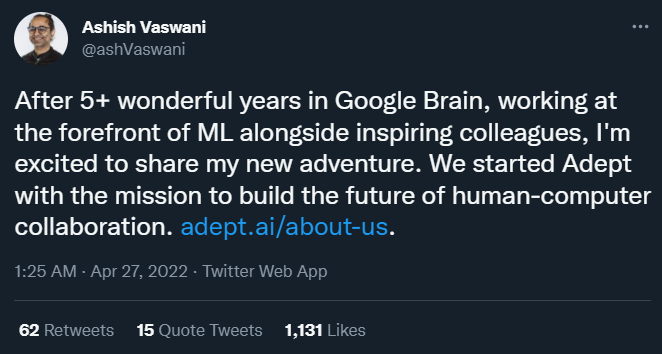

在谷歌,我们训练出了越来越大的 Transformer,梦想着有朝一日构建一个通用模型来支持所有 ML 用例。但是,这其中有一个明显的局限:用文本训练出的模型可以写出很棒的散文,但它们无法在数字世界中采取行动。你不能要求 GPT-3 给你订机票,给供应商开支票,或者进行科学实验。

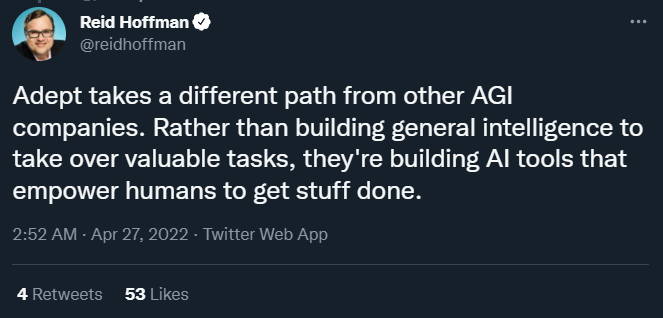

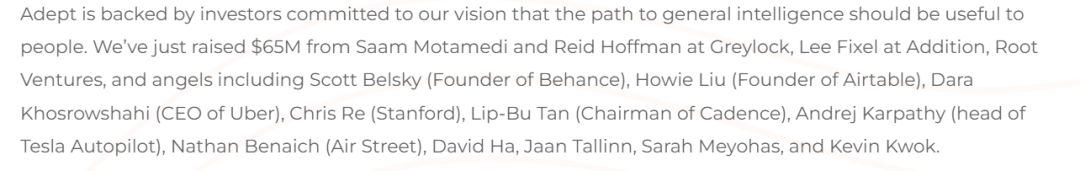

真正的通用智能要求模型不仅能读能写,还能以一种对用户有帮助的方式采取行动。这就是我们创立 Adept 的初衷:我们正在训练一个神经网络来使用世界上的每一款工具和 API,该网络建立在人们已经创造的大量现有能力的基础上。

实际上,我们正在创建一个通用系统,帮助人们在电脑前完成工作,我们管这个系统叫:每个知识工作者的「通用合作者」。你可以把它想象成你电脑里的一个 overlay,它和你一起工作,使用和你一样的工具。

使用 Adept,你能专注于你真正喜欢的工作,并要求模型承担其他任务。例如,你可以要求模型「生成月度合规报告」,所有这些都使用现有的软件,如 Airtable、Photoshop、ATS、Tableau、Twilio。我们希望这个「合作者」是一个好学生,可训练性非常强,非常有帮助。

这一产品愿景让我们兴奋不已,不仅因为它对每个在电脑前工作的人来说都非常有用,还因为我们相信这是实现通用智能最实用、最「安全」的途径。与生成语言或自行决策的大型模型不同,我们的模型范围更窄——我们是现有软件工具的接口,更容易缓解偏见问题。对我们公司来说至关重要的是,我们的产品如何成为一种工具,来了解人们的偏好,并在每一步中整合人类的反馈。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

登录查看更多

相关内容

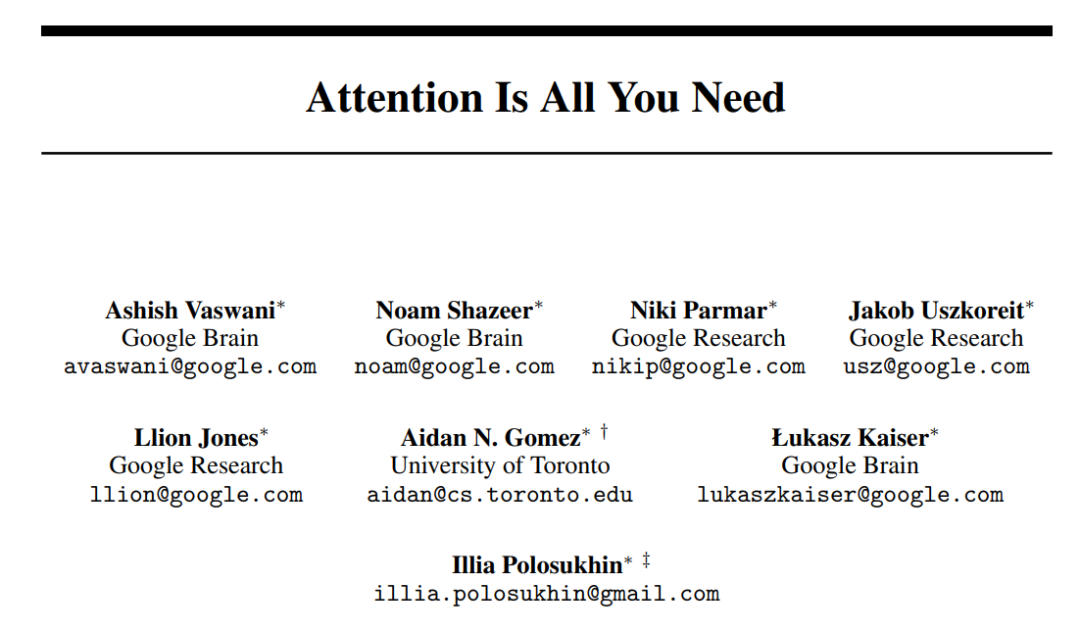

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构

Arxiv

15+阅读 · 2020年5月13日