【CVPR2020-Facebook AI】单样本自适应域脸生成,One-Shot Domain Adaptation

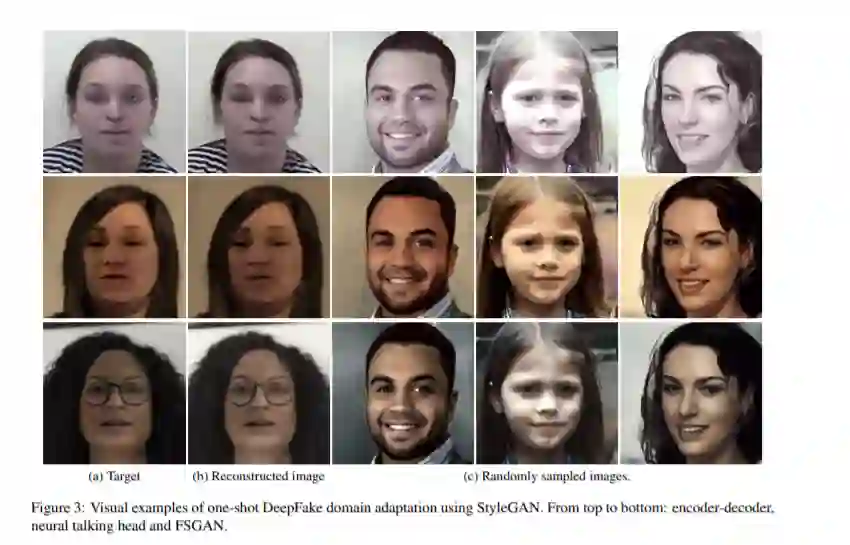

在这篇论文中,我们提出了一个框架,能够生成与给定的一次性样例相同分布的人脸图像。我们利用一个预先训练的StyleGAN模型,它已经学会了一般的面部分布。针对这一一次性目标,我们提出了一种快速调整模型权值的迭代优化方案,以使输出的高阶分布适应目标的高阶分布。为了生成相同分布的图像,我们引入了一种风格混合技术,将低水平的统计信息从目标传输到模型随机生成的人脸。这样,我们就能够生成无限数量的面孔,这些面孔既继承了一般人脸的分布,也继承了一次性人脸的分布。新生成的人脸可以作为其他下游任务的增强训练数据。这样的设置很有吸引力,因为它需要在目标域中标记很少的标记,甚至只需要一个示例,而在现实世界中,人脸操作通常是由各种未知的和独特的分布导致的。结果表明,本文提出的单样本自适应方法是一种有效的人脸操作检测方法,并与其他多镜头自适应方法进行了定性和定量的比较。

https://arxiv.org/abs/2003.12869

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“OSDA” 就可以获取《【CVPR2020-Facebook AI】单样本自适应域脸生成,One-Shot Domain Adaptation》专知下载链接

登录查看更多

相关内容

专知会员服务

78+阅读 · 2020年2月25日