【CVPR2020-加州理工大学Devi Parikh】多任务视觉和语言表示学习

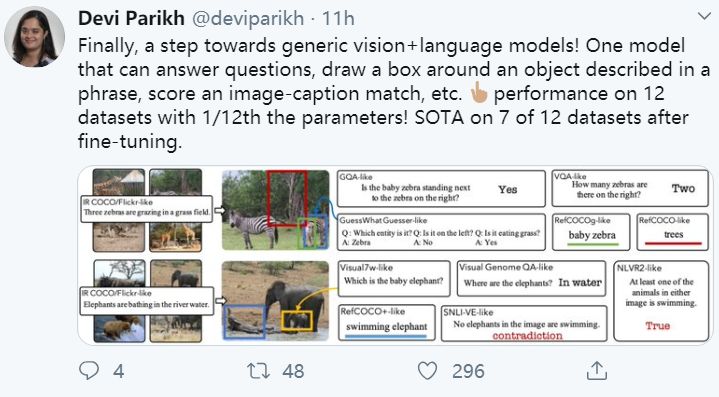

许多视觉和语言的研究集中在一组小而多样的独立任务和支持的数据集上,这些数据集通常是单独研究的;然而,成功完成这些任务所需的视觉语言理解技能有很大的重叠。在这项工作中,我们通过开发一个大规模的、多任务的训练机制来研究视觉和语言任务之间的关系。我们的方法最终在12个数据集上建立了一个模型,这些数据集来自4大类任务,包括可视化问题回答、基于标题的图像检索、基础引用表达式和多模态验证。与独立训练的单任务模型相比,这意味着从大约30亿个参数减少到2.7亿个参数,同时在各个任务中平均提高性能2.05个百分点。我们使用我们的多任务框架来深入分析联合训练不同任务的效果。此外,我们还展示了从单一的多任务模型中细化特定任务模型可以带来进一步的改进,达到或超过最先进的性能。

地址:

https://arxiv.org/abs/1912.02315

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“VLRL” 就可以获取CVPR2020论文《多任务视觉和语言表示学习》专知下载链接

登录查看更多

相关内容

Devi Parikh是佐治亚理工学院交互计算学院的副教授,也是Facebook人工智能研究(FAIR)的研究科学家。她的研究兴趣包括计算机视觉和人工智能,特别是视觉识别问题。她最近的工作包括探索视觉和语言交叉的问题,并利用人机协作来构建更智能的机器。她还研究了其他一些课题,如分类器集成、数据融合、概率模型推理、3D重组、条形码分割、计算摄影、交互式计算机视觉、上下文推理、图像的层次表示和人类调试。

专知会员服务

32+阅读 · 2020年2月21日

专知会员服务

24+阅读 · 2019年12月30日

Arxiv

7+阅读 · 2019年6月14日

Arxiv

6+阅读 · 2018年3月27日