赛尔原创@ACL 2021 | ExCAR: 事理图谱增强的可解释因果推理

论文名称:ExCAR: Event Graph Enhanced Explainable Causal Reasoning 论文作者:杜理,丁效,熊凯,刘挺,秦兵 原创作者:杜理,丁效 转载须标注出处:哈工大SCIR

1.简介

此前的基于文本的因果推理工作主要从事件对中学习因果知识。然而,我们注意到,在因果推理过程中,额外的证据事件亦能起到支撑因果推理,并增强结果的可解释性与稳健性的作用。为此,我们提出了基于事理图谱的可解释因果推理框架ExCAR。给定因果对,ExCAR能够从预先构建的因果知识库中获取一系列因果证据,并利用一个条件马尔可夫神经逻辑网络以推断出结果。实验显示,ExCAR能够有效提升模型因果推理的准确率与稳健性。

2. 动机

因果推理旨在理解事件之间的因果关系。事件间因果关系知识可能在多种人工智能领域内的应用,例如阅读理解 [1] 、问答 [2] 等中发挥重要作用。

此前的工作大多数从预先标注的因果对中学习因果知识 [3] 。尽管在特定数据集上取得了优异性能,然而近期的研究显示,这些模型可能依赖文本中某些仅与标签呈相关关系的统计模式做出预测,而非真正掌握原因与结果之间的因果关系 [4,5,6] 。这使得此类模型的推理结果可解释性差,且稳健性可能较差。

不同于前人仅依赖于因果对的工作,我们注意到,在原因事件与结果事件之间,可能存在一系列证据事件。这些证据事件能够作为额外线索,以帮助模型理解原因与结果之间的因果机制。图 1 (a) 举例说明了两个中间事件 流动性过剩和 : 投资需求增加 如何作为解释,说明事件 量化宽松 逐渐导致事件 房价上涨 的过程。

此外,此类中间事件的缺乏还可能限制模型因果推理的性能。如图 1 (b)所示, 和 之间的因果关系不能从 和 之间的已知因果关系直接推导出来。然而,如果我们已知有中间事件 ,根据因果关系的传递性(Hall等人,2000), 和 的逻辑链则可以自然地从观察到的逻辑链 和 推导出。

为充分利用证据事件在因果推理中的作用,我们提出了一个事理图谱知识增强的因果推理框架ExCAR (Event graph knowledge enhanced explainable CAusal Reasoning)。如图 1 (c)所示,给定一个事件对 ,ExCAR首先从预先构建的大规模因果事理图谱中获取一系列可能的中间证据事件(如 , ),这些证据事件进一步组成了一系列因果规则,如 ,这些因果规则形成了对于因果机制的解释。

Pearl等人 (2001)指出,因果规则应该是或然性的。通过将因果规则概率化,我们将能够更好应对数据中存在的复杂因果模式与可能的噪声。然而,因果叠加效应的存在使得建模因果规则的概率仍为一具有相当挑战的任务。不同于知识图谱等知识库中存在的一阶逻辑规则,因果规则的强度将受到不同的前件影响而产生变化。如图 1 (d) 所示 ,感冒 引起的发烧 极少导致生命危险,然而败血症 引起的发烧将以一较大概率导致生命危险。

针对这一问题,我们进一步提出一个条件马尔可夫神经网络 (Conditional Markov Neural Logic Network, CMNLN)以建模因果规则之间的条件因果强度。具体而言,CMNLN首先将从因果事理图谱中获取的一系列因果规则转化为一系列因果逻辑链条,并得到因果链条的分布式表示。随后,利用一个前件感知的势函数建模规则的条件因果强度,并通过连乘条件因果强度得到每条因果逻辑链的因果强度。最后,通过综合各个逻辑链中包含的因果信息做出预测。

实验结果显示,ExCAR能够有效利用事理图谱知识增强因果推理性能,并增强推理结果的可解释性与稳定性。

3. 背景

3.1 问题定义

本文中所涉及的因果推理问题可以被定义为一个多项选择问题。如下文中例子所示,给定一个前提事件,模型需从两个候选的假设事件中做出选择,使得选出的假设事件能够和前提事件形成因果关系。例子:前提事件: 公司出现了亏损。

-

Ask-for : 原因事件 -

假设 1: 该公司生产的产品收到了广泛欢迎。 -

假设 2: 该公司生产的部分产品存在缺陷。

因此,因果推理问题又可被视作一个预测问题:给定前提事件与某一假设事件组成的因果对 ,模型需输出一个分数衡量该因果对的合理性。

3.2 因果事理图谱

因果事理图谱可以视作一个大型事件间因果关系知识库。因果事理图谱可用一个有向无环图 描述:其中 是节点的集合,每个节点是一个事件; 是边的集合, 表示事件 与事件 之间的因果关系。

利用马尔可夫逻辑网进行基于规则的因果推理

为增强因果推理的稳健性和可解释性,本文将因果推理进一步转化为一个基于规则的推理问题。给定因果对,我们从预先构建的因果事理图谱中获取一系列中间事件,这些中间事件进一步组成一系列因果逻辑规则,例如规则 代表事件 与 之间的因果关系,其中 为代表因果关系的逻辑连接词。

如上文所述,因果逻辑均应为概率逻辑。马尔可夫逻辑网络 (MLN) (Pearl等人,1988) 可以通过为每个因果规则分配一个因果强度来建模这种不确定性。其中因果强度为一概率,衡量因果规则是否成立。令 表示规则 的因果强度。MLN 使用势函数 估计 。此后,MLN通过简单地连乘所有规则的因果强度来预测因果关系分数 :

其中 为一常数。

然而,使用MLN的基于规则的因果推理仍然存在两个挑战:1) 在MLN中,势函数通常为定义为一些手工提取的特征的线性组合;2) MLN 无法模拟规则前件的影响。不同于MLN,本文提出了一个条件马尔可夫神经逻辑网络CMNLN。CMNLN将逻辑规则转化为分布式表示,以对规则的条件因果强度进行建模。

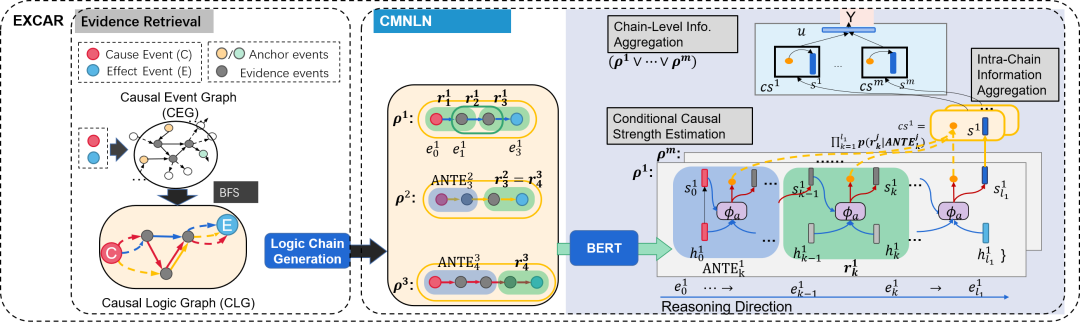

图2 ExCAR框架以及CMNLN模型的结构

4. 方法

如图2 所示,ExCAR框架包含两个主要单元:给定因果对 之后,ExCAR利用一个证据获取模块,从已构建的因果事理图谱中获取一系列证据事件,并进一步形成因果逻辑链条。随后,利用条件神经马尔可夫逻辑网络 (CMNLN),基于以获取的因果逻辑链条进行推理。

4.1 证据事件获取

给定因果对 ,为了从因果事理图谱中获取中间证据事件,我们需要首先在因果事理图谱中定位 与 。为此,我们假设,语义相似的事件应该有类似的原因与结果,并在事理图谱中有类似的位置。为此,我们利用预训练语言模型ELMO [7] 得到因果事理图谱中每个事件,以及 与 的语义表示向量。随后,通过计算向量余弦夹角,找到因果事理图谱中与 或 语义相似的事件,并以这些事件为起点或终点,通过广度优先遍历(BFS),从因果事理图谱中获取一系列中间证据事件。

给定的原因事件 、结果事件 与获取的证据事件进一步形成了一个因果逻辑图 。通过将 作为后续推理过程的输入,因果推理过程能够获得逻辑规则的支持。

4.2 条件马尔可夫神经逻辑网络

概览

条件马尔可夫神经逻辑网络(CMNLN)依赖因果逻辑图中包含的一系列因果逻辑规则进行因果推理。然而,如上文所述,因果叠加效应的存在使得因果规则的因果强度可能随不同的前件而发生变化。其中,一个前件可能是一个事件,某个规则,或者由多个规则组成的复合规则。对于某一因果规则 ,我们将其前件记为 。因此,受前件的影响, 的因果强度可以用一个条件概率 刻画。

如图2所示,在因果逻辑图中,同一条因果规则可能对应多个前件,而每个不同前件可能对该规则造成不同影响。因此,我们将因果逻辑图视作成一系列因果逻辑链条 的组合。这样,对于每一条因果规则 ,我们均能够利用一个前件感知的势函数(antecedent-aware potential function)估计该规则的链特异(chain-specific)的因果强度。通过综合所有逻辑链的因果信息,做出最终预测。

逻辑链生成

如图2所示,任意一条逻辑链 描述了从原因事件 开始,结束与结果事件 的一系列传递性的因果规则。因为每条规则 由两个事件 和 组成,所以一个因果逻辑链 和 规则包含总共 个事件 ,其中 和 分别是原因事件 和结果事件 。分别以 和 作为起点和终点,我们可以使用深度优先搜索算法枚举出因果逻辑图中所有不同的因果逻辑链。

事件表示

我们利用预训练语言模型BERT (Devlin等人,2019) 得到每个事件的逻辑链特异的表示。具体而言,对于包含 个事件 的逻辑链 ,我们首先将其处理成果如下形式:

随后,我们将处理后的事件序列输入BERT,并将每个事件前的[CLS] token 的向量化表示作为该事件的表示。如此,我们得到一系列表示向量 ,其中 是逻辑链 中第 个事件的表示。并且,注意, 是原因事件 的表示, 是结果事件 的表示。

链特异的因果强度学习

给定某一因果链条 以及相应的事件表示 ,CMNLN利用前件感知的势函数得到各个规则的链特异的因果强度。

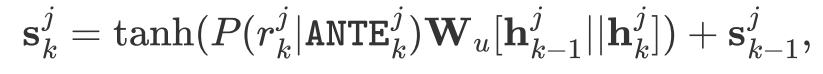

具体而言,对于 中的规则 ,我们首先定义其链特异的前件为 ,并将其记为 。给定 ,我们能够利用前件感知的势函数得到链特异的条件因果强度估计:

因为每条因果规则 由两个事件 和 组成,因此 的输入是 、 和 的分布式表示。我们将 的表示记作 ,并在下文描述如何得到 。

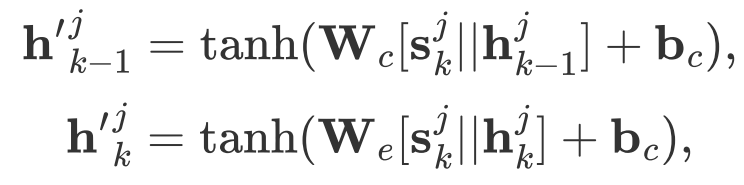

给定 , 和 ,为了建模 对于因果强度的影响,我们首先得到事件 与 的前件感知的表示:

其中 为拼接操作, , 是两个不同的参数矩阵,分别建模 对于 和 的影响。

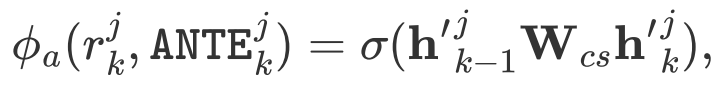

随后,我们利用上下文感知的事件表示 与 ,得到规则 的条件因果强度:

其中 为一参数矩阵, 为sigmoid函数。

前件的分布式表示的计算

在迭代计算条件因果强度的同时,我们亦不断更新前件的表示。具体地,在推理过程的第一步,我们将前件表示 初始化为 。在推理过程的第 步, 我们同时利用第 步的前件表示 、条件因果强度 、以及 中蕴含的两个事件的表示向量,得到第 步对应的前件的表示:

其中 同样为参数矩阵。

链内因果信息的汇总

在得到一条因果逻辑链内每条规则的因果强度后,我们汇集链内的因果信息,以得到这条逻辑链的表示,以及这条逻辑链的因果强度估计。我们注意到,在推理过程中, 实际上包含了 中所有逻辑规则。因此,我们将 的表示作为整条逻辑链 的表示。为清晰起见,我们将其记作 。

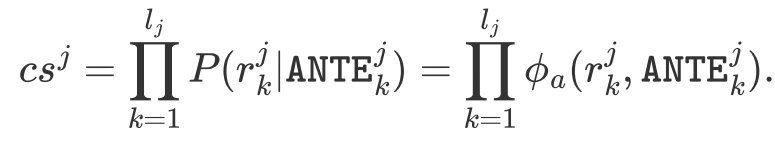

同时,我们通过连乘 中包含的所有因果规则的条件因果强度来得到整条链的因果强度:

随后,我们将逻辑链因果强度做如下归一化:

链间因果信息的汇总

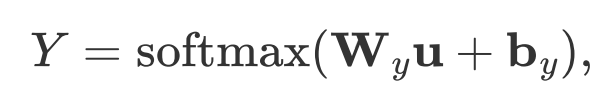

最后,我们通过合取各条逻辑链所蕴含的因果信息来得到对于因果分数的预测。直观上看,若果一条因果链的因果强度越大,则其应该对于因果分数的影响越大。因此,我们利用归一化的链因果强度 ,来对于逻辑链表示 进行线性组合,从而得到链间因果信息的汇总:

其中 可以视作 中包含的因果信息的汇总。

从而,因果分数 可以利用 得到:

其中 和 均为可训练的参数。

4.3 训练过程

训练过程中,为进一步增强因果强度估计的可靠性,我们引入了额外的因果逻辑增强的负采样过程。具体而言,如果因果逻辑图中存在一条规则 ,根据因果逻辑的单向性,我们可以得到一条错误规则 。进一步,从因果逻辑图中,我们还可为错误规则 利用随机采样生成相应的错误前件。理想情况下,模型对于这些错误规则的因果强度估计均应该为0. 此外,通过结合因果的单向性与传递性,还可产生更多模式更丰富的错误规则。例如,如果 ,则可以得到错误规则 。通过采样错误规则,并训练势函数,使得势函数在错误规则上的取值 接近于0,因果强度估计的可靠性将被进一步提升。

其中 和 均为交叉熵损失。 衡量预测的因果分数与真实值的差异; 衡量估计的条件因果强度与真实值的差异。 为一平衡参数。

5. 实验

5.1 因果事理图谱的构建

我们从CausalBank (Li等人,2018) 中收集了大量因果对。经过清洗后,尚余约150万对因果对。因果事理图谱基于这些因果对构建。

5.2 实验设定

给定原因事件或结果事件,我们从因果事件图中找到三个与之最相似的事件,并将它们用作锚点。在证据获取过程中,我们将BFS 的最大搜索深度限制为3,并将证据事件集的大小限制为不超过8。我们采用预训练的 BERT-base 模型作为事件编码器,将每个输入事件编码为 768维向量。在这两个数据集上,对于每个实例,我们采样了5个错误规则以促进条件因果强度的估计。在目标函数中,平衡系数 的值设定为1。

5.3 实验结果

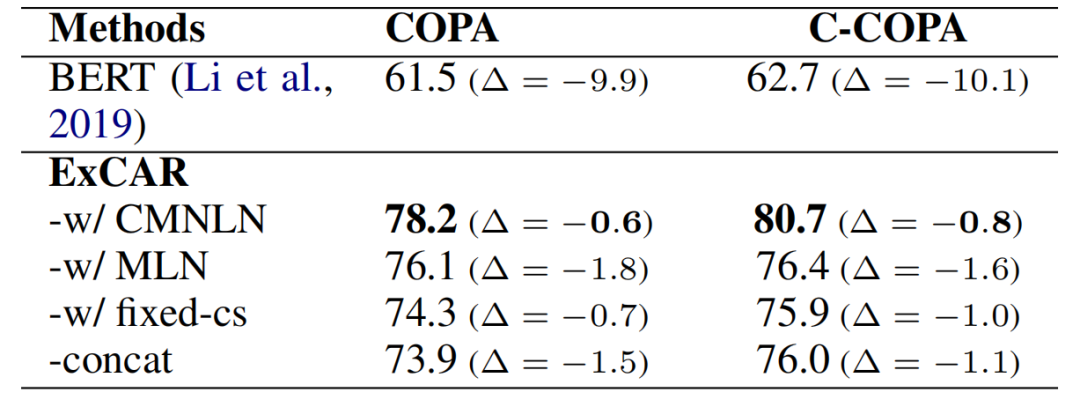

表2 COPA和C-COPA上因果推理的准确率

定量分析

在因果推理数据集COPA和C-COPA上的结果列于表1中。从中我们得出如下结论:

(1) 基于统计的方法CS [3] 和CS_MWP (Sasaki等人, 2017)具有接近于BERT-base的表现。这主要是因为他们从高达 10TB 的大规模语料库中收集了具有精细模式的因果知识。而进一步利用这些因果知识训练BERT可能会进一步的性能增益。这留待以后的工作。

(2) 与基于因果对的BERT相比,基于ExCAR的方法具有更高的准确率。这表明从因果事理图谱中引入额外的证据事件有助于揭示因果决策机制,进而提高因果推理的准确性。

(3) 相比于ExCAR-concat,ExCAR-w/ MLN与ExCAR -w/ CMNLN具有更高的性能。这是因为,ExCAR-concat将因果逻辑图转化为了事件链,从而丢失了结构信息。相比之下,ExCAR-w/ MLN与ExCAR -w/ CMNLN能够利用因果逻辑图中复杂的因果关系模式,以增强推理性能。

(4) 与ExCAR -w/ fixed-cs相比,ExCAR-w/ MLN 和 ExCAR -w/ CMNLN 表现出更高的性能。这说明了将规则神经化以建模规则的不确定性有助于因果推理任务。

(5) 与ExCAR-w/ MLN相比,ExCAR-w/ CMNLN 进一步提高了预测精度。这表明通过利用前件感知的势函数,CMNLN 能够对逻辑规则的条件因果强度进行建模。

结果的稳定性分析

表2 对抗攻击后的因果推理准确率

本文中,我们希望通过引入额外的证据事件以增强推理结果稳定性。为探究额外的证据信息对于推理系统的稳定性的影响,我们引入了对抗分析。类似于Bekoulis等人 [8] ,我们通过在输入的词嵌入上添加微小扰动项来攻击推理系统。扰动项采用基于梯度的方法 FGM [9] 得到。

表2 显示了对抗攻击后的预测准确率,其中 表示对抗攻击带来的性能变化。例如, = -9.9 表示对抗攻击后预测准确度下降 9.9%。相比于基于事件对的BERT,ExCAR 可以显着提高预测精度的稳定性。这些结果显示,ExCAR可以通过引入额外的证据事件,揭示背后的因果机制,从而提升预测结果的稳定性。

6. 总结

本节中,我们提出了一个可解释的因果推理框架ExCAR。给定一个因果事件对,ExCAR能够从预先构建的因果事理图谱中获取一系列逻辑规则,以促进对于因果决策机制的更多理解。此外,为建模因果逻辑规则的条件因果强度,我们提出了一个结合神经模型与符号逻辑的条件神经马尔可夫逻辑网络。实验显示,ExCAR能够有效提高因果推理的准确率、稳定性以及可解释性。

参考文献

[1] Oh J H, Torisawa K, Hashimoto C, et al. Why-question answering using intra-and inter-sentential causal relations. ACL 2013.

[2] Sun Y, Cheng G, Qu Y. Reading comprehension with graph-based temporal-casual reasoning. Proceedings of the 27th International Conference on Computational Linguistics. 2018: 806-817.

[3] Luo Z, Sha Y, Zhu K Q, et al. Commonsense causal reasoning between short texts. Fifteenth International Conference on the Principles of Knowledge Representation and Reasoning. 2016.

[4] McCoy R T, Pavlick E, Linzen T. Right for the wrong reasons: Diagnosing syntactic heuristics in natural language inference. arXiv preprint arXiv:1902.01007, 2019.

[5] Poliak A, Haldar A, Rudinger R, et al. Collecting diverse natural language inference problems for sentence representation evaluation. arXiv preprint arXiv:1804.08207, 2018.

[6] Gururangan S, Swayamdipta S, Levy O, et al. Annotation artifacts in natural language inference data. arXiv preprint arXiv:1803.02324, 2018.

[7] Peters M E, Neumann M, Iyyer M, et al. Deep contextualized word representations. Proceedings of NAACL-HLT. 2018: 2227-2237.

[8] Bekoulis G, Deleu J, Demeester T, et al. Adversarial training for multi-context joint entity and relation extraction. arXiv preprint arXiv:1808.06876, 2018.

[9] Miyato T, Dai A M, Goodfellow I. Adversarial training methods for semi-supervised text classification. arXiv preprint arXiv:1605.07725, 2016.

本期责任编辑:丁 效

理解语言,认知社会

以中文技术,助民族复兴