DeepMind重磅论文:不用人类标记,几张图片就能渲染出3D场景

编者按:今天,DeepMind的研究人员在Science上发表论文,推出了一种新的神经网络——GQN,只用几张二维照片,就能重建全部的三维场景,可以说是计算机视觉领域的又一关键突破。

让机器对空间环境进行感知似乎一直是DeepMind研究的重点,一个多月前我们曾报道过他们的另一项研究:DeepMind用AI解密大脑:当你找路时,大脑发生了什么。空间感知对人类来说很简单,例如当我们第一次走进一个房间,扫一眼就能知道屋里有哪些物品、它们都在哪个位置上。只看到桌子的三条腿,你也能推断出第四条腿的大致位置和形状。另外,即使你没有熟悉屋里的每个角落,也能大概描绘出它的平面图,或者能想象出从另一个角度看房间应该是什么样子的。

但是想让人工智能系统做到上述行为的确很困难。现在最先进的计算机视觉系统仍需要在大型经过标注的数据集上进行训练,而数据标注又是一项费时费力的工作,所以每次模型只能捕捉一小部分场景。随着网络越来越复杂,想详细了解的周围环境也越复杂:最近的座位在哪?沙发是什么材质的?所有影子的光源在哪?照明开关可能在哪?

在这次的研究中,DeepMind研究人员介绍了一种能感知周围环境的框架——GQN(Generative Query Network)。和婴儿或动物一样,GQN通过观察周围环境收集数据,从而学习,无需人类对场景进行标记,就能掌握大致空间结构。

GQN模型由两部分组成:一个表示网络和一个生成网络。表示网络将智能体所观察到的画面作为输入,生成一个表示(向量),描述了基本场景。之后,生成网络从此前没有观察到的角度对场景进行预测(或者说是“想象”)。

戳视频观看GQN原理解读

但是表示网络并不知道生成网络要从哪个视角预测场景,所以它必须找到一种高效、精确的描绘场景平面的方法。它通过捕捉最重要的元素,例如物体的位置、颜色和房间平面,进行简单表示。训练期间,生成器学习辨认物体、特征、关系和环境的规律。这一套“共享”的概念让表示网络能用一种高度简练、抽象的方式描绘场景,剩余的细节部分就由生成网络补充。例如,表示网络用一小串数字表示一个“蓝色方块”,生成网络就知道从某个角度应该如何用像素展现出来。

DeepMind研究人员在程序生成的虚拟3D环境中对GQN做了多次试验,包括多种不同物体,被摆放在不同的位置,并且形状、颜色、材质都不相同,同时还改变了光线方向和遮挡程度。通过在这些环境上进行训练,他们用GQN的表示网络去生成一个从未见过的场景。在实验中人们发现GQN展现出了几个重要特征:

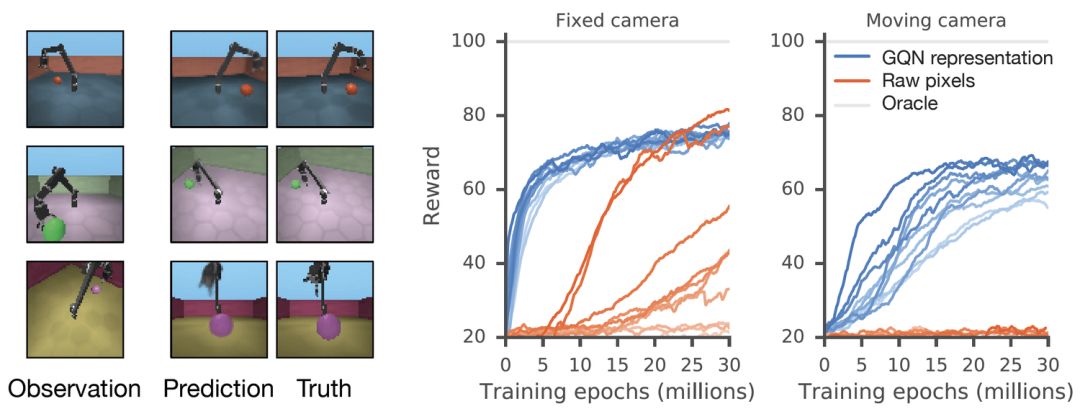

GQN的生成网络可以在全新视角“想象”出此前没有见过的景象,精确度非常高。给定一个场景表示和新的相机角度,网络不需要任何先前信息就能生成精确的图像。所以生成网络也可以近似看成是从数据中学习的渲染器:

GQN的表示网络可以独自学习算数、定位、分类物体。就算在小型表示上,GQN也能在具体视角上做出非常精准的预测,和现实几乎一模一样。这说明了表示网络观察得非常仔细,例如下面这个由几个方块堆叠起来的场景:

GQN可以表示、测量并且减少不确定性。即使在没有完全看到所有场景的情况下,网络也可以解释其中的不确定之处。同时也能根据部分图像拼成完整的场景。下面的第一人称视角和自上而下的预测方法就是其中的“秘诀”。模型通过它预测的变化性表达不确定性,其中预测的变化性随着不断在迷宫中移动减少(灰色三角是观察位置)。

GQN表示支持稳定、数据高效的强化学习。给定GQN表示后,目前顶尖的深度强化学习智能体就开始学习以数据有效的方式完成任务。对这些智能体来说,生成网络中编入的信息可以看作是对环境固有的认知:

利用GQN我们观察到了更多数据有效的学习,比通常只利用原始像素的方法快了近4倍达到收敛水平

相较于前人研究,GQN是一种全新的学习现实场景的简单方法。重要的是,这种方法不需要对具体场景建模,或者花大量时间对内容标注,一个模型就能应用多个场景。它还学习了一种强大的神经渲染器,能够在任意角度生成精确的场景图像。

不过,与一些传统计算机视觉技术相比,这次所提出的方法仍然有很多限制,并且目前也都是在虚拟的合成场景上训练的。不过,随着更多可用数据的出现以及硬件的提升,研究人员希望进一步套索GQN的可能性,比如将它应用到现实场景中,同时提高成像分辨率。未来,研究GQN对更广泛的场景理解非常重要,例如加入时间的维度,让它学习对场景和移动的理解,同时应用到VR和AR技术中。尽管前路漫漫,这项工作对全自动场景辨别来说是重要一步。

DeepMind博客地址:deepmind.com/blog/neural-scene-representation-and-rendering/

论文地址:science.sciencemag.org/content/360/6394/1204