牛!何恺明包揽2项ICCV 2017最佳论文奖!这位高考状元告诉你什么是开挂的人生

大神终究是大神!

刚刚,AI 科技大本营获悉,继两次荣获 CVPR 最佳论文奖之后,何恺明参与的两篇最新论文又分别摘下 ICCV 2017 的最佳论文奖(Best Paper Award)和最佳学生论文(Best Student Paper Award)两项大奖。

论文简介:我们提出了一个简单、灵活和通用的对象实例分割框架。我们的方法能有效检测图像中的对象,同时为每个实例生成高质量的 segmentation mask。这种被称为 Mask R-CNN 的方法通过添加用于预测 object mask 的分支来扩展 Faster R-CNN,该分支与用于边界框识别的现有分支并行。Mask R-CNN 训练简单,只需在以 5fps 运行的 Faster R-CNN 之上增加一个较小的 overhead。此外,Mask R-CNN 很容易推广到其他任务,例如它可以允许同一个框架中进行姿态估计。我们在 COCO 系列挑战的三个轨道任务中均取得了最佳成果,包括实例分割、边界对象检测和人关键点检测。没有任何 tricks,Mask R-CNN 的表现优于所有现有的单一模型取得的成绩,包括 COCO 2016 挑战赛的冠军。

论文地址:

https://arxiv.org/abs/1703.06870

论文简介:目前准确度最高的目标检测器采用的是一种常在 R-CNN 中使用的 two-stage 方法,这种方法将分类器应用于一个由候选目标位置组成的稀疏样本集。相反,one-stage 检测器则应用于一个由可能目标位置组成的规则密集样本集,而且更快更简单,但是准确度却落后于 two-stage 检测器。在本文中,我们探讨了造成这种现象的原因。

我们发现,在训练密集目标检测器的过程中出现的严重的 foreground-background 类别失衡,是造成这种现象的主要成因。我们解决这种类别失衡(class imbalance )的方案是,重塑标准交叉熵损失,使其减少分类清晰的样本的损失的权重。Focal Loss 将训练集中在一个稀疏的困难样本集上,并防止大量简单负样本在训练的过程中淹没检测器。为了评估该损失的有效性,我们设计并训练了一个简单的密集目标检测器—RetinaNet。试验结果证明,当使用 Focal Loss训练时,RetinaNet 不仅能赶上 one-stage 检测器的检测速度,而且还在准确度上超越了当前所有最先进的 two-stage 检测器。

2009 年,在 IEEE 举办的 CVPR 大会上,还在微软亚研院(MSRA)实习的何恺明的第一篇论文“Single Image Haze Removal Using Dark Channel Prior”艳惊四座,获最佳论文,这是第一次完全由中国人组成的团队获得该奖项。

2016年,何恺明所在团队的另一篇论文“Deep Residual Learning for Image Recognition”再获 CVPR 最佳论文奖。

各位读者有什么感想?欢迎在评论区留言。

SDCC 2017

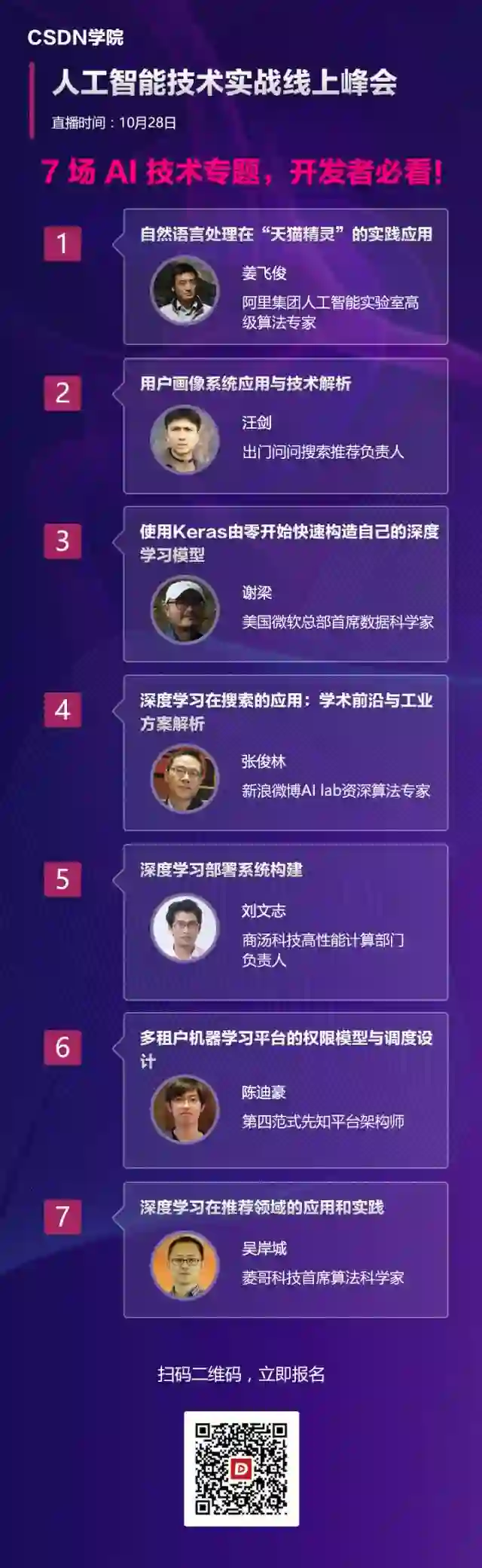

10 月 28 日(本周六),SDCC 2017“人工智能技术实战线上峰会”将在CSDN学院以直播互动的方式举行。

作为SDCC系列技术峰会的一部分,来自阿里巴巴、微软、商汤科技、第四范式、微博、出门问问、菱歌科技的AI专家,将针对机器学习平台、系统架构、对话机器人、芯片、推荐系统、Keras、分布式系统、NLP等热点话题进行分享。

先行者们正在关注哪些关键技术?如何从理论跨越到企业创新实践?你将从本次峰会找到答案。每个演讲时段均设有答疑交流环节,与会者和讲师可零距离互动。

☞ 点击阅读原文,查看峰会详情