ICML 2022开奖!复旦、上交、厦大多篇工作入选杰出论文

新智元报道

新智元报道

【新智元导读】ICML 2022杰出论文揭晓!复旦、上交、厦大等中国高校上榜,吴恩达、Jeff Dean等获时间检验奖荣誉提名。|还在纠结会不会错过元宇宙和web3浪潮?清华大学科学史系副教授胡翌霖,这次给你讲个透!

杰出论文(Outstanding Papers)

Monarch: Expressive Structured Matrices for Efficient and Accurate Training

Solving Stackelberg Prediction Game with Least Squares Loss via Spherically Constrained Least Squares Reformulation

Adversarially Trained Actor Critic for Offline Reinforcement Learning

Stable Conformal Prediction Sets

Do Differentiable Simulators Give Better Policy Gradients?

Learning inverse folding from millions of predicted structures

Learning Mixtures of Linear Dynamical Systems

Causal Conceptions of Fairness and their Consequences

Active fairness auditing

Understanding Dataset Difficulty with V-Usable Information

G-Mixup: Graph Data Augmentation for Graph Classification

The Importance of Non-Markovianity in Maximum State Entropy Exploration

Minimum Cost Intervention Design for Causal Effect Identification

Privacy for Free: How does Dataset Condensation Help Privacy?

Bayesian Model Selection, the Marginal Likelihood, and Generalization

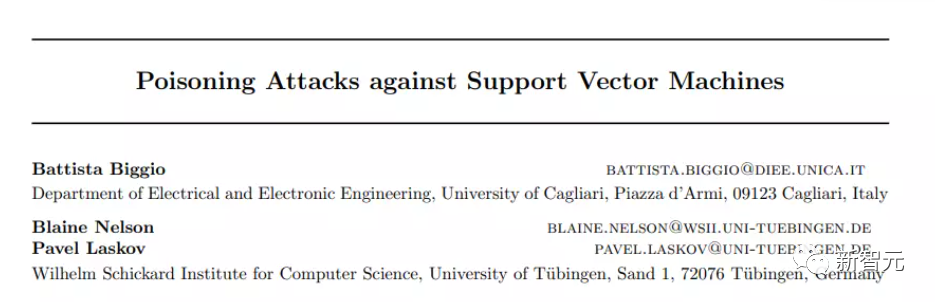

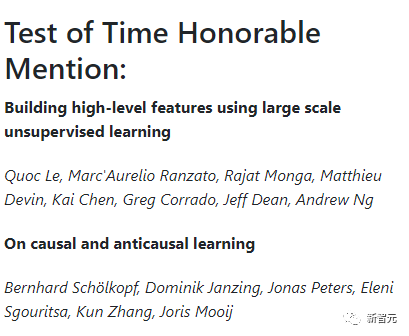

Test of Time Award (时间检验奖)

本届时间检验奖授予了十年前ICML的一篇论文,该论文对机器学习领域产生了实质性影响,包括研究和实践。

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年9月19日

Arxiv

0+阅读 · 2022年9月15日

Arxiv

17+阅读 · 2019年9月9日