在第 15 届 ACM 国际互联网搜索与数据挖掘大会(WSDM 2022)上,来自清华、人大和中科院计算所的研究者获得了最佳论文奖,时间检验奖花落推荐系统。

![]()

2 月 21 日至 25 日,第 15 届 ACM 国际互联网搜索与数据挖掘大会(The 15th International Conference on Web Search and Data Mining,WSDM 2022)在线上召开。

作为数据库 / 数据挖掘类的主要会议之一,WSDM 是由 ACM 所属的信息检索(SIGIR)、数据挖掘(SIGKDD)、数据库(SIGMOD)和网络信息处理(SIGWEB)四个专委会协调筹办。该会议主要发表与网络或社交网络搜索和数据挖掘相关的高质量原创论文,重点关注实用的搜索和数据挖掘新模型、算法设计和分析、经济影响以及对准确率和性能的深入实验分析。

本届 WSDM 会议共接收了 790 篇长文投稿,最终录用了 160 篇,录用率约为 20%。近日,WSDM 2022 公布了最佳论文奖和最佳论文奖亚军,其中来自清华、人大和中科院计算所的研究者获得了大会唯一的最佳论文奖。

![]()

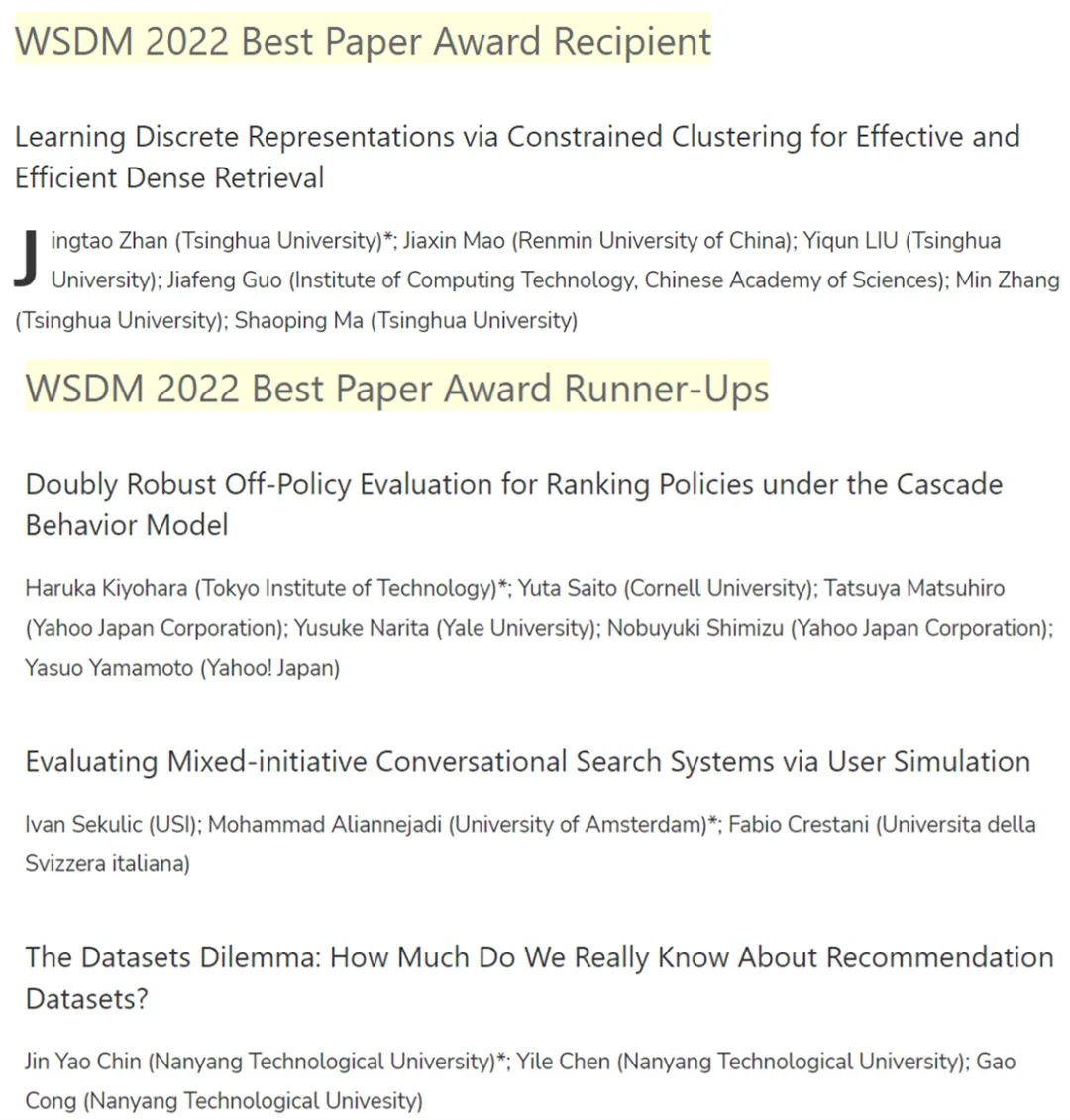

WSDM 2022 的最佳论文奖首次授予了清华大学、人大、中科院计算所等中国科研机构研究者合作完成的论文《Learning Discrete Representations via Constrained Clustering for Effective and Efficient Dense Retrieval》。

![]()

密集检索(DR)已经实现了 SOTA 排序效果。然而,大多数现有 DR 模型的效率受到一些限制,特别是存储密集向量需要大量内存成本,并且在向量空间中做最近邻搜索(NNS)非常耗时。因此,该研究提出了一种新型检索模型 RepCONC,通过约束聚类(CONstrained Clustering)学习离散表征。

RepCONC 联合训练双编码器和乘积量化(PQ)方法来学习离散文档表征,并实现具有紧凑索引的快速近似 NNS。它将量化建模为一个受约束的聚类过程,这要求文档嵌入围绕量化质心均匀聚类,并支持量化方法和双编码器的端到端优化。

该研究从理论上证明了 RepCONC 中均匀聚类约束的重要性,并通过将其简化为最优传输问题的一个实例,为约束聚类导出了一个有效的近似解。除了约束聚类,RepCONC 进一步采用基于向量的倒排文件系统 (IVF) 来支持 CPU 上的高效向量搜索。对两个流行的 ad-hoc 检索基准进行的大量实验表明,在多种压缩比设置下,RepCONC 比其他向量量化基准实现了更好的排序效果,它在检索效率、记忆效率和时间效率方面也大大优于现有的各种检索模型。

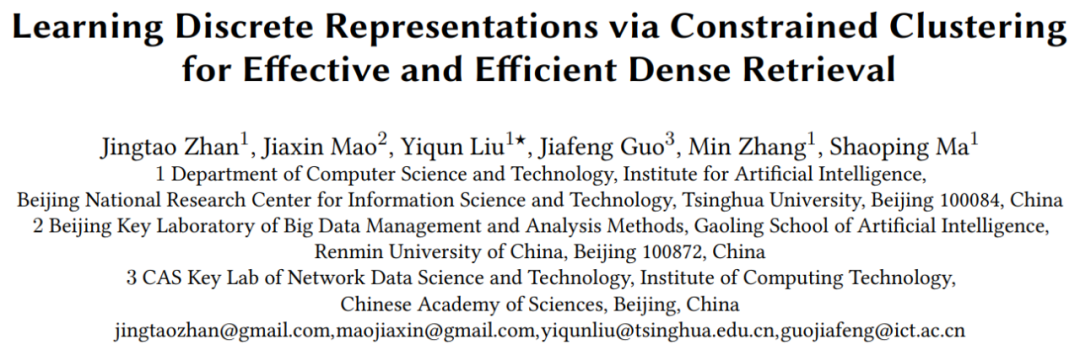

WSDM 2022 共有 3 篇论文获得最佳论文奖亚军,分别如下

论文 1:Doubly Robust Off-Policy Evaluation for Ranking Policies under the Cascade Behavior Model

![]()

论文 2:Evaluating Mixed-initiative Conversational Search Systems via User Simulation

![]()

论文 3:The Datasets Dilemma: How Much Do We Really Know About Recommendation Datasets?

![]()

本届会议的时间检验奖(Test of Time Award)授予了在 WSDM 2011 上发表的论文《Recommender Systems with Social Regularization》。

![]()

推荐系统已被证明是学界和业界的一个经久不衰的研究课题。2011 年关于推荐系统的这篇论文因其重要性以及对社区的影响而被评奖委员会授予时间检验奖。该论文着眼于信任和推荐之间的深层关系,认识到用户不一定与他们信任的每个人都有相似的品味,但这种信任对于推荐至关重要。研究者通过为不同的推荐任务确定最合适的社交关系,有助于确立将社交信息纳入推荐系统的价值。因此,这篇论文具有很高的影响力,并在 WSDM 时间检验奖的所有提名论文中被引用次数最多。同时,论文也显示了对推荐中信任和透明度的重要性的远见,这已成为最近的一个重要课题。

完整接收论文列表:https://www.wsdm-conference.org/2022/accepted-papers/

参考链接:https://www.wsdm-conference.org/2022/

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com