CVPR 2019 Oral 论文解读 | 利用事件相机将模糊视频还原成高速清晰视频

本文为 AI研习社CVPR顶会赞助计划获得者 @rain 在 CVPR小组 原创首发。

今天首度解读一篇CVPR19 oral论文,利用事件相机将模糊视频还原成高速清晰视频。该文利用了目前火热的事件相机,巧妙的利用多传感器之间的互补特性,且具有很好的推广应用价值。过去大家做图像的去模糊,一般只会考虑普通相机采集到的图片,通过估计模糊的核函数,来为图像做去模糊,而这里引入了一个高速的事件相机,通过两个有互补特性的sensor, 为其特性和两者采集数据之间的关系进行建模,把问题formulate成一个简单的非凸优化的问题,

Bringing a Blurry Frame Alive at High Frame-Rate with an Event Camera

Liyuan Pan 1,2, Cedric Scheerlinck1,2, Xin Yu1,2, Richard Hartley1,2, Miaomiao Liu1,2, and Yuchao Dai3

1 Research School of Engineering, Australian National University, Canberra, Australia

2 Australia Centre for Robotic Vision

3 School of Electronics and Information, Northwestern Polytechnical University, Xi’an, China

摘要

事件像机可以测量在高速下精确到微秒的运动和照明变化下的强度变化(称为“事件”)。与主动式像素传感器(APS)相比,事件相机允许同时输出强度帧。然而,当相机输出图像帧率相对较低,图像中的运动模糊就比较严重。一个模糊的图像可以看作是一个序列的潜在图像的积分,而事件相机能找出潜在图像之间的变化。因此,我们能够通过在潜图像上关联事件数据来对模糊生成过程建模。在本文中,我们提出一种简单有效的基于事件的方法,基于事件的二重积分模型,从一个模糊的帧及其事件数据中,重建高帧率的清晰视频。这种视频的生成基于求解一个简单的单标量的非凸优化问题。通过合成图像和真实图像的实验结果论证了该模型的优越性和并且该方法已经超过了当前最好水平。

事件相机(如动态视觉传感器)(DVS)[17]和动态像素视觉传感器(DAVIS)[3])是异步测量的传感器,可测量在每个像素上的强度变化,拥有微秒级的时间分辨率(如果在场景中没有物体运动,就没有触发事件)。事件流通过精确的逐像素级别强度的变化来对运动信息进行编码。与传统相机相比,事件摄像机更适应低照度和高动态的场景,因为他们不受不足/过度曝光的影响或与同步快门相关联的运动模糊。基于事件相机和标准摄像机内在差别,现有计算机视觉算法设计因为标准相机不能用于事件相机直接。虽然(DAVIS)[3]可以同时提供强度帧和事件输出,当前事件相机仍然存在的主要局限性:

• 低帧率强度图像:相对于高时间分辨率的事件数据(≥3µs框架速率),当前事件相机仅输出低帧率强度图像(≥5ms时间分辨率)。

• 固有的模糊效果:当录制高度动态时场景中,运动模糊是一个常见的问题,这来源于场景和相机之间的相对运动。APS输出的强度图像趋向于模糊。

为了应对这些挑战,已经有了各种各样的通过重构高帧率视频的方法涌现出来。现有的方法大致可分为:1)只利用事件数据[1],[27],[2],其中结果往往缺乏自然视频的质感和一致性,因为他们没有使用具有互补性的低帧率的强度图像;2)只利用低帧率强度图像[11]提出了一种端到端学习框架学习单个模糊图像与之间视频序列的回归关系,而不使用丰富的事件信息;3)事件与强度图像结合解决方案[29],[31],[4],它建立于两者之间的相互作用的信息。然而,这些方法在解决与捕获图像相关的模糊问题上都失败了。因此,重建的高帧率视频还是会出现模糊。

尽管模糊的帧会导致的图像退化,他们也编码了相机和场景之间的相对运动。充分利用编码后的运动信息有利于重建高帧率的视频。

为此,我们提出了一个基于事件的二重积分(EDI)模型,通过重构来解决上述问题,从一个单一的图像(均匀模糊)及其事件序列中重建一个高帧率的视频,其中模糊在每个重构帧中得到缓解。我们的EDI模型揭示了高帧率清晰视频,捕获的强度帧和事件数据之间的关系。基于EDI模型,高帧率视频生成问题可转化为简单作为简单的非凸优化问题。我们的主要贡献总结如下

1) 我们提出了一个简单有效的模型,命名为基于事件的二重积分(EDI)模型,从一个单一的图像及其对应的事件数据中恢复高帧率清晰的视频。

2) 利用我们提出的EDI公式,我们提出了稳定而通用的方法通过求解非凸优化问题生成一个清晰的视频,特别是在低照明和复杂的动态条件下。

3) 我们重建视频的帧率理论上可以与事件发生率一样高,(比我们实验中的原始帧率高200倍)。

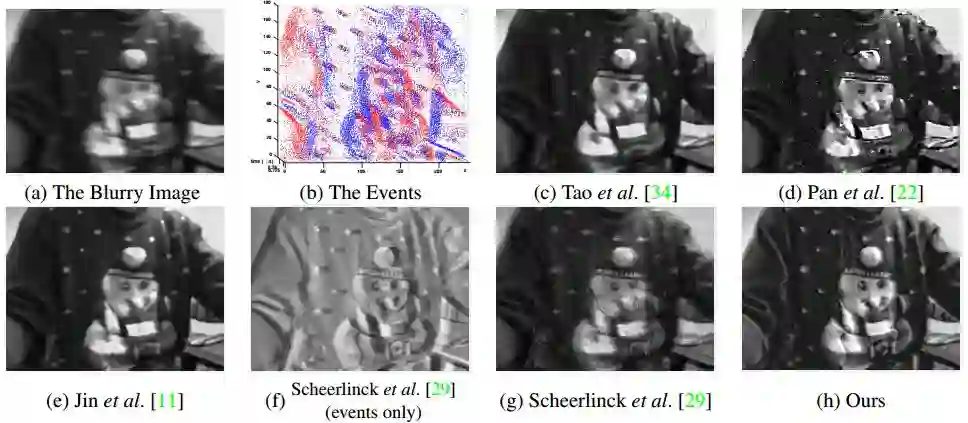

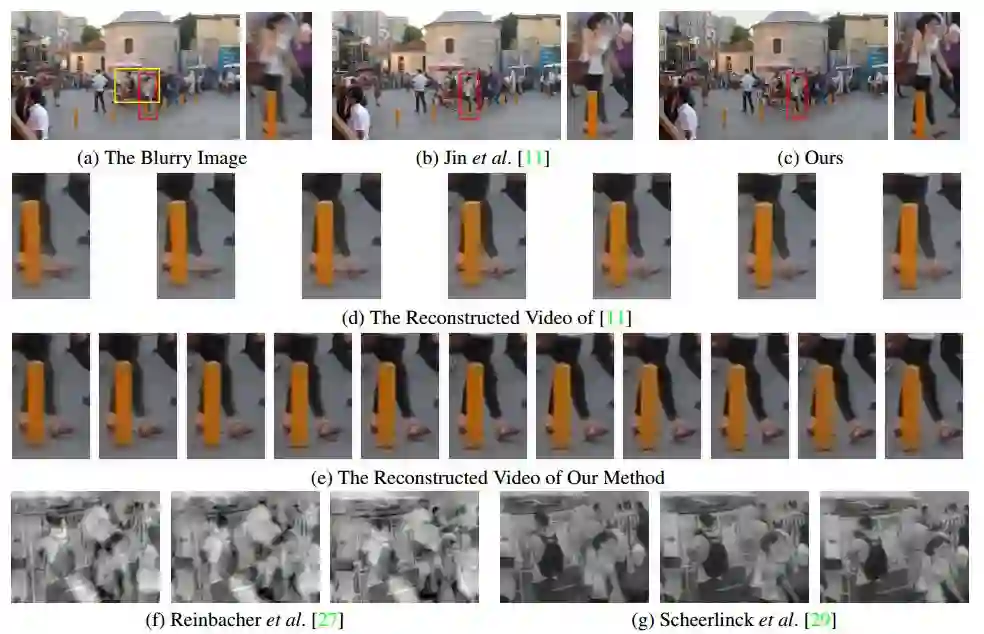

我们看一下基于事件相机采集的真实数据的重建结果,a)是模糊图像,b)对应的事件相机的数据,c)[34]方法的去模糊结果,d)[22]方法的去模糊结果,e)[11]方法的去模糊结果,(f-g)[29]方法的结果,h)我们方法的结果。

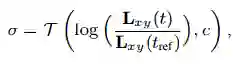

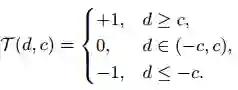

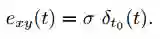

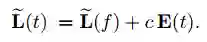

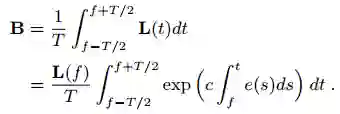

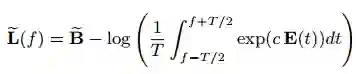

事件相机的数学模型可以用下面的式子来描述

其中潜图像用Lxy(t)表示t时刻x,y位置处的图像强度,而且潜图像并不能从相机的输出中直接得到。

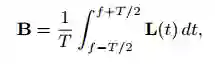

强度图像的数学模型可以用下面的式子描述

普通相机可以提供全帧的强度图像,当然速度比事件相机的速度慢很多。这里的B是一个模糊图像,是在积分时间里的均值。

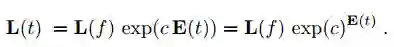

基于事件相机的双积分模型可表示为

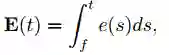

e表示随时间变化的连续函数。

我们接着定义E作为在时间点f 和t 之间的事件的积分累加,

这样潜图像L可以表示为

对于模糊图像,我们有

我们把几个式子合并之后可以得出

如果能计算出上面这个式子,那么潜图像L(t)也就可以求解出来,这也就是论文的算法核心之处。

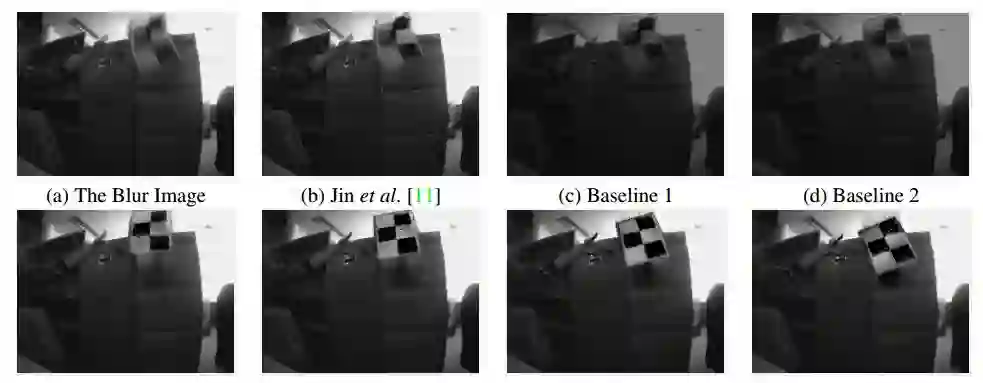

再来看一些实验结果

a)是模糊图像,b)[11]方法的去模糊结果,c)我们baseline1方法的去模糊结果,d)我们baseline2方法的去模糊结果,e)我们的重建方法在L(0)到L(150)的采样结果。

最后是在合成数据集上的结果。a)是模糊图像,b)[11]方法的去模糊结果,c)我们方法的去模糊结果。明显能看出本文方法的优势。

总结一下全文,该文对强度图像和事件数据之间的关系进行了建模,实验部分从与其他state of the arts 的方法的对比上可以看出,该方法明显优于现有的方法。值得大家一读。