【泡泡图灵智库】Deep EndoVO:一种基于递归卷积神经网络的内窥镜胶囊机器人视觉测距方法

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Deep EndoVO: A recurrent convolutional neural network (RCNN) based visual odometry approach for endoscopic capsule robots

作者:Mehmet Turan , Yasin Almalioglu , Helder Araujo ,Ender Konukoglu ,Metin Sitti

来源:Neurocomputing

编译:张国强

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——Deep EndoVO:一种基于递归卷积神经网络(RCNN)的内窥镜胶囊机器人视觉测距方法。

可摄入无线胶囊内窥镜是一种新兴的微创诊断技术,它被用于检查胃肠道并诊断各种疾病和病理。医疗设备公司和许多研究小组最近在将被动式胶囊内窥镜转换为主动式胶囊机器人方面取得了实质性进展,从而能够更加准确,精确和直观地检测患病部位的位置和大小。由于可靠的实时姿态估计功能对于主动控制的内窥镜胶囊机器人至关重要,因此在本研究中,我们提出了用于内窥镜胶囊机器人操作的单目视觉测距(VO)方法。我们的方法是应用深度递归卷积神经网(RCNN)进行视觉测距任务,其中卷积神经网络(CNN)和递归神经网络(RNN)分别被用于特征提取和帧间动态推断。在一个真实的猪胃数据集上进行的详细分析和评估证明,我们的系统为不同类型的内窥镜胶囊机器人轨迹提供了高平移和旋转精度。

主要贡献

1. 据我们所知,这是通过深度学习技术为内窥镜胶囊机器人和手持式标准内窥镜定位开发的第一种单目VO方法。

2. 与传统的单目VO方法相反,不需要先验知识和参数调整来恢复绝对轨迹尺度。

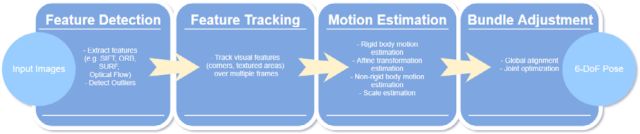

图1 传统VO流程图

3. 由于一种新颖的RCNN体系结构被引入,它可以成功地模拟跨内窥镜视频帧的顺序依赖性和复杂运动动力学。

4. 记录一个真实的猪胃数据集和一个合成人体模拟器数据集,其中包含6-DoF地面实况姿态标签和3D扫描,这些我们正在考虑为该领域的其他研究人员公开。

算法流程

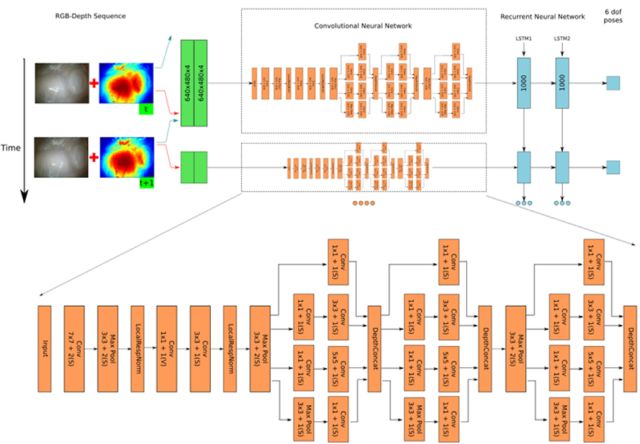

图2. 本文提出的基于RCNN的单目VO系统的体系结构

算法1:Deep EndoVO

第一步:读取两个连续输入的RGB图像。

第二步:Tsai-Shah SfS:从RGB图像创建深度图像。

第三步:从RGB深度图像中减去训练集的平均深度值。

第四步:将预处理的RGB深度帧对叠加以形成张量。

第五步:将张量提供到启动模块堆栈中创建特征向量。

第六步:将特征的表示发送到RNN层。

第七步:估计6-DoF的相对姿势。

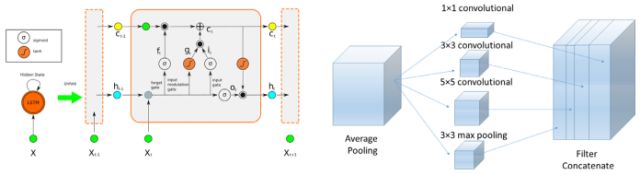

图3 本文提出的模型的LSTM和初始层的结构

算法二:伪代码来计算网络上的损失

1: procedure CalculateLoss

2: loss ← 0

3: for layer in layers do

4: for top, loss_weight in layer. tops, layer. loss_weights do

5: loss ← loss + loss_weight × sum(top) 。

反向传播算法被用于计算RCNN权重的梯度,其被传递给Adam优化方法以使用随机目标函数的基于一阶梯度的优化来计算每个参数的自适应学习速率。 除了节省过去平方梯度的指数衰减平均值之外,Adam优化保持了过去梯度的平均指数衰减,这与动量相似。

主要结果

文章结果主要针对上述四点贡献:

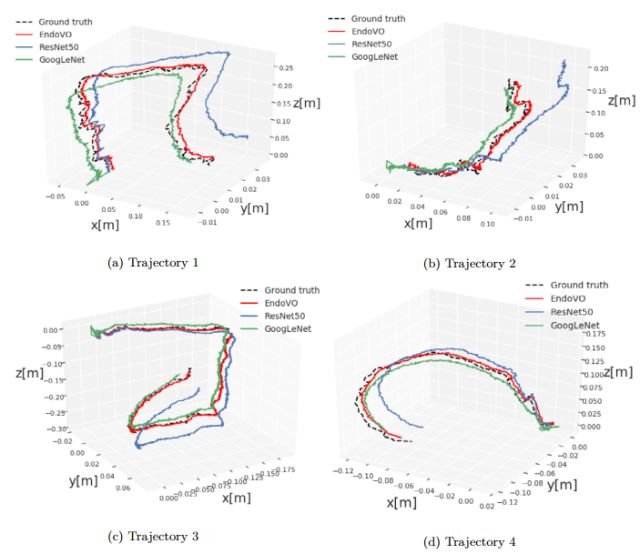

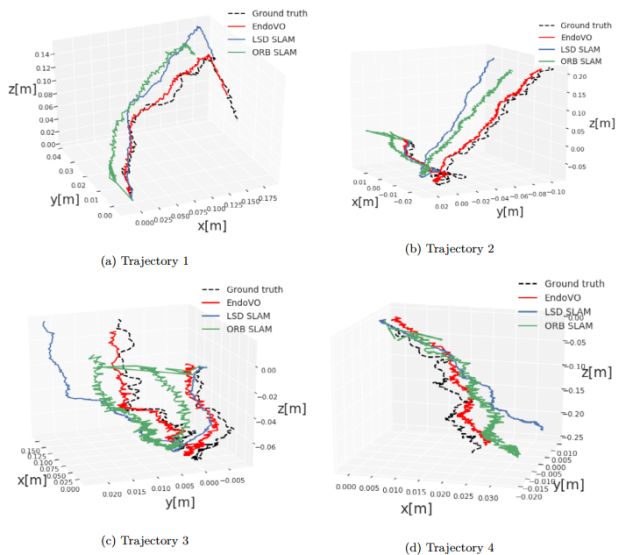

1. 如下图看到的,Deep EndoVO是最接近地面真实轨迹的。该尺度根据模型进行了正确计算和维护。

图4 基于DL的VO模型预测的样本地面真实轨迹和估计的轨迹。

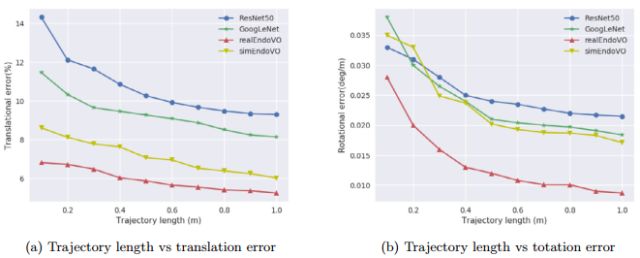

2.如下图所示,在平移和旋转位置估计方面,Deep EndoVO优于其他两个模型。

图5 (a)轨迹长度VS转换错误。(b)轨迹长度VS旋转错误

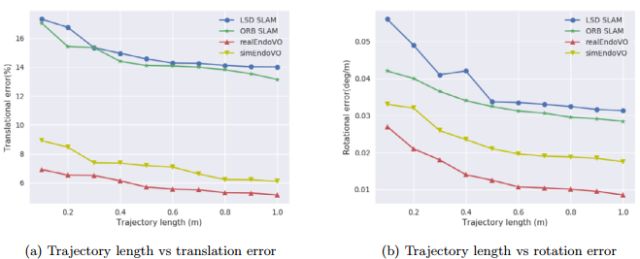

3.Deep EndoVO在平移和方向估计中均优于最先进的SLAM方法ORB SLAM和LSD SLAM。

图6 (a)轨迹长度VS转换错误(b)轨迹长度VS旋转错误

4.与最先进的SLAM方法相比,Deep EndoVO最接近地面真实轨迹。

图7 通过DEndoVO,LSD SLAM和ORB SLAM获得的地面实况和轨迹图。

Abstract

Ingestible wireless capsule endoscopy is an emerging minimally invasive diagnostic technology for inspection of the GI tract and diagnosis of a wide range of diseases and pathologies. Medical device companies and many research groups have recently made substantial progresses in converting passive capsule endoscopes to active capsule robots, enabling more accurate, precise, and intuitive detection of the location and size of the diseased areas. Since a reliable real time pose estimation functionality is crucial for actively controlled endoscopic capsule robots, in this study, we propose a monocular visual odometry (VO) method for endoscopic capsule robot operations. Our method lies on the application of the deep recurrent convolutional neural networks (RCNNs) for the visual odometry task, where convolutional neural networks (CNNs) and recurrent neural networks (RNNs) are used for the feature extraction and inference of dynamics across the frames, respectively. Detailed analyses and evaluations made on a real pig stomach dataset proves that our system achieves high translational and rotational accuracies for different types of endoscopic capsule robot trajectories.

.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com