【信息图】神经网络动物园前序:Cell与层之间如何连接

点击上方“公众号”可以订阅哦!

1新智元编译

来源:asimovinstitute.org

编译:弗格森

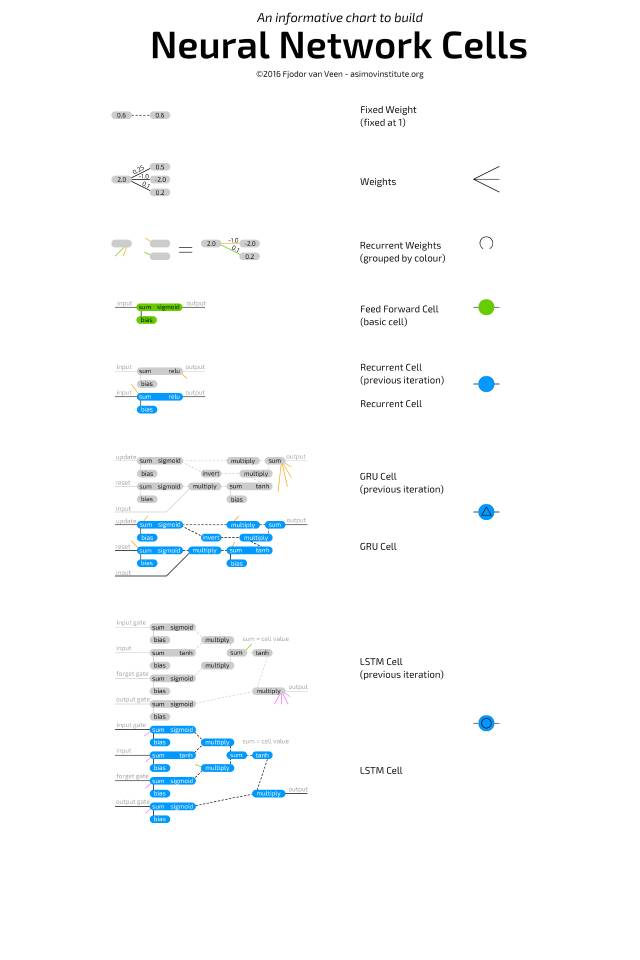

【导读】 此前介绍的神经网络动物园让大家大饱眼福,看到了各种各样的神经网络模型。今天带来更为基础的介绍:组成神经网络模型的基本单元和层是怎么样的?通过信息图表,作者介绍了最基础的单元、长短期记忆单元、门循环单元等等。

信息图表:神经网络基本单元

神经网络动物园展示了不同类型的神经网络基本单元和多样化的神经网络层之间的连接。但是,它并没有真正地展示每一个基本单元是如何工作的。许多基本单元的类型我最初会赋予不同的颜色来区分网络,但是现在我发现,这些基本单元或多或少是以相同的方式工作的,所以这里只需要提供基本的单元图像,就足以进行描述。

一个基本的神经网络单元是非常简单的,这也就是你在常规的前馈架构中会看到的那一类。单元通过权重连接到其他神经元,即它可以连接到先前层中的所有神经元。每个连接都有自己的权重,这通常只是一个随机数。权重可以是负数,正数,非常小,非常大或为零。每一个基本单元连接的值都会乘以相应的连接权重,得到的值再全部相加。除此之外,还增加了偏差(bias)。偏差可以防止单元在零输出的情况下被卡住,并且可以加速一些操作,减少解决问题所需的神经元数量。偏差也是一个数字,有时是常数(通常为-1或1),有时是变量。然后,这个总和通过激活函数,其结果的值然后变为单元的值。

卷积单元非常像前馈单元,除了它们通常仅连接到前一层的几个神经元。它们通常用于保存空间信息,因为它们不是连接到几个随机单元,而是连接到一定距离内的所有单元。这使得它们对于具有许多局部信息(例如图像和声波(但大多是图像))的数据是非常实用的。去卷积(Deconvolutional)单元恰恰相反:它们倾向于通过局部连接到下一层来解码空间信息。这两个单元通常都有很多独立进行训练的克隆单元(clone);每个克隆单元都有自己的权重,但是连接的方式是完全一样的。这些克隆单元可以被认为是位于具有相同结构的分开的网络中。两者基本上与常规单元相同,但它们的使用方式不同。

池化和内插(interpolating)单元经常与卷积单元结合。这些单元不是真正的单元,而更多的是原始的操作。池化单元接收传入的连接,并决定哪个连接能通过。在图像中,这可以被认为是在缩小图像,您将无法再看到所有像素,并且必须了解保留哪些像素、丢弃哪些像素。内插单元执行相反的操作:它们接收一些信息并将其映射到更多信息。额外的信息由它编造的,就像放在一张小分辨率图片上一样。内插单元不是池化单元的唯一反向操作,但它们相对较为常见,因为它们实现起来很简单。二者在连接上分别像卷积和去卷积单元。

均值和标准偏差单元(二者几乎只能在概率单元中作为配对出现)用于表示概率分布。均值是平均的值,标准偏差表示偏离平均值(在两个方向)有多远。例如,用于图像的概率单元可以包含关于特定像素中有多少红色的信息。比如,平均值可能是0.5,标准偏差0.2。当从这些概率单元进行采样时,可以在高斯随机数发生器中输入这些值,0.4到0.6之间的任何值都是非常可能的结果,远离0.5的值会越来越少见(但仍然可能)。它们通常完全连接到上一层或下一层,并且它们没有偏差。

循环单元的连接不仅表现在层次上,还表现在时间上。每个单元内部会存储其先前的值。它们像基本单元格一样更新,但具有额外的权重:连接到单元的以前的值,大部分时间也连接到同一层中的所有单元格。当前值和存储的先前值之间的这些权重非常像一个易失性存储器(如RAM),继承了具有一定“状态”的两个属性,如果不被馈送就会消失。因为先前的值是通过激活功能传递的值,并且每个更新通过激活功能与其他权重一起传递此激活值,信息将不断丢失。实际上,保留率是如此之低,后来只要经过四五次迭代,几乎所有的信息都会丢失。

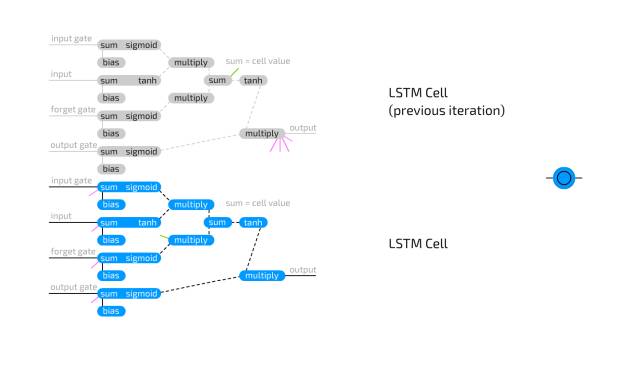

长短期记忆单元被用来应对循环单元中信息快速损失的问题。 LSTM单元是逻辑循环,从如何为计算机设计存储单元复制。与存储两种状态的RNN单元相比,LSTM单元存储四个:输出的当前和最后值以及“存储单元”状态的当前和最后值。它们有三个“门”:输入,输出,忘记,它们也只有常规的输入。这些门中的每一个都具有自己的重量,意味着连接到这种类型的单元需要设置四个权重(而不是仅一个)。门的功能很像流闸,而不是栅栏门:可以让一切都通过,也可以只是一点点信息通过,或者不让任何东西流过。这可以通过将输入信息乘以0到1的值来实现,该值存储在该门限值中。

然后,输入门确定允许将多少输入添加到单元格值中。输出门确定网络的其余部分可以看到多少输出值。忘记门不连接到输出单元的先前值,而是连接到先前的存储单元值。它确定要保留的最后一个存储单元状态的多少。它没有连接到输出,所以信息丢失的发生会更少,因为没有激活功能放置在循环中。

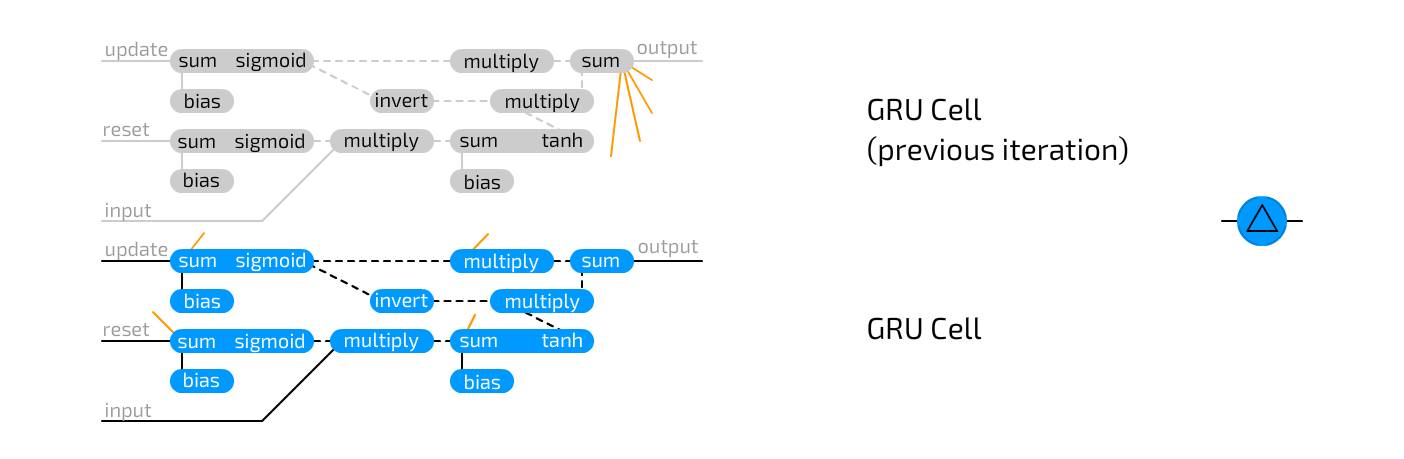

门循环单元是LSTM单元的变异。它们也使用门来消除信息丢失,但是只需要两个门:更新和重启。这使得他们的表现力稍逊一筹,但也稍微快一些,因为他们使用的连接数量更少。实质上,LSTM单元和GRU单元之间存在两个区别:GRU单元不具有由输出门保护的隐藏单元状态,并且它们将输入和忘记门组合成单个更新门。这个思路是,如果你想允许很多新的信息,你可能会忘记一些旧的信息 。

将神经元连接形成图形的最基本的方法是将所有内容全部连接。这在 Hopfield 网络和 Boltzmann 机器中可以看到。当然,这意味着连接数量呈指数增长,但是性能却不一定会如预期一般。这被称为完全(或完全)连接。

一段时间后,有人发现将网络分成不同的层是一个有用的特征,其中层的定义是一组或几组神经元,它们彼此不相连,但仅与来自其他组的神经元相关联。这个概念在限制玻尔兹曼机器中得到使用。使用层的想法现在广泛应用于任意数量的层,并且可以在几乎所有当前架构中找到。(也许令人困惑)这也被称为完全连接或完全连接,因为实际上完全连接的网络是不常见的。

卷积连接的层比完全连接的层更受约束:我们将每个神经元仅连接到靠近的其他组中的神经元。如果一对一地将信息直接馈送到网络中(例如,每个像素使用一个神经元),图像和声波所包含的信息量会非常大。卷积连接的想法来自一种观察:空间对于保留信息可能很重要。从本质上看,这是一个很好的猜测,因为它被用于许多基于图像和声波的神经网络应用中。然而,这种设置比完全连接的层更不具有表现力。实质上,它是一种“重要”过滤方式,决定了哪些紧密分组的信息包是重要的;卷积连接非常适合降维。在什么空间距离神经元仍然可以连接取决于实现,但范围高于4或5个神经元很少会使用。注意,“空间”通常是指二维空间,这是为什么大多数表示显示连接的是三维神经元片段的原因;连接范围会被应用于所有维度。

另一个选择当然是随机连接的神经元。这也带来了两个主要的变化:通过允许所有可能连接的一部分,或者连接一些不同层之间的神经元。随机连接有助于线性降低网络的性能,并且可以在完全连接的层遇到性能问题的大型网络中有用。在某些情况下,具有稍微更多神经元的稀疏连接层可以表现更好,特别是在需要存储大量信息但没有多少信息需要交换的情况下(有点类似于卷积连接层的有效性,只是随后被随机)。非常稀疏连接的系统(1或2%)也会被使用,如ELM,ESN和LSM所示。特别是在加速网络的情况下,这是很有意义的,因为神经元具有的连接越多,每个权重将承载的能量越少,意味着更少的传播和重复的模式。

时间延迟连接是不从上一层获取信息的神经元(通常来自与之相同的层,甚至与其自身连接)之间的连接,但是来自过去的层(主要是先前的迭代)。这允许暂时地存储相关信息(时间,序列或顺序)。这些类型的连接通常会需要经常手动重置,以清除网络的“状态”。与常规连接的主要区别在于,即使网络未被训练,这些连接也在不断变化。

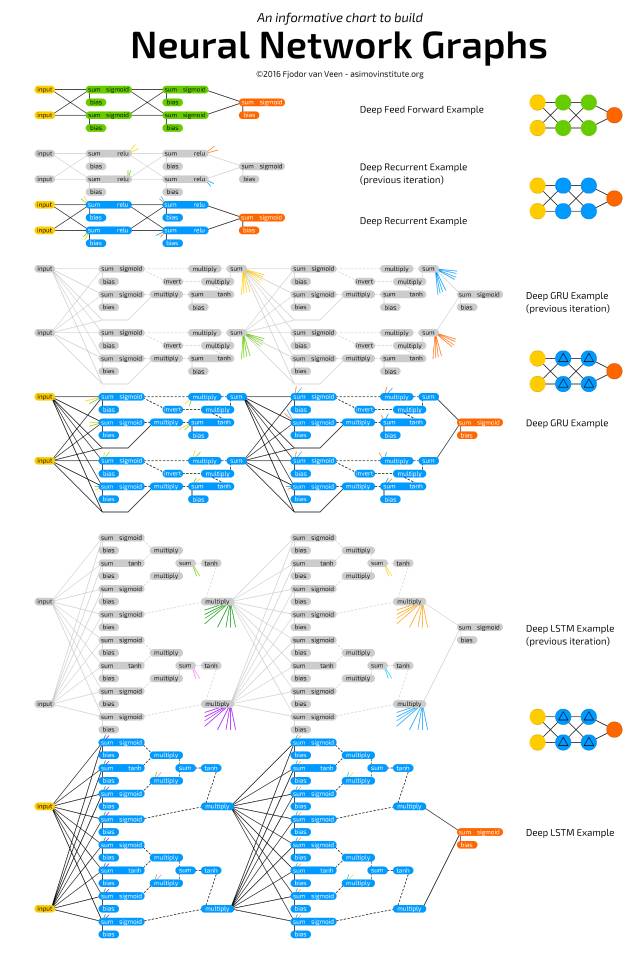

下图显示了上述类型的一些小样本网络及其连接。当我要弄清楚到底连接是怎么样的时候,我会使用它(与使用LSTM或GRU单元格特别有关):

注:投稿请电邮至124239956@qq.com ,合作 或 加入未来产业促进会请加:www13923462501 微信号或者扫描下面二维码:

文章版权归原作者所有。如涉及作品版权问题,请与我们联系,我们将删除内容或协商版权问题!联系QQ:124239956