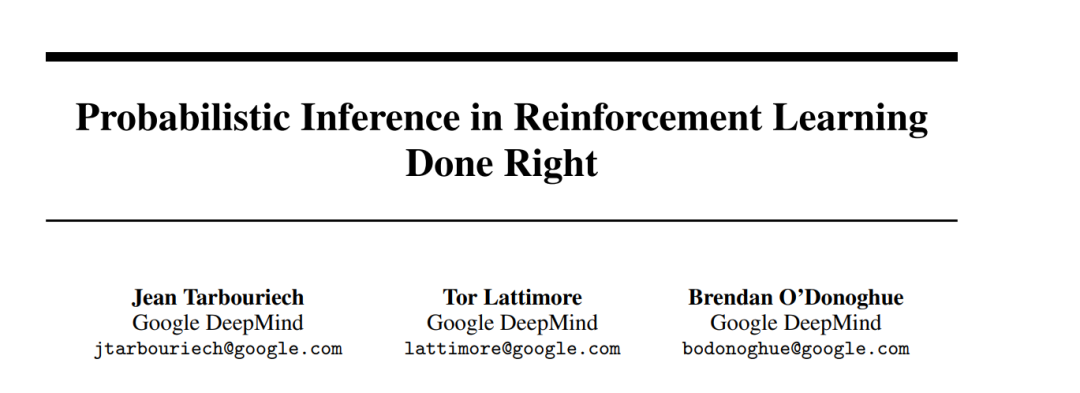

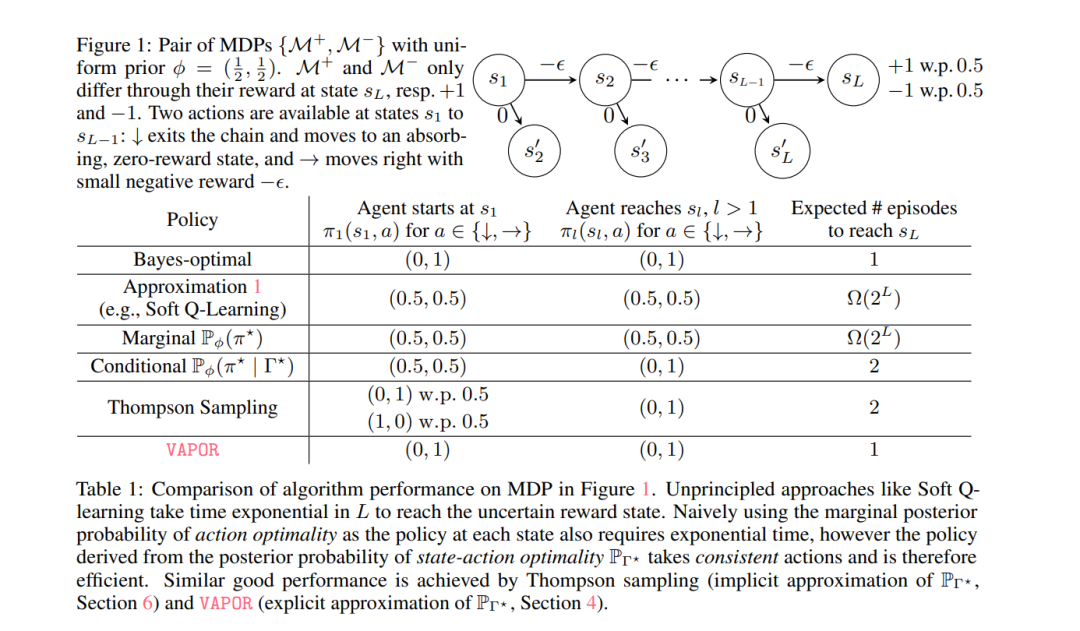

在强化学习(RL)中的一个流行观点将问题视为在马尔可夫决策过程(MDP)的图形模型上进行概率推理。研究的核心对象是在最优策略下访问每个状态-动作对的概率。以前对这一数量的近似方法可能会相当差,导致算法没有实现真正的统计推理,因此在挑战性问题中表现不佳。在这项工作中,我们对状态-动作最优性的后验概率进行了严格的贝叶斯处理,并阐明了它如何在MDP中流动。我们首先揭示了这一数量确实可以用来生成有效探索的策略,以遗憾为度量。不幸的是,计算它是不可行的,因此我们推导出一个新的变分贝叶斯近似,得出一个可行的凸优化问题,并证明由此产生的策略也能有效探索。我们称我们的方法为VAPOR,并展示它与汤普森采样、K学习和最大熵探索有着紧密的联系。我们以一些实验作为结尾,展示了VAPOR的深度强化学习版本的性能优势。

成为VIP会员查看完整内容

相关内容

Arxiv

223+阅读 · 2023年4月7日